En octobre, Qualcomm a annoncé le Snapdragon X Elite, un système sur puce pensé pour les ordinateurs sous Windows, et annoncé pour le milieu de l'année 2024. Il est basé sur le cœur Oryon (issu des travaux de Nuvia) et la société américaine a indiqué récemment que la nouvelle puce serait plus rapide que l'Apple M3. Et au vu des configurations des deux SoC… c'est probablement le cas et c'est normal.

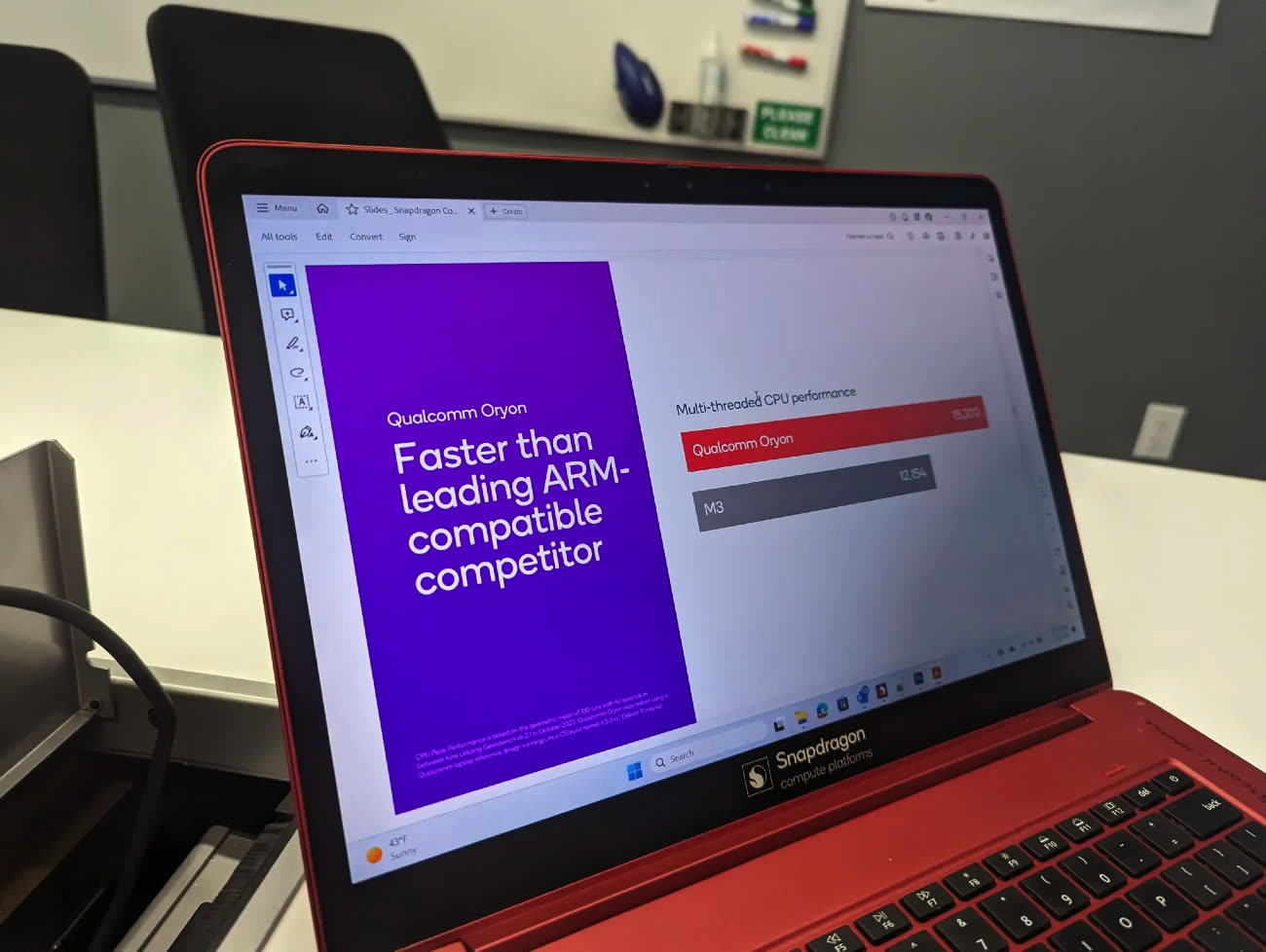

Ce sont nos confrères de Digital Trends qui partagent cette image : un benchmark fourni par Qualcomm montre que la nouvelle puce est plus rapide que l'Apple M3 sur plusieurs cœurs, avec un gain d'environ 20 %. Mais il n'y a rien d'étonnant : la puce possède plus de cœurs.

Avec Oryon et le Snapdragon X Elite, Qualcomm compte battre le M2 et les puces x86

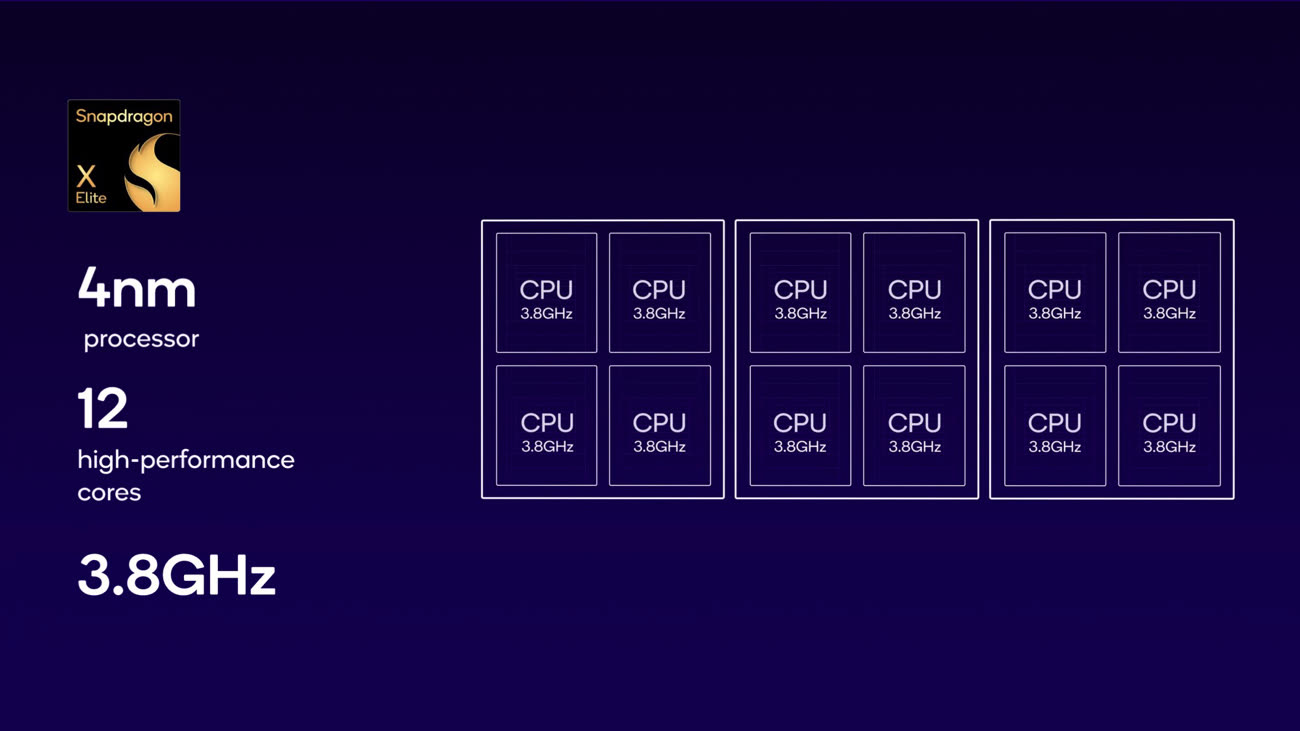

Notre actualité sur le sujet l'expliquait déjà : le système sur puce Snapdragon X Elite a été annoncé avec 12 cœurs identiques et une fréquence de 3,8 GHz (4,3 GHz en pointe). En face, l'Apple M3 reste assez conservateur : il possède quatre cœurs performants et quatre cœurs basse consommation (4+4). Même en prenant en compte que les performances sur un seul cœur sont à l'avantage d'Apple, le plus grand nombre de cœurs permet mécaniquement à la puce de Qualcomm de prendre la tête. Pour tout dire, le Snapdragon X Elite est probablement plus rapide dans ce cas de figure que l'Apple M3 Pro, un système sur puce doté de 11 (5+6) ou 12 (6+6) cœurs.

Par contre, Qualcomm évite pour le moment de trop mettre en avant la puissance de son GPU : si le CPU est très rapide, le GPU est un peu à la traîne comparativement et se place entre une puce M2 et une puce M1 Pro (Apple ne donne pas la puissance exacte du M3, mais elle est probablement au moins équivalente au vu des performances mesurées.

En réalité, comme souvent avant la sortie d'un produit, les fabricants choisissent évidemment les cas les plus favorables et mettre en avant les performances d'un CPU doté de 12 cœurs est logique. Reste à voir comment s'en sortiront les PC équipés de la puce dans la pratique : elle aura du travail pour émuler des logiciels comme Chrome, qui n'existe pour le moment pas dans une variante ARM64 pour les PC sous Windows.