Environ cinq ans après le lancement des premiers PC portables sous Windows 10 « ARM », Microsoft a annoncé récemment son premier kit de développement, une machine connue précédemment sous le nom de code Volterra. Vendu 700 €, ce PC aux allures de Mac mini reprend en fait en partie la philosophie du kit de développement Apple de 2020, le DTK. En effet, en interne, Microsoft a littéralement réutilisé les composants de la Surface Pro 91.

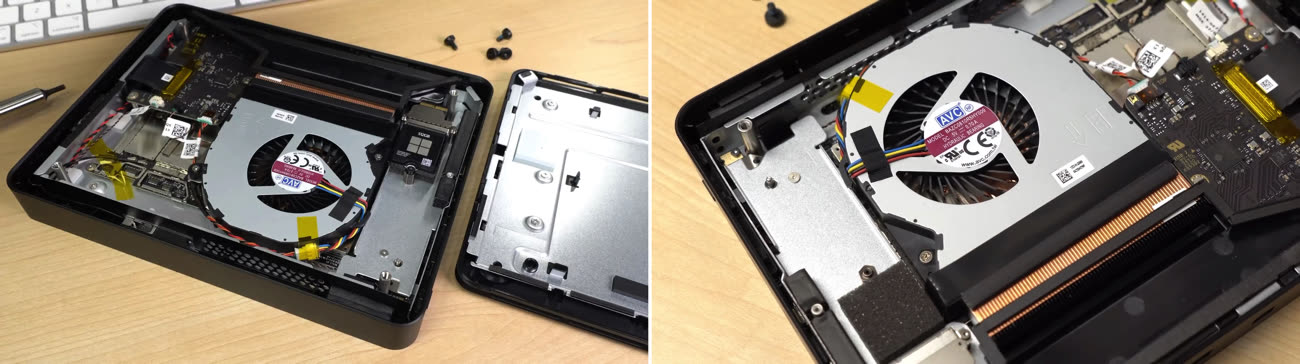

La vidéo de Jeff Geerling, un vidéaste capable de prouesses inattendues dans ses essais de cartes Raspberry Pi, montre l'intérieur du kit de Microsoft, avant de faire quelques tests. La partie la plus intéressante vient de la carte mère : il s'agit de celle de la Surface Pro 9, avec 32 Go de RAM et un SSD de 512 Go. Ce dernier est amovible et il semble possible de le remplacer par n'importe quel modèle NVMe M.2, même si celui d'origine est très compact… comme dans les tablettes.

On peut voir que Microsoft a vraiment fait le service minimum sur certains composants : certains connecteurs sont présents mais inutilisés, probablement ceux qui gèrent l'écran de la tablette et la connectivité 5G. Dans les petites différences, on peut noter l'adjonction d'un adaptateur USB vers Ethernet en interne et — surtout — un ventilateur qui va permettre d'évacuer la chaleur émise par la puce. La Surface Pro 9 se passe de ce dernier, mais la tablette peut employer une partie de la coque comme dissipateur passif, alors que le boîtier du kit de développement est en plastique.

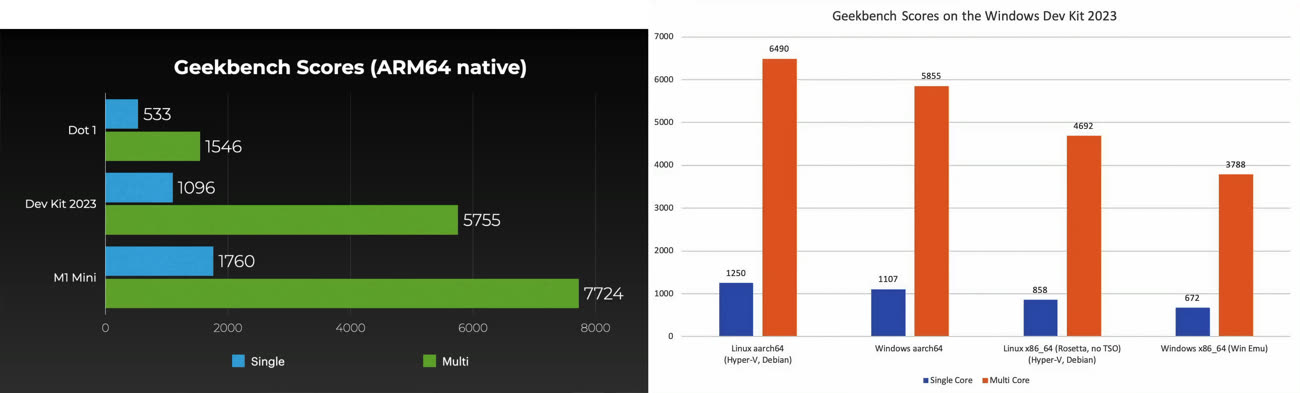

Au niveau des performances, le système sur puce Snapdragon 8cx Gen 3 (appelé Microsoft SQ3 dans la Surface Pro 3, mais il s'agit de la même puce) demeure assez loin de l'Apple M1. Qualcomm utilise une architecture 4+4, en combinant quatre cœurs rapides dérivés du Cortex X1 et quatre cœurs dérivés du Cortex A78, qui sont rapides, mais un peu moins. Le système se passe des variantes basse consommation classiques.

Malgré cette configuration musclée en théorie, la puce ne rivalise pas du tout avec l'Apple M1, et encore moins avec l'Apple M2. Point amusant, s'il n'est pas possible d'installer une distribution GNU/Linux directement, les performances dans une machine virtuelle sont plus élevées que sous Windows 11. De même, l'installation de Rosetta 2 sous GNU/Linux pour émuler le code x86 donne de meilleurs résultats que la solution de Microsoft.

Dans tous les cas, il est étonnant de voir Microsoft suivre la voie du DTK d'Apple (qui, rappelons-le, intégrait un A12Z issu des iPad Pro) avec autant de retard. Peut-être que Microsoft se rend enfin compte que les développeurs d'applications n'ont pas forcément envie d'acheter une Surface Pro (assez onéreuse) et qu'une tablette tactile n'est pas nécessairement le matériel le plus adapté pour ça. Pour les personnes intéressées, Microsoft vend son kit de développement pour 699 €, et il ne devra pas repartir après quelques mois, lui.

Reste à voir si les développeurs suivront, car Microsoft n'est pas du tout dans la même position qu'Apple. Le DTK a été proposé en 2020 plusieurs mois avant le lancement des premiers Mac M1, avec une attente importante liée au fait qu'Apple abandonnait le x86.

Chez Microsoft, il n'y a pas de transition directe vers ARM, mais uniquement quelques PC portables dont personne ne veut en pratique, ce qui n'incite évidemment pas les développeurs à porter leurs logiciels pour la nouvelle architecture. Qui plus est, cinq ans après les premiers PC, certains outils fonctionnent encore uniquement en x86, avec une émulation franchement lente… sur une plateforme qui l'est déjà au départ.

-

Dans une logique très Microsoftienne, la Surface Pro X a été suivie de la Surface Pro 9. Ne cherchez pas à comprendre. ↩︎