Adobe va doter Premiere Pro de fonctions de manipulation d'image grâce à son modèle d'IA Firefly et à d'autres IA génératives de vidéos.

Aucune bêta n'est pour le moment proposée, mais ces nouveautés arriveront dans Premiere Pro plus tard dans l'année. Adobe va utiliser son IA générative Firefly — déjà employée dans la retouche de photos — pour modifier des séquences vidéo. Le clip de démonstration donne plusieurs exemples de situations ou l'IA générative vient corriger un défaut dans l'image ou en créer de nouvelles sans besoin de ressortir la caméra.

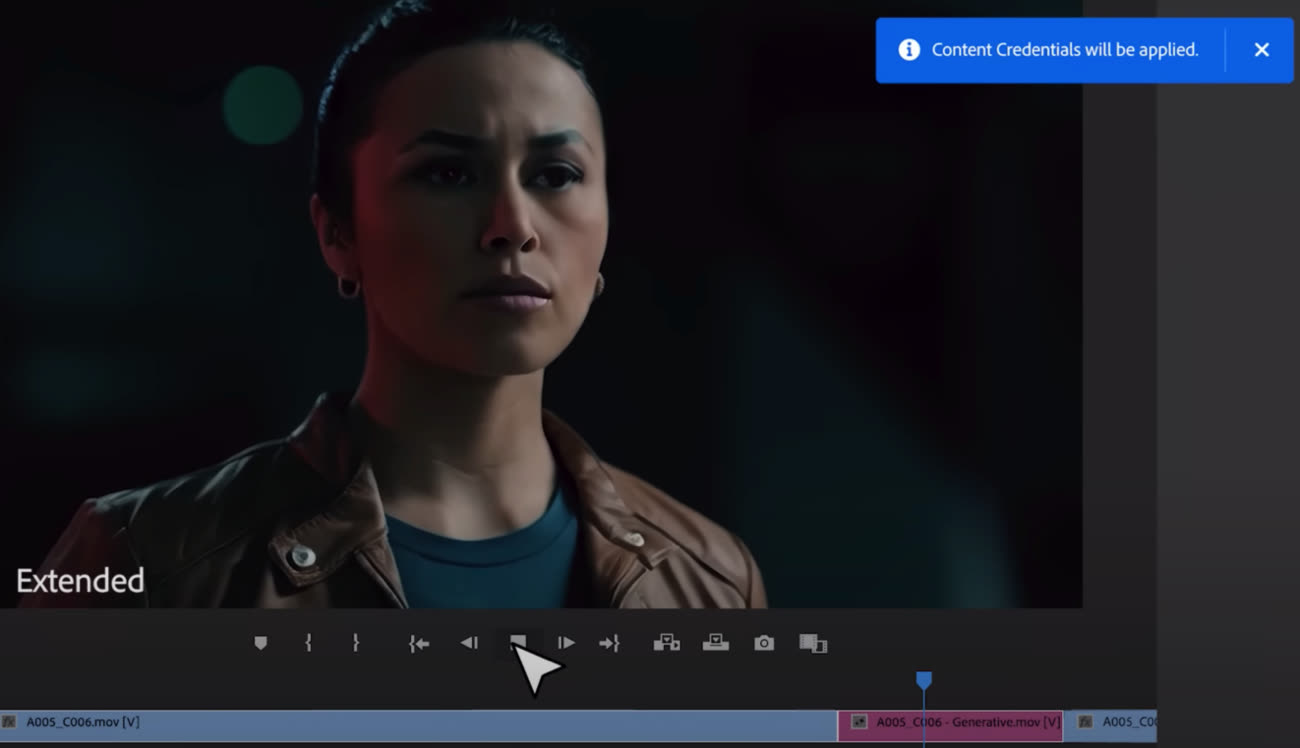

En quelques clics et en utilisant parfois quelques prompts pour expliciter ce que l'on veut, Firefly peut substituer un objet par un autre, gommer des éléments inutiles ou disgracieux dans le décor, ajouter une cravate à un acteur ou créer de nouvelles scènes d'enchainement : une vue sur un panorama sur une ville ou une séquence en voiture. Il peut être nécessaire aussi d'allonger un plan qui s'avère trop court, par exemple un gros plan sur un visage.

Les modifications montrées dans ce clip de démo sont plutôt convaincantes… lorsqu'on ne s'attarde pas trop longtemps sur les détails. L'effacement d'un bloc d'alimentation et de tuyaux sur un mur garde les traces de la gomme ; le visage généré pour allonger un gros plan sur l'actrice trahit un rendu informatique ; les compteurs dans la planche de bord de la voiture ont des chiffres et des lettres distordus, etc.

On retrouve les défauts habituels de ces modèles d'IA et certains iront sans nul doute en se réduisant. Quelques-uns des exemples proposés ont été réalisés avec des modèles de tierces parties comme Pika Labs, Runway et OpenAI dont le modèle Sora a étonné lors de la présentation il y a quelques semaines (lui aussi est encore au stade de la recherche, avec tout ce que cela implique comme bugs et faiblesses).

Sora : le générateur de vidéos d’OpenAI sera accessible au grand public plus tard cette année

C'est l'autre volet de cette présentation d'Adobe, Premiere Pro va utiliser en priorité Firefly, le modèle maison, mais l'éditeur teste l'intégration d'autres modèles pour offrir une palette plus large aux monteurs qui pourront vouloir exploiter plutôt telle ou telle IA en fonction de ses points forts.

Enfin, Adobe va utiliser son « label de provenance » numérique pour intégrer un sceau numérique — Content Credentials — sur ces images afin d'expliciter qu'elles ont été en partie créées avec une IA.

L'IA générative Firefly disponible gratuitement dans Adobe Express

Firefly, l'IA générative d'Adobe, comprend maintenant le français

Source :