Vous commencez à avoir fait le tour de Dall-E ? Alors il est l'heure d'essayer Stable Diffusion, un autre modèle d'apprentissage automatique d'images qui tourne localement sur votre Mac ! Le développeur Divam Gupta vient de publier une nouvelle version de Diffusion Bee, une interface graphique pour Stable Diffusion permettant de s'en servir sans compétences techniques sur macOS. Elle offre (entre autres) de générer des images à partir d'une poignée de mots.

Contrairement à Dall-E, Stable Diffusion est un projet libre qui nécessite de mettre un peu les mains dans le cambouis pour démarrer. Diffusion Bee résout ce problème étant donné qu'il s'agit simplement d'un programme à faire glisser dans votre dossier Applications. Tout fonctionne hors-ligne et aucune donnée n'est envoyée dans le nuage.

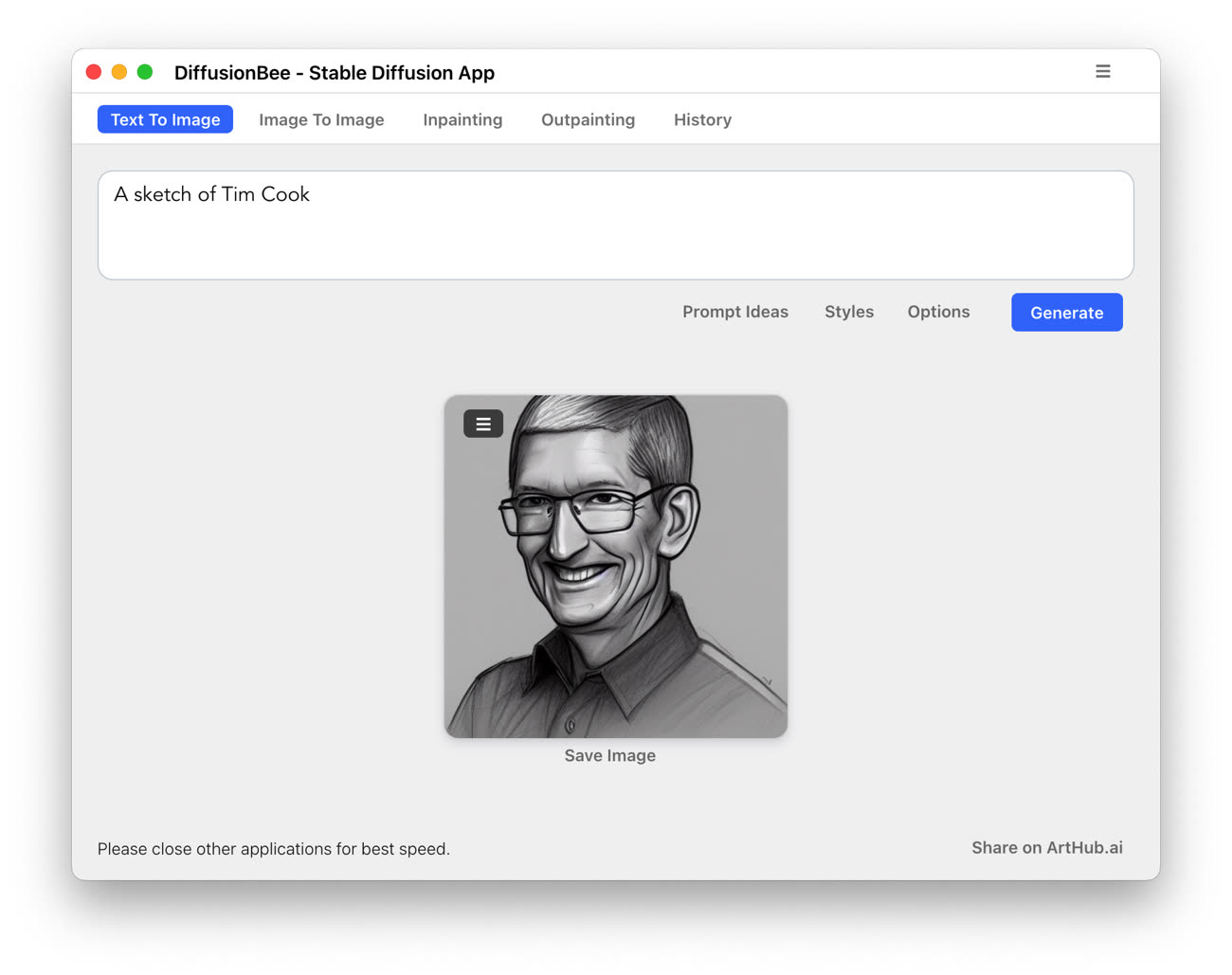

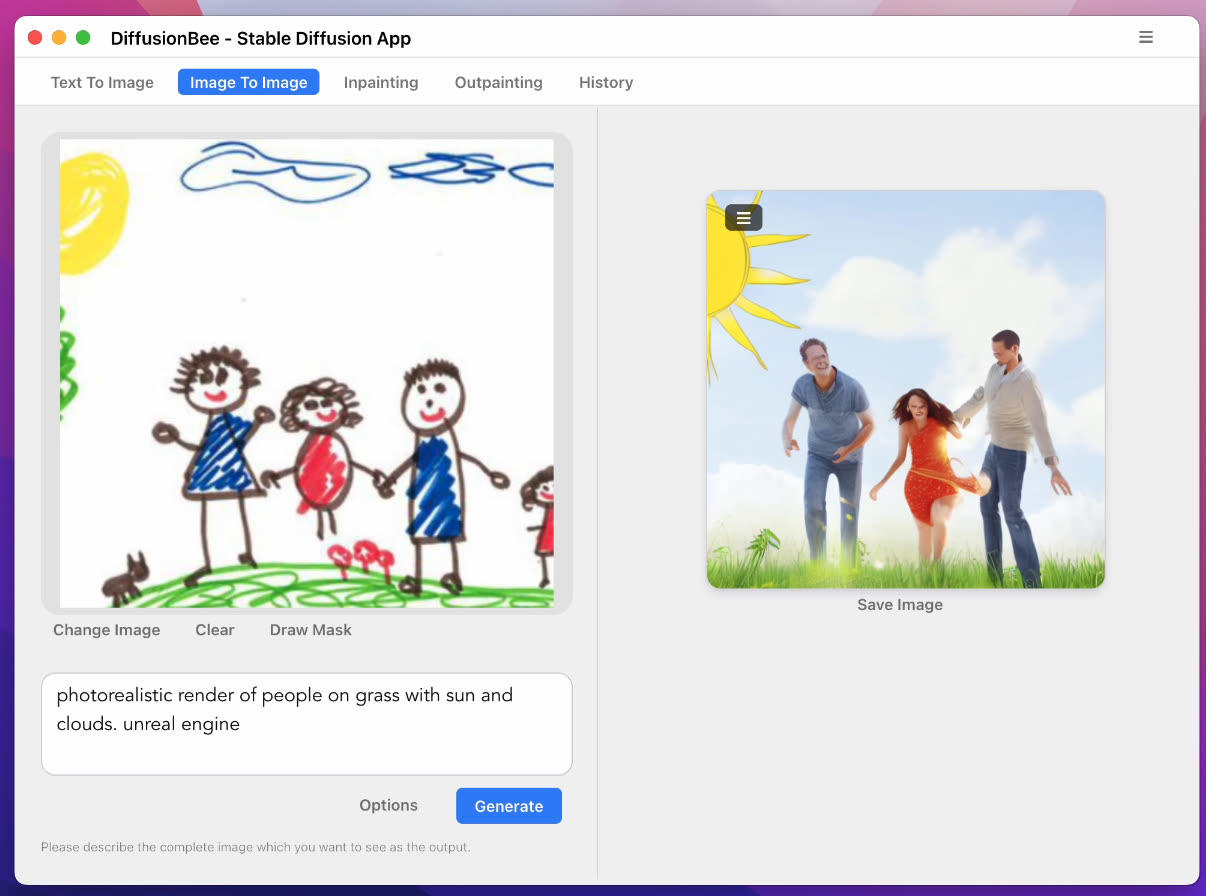

L'interface est très simple : un cadre vous invite à entrer une description, et un clic permet de générer l'image. Plusieurs options sont disponibles, et on pourra également utiliser l'IA pour modifier une image existante en ajoutant des éléments ou en lui laissant imaginer ce qui se passe hors du cadre. Des paramètres avancés sont proposés pour les utilisateurs désirant aller plus loin.

L'application tire sur la carte graphique et il est recommandé de ne pas utiliser d'autres programmes pendant la génération d'image (ça freeze assez vite chez moi sur mon iMac Intel). Les propriétaires de Mac plus récents devraient obtenir de meilleurs performances, Diffusion Bee étant optimisé pour les puces M1 et M2.

Si vous voulez jouer avec l’IA sans rien télécharger, rappelons que Dall-E a récemment supprimé sa liste d'attente. Cependant, la génération d'image est limitée à un certains nombres de crédits par mois, et il faudra ensuite passer à la caisse pour continuer à créer.