Comme chaque année, Apple améliore Core ML, sa solution d’apprentissage automatisé destinée aux développeurs autant qu’à ses propres usages. Et en 2021, Core ML 5 apporte plusieurs améliorations significatives, avec une mise à jour résolument tournée vers le futur à l’instar de Swift Concurrency que nous avons évoqué dans un article précédent.

De nouvelles capacités pour identifier les sons et images

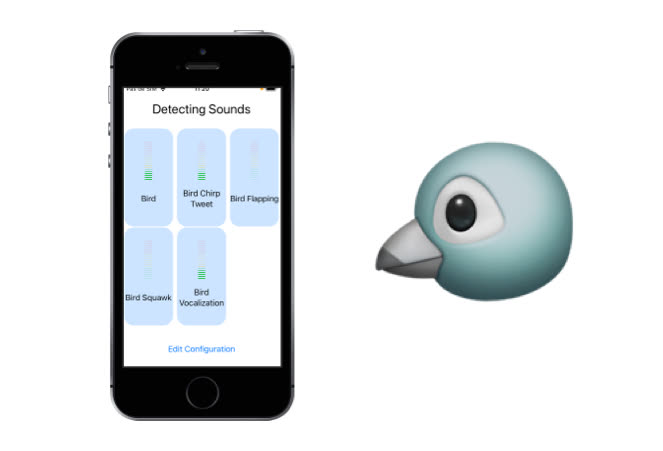

Core ML est composé de plusieurs frameworks, des briques spécialisées dans une tâche précise. Au menu des évolutions majeures, le module Sound Analysis intègre désormais un modèle préinstallé que les développeurs peuvent utiliser directement.

Ce modèle permet de détecter plusieurs centaines de bruits sans effort. Je l’ai testé dans mon jardin pour détecter le chant des oiseaux avec un iPhone SE sous iOS 15 et les résultats sont impressionnants. Les apps qui permettent de détecter les cris d’enfants ou des outils d’accessibilité capables d’identifier les bruits des voitures deviennent ainsi très faciles à créer. Et d’autres usages pourront être inventés à partir de ce nouveau framework.

Autre framework fourni par ML, Vision voit de mieux en mieux. Cette brique spécialisée dans la détection de contenu visuel est …