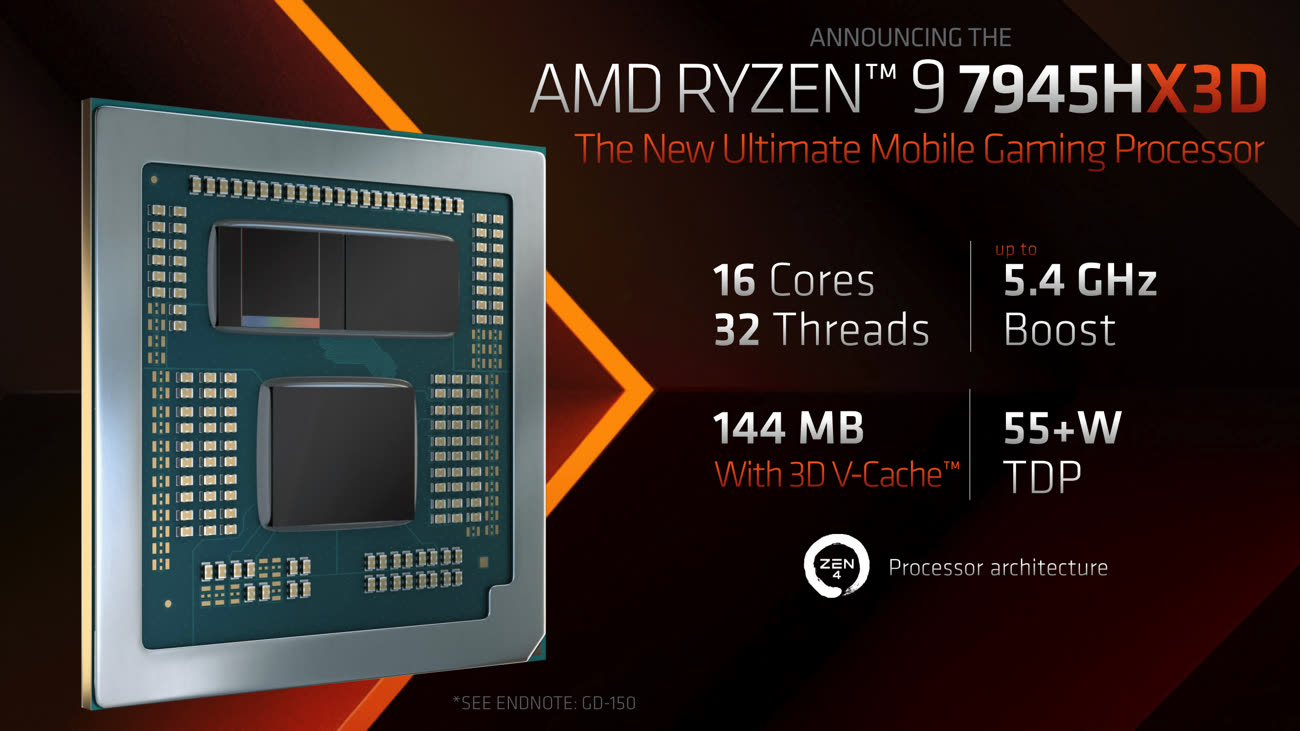

AMD vient d'annoncer le Ryzen 9 7945HX3D1, un processeur pour les PC portables très haut de gamme. Il intègre en effet de la mémoire cache 3D V-Cache, une technique qui permet d'améliorer très nettement les performances dans les jeux.

La mémoire 3D V-Cache est une technologie qu'AMD a pour le moment employée uniquement dans quelques processeurs pour les joueurs et uniquement dans des puces dites desktop, c'est-à-dire qui visent les PC fixes. Elle consiste à placer une puce de 64 Mo de mémoire cache de niveau 3 directement au-dessus d'un des chiplets du processeur, pour augmenter la capacité totale. Dans le Ryzen 9 7945HX3D, elle passe de 64 Mo (dans le Ryzen 9 7945H)à 128 Mo au total.

AMD gagne la palme des CPU les plus rapides dans les jeux avec les Ryzen "3D"

Pour bien comprendre la manœuvre, il faut expliquer le principe des chiplets : les Ryzen d'AMD sont des puces modulaires. Le CPU se compose en effet de plusieurs petits composants, les chiplets, ce qui permet de réduire les coûts de production tout en segmentant plus facilement la gamme. Un Ryzen 9 comme celui-ci contient donc 16 cœurs au total, sous la forme de deux chiplets comprenant chacun 8 cœurs et 32 Mo de mémoire cache. Un troisième chiplets va gérer la RAM mais aussi la partie graphique, qui intègre deux unités RDNA 2. Ce GPU intégré a peu d'intérêt dans le cas du Ryzen 9 : la puissance de calcul est très faible et il sert essentiellement à afficher l'OS et décoder de la vidéo. Dans la pratique, les PC portables équipés d'un Ryzen 9 intègrent habituellement une carte graphique dédiée, bien plus puissante.

Nous venons de le voir, le CPU contient donc deux chiplets pour les cœurs, et l'un d'entre eux est relié à la mémoire 3D V-Cache. Pour éviter les soucis avec cette configuration asymétrique — huit cœurs disposent de 96 Mo de cache, les huit autres de 32 Mo —, AMD propose des outils qui optimisent la gestion des threads et des applications. Pour le reste, le processeur a une fréquence maximale de 5,4 GHz et une fréquence de base un peu inférieure à celle de la version classique (2,3 GHz contre 2,5 GHz). Dans la pratique, AMD annonce des gains de 11 à 23 % en fonction de la limite de consommation.

Des performances élevées, comme la consommation

Le Ryzen 9 7945HX3D devrait être plus rapide qu'une puce Apple M2 Max, tant grâce à sa mémoire cache que son nombre de cœurs (16 cœurs, 32 threads) et sa fréquence maximale. Mais les performances ont un coût… énergétique. En effet, le processeur doit disposer d'une bonne enveloppe thermique pour que l'utilisateur puisse profiter de sa substantifique moelle. Et cette enveloppe va dépendre en partie du fabricant du PC. AMD laisse en effet un peu de latitude aux intégrateurs, qui peuvent choisir le TDP — en simplifiant, la consommation moyenne — en fonction du système de refroidissement. Elle est annoncée comme étant de 55+ W, ce qui est assez vague, mais la documentation d'AMD montre des exemples avec un CPU limité à 40 W et d'autres à 70 W.

Il faut enfin noter que la mémoire 3D V-Cache permet paradoxalement de meilleurs gains avec un TDP limité : elle a plus d'influence sur les performances quand le CPU est limité en fréquence par son enveloppe thermique que quand la bride est lâchée. Enfin, comme avec les autres processeurs de ce type, certaines applications professionnelles sont encore une fois paradoxalement plus rapides sur la version classique : la mémoire peut limiter la fréquence maximale, et certaines applications préfèrent la fréquence à la mémoire. Mais dans les jeux, les gains de la mémoire 3D V-Cache sont généralement importants.

Reste la question du prix, car si la puce est probablement plus rapide que le M2 Max d'Apple, les PC portables équipés risquent d'être particulièrement onéreux. Comme ils visent les joueurs, les premiers modèles disponibles comme l'Asus Rog Strix Scar 17 repéré par Les Numeriques devraient être vendus entre 3 400 et 3 700 €. Pour ce prix, vous aurez évidemment la version mobile de la GeForce RTX 4090, elle aussi très nettement plus puissante que la partie graphique des M2 Max d'Apple.

-

La personne qui détermine les noms n'a pas encore été licenciée. ↩︎