Vous le savez : nous approchons à grands pas du premier avril 2026, qui marquera le cinquantième anniversaire d'Apple. Un demi-siècle pendant lequel les innovations de la marque à la pomme ont pris une place de plus en plus importante dans notre quotidien.

iPhone, Mac, pour ses 50 ans, Apple se réveillerait comme jamais : la semaine Apple

"Apple : les 50 premières années", le livre de David Pogue

Les technologies conçues à Cupertino ont envahi nos bureaux, nos maisons, nos étagères, et même le moindre recoin de nos poches et de nos vies.

Et vous, quand avez-vous rejoint l'aventure ?

À l'occasion de cet anniversaire, nous aimerions recueillir vos témoignages. Peu importe que vous soyez nés de la dernière pluie d'iPhone ou d'un antique déluge d'Apple II. Chacun a sa place dans cette histoire qui nous rassemble, souvent pour le meilleur, et quelquefois, pour le pire.

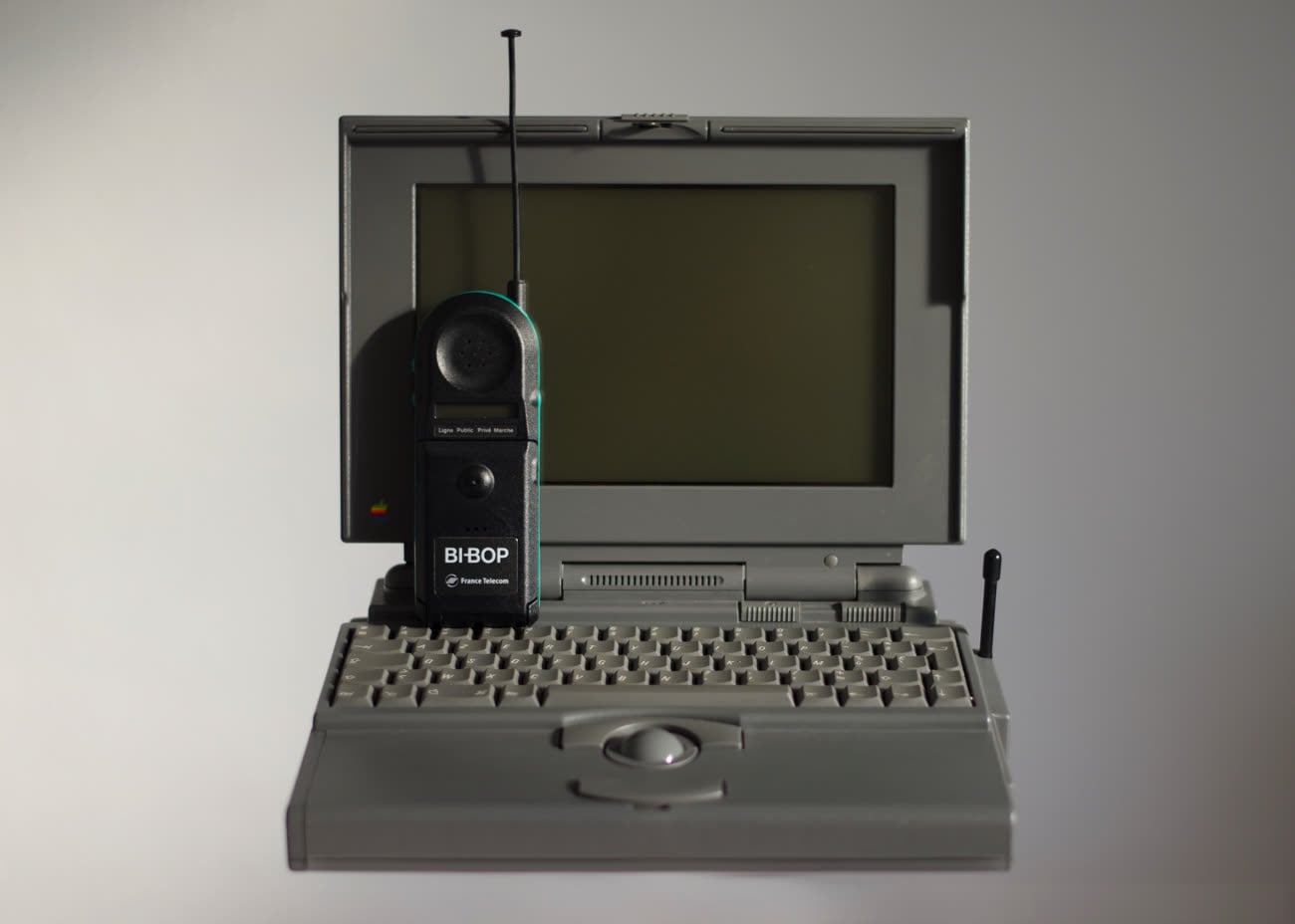

Il y a ceux qui n'oublieront jamais la découverte du premier iMac sur un coin de table dans le rayon informatique tout beige d'une Fnac de province. Ceux qui ont craqué pour une paire d'AirPods juste à cause du petit clac ! que fait leur boîtier quand on le ferme. Et ceux qui attendent encore le G5 à 3 Ghz promis par Steve Jobs.

Certains se souviendront toute leur vie du chargement des extensions pendant le démarrage de Mac OS 9, tandis que d'autres ont découvert Apple avec iTunes sur Windows, Safari sur leur premier iPhone, ou une Apple TV reçue à Noël et qui a bien failli finir sur Le Bon Coin.

Bref, de l'Apple II au MacBook Pro M5, de QuickTime à Keynote, de Steve Jobs à Tim Cook, du succès de la LaserWriter au fiasco d'Apple Plans, on a tous traversé une partie de ce demi-siècle avec Apple.

La parole est à vous, chers lecteurs !

Nous vous ouvrons tout grand nos pages — comme toujours — pour partager vos souvenirs les plus marquants de cette histoire déjà longue. Belles rencontres, logiciels adorés, expériences marquantes, horribles bugs, pires plantages, petites mesquineries et autres madeleines de Proust, dites-nous ce qui vous passe par la tête quand vous pensez à Apple.

Nous avons peut-être un projet derrière la tête à ce sujet… Le contraire aurait été étonnant, de la part d'une équipe qui accompagne Apple et sa communauté francophone depuis plus de la moitié d'un demi-siècle !

Pour participer à cet appel à témoins pas comme les autres, vous pouvez :

- réagir dans le commentaires

- participer au sujet dédié sur nos forums

- nous écrire un mail à 50ans@macg.co

A vous de jouer !