Depuis quelques mois, une rumeur bruissait1 : la fonction CSAM (Child Sexual Abuse Material) prévue au départ pour détecter les images pédopornographiques dans les photothèques des clients d'Apple aurait été activée dans le Finder de macOS. Or, il n'en est rien.

La première chose à expliquer est simple : devant les différentes réactions négatives à sa technologie, Apple a officiellement abandonné son projet de détection d'images pédopornographiques. Le Finder ne tente donc pas de détecter ce type d'images et n'envoie pas les données aux serveurs d'Apple. Le développeur Howard Oakley l'a bien expliqué sur son blog The Eclectic Light. Pour autant, le Finder envoie bien certaines informations à Apple.

La détection des données dans les images

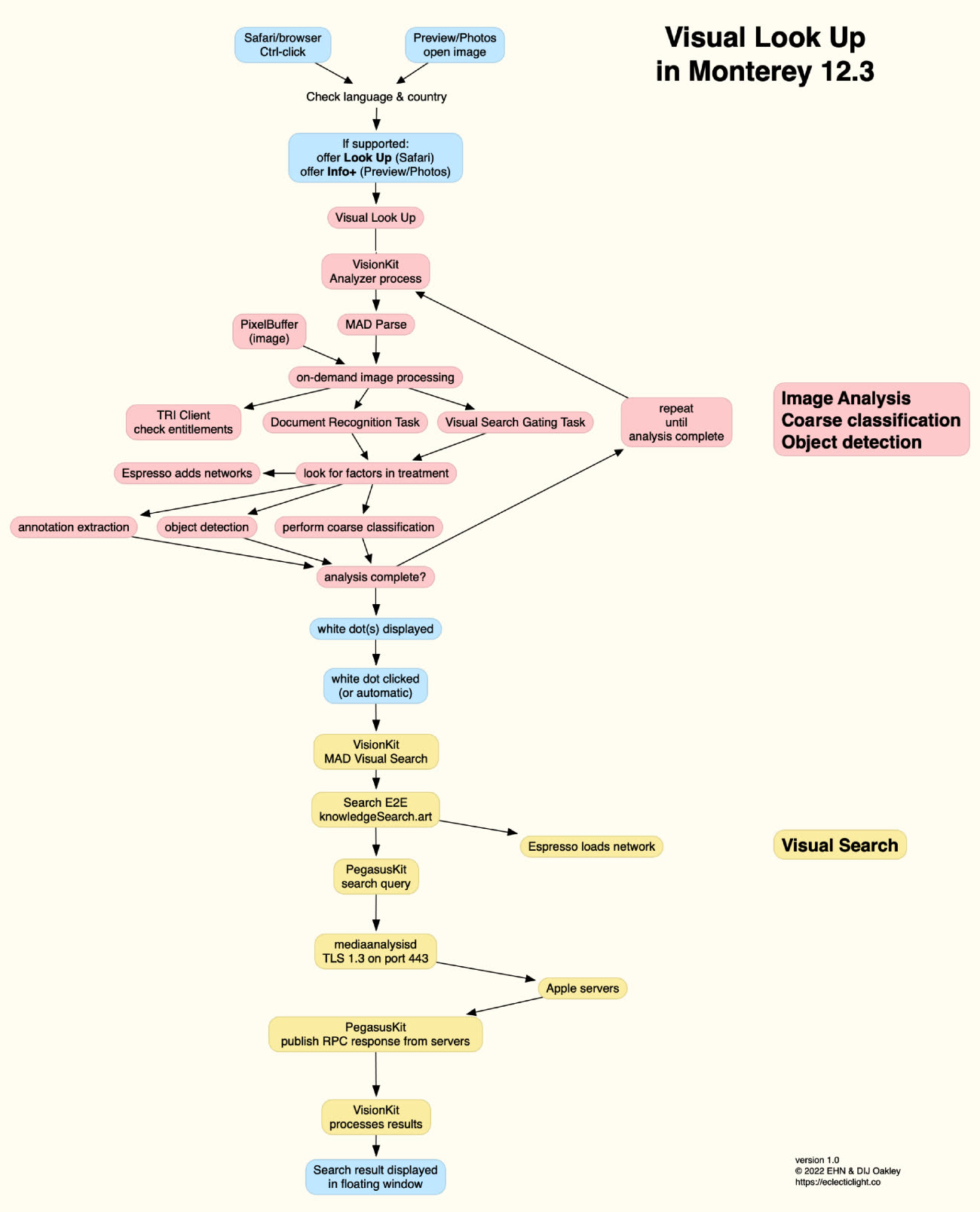

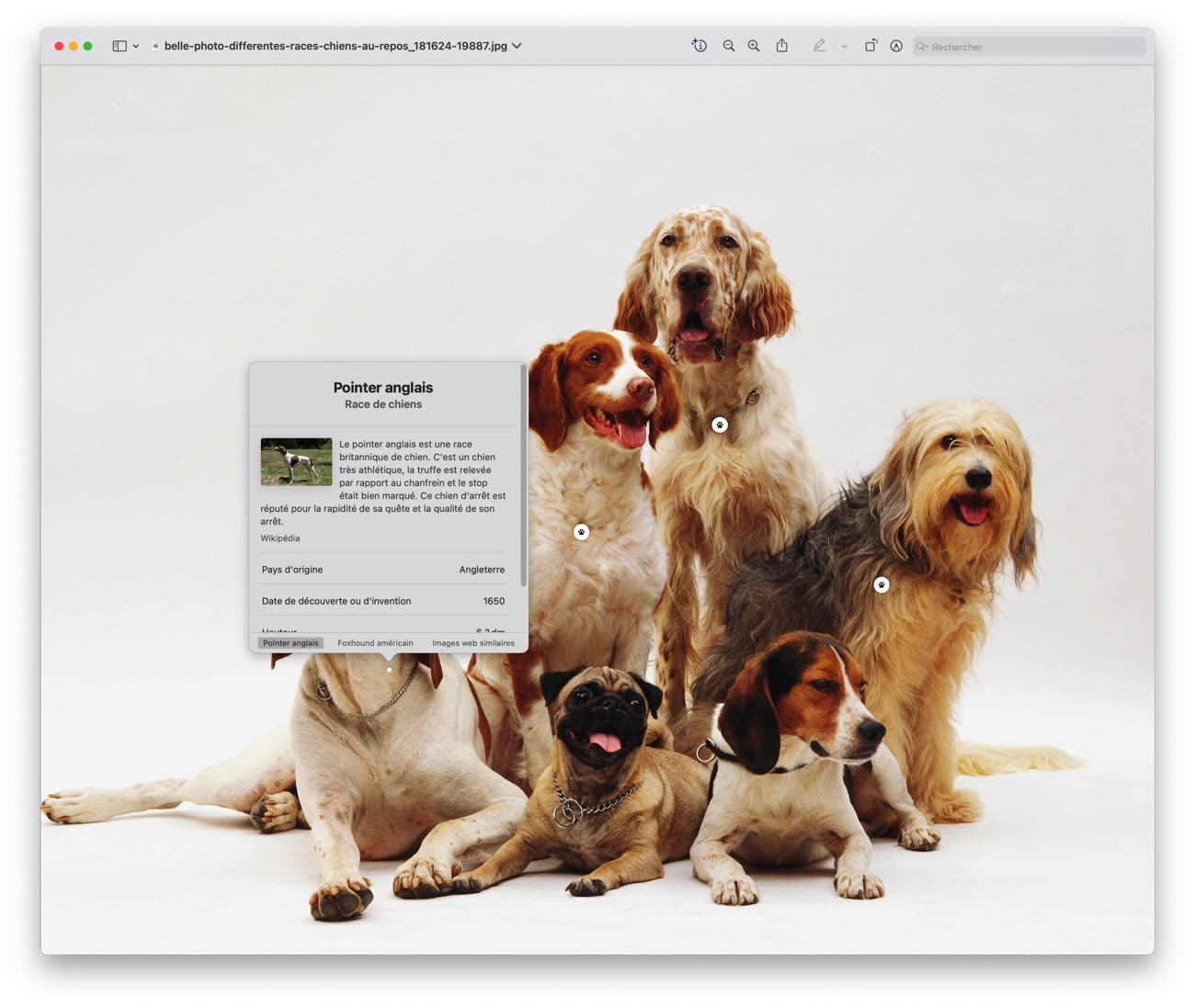

La rumeur a en réalité un fondement : la technologie Visual Look Up. Elle permet de détecter le sujet de certaines images, comme les chats, les chiens, des peintures, etc. Nous n'allons pas vous détailler toutes les étapes de la détection, mais votre Mac va analyser le contenu de chaque image affichée, effectuer différents traitements et créer un neural hash. Ce dernier va être comparé à d'autres neural hash et à la fin du processus l'envoyer sur les serveurs d'Apple pour obtenir les résultats, via le processus mediaanalysisd. La technologie fonctionne si vous ouvrez une image avec Aperçu, mais aussi avec Quick Look, par exemple.

Ce n'est pas un identifiant unique

La question que vous pourriez vous poser est simple : « Quelle est la différence avec la détection d'images pédopornographique ? ». Elle est légitime, mais vient d'une incompréhension : un neural hash n'est pas un identifiant unique ni même un identifiant d'une image. Il s'agit du résultat de différents traitements sur une partie d'une image, qui ne permet pas d'identifier une image en particulier ni de revenir à l'image originale. Il permet de vérifier que ce que macOS a détecté est probablement un chien (et le probablement est important), mais c'est tout.

Les tests dans une machine virtuelle montrent bien que seuls les neural hash sont transmis, et ils ne permettent tout simplement pas de déterminer le contenu de l'image complète ni de l'identifier. Et les images complètes ne sont évidemment pas envoyées chez Apple, ne serait-ce que parce que le volume de données serait absolument gargantuesque.

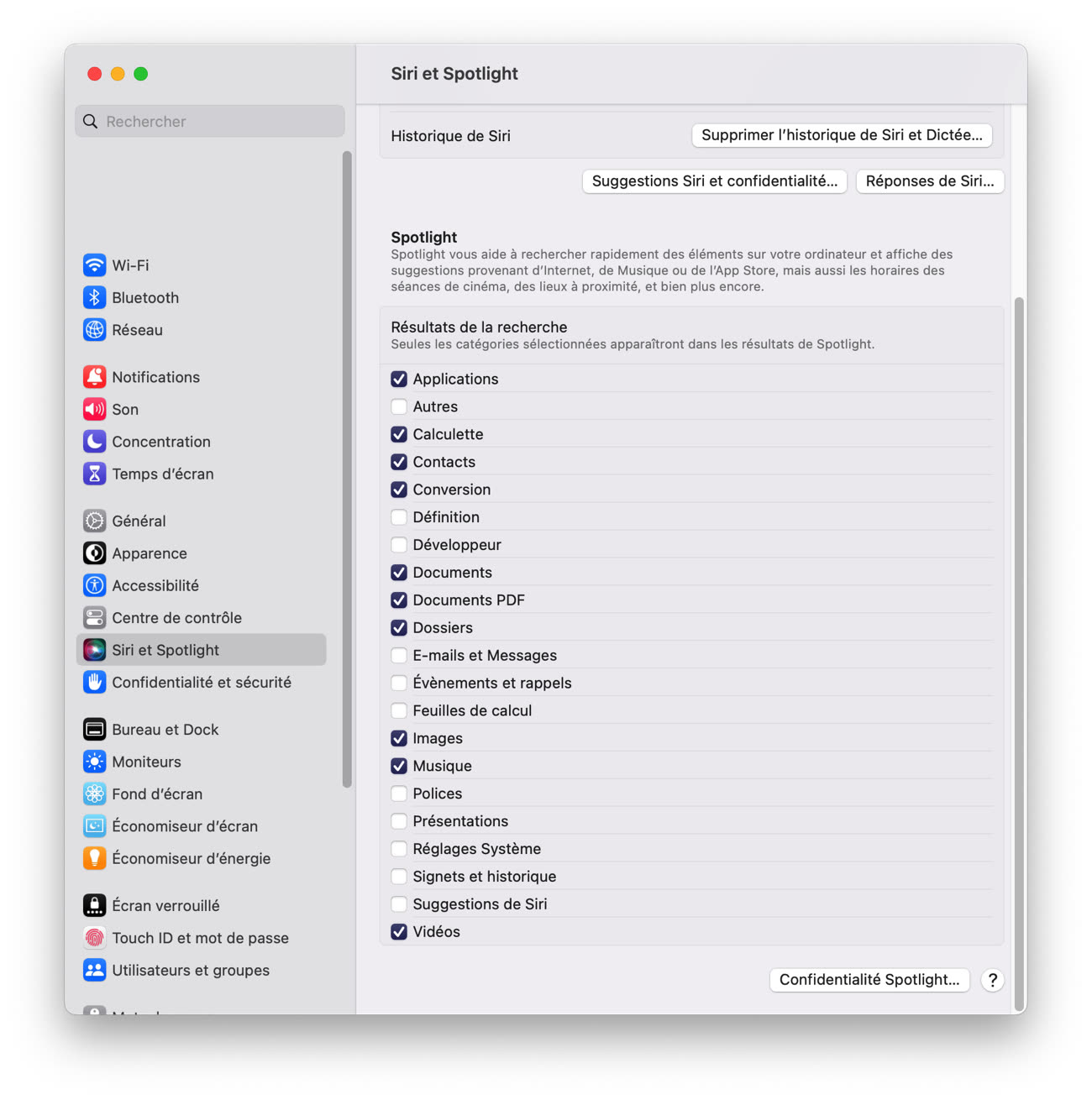

Si jamais vous n'avez pas envie d'envoyer les données à Apple, il est possible de désactiver la fonction. Dans Réglages Système > Siri et Spotlight, il faut décocher Suggestions de Siri dans Résultats de la recherche, et l'option disparaîtra.

-

Le lien renvoie vers une copie de la page, le message a été supprimé depuis. ↩︎