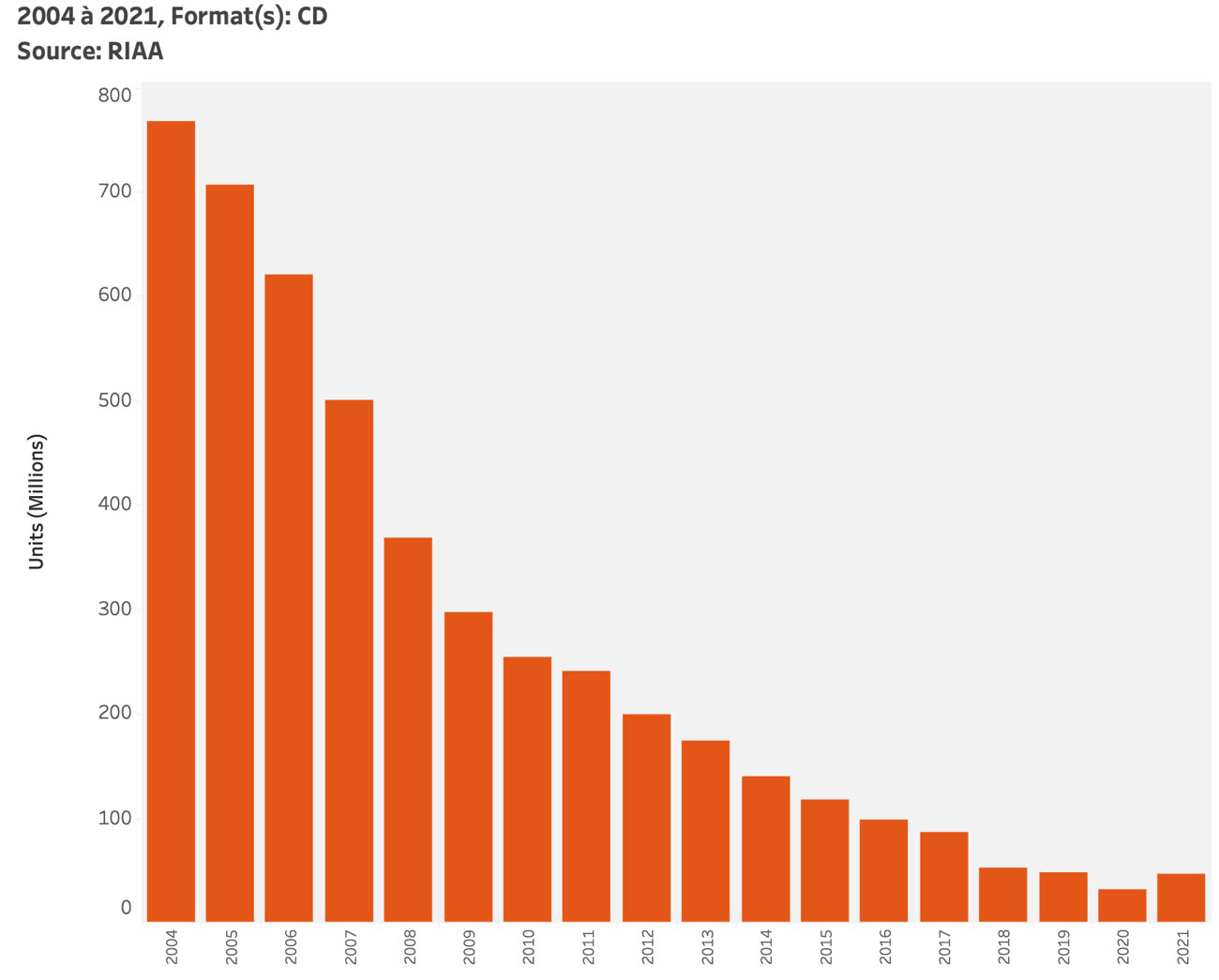

Après le vinyle, c'est au tour du CD de revenir sur le devant de la scène. Les ventes de disques ont augmenté pour la première fois depuis 2004 aux États-Unis selon les données recueillies par la Recording Industry Association of America (RIAA). Les chiffres du CD étaient en chute libre depuis 2004, une période où 767 millions de disques s'étaient écoulés. En comparaison, l'année 2020 a été la pire année pour le support avec seulement 31,6 millions de galettes vendues.

Mais les ventes sont reparties à la hausse en 2021 avec 46,6 millions de disques écoulés, ce qui représente une jolie hausse de + 47,7 % par rapport à l'année précédente. Les revenus engrangés par le CD sont passés de 483,2 millions de dollars à 584,2 millions de dollars. Si l'on parle souvent du grand retour du vinyle, le CD conserve tout de même plusieurs avantages : « la qualité sonore est très bonne, le format est petit, pratique, peu onéreux à produire et usant moins de matières problématiques que le vinyle », analyse Sophian Fanen, auteur du livre Boulevard du stream.

En France, les chiffres ne sont pas encore connus, mais on peut s'attendre à une hausse similaire. Récemment, plusieurs artistes ont décidé de mettre le CD en avant dans leurs campagnes promotionnelles. Les rappeurs Orelsan et Vald ont par exemple proposé des versions différentes de leurs albums (5 éditions différentes pour V, 15 pour Civilisation). Pour Sophian Fanen, l'achat d'un CD permet aux fans de soutenir et de montrer leur attachement aux artistes.

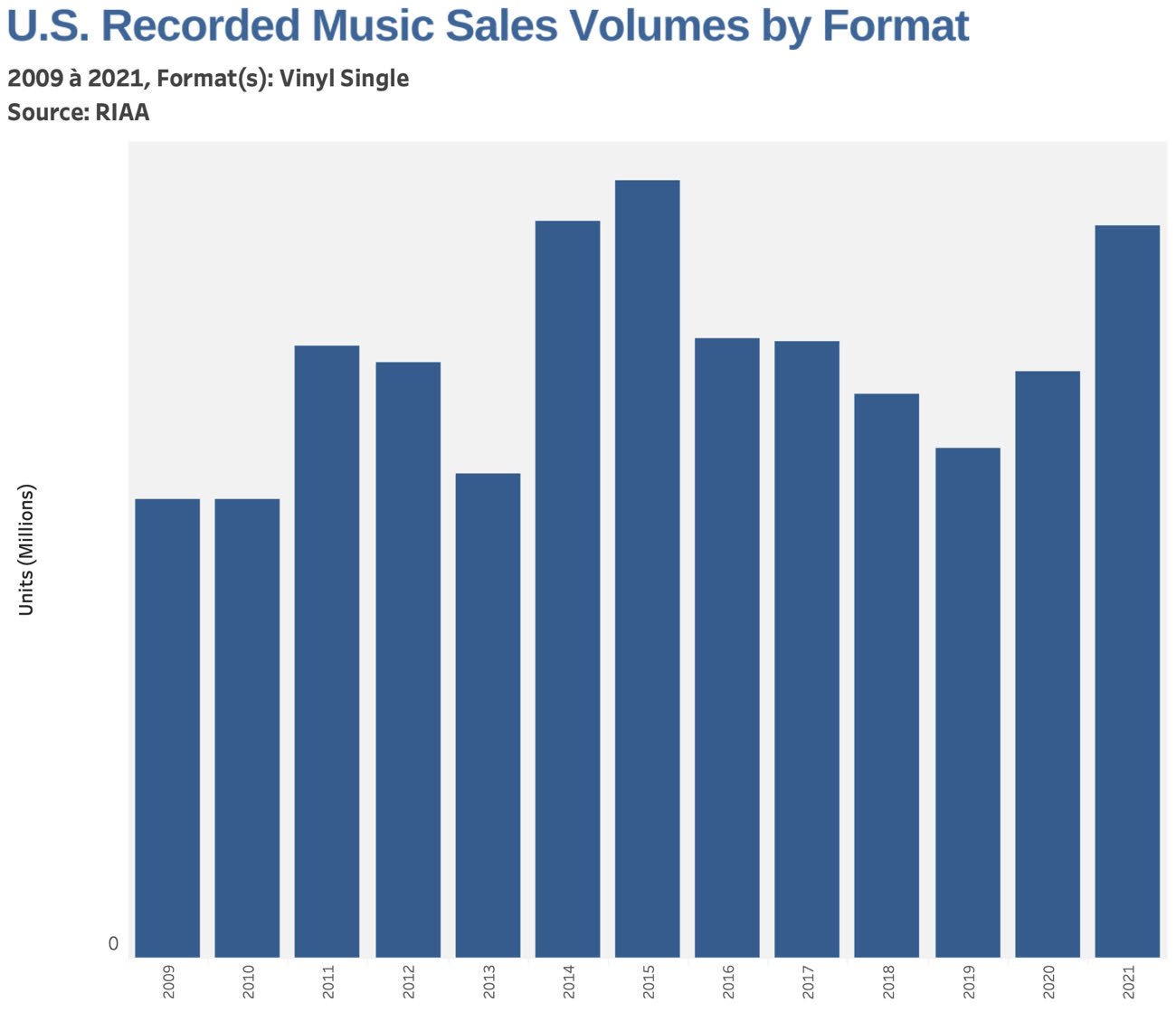

En parallèle, le vinyle continue de bien se porter. Le support aurait représenté 23 % des ventes de disques au Royaume-Uni en 2021 selon les chiffres de l’industrie phonographique britannique (BPI). Adele aurait fait presser plus de 500 000 vinyles de son album 30. Lors de l'avant-dernière semaine de décembre 2021, les ventes de vinyle ont dépassé les 2 millions d'exemplaires d’après MRC Data : une première depuis 1991.

Cependant, cette bonne lancée pourrait être arrêtée nette par des problèmes d'approvisionnements. Les usines de vinyles en activités ne sont pas nombreuses, et les embouteillages sont fréquents en période de fin d'année. De plus, une hausse des prix est prévue suite à différentes pénuries de composants. Si ce retour du support physique est intéressant, rappelons que le streaming reste de loin la plateforme la plus en vogue : les abonnements payants ont rapportés plus de 8,6 milliards de dollars aux États-Unis et représentent plus de 57,2 % des revenus mesurés par la RIAA.