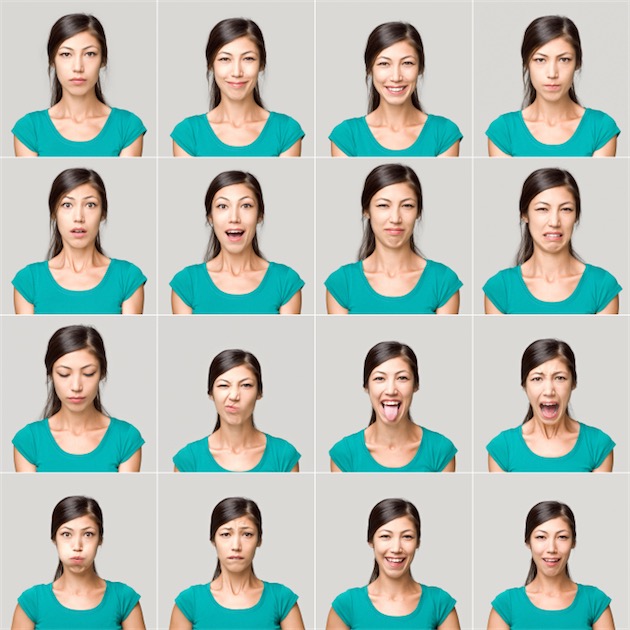

Apple s'est offerte une nouvelle startup, baptisée Emotient. Cette information du Wall Street Journal a été confirmée par Apple, sans plus de commentaires. Emotient utilise des techniques d'intelligence artificielle pour analyser les expressions faciales, brèves ou plus longues, et en déduire les émotions exprimées par le visage des sujets.

Le quotidien explique qu'Emotient a travaillé avec des clients dans le domaine de la santé et du commerce. Dans le premier cas des docteurs essayaient de comprendre les signes de douleur exprimés par des patients qui ne pouvaient les formaliser. Dans l'autre, il s'agissait de voir comment des personnes réagissaient à des publicités ou face à des articles lors de leurs déambulations dans un magasin. Emotient a travaillé aussi avec Accenture pour tenter de voir s'il était possible d'anticiper la réponse d'un client face à une proposition financière.

Cette entreprise de San Diego avait précédemment levé 8 millions de dollars auprès d'un fonds d'investissement d'Intel, poursuit le quotidien, mais elle n'avait pu obtenir de nouveaux fonds.

Dans une vidéo de présentation de sa solution, Emotient donne quelques exemples d'utilisation. Comme de trier des images dans une base de photos en fonction des expressions des visages. Un autre implique une automobiliste avec un assistant de conduite qui chercherait à proposer un nouvel itinéraire en fonction de l'humeur décelée par le conducteur.