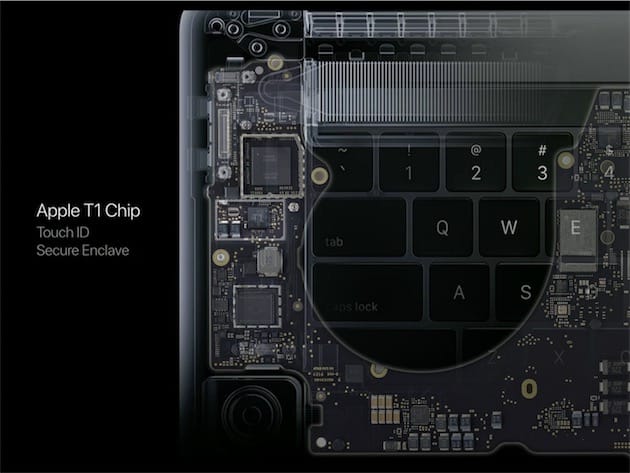

La petite puce T1 présente dans les nouveaux MacBook Pro pour gérer la Touch Bar et Touch ID pourrait bien être un cheval de Troie signé Apple. D'après Bloomberg, le constructeur a bien l'intention de confier à cette puce plus de fonctions dans l'avenir, quitte à déshabiller petit à petit les processeurs Intel.

Ce processeur, dont le développement a débuté l'an dernier, porte le nom de code T310. Basé sur une architecture ARM — la même au cœur des puces Ax des produits iOS —, il prendrait en charge des fonctions basse consommation, laissant donc le soin au processeur Core le traitement des tâches les plus lourdes.

Power Nap serait une des fonctions prises en charge par cette nouvelle puce nouvelle génération : présente dans OS X depuis Mountain Lion en 2012, elle a pour mission de récupérer les courriels, installer des mises à jour, synchroniser les rendez-vous, etc. pendant que l'écran est éteint et l'ordinateur en veille. Cette fonction consomme déjà peu d'énergie avec un processeur Intel, mais Apple veut aller encore plus loin et épargner au maximum la batterie. Un sujet particulièrement sensible, en particulier sur les derniers MacBook Pro.

De fait, cette puce T310 — T2 ? — aurait des connexions avec plus de composants que la T1 actuelle ; elle pourrait ainsi se lier d'amitié avec le stockage du Mac, et des composants réseau. On ne parle toujours pas de Mac ARM à proprement parler, Apple ayant visiblement choisi la politique des petits pas.

D'ailleurs, Bloomberg assure que le constructeur n'a pas en projet de lâcher Intel, du moins pas à court terme. Néanmoins, cela fait cinq ans qu'Apple explorerait la possibilité d'abandonner son partenaire de Santa Clara afin d'améliorer l'efficacité et les performances de ses ordinateurs. On pourrait rencontrer cette future puce dès les prochains MacBook Pro, plus ou moins programmés en fin d'année.