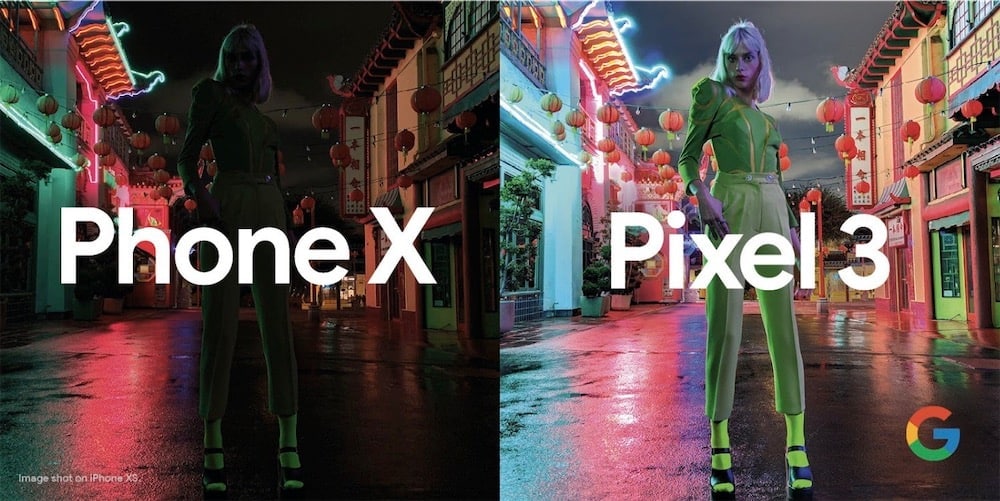

Partagée sur Twitter par un responsable produit marketing de Google, ce visuel compare une prise de vue de nuit sur un "Phone X" (qui se trouve être un iPhone XS, comme écrit en petit) et la même scène avec le mode Night Sight des Pixel 3 (lire aussi Un Pixel 3 XL entre les mains d'un utilisateur d'iPhone & Les Pixel 3 repoussent les limites de la photographie informatisée).

Chez Apple, le sujet est plongé dans le noir et le décor coloré en arrière plan restitué dans l'ambiance nocturne. Chez Google, le sujet est parfaitement visible et le fond très éclairé, peut-être un poil trop. Sans la personne dans le champ, la photo sur iPhone aurait pu se défendre face à celle de Google qui tend vers un rendu artificiel. Mais avec le sujet en plein milieu, la photo du XS devient difficilement exploitable, même pour un banal partage. Ce comparatif est peut-être le prélude à une vaste campagne de la part de Google. Coïncidence, une promo de 200 € est en cours sur les Pixel 3, ici comme ici ou là (Merci B.) et via 9to5Google.