Apple M1 : Intel se défend en utilisant de grosses ficelles

Piqué au vif par les performances remarquables de la première puce Apple Silicon, Intel se défend finalement de manière frontale. La firme de Santa Clara a transmis à des sites orientés PC, PCWorld et Tom's Hardware, des benchmarks qui sont en sa faveur. Le procédé est connu et utilisé par tous les fabricants : il s'agit de choisir soigneusement les tests en ne retenant que ceux qui sont favorables…

Intel oppose la puce M1 (dans le MacBook Pro équipé de 16 Go de RAM) au processeur Core i7-1185G7, une puce de 11e génération gravée en 10 nm (avec là aussi 16 Go de RAM). Cette puce a un TDP de 28 W (configurable jusqu'à 12 W), 4 cœurs / 8 threads, une fréquence de base de 3 GHz (configurable à 1,2 GHz) et une fréquence Turbo jusqu'à 4,8 GHz.

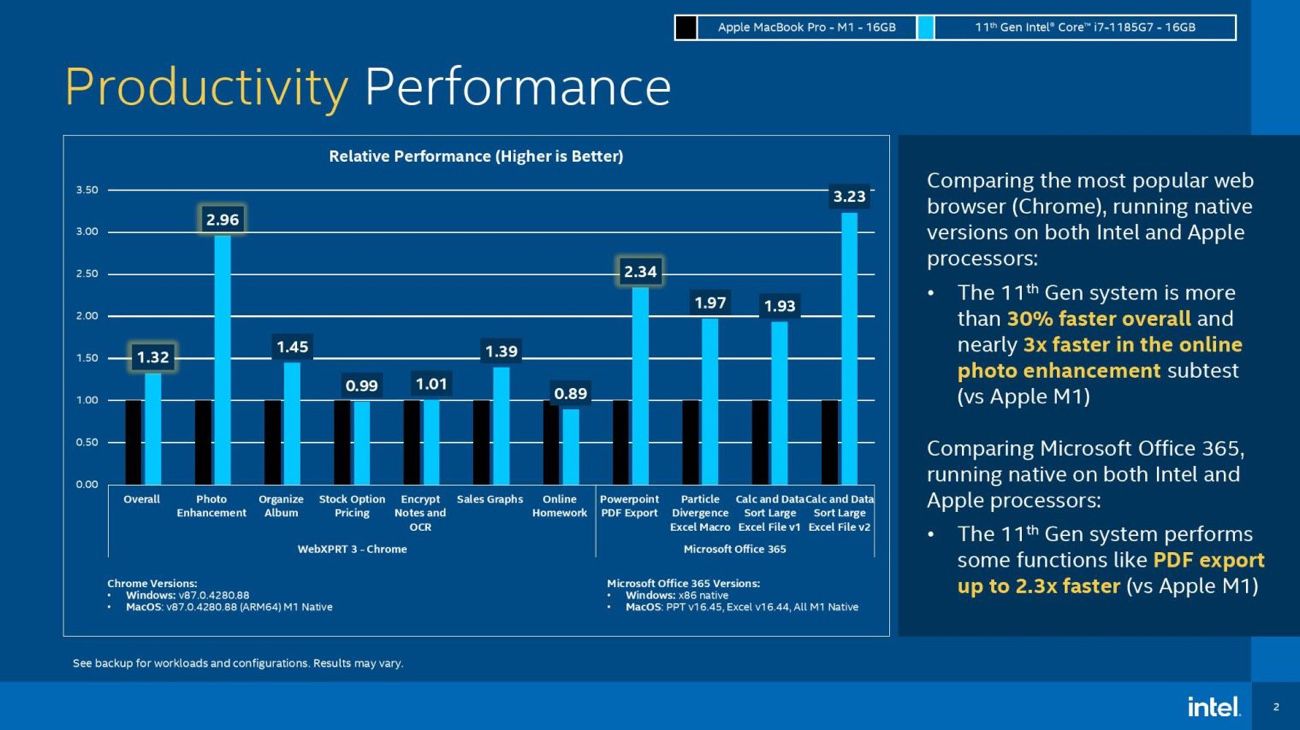

Sur le test WebXPRT, qui s'intéresse aux performances web, réalisé avec Chrome 87, Intel assure que sa puce est globalement 32 % plus rapide que la M1. Sur Office 365 (version x86 d'un côté contre version Apple Silicon de l'autre), Intel met par exemple en avant un export de PDF 2,3 fois plus rapide sur PowerPoint.

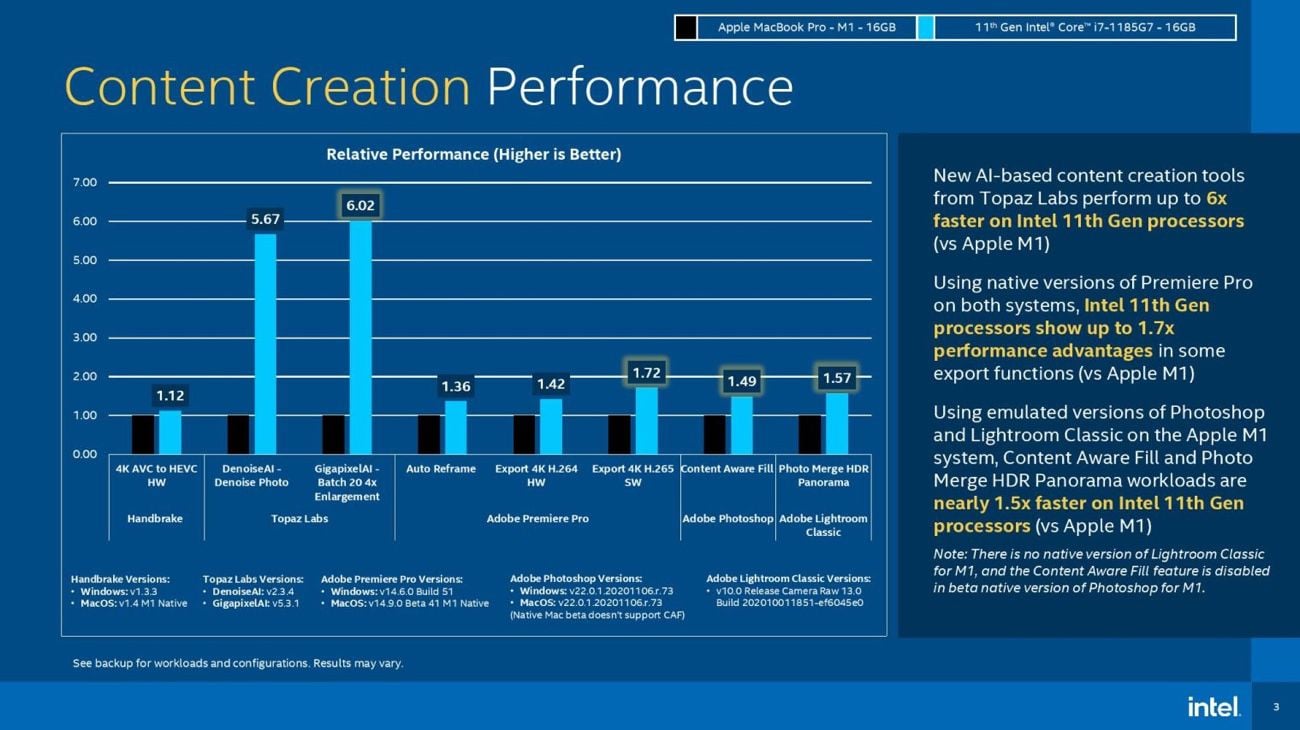

Concernant les logiciels créatifs, Intel note une petite avance en sa faveur sur Handbrake, lors de la conversion d'une vidéo 4K AVC en HEVC. L'écart est bien plus important sur les logiciels de Topaz Labs, où les opérations sur les photos sont environ 6 fois plus rapides avec le Core i7.

Sans nier le résultat, il faut néanmoins préciser que les applications de Topaz Labs font partie des rares à tirer parti de l'accélération matérielle des puces Intel, et qu'à l'inverse elles ne sont pas encore optimisées pour l'architecture Apple Silicon. Intel a bien évidemment choisi les applications et même les tâches les plus avantageuses. Apple pourrait tout aussi bien répliquer en sortant des graphiques où Pixelmator Pro apparait comme 15 fois plus rapide sur M1 que sur Core i7, pour ne citer qu'un exemple.

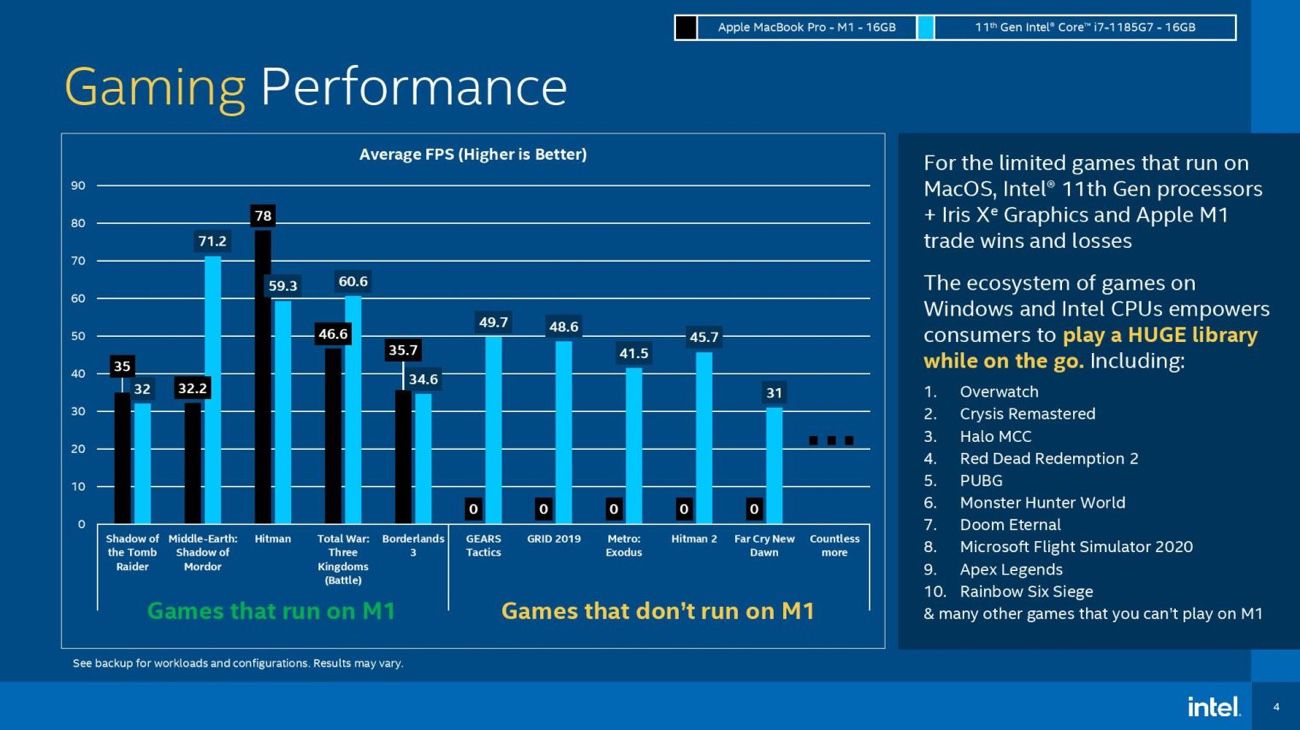

Dans la série de diagrammes qui concerne les jeux, Intel concède que l'Apple M1 peut parfois faire mieux que son processeur (les jeux sur lesquels la M1 est en retrait sont ceux qui tournent via Rosetta). Mais ce graphique sert en fait de prétexte pour montrer que de nombreux jeux ne sont pas compatibles avec macOS, ce qui est indéniable, mais ne date pas de l'architecture Apple Silicon.

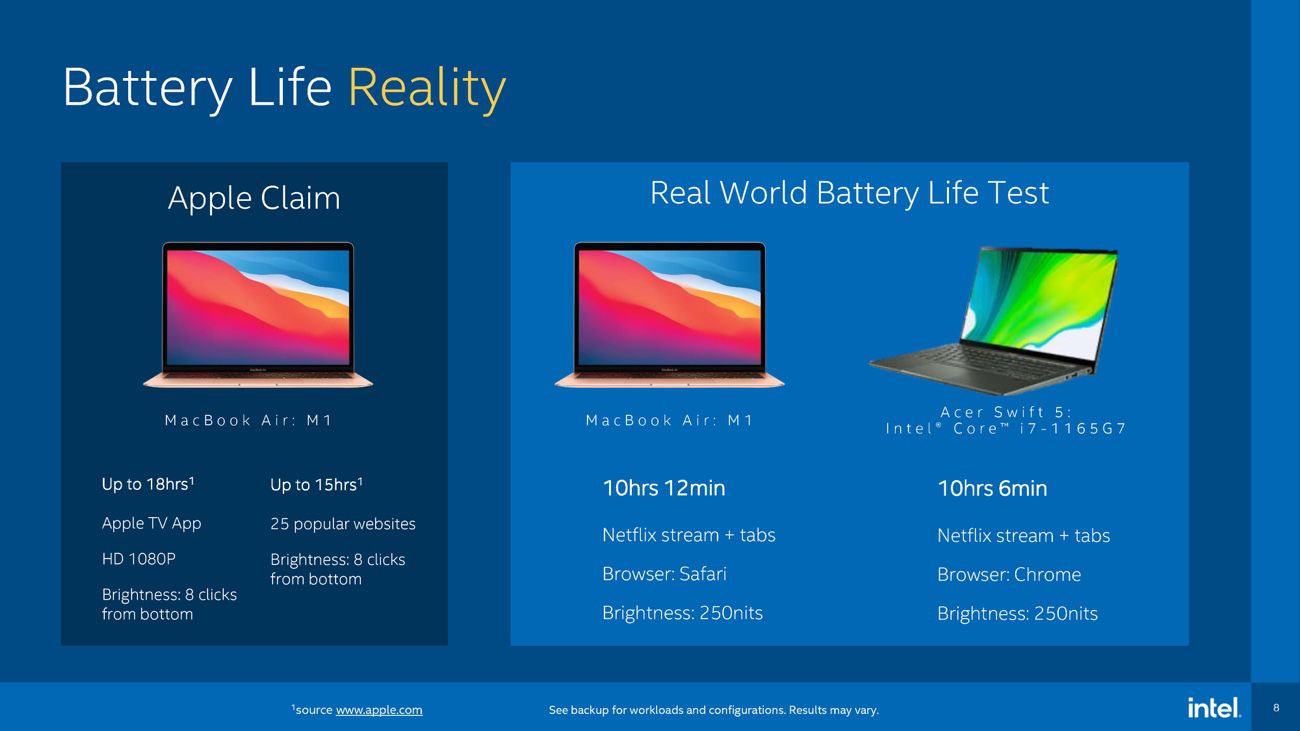

Intel ne s'arrête pas là. Une autre diapositive montre que l'autonomie « réelle » n'est pas si différente que ça entre un Mac et un PC. Sauf que ce n'est plus le MacBook Pro M1, le champion en la matière, qui est pris en guise de comparaison, ni même le Core i7-1185G7. La firme de Santa Clara préfère mesurer le MacBook Air M1 à l'Acer Swift 5 équipé d'un Core i7-1165G7 moins puissant. Selon son test de navigation web et de Netflix, le MacBook Air tient uniquement 6 min de plus que l'Acer.

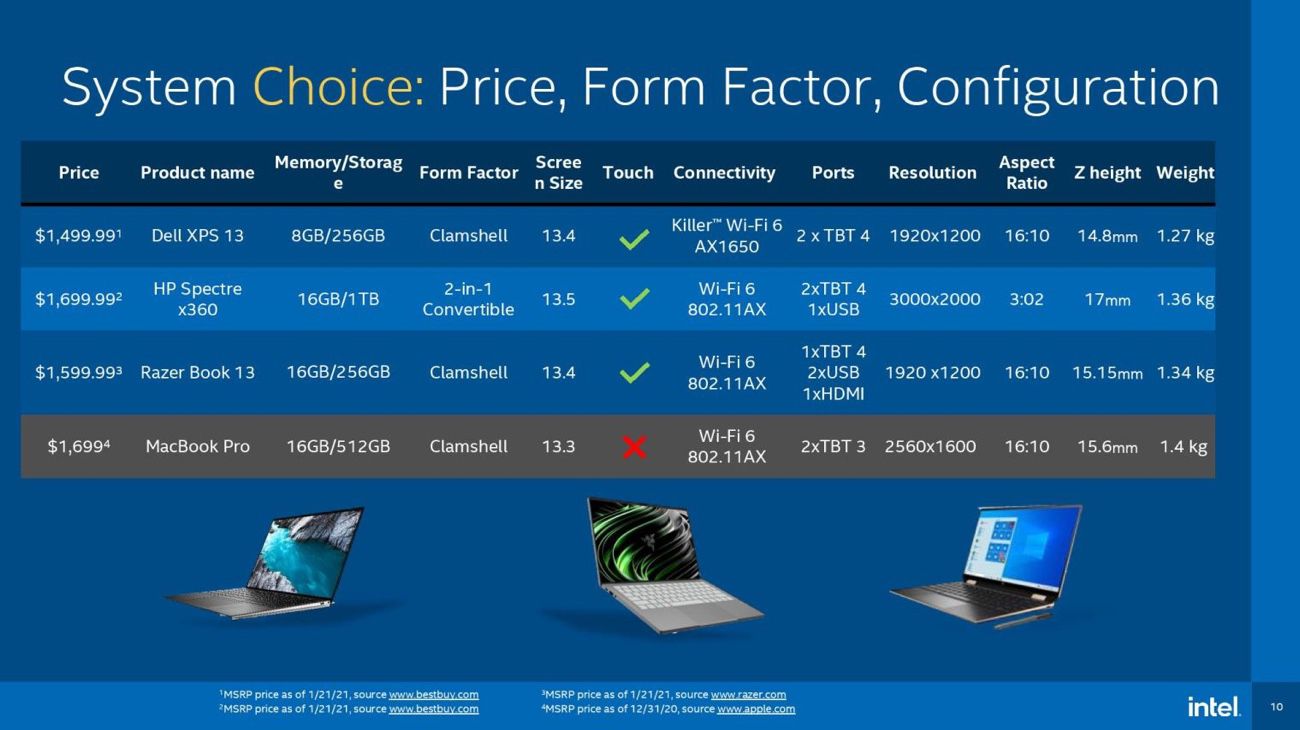

« Plus qu'une question de performances, c'est une question de choix », indique une autre diapositive donnant à voir des ordinateurs aux formats différents. Intel joue aussi la carte des fiches techniques qui montrent un MacBook Pro pas aussi attractif que les PC concurrents, mais les caractéristiques présentées omettent notamment le processeur et l'autonomie. D'autres diapositives pointent l'absence de prise en charge des eGPU sur les Mac M1, la gestion d'un seul écran externe par le MacBook Air/Pro ou encore l'absence d'écran tactile.

Bref, tous les inconvénients que l'on peut trouver aux Mac M1, Intel prend grand soin de les souligner. Si certains arguments et benchmarks sont valables, d'autres sont discutables. L'exercice est de toute façon biaisé dès le départ, puisqu'il s'agit de montrer la supériorité des puces Intel coûte que coûte, c'est-à-dire en triant sur le volet les tests et éléments de comparaison.

C'est de bonne guerre, Apple fait après tout la même chose quand elle vante les progrès extraordinaires de la puce M1, à la différence près que le nom d'Intel reste discret dans sa communication. Finalement, si la firme de Santa Clara se sent obligée de publier toutes ces comparaisons en sa faveur — alors même qu'elle fournit toujours des puces pour une partie des Mac —, n'est-ce pas parce qu'elle se sent menacée par le mouvement impulsé par une « société lifestyle de Cupertino » ?

En fait ça illustre surtout le retard énorme d’Intel…

'tain, ça brasse des milliards, ça domine la tech mondiale depuis douze mille ans, ça emploie je ne sais pas combien de milliers de personnes, si on compte les sous-traitants ça a le chiffre d'affaire d'un état et au final quoi ?

Concours de bites !

C'est vraiment ridicule.

@ BordelInside

pour "ceux qui savent", un PC sous Windows équipé d'un CPU Intel n'a, à date, que très peu d'intérêt face à un Mac sous M1, niveau puissance, niveau autonomie, niveau prix ... pas mal Apple

Je parle d'un PC "équivalent", bien sur...

Bon

Mais au final, il faut garder son sang froid et avoir du recul. Déja, nombre d'utilisateurs, même au fait de la science technique, cherchent avant tout un PC sous Windows. Apple va croquer des pdm au marché PC, mais rien de significatif.

Le vrai concurrent d'Intel s'appelle AMD, et pas Apple.

AMD croque des pdm à Intel progressivement, alors pas un raz de marrée, certes, mais ça commence à compter tout de même, et sur toutes les gammes : les ultra books, les PC bureautique, les stations de travail, les machines de gaming, etc, etc, le ryzen se décline de partout en affichant, à chaque fois, mieux pour moins cher.

Et même là, Intel tremble, mais Intel reste majoritairement le plus gros vendeur de CPU et de loin

Donc voila, c'est bien de se toucher la nouille avec nos M1, et on a raison, on a fichtrement raison, mais il faut aussi raison garder et avoir conscience de qui tient le marché, et qui tient le marché c'est Intel

@pocketlatex

Justement, de la part de Intel cette pub en forme de concours de zob me paraît un peu ridicule - je ne voulais rien dire de plus que ça ;-)

(comme je trouve parfaitement ridicule les discours de certains sur la chute imminente et bien mérité du goliath Intel sous les coups surpuissants du David-M1 - et je ne parle même pas de ce que je pense de se sentir très supérieur parce qu'on a acheté un ordi avec une puce dedans que les tests disent qu'elle est mieux que la puce d'en face... ;-)

Laissons leur ce baroud d’honneur 🤷♂️

Quand Apple sortira le M2, la messe sera dite ☠️

@Sgt_Pepper

Ouais, enfin un baroud d'honneur, normalement c'est assez glorieux, plutôt court et tu meurs à la fin.

Là...

@BordelInside

là le mourant releve le bras ensanglanté en gromelant un « rhaaaaaaaaa »

:D

Tiens, ça me donne envie de revoir "The Party"

@BordelInside

on est en train de regarder la fin de Game of thrones, c’etait trop facile, on voit ca tous les soirs en ce moment :D

@raoolito

Argh, la fin de GoT...

Là, c'est la décence, la cohérence et la dignité qui ont eu une mort de m... sans même un dernier baroud d'honneur...

Et ce biiiiiiip de Georges RR Martin qui fait n'importe quoi au lieu d'écrire la suite de ses p... de bouquins.

Ah ça y est, je suis énervé, j'vais aller péter des trucs !!!!! :D

@BordelInside

« Et ce biiiiiiip de Georges RR Martin qui fait n'importe quoi au lieu d'écrire la suite de ses p... de bouquins. »

N’importe quoi, pas vraiment. Il bosse sur l’univers et le script des 5 futurs séries se passant dans le monde de GoT. C’est certainement plus facile pour lui, que d’écrire la suite de ses livres, vu qu’il n’est pas en bonne santé.

Perso, j’ai cessé de croire à la sortie de nouveaux livres GoT il y a 3 ans. Je m’attends davantage à attendre l’annonce du décès de GRRM très prochainement.

Et comme ce biiiip de biiip a annoncé avoir pris des mesures légales pour empêcher un autre auteur de reprendre la plume après sa mort, il faudras attendre la fin des droits d’auteurs (2070-2080), pour lire enfin ces ouvrages ..

@IceWizzard

"Perso, j’ai cessé de croire à la sortie de nouveaux livres GoT il y a 3 ans."

Ouais, je sais bien, moi aussi (quoi que plus récemment) - mais considérant la richesse des tomes existants je trouve ça...

(et j'aurais aimé avoir la "vraie" version de la fin parce que je n'ai pas du tout aimé la version portnawak baclée de la série)

Bref.

De toute façon il suffit d'utiliser les 2, ce qui est mon cas, pour constater la supériorité écrasante du MBA M1 sur n'importe quel portable Windows standard.

Quand on voit la gueule des slides, on se dit que c’est pas gagné....

C'est peut-être une pub déguisée pour Apple, non? Sérieux, déjà la présentation façon powerpoint année 90, ça fait sourire, après tout le reste c'est juste de la mauvaise fois, voire de la caricature. On peut trouver des defaults aux nouvelles machines M1 (J'ai retourné mon mac mini M1 à cause des bugs sur les écrans externes juste insupportables) mais Apple a signé une véritable révolution dans les Processeurs. Rien que le rapport Puissance/Watt fait rentrer Apple dans une autre dimension. Perso, je suis lassé de MS et Intel, toujours à promettre la lune, toujours a dire ça sera mieux la prochaine version, toujours a changer de direction sans aucune considération pour le consommateur. AMD (Ryzen) et Nvidia (RTX3XXX), j'aime déjà beaucoup plus mais ils sont dépendants de MS.

Et comme le fait remarquer Macwelt.de, Intel a curieusement oublié l'aspect "bruit", à savoir le bruit des ventilateurs qui sur PC Windows ne manquent pas de se faire très bien entendre.

Intel n'a pas trop le choix, elle a probablement été surprise par les perfs globales du M1.. donc il faut "absolument recoller au marché coûte que coûte" ! Les benchs sont toujours favorables à ceux qui les font, ils sont aussi faits pour ça quand ils ne sont pas établis par des entités indépendantes. Mais le quidam de la rue qui n'est pas forcément un spécialiste de ce genre de mesures, va être rassuré en voyant qu'au final les dégâts ne sont pas aussi grands qu'il imaginait.. voire qu'il n'y en a pas ?

Apple a choisi ses benchmarks, Intel a chois ses benchmarks.

Ca fait un peu rageux de couiner contre le marketing orienté d'Intel alors que notre Apple s'en est fait le chantre depuis des années.

C'est pas rageux non. Non, vraiment pas. Intel biaise ses benchs.

Il suffit de prendre les mêmes config avec 8 Go de ram et le M1 écrasera l'intel.

Il suffit de faire des benchs généreux sur toutes les fonctions des logiciels utilisés par Intel pour voir le M1 écraser le X86.

Ces slides c'est tellement de la mauvaise fois... Le seul endroit ou ils peuvent se targuer d'être meilleurs c'est la taille de la ludothèque, mais ce n'est pas grâce à leur gpu embarque hein !

Et encore World of Warcraft qui reste un des seul jeu optimisé m1 aujourd'hui n'est même pas mis en concurrence. Pourquoi ? Parce que le M1 bat X10 à plat de couture tous les cpu avec gpu intégrés intel...

Il y a une différence entre faire des slides pour dire "he là dans notre labo sur ces fonctions on le bat !" et tous les benchs indépendants qui sont sortis et qui écrasent intel et le mettent à la poubelle.

On ne parlera même pas de l'émulation de windows qui tourne mieux sur M1 qu'en natif sur machine dédiée de Microsoft : c'est une autre histoire mais ça en dit tout aussi long sur les qualités du M1.

Il n'y a vraiment personne pour faire des tests indépendants et objectifs ?

Cela demanderait d'utiliser le même logiciel de test avec les deux plateformes à tester, sans optimisation aucune pour une quelconque plateforme - si on ne veut vraiment tester que la puce.

Mais le vrai problème, c'est que la puce M1 ne contient pas qu'un processeur, elle contient bien d'autres choses dont un GPU. Et les core i3, 5, 7 aussi il me semble. Donc déjà à la base il est difficile de comparer vraiment les mêmes choses...

Finalement on ne peut comparer que des machines dans leur globalité.

Donc pour un test vraiment objectif, il faudrait que tous les autres composants hors "puce" soient identiques. Peut-on trouver de telles machines à comparer ?

@marc_os

ça ne marche pas vraiment comme ça, et je trouve qu'il y a un discours anti-bench assez étrange ici étant donné que ce type de "marqueur" est utilisé par l'ensemble de la presse informatique et par les passionnés "sérieux et reconnus" sur Internet depuis des décennies

Un bench c'est un marqueur, après il y a le bon bench et le mauvais bench. Le bon bench, tu lance le bench, ça donne un score et voila, c'est un bon bench. Le mauvais bench, tu lances le bench, bon.... ça donne un score et BIM ! Voila ! c'est un mauvais bench

Plus sérieusement, il existe des benchs "génériques" type Geekbench, et c'est franchement "pas mal", on va dire que ça donne une pas trop mauvaise idée de ce que la machine a dans le ventre, au global. Mais ce n'est pas la panacée non plus, et bien souvent après Geekbench, sont lancés d'autres benchs plus spécifiques, qui permettent de mieux savoir de quoi on parle

Cinebench R23, par exemple, est un excellent marqueur pour de nombreux usages autour de la post prod, des vfx, de la 3D (surtout avec Cinema 4D), etc

Il y en a d'autres pour d'autres métiers (audiovisuel, archi, ...), le truc c'est d'utiliser des benchs connus et reconnus, et pas sorti du petit chapeau magique

Et là, Intel, avec ses exports PPT plus rapide ... c'est pas qu'ils prennent un peu les gens pour des cons, du tout, je dirais plutot qu'ils prennent "curseurs poussés au max" les gens pour des cons, et la finalité est douteuse, sinon qu'ils se décrédibilisent. Pour un poid lourd pareil avouez que ça la fout un peu mal

Mais j'en reviens à mon propos principal : les benchs c'est très bien, mais quand on utilise des marqueurs universellement reconnus (c'est simple, c'est les mêmes peu ou prou sur tous les sites sérieux de review).

Là, on est pas vraiment dans ce cas.

Bouh Intel

Et quand Apple va passer le reste de la gamme MacBook Pro 16 mais surtout iMac et Mac Pro

Ça sent les cheveux blancs pour Intel 😁

Ce que je constate, entre un MacBook Pro 16" i9 16 GB et un Mac Mini M1 8 GB, c'est un silence et un confort d'utilisation à nulle autre pareil à mettre sur le compte du M1.

Là où le MacBook Pro transpire comme un boeuf et souffle comme un boeuf, le M1 travail sans broncher, sans bruit, de manière efficace et efficiente. Surtout depuis la mise à jour de MacOS Big Sur 11.2.

C'est les mêmes apps, les mêmes config, la même façon de travailler, d'ouvrir les fichiers Office et pourtant ... avec le M1 j'ai, l'impression de travailler sur un iPad.

J'ai un collègue informaticien très pointu en dev qui fait aussi de la 3D pour ses loisirs, quand est sorti le dernier mac pro, je lui en ai parlé, il m'a ri au nez en disant que son pc portable ASUS avec 64 GO de ram faisait surement mieux en rendu de calcul que n'importe qu'elle mac pro... comme quoi le monde pc est parfois dans sa bulle aussi (comme le monde mac d'ailleurs). Rien que le fait de parler d'Apple chez certains pciste, te font passer dans la case bouffon qui connait rien car il met pas ses mains dans le cambouis (base de registre, etc...). Pas étonnant que le M1 soit ignoré du coup car ils sont persuadés d'avoir les meilleurs machines déjà, car non mac...

@Boboss29

Il est peut être dans sa bulle, mais vous aussi, en caricaturant on pourrait même dire que n’importe quel PC avec une bonne carte Nvidia explosera n’importe quel Mac Pro en 3D pour plusieurs raison, mais la principale (dites moi si je me trompe) c’est que la majorité des logiciels 3D n’existent que sous Windows, et sont optimisés pour les Nvidia et cuda (le meilleur exemple étant 3DS Max, un autre exemple, sur Mac AutoCAD ne fait plus de rendu 3D depuis quelques années...).

Pour finir, petite anecdote perso: quand je fait de la 3D sur Blender, je retourne sur Windows pour les rendus ou je les fais sur une autre machine plus puissante que mon mac principal pour que cela dure moins longtemps.

Donc comme votre voisin je vous aurais ri au nez, et après je vous aurais expliqué en quoi vous vous trompiez.

@ya2nick

Mais je n'avais aucune ambition de le convertir au mac, je lui parlais de l'annonce des mac pro avec xeons 28 cores et ram jusqu'à 1.5 to, en lui disant que j'étais impressionné par la fiche technique 😊 et lui de me dire que son pc perso faisait sûrement aussi bien voire mieux (avec un i7 dernier cri et une carte graphique gamer) Ce qui est quand même de la mauvaise fois (machine qui peut faire tourner Windows aussi hein, mais comme c'est un mac c'est forcément pas bien dans son esprit)

@Boboss29

Ton pote informaticien ne doit pas s’y connaître vraiment en configuration. Il y a une grosse différence entre les i7 et les xeons. Et entre lés configuration xeon + carte pro et les i7 + carte gamer. C’est vraiment vouloir comparer la golf gti et le blindé amphibie quoi. Un xeon c’est comme un train de marchandises, ça avance pas forcément vite, ça n’accélère pas plus que ça, mais ça fait fonctionner les calculs pendant des heures sans planter avec sa ram ecc, et idem quand c’est couplé aux cartes pros. Si par exemple, tu as des rendus d’effets spéciaux à faire pour le cinéma, tu fais tourner plusieurs workstations tranquillement pendant des journées entières s’il le faut. Pareil pour des calculs scientifiques etc.

Les i7 + carte gamer, c’est pour faire des accélérations sur la rocade et ça n’a pas du tout la même endurance ni la même optimisation.

Après, on peut rentrer dans les détails, mais vraiment les réflexions des geeks, c’est un peu n’imp. Ou autant dire « tu me fais rire avec ta jeep, moi je vais plus vite avec mon alfa roméo »

@Dark Phantom

On est d'accord 😊

j'attend le prochain comparatif Intel qui va nous prendre un Atom pour montrer qu'il a une bonne autonomie, et après un Xeon 28 core pour montrer qu'il compresse plus vite une vidéo. Tiens d'ailleurs ils sont où les bench sur la compression vidéo made in Intel ?

@Boboss29

Les PC sous ARM vendus depuis 2017 annoncent fièrement 15 à 20h d'autonomie

Donc des PC qui tiennent plus de 15h, ça existe.

Problème : ils tournent sous CPU Snapdragon (les CPU des smartphones Android) et les performances à l'usage se situent aux alentours de celles d'un Celeron entrée de gamme de 2015...

Pour des machines vendues plus de 1000€, ça la fout mal

Qu’ils en profitent. Lorsqu’Apple sortira la puce M1X au printemps puis les M2/M2X dans un an, Intel n’auront que leurs yeux pour pleurer.

Intel je ne savais même pas qui travailler encore

Sa fait 15 ans que leur processeurs s’appelle i3,i5,i7,i9 et n’évolue quasiment pas au moins avec Apple j’espère voir une évolution tout les ans !

Le commencement de la fin...

Et encore une fois: attention à ne pas enterrer Intel trop vite.

Ils seront encore un acteur majeur de l’industrie pour des années et risquent de conserver longtemps leur place de n°1

@ YetOneOtherGit

tout à fait, surtout si l'on considère, comme l'on annoncé les plus érudits ici, qu'Apple "va dans le mur"

@pocketalex

Tu connais les pommes tapées ?

https://fr.wiktionary.org/wiki/pomme_tap%C3%A9e

@YetOneOtherGit

Nokia aussi! Leader Incontestable des téléphones portable!

Apple? C’est un jouet l’iPhone !

Internet? Nous aussi avec le browser WAP!

De toute façon, avec un test de résistance, tout le monde voit que notre 3310 Facelift 23 est mieux...

J’ai raté un truc ??? :-)

@fendtc

"Nokia aussi! Leader Incontestable des téléphones portable!"

Comparaison n’est pas raison.

Je ne vais pas encore une fois expliquer pourquoi ce raisonnement est trivial et complètement à côté de la plaque tant il ext primaire.

Si tu veux faire un effort essaye de comparer les situations.

Mais bon je sais que c’est inutile de demander d’essayer de prendre un peu de hauteur dans ses réflexion 😣

Si par hasard cela t’intéresse tu trouveras dans d’autres actualités les éléments argumentés et étayées que je suis fatigué de répéter 😎

@YetOneOtherGit

C’est juste que:

- un géant peut tomber... même si c’est un géant

- meme un acteur incontournable peut disparaître en 10 ans...

- la comparaison n’est pas si absurde : une entreprise leader, en panne d’innovation, bloquée sur un usage qui se prend une baffe par un outsider...

Mais oui: deux exemples très différents...

Pour le reste: l’histoire nous dira si la fin est la même!!!

@fendtc

"- la comparaison n’est pas si absurde : une entreprise leader, en panne d’innovation, bloquée sur un usage qui se prend une baffe par un outsider..."

Elle l’est de façon vertigineuse.

Pour le reste les chutes de majors de cette taille sont des phénomènes rarissimes qui sont liés à des circonstances toujours très particulièrement n’ayant strictement rien à voir avec la situation actuelle d’Intel dont tu dois ignorer la plus grande part.

Que connais tu vraiment de la situation d’Intel ?

Que connais tu vraiment des marchés sur lesquels Intel opère?

Que connais tu vraiment de la dynamique de ses marchés?

Que connais tu des facteurs d’inertie renforçant la position d’Intel ?

que connais tu des moyens dont dispose Intel pour rebondir?

...

Nous sommes sans doute en plein ultracrépidarianisme.

Si tu veux comprendre un rien les forces d’Intel et les cartes qu’ils ont en main je t’invite à lire le rapport d’activité d’AMD : eux savent de quoi ils parlent.

PS : Ceux qui me connaissent ici savent à quel point Intel n’est pas ma tasse de thé, ce n’est pas eux que je défends mais la raison 😎

@YetOneOtherGit

Non je ne suis pas dans les petits papiers d’intel... non je ne peux pas imaginer ce qu’intel a Sous le pied...

MAIS: je m’interroge sérieusement...

- ils connaissent les contrats et les volumes pour Apple... ils ne sont pas aveugles !!!

- les perfs des iPad et du DTK sont connus depuis presque 1 an...

- l’impact d’image d’Apple est également connu (la migration d’Apple vers intel avait à l’époque enorgueilli Intel!)

Et malgré tout : Intel répond (après plusieurs mois) avec ça????

Je me demande donc si le géant (qui n’arrive plus à affiner sa gravure, qui coupe les têtes...) n’est pas beaucoup plus fragile qu’on ne le croit !

On peut cracher sur le dos d’intel... mais l’informatique ne serait pas la où elle est aujourd’hui sans Intel!

Je ne suis pas dans les papiers de Microsoft non plus. Mais eux ils réagissent fort: services cloud (on est très loin des serveurs IIS), intégration de Linux (via le WSL), cycles de MaJ de Windows 10... la « défaite » de Windows Mobile fut un électrochoc et ils sont repartis.

Mais côté Intel, la réponse c’est un « bench » sur un export PDF d’un PPTX???

Désolé le compte n’y est pas!

Avec la migration d’architecture chez Apple, les très bons résultats des ryzen , j’avais espéré une nouvelle course à l’innovation... et un sursaut d’intel. Ça fait 1 an au bas mots que tous les indicateurs pour nous le grand public indiquent que la concurrence va en arriver là... 1 an...

Et la réponse d’intel c’est ça ?!?!? WTF?!?!?

@fendtc

Pour résumer : tu te trompes de guerre et de champ de bataille.

Pour le reste nul besoin d’être dans les petits papiers : il suffit de savoir lire les rapports d’activité des acteurs de l’industrie et le travail des cabinets d’analyses et de prospective.

Ajoutes une honnête culture business...

@fendtc

Je pense que le futur proche d’intel est assez connu quand même là ils vont sortir leurs propres gpu en tablant sur le milieu de gamme pour enlever des parts de marché à nvidia et amd. En gros , il va y avoir une guerre entre les Apple silicon et Intel même côté gpu. La guerre de concurrence, ça reste sain, on est d’accord.

Côté processeur, ils vont évidemment sortir (puisque ça fait longtemps qu’ils le font et amd aussi ) des cpu avec gpu intégrés et moins de conso, gravés plus fins.

Là où on attend tous un peu Apple, c’est sur les processeurs serveur et workstations et là on verra ce qu’il se passe.

Sinon je ne serais pas surpris de voir Intel fabriquer ses propres machines comme (Google, ou Microsoft ou Apple ). Même nvidia l’avait fait pour son tegra avec la tablette shield et la presque console shield tv. Il y avait de très bonnes choses avec les jeux en streaming et GeForce.

@YetOneOtherGit

Bien entendu, déjà parce qu'a le M1 ou les autres Apple Silicon ne seront que pour les mac, et ensuite parce que le parc Intel est si grand que l'image de marque est loin de devenir ringarde... Et je vois plus AMD comme concurrent direct, mais idem, c'est la même architecture sur les pc pour le moment.

Intel sort le même bullshit marketing que Apple. Ici certains confondent puissance/consommation et puissance. Non le cpu M1 n'est pas un xeon ou un ryzen loin de la

@en chanson

En même temps, il n’y a pas beaucoup de portable avec un xeon...

https://www.lenovo.com/fr/fr/laptops/thinkpad/p-series/ThinkPad-P17/p/20SNCTO1WWFRFR2

Là, avec pudiquement « à partir de 3,4Kg » pour un i3... et 12h d’autonomie avec la batterie 100Wh et le mode turbo 5.2GHz désactivé...

PS: heureusement qu’il est lourd, sinon, avec la puissance des ventilateurs il passe dans la catégorie « drones »!!!

PPS: pour les 3500€, ils fournissent le casque anti bruit!

@en chanson

C'est pour ça qu'il est sur les macbook air et mac mini à 800€ sous Intel les air et mini démarraient la gamme avec des i3 ou i5 bicoeur, aux performance pas si folle que ça. Là, Intel doit sortir ses derniers core i7 pour dire qu'ils font un peu mieux... Des processeur qui auraient été sur des macbook pro à plus 2000€ pour commencer si Apple était resté sous Intel. C'est ça qui est risible et limite pathétique pour Intel. Comme se vanter que son processeur fait tourner 1,5 fois mieux photoshop que son concurrent qui lui est sous émulation x86. Ou de dire : oui mais il y a plus de jeux sur pc que sur mac. Car niveau perfs, le M1 mets une violente fessées à leur gpu intégré par exemple, mais ça ils n'en parlent pas. Et pas de rendu vidéo dans leurs graphe, car le M1 dans ce domaine se mesure à des processeurs encore plus performants (j'ai vu sur YouTube des comparatif avec des i9 et c'est loin d'être ridicule). Sans parler du silence qui est limite troublant par moment (elle tourne encore la machine ? A oui, elle encode là...). Quand je fais mumuse avec After Effects, j'ai pas réussi à faire ralentir la machine encore, à mon humble niveau, compositing vidéo simple et des effets kitsch ou titrages, mais c'est fluide et ça ralenti pas, sur un mini à 1000€ et un écran 4k...

J’ai l’impression que beaucoup de monde ici a déjà enterré Intel voir AMD.

Il ne faut pas oublier que le gros du marché d’Intel est le monde professionnel et notamment celui des serveurs (hors super ordinateur bien sûr)

Et dans ce monde la conversion ne risque pas de se faire au changement de matériel comme le ferai un particulier.

Je n’ai aucun amour particulier pour telle ou telle marque. Mais pour exemple, et pour ceux qui saisiront les mots ( que je pourrai développer si certains le souhaitent ) quand vous disposez d’un parc de serveurs de plusieurs centaines de machines (Linux, Windows server, Bsb) en x64 hébergées dans une architecture virtuelle en haute disponibilité et donc clusterisée les coûts de passage d’une architecture à une autre sont absolument colossaux pour peu que votre solution de virtualisation soit compatible (VMware vSphere, Xen server ou HyperV)

Il faut changer les serveurs hôtes mais également les serveurs hébergés.

Pour exemple, nous avons un cluster HA de 3 ESXi Intel. (HA: haute disponibilité, si un noeud (un serveur physique de virtualisation) du cluster tombe -panne matériel par exemple- les deux autres noeuds reprennent la totalité des serveurs en cours d’exécution de façon totalement transparente pour l’utilisateur au travers d’un mécanisme nommé chez VMware Fault Tolerence).

Et bien dernièrement, j’ai dû, pour des raisons de couts, me tourner vers un nouveau serveur équipé de bi pro AMD Epyc.

Un beau bébé pour des besoins de calcul et de simulation.

2bipro AMD Epyc 48c/96t (pour une capacité de 112Ghz) et 512Go de Ram pour 20 To de stockage en full flash ultrarapide.

J’ai choisi de l’AMD car bien moins cher qu’intel. Plusieurs 10aine de millier d’euro de différence.

Cependant je sais que je ne peux pas ajouter ce serveur dans mon cluster car c’est de l’AMD.

Car un cluster ne peut être composé que d’Intel ou que d’AMD. (Pas un problème dans mon cas et je le savais avant l’achat évidement) il existe au niveau du cluster un paramètre de compatibilité

Indispensable. On fixe généralement ce paramètre au niveau du processeur le plus ancien du cluster. (Skylake par exemple).

Tout cela pour dire que même si Apple ou AMD font du très bon boulot. Malheureusement en entreprise de trop lourde limitation existe et vont, à mon grand regret, drastiquement freiner ces adoptions.

Et c’est bien sûr la partie serveur qu’Intel fait son beure. Ne les enterraient pas trop vite.

Cordialement,

@icecubee5

De toute façon qu'on le veuille ou non Intel sur mac c'est fini, et la première proposition d'Apple est vraiment prometteuse pour l'avenir du Mac. Hâte de voir la suite.

@Boboss29

Ah ça je ne dis pas ke contraire.

Personnellement ça me dérange ce nouvel isolement d’Apple mais ce n’est que mon avis. J’espère voir les autres os de nouveau être facilement utilisables et compatibles sur Mac. Et puis de ne sont pas les alternatives qui manque donc ça n’est pas vraiment un problème.

Les silicon semblent en tt cas prometteurs.

Je souligné juste que la mort d’intel ça n’est pas pour tt de suite

Pages