GeForce RTX série 30 : Nvidia n'Ampere pas une

À quelques semaines de la sortie de la PlayStation 5 et de la Xbox Series X, toutes deux propulsées par des puces AMD, Nvidia a voulu frapper fort en dévoilant sa nouvelle génération de cartes graphiques pour PC (sur Mac, comme d'habitude, il faut faire une croix dessus). Les GeForce RTX série 30 vont profiter d'une nouvelle architecture, nommée Ampere, qui est censée offrir des performances jusqu'à deux fois supérieures à l'architecture Turing actuelle pour le ray tracing et l'intelligence artificielle.

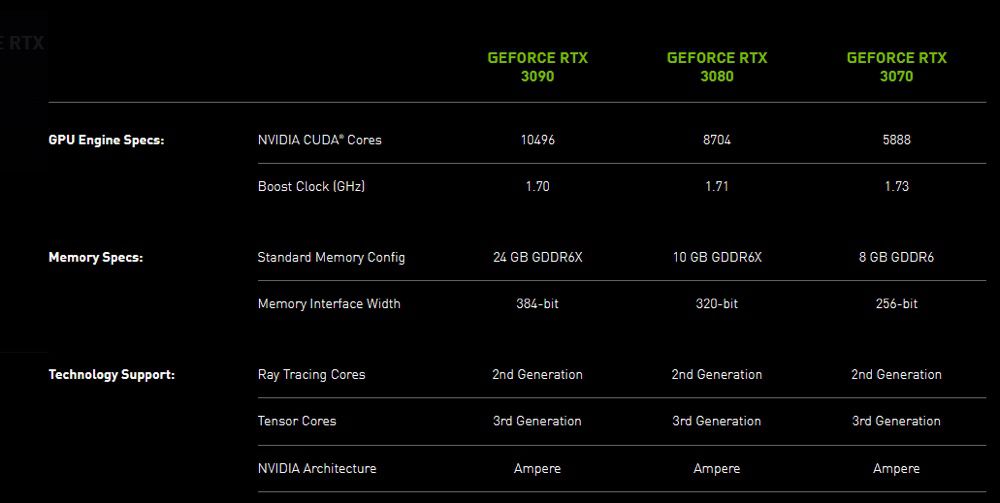

Dans le détail, plusieurs composants de base des GPU ont été améliorés : il y a de nouveaux multiprocesseurs de streaming « offrant un débit deux fois supérieur », des cœurs ray tracing de deuxième génération, des cœurs Tensor (pour l'IA) de troisième génération, de la mémoire GDDR6X plus rapide… Le tout est gravé en 8 nm par Samsung, au lieu de 12 nm pour les GeForce RTX 2000.

Les trois premières cartes de la série sont les GeForce RTX 3070, 3080 et 3090. Nvidia assure qu'il s'agit du « plus grand saut générationnel » de son histoire. Le fabricant promet par exemple une puissance brute de 30 TFLOPS sur la RTX 3080, à comparer aux 11 TFLOPS de la RTX 2080, de quoi jouer systématiquement à 60 i/s en 4K. La RTX 3090 place quant à elle la barre à 36 TFLOPS, ce qui permet d'envisager la 8K à 60 i/s avec certains jeux — mais qui a un écran 8K ?

Même si le rapport performances-watt est censé doubler par rapport à l'architecture Turing, les RTX série 30 vont consommer plus que leurs prédécesseures (jusqu'à 350 W pour la 3090). Ça aide pour augmenter significativement les performances.

En plus des cartes proposées par MSI, Gigabyte et consorts, Nvidia va encore commercialiser des modèles de son cru, nommées Founders Edition. La GeForce RTX 3070 sera en vente en octobre à 519 €, la RTX 3080 le 17 septembre à 719 € et le monstre RTX 3090 le 24 septembre à 1 549 €.

Pour marquer le coup, Nvidia et Epic ont annoncé la prise en charge de la technologie RTX par Fortnite. Quatre effets de ray tracing seront bientôt ajoutés dans le jeu : les reflets, les ombres, l'éclairage global et l'occlusion ambiante seront ainsi plus poussés. Une avancée que les possesseurs de Mac n'auront définitivement pas.

@leo3d

"Le Mac Pro 2019 aurait fier allure avec un threadripper 3990X + RTX 3090"

La question est : se vendraient-ils mieux et seraient-ils plus profitable dans ce cas ?

avec un TR oui

avec une 3090... mmmmh pas sûr

@Dimemas

"avec un TR oui

avec une 3090... mmmmh pas sûr"

de gros doutes quand même 😉

Tu dois avoir raison je pense :/

@Dimemas

"Tu dois avoir raison je pense :/"

Toujours très difficile ce genre d’arbitrage 😉

j'aurais adoré un tel mac.

@oomu

Tu n’es pas le seul, mais nous devons assumer le prix ce notre marginalité 🤓

@YetOneOtherGit

"Tu n’es pas le seul, mais nous devons assumer le prix ce notre marginalité 🤓"

Je ne me suis jamais senti aussi bien que là ou les autres ne sont pas.

@fte

"Je ne me suis jamais senti aussi bien que là ou les autres ne sont pas."

Mon petit plaisir pour assumer ma marginalité 😉

https://raptorcs.com/TALOSII/

Je serai curieux de savoir comment une telle consommation se répercute la fin de l'année sur la facture d'électricité...

Qui joue en 8K ? -> quasiment personne, mais pour certains jeux de simulation en multi-écran (imaginez 2 ou 3 moniteurs 4K) ou les futurs moniteurs 32:9 qui arriveront avec une résolution verticale de 2160p (soit l'équivalent de 2 écrans 4K en nombre total de pixels), cette puissance sera bien nécessaire.

Sur le Samsung Odyssey G9 (32:9 1440p) ou un moniteur 4K, qui ont à peu près le même nombre de pixels, une RTX 2080Ti fait tourner Microsoft Flight Simulator aux environs de 30-40fps à peine en avec les paramètres Ultra dans les zones riches de détails comme les grandes villes. Alors même que le G9 est un moniteur 144Hz.

Il y a donc largement de quoi améliorer et ce bond de puissance sera bienvenu.

Au sujet de la consommation, certains ont la mémoire courte (ou alors sont très jeune :)).

J'ai une GTX980Ti Founder Edition qui doit avoir 5 ans (couplée avec un I7 9700K 8 coeurs, et 16Go à 3200Mz) c'est une machine dédiée au jeux uniquement.

Qui en passant, fait toujours tourner tous les derniers jeux en 60/s (en 1080) pratiquement avec tous les réglages en élevés ou Ultra.

Celle-ci consomme jusqu'à 320W.

Donc les consommation des séries 3000 ne m'étonnent pas du tout compte tenue de leur puissance.

Les hauts de gamme Nvidia ont toujours eu des consommations à ce niveau.

D'ailleurs vu la durée de vie et le suivi de Nvidia, je vais commander un 3080 dès sa sortie. Et je repartirais pour 5ans.

@fatch2

Oui. J’ai aussi un G5 bi-proc à 604W. La tendance est quand même largement à l’inverse et vous serez d’accord que ça demande une alimentation d’une taille non négligeable et rare dans le tout prêt.

@Nesus

Tout à fait, mais quand on se monte une machine de gaming il faut calibrer l'alimentation en pensant au futur pour ne pas avoir à la changer à chaque évolution.

Pour ma part j'avais choisi une alim de 850W (EVGA Supernova 850 T2 garantie 10 ans) au cas ou mes finances me permettent un jour d’acquérir une Titan.

Aujourd'hui je ne regrette pas mon achat.

Pages