GeForce RTX série 30 : Nvidia n'Ampere pas une

À quelques semaines de la sortie de la PlayStation 5 et de la Xbox Series X, toutes deux propulsées par des puces AMD, Nvidia a voulu frapper fort en dévoilant sa nouvelle génération de cartes graphiques pour PC (sur Mac, comme d'habitude, il faut faire une croix dessus). Les GeForce RTX série 30 vont profiter d'une nouvelle architecture, nommée Ampere, qui est censée offrir des performances jusqu'à deux fois supérieures à l'architecture Turing actuelle pour le ray tracing et l'intelligence artificielle.

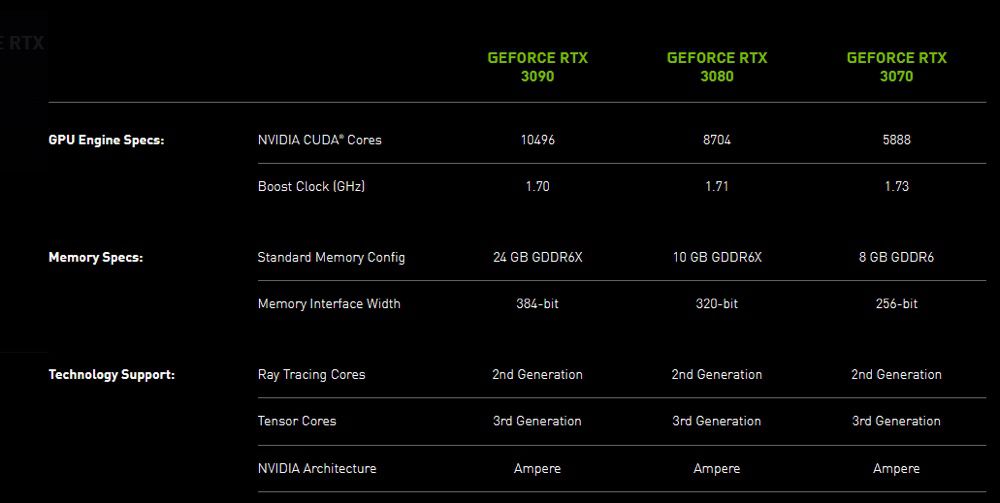

Dans le détail, plusieurs composants de base des GPU ont été améliorés : il y a de nouveaux multiprocesseurs de streaming « offrant un débit deux fois supérieur », des cœurs ray tracing de deuxième génération, des cœurs Tensor (pour l'IA) de troisième génération, de la mémoire GDDR6X plus rapide… Le tout est gravé en 8 nm par Samsung, au lieu de 12 nm pour les GeForce RTX 2000.

Les trois premières cartes de la série sont les GeForce RTX 3070, 3080 et 3090. Nvidia assure qu'il s'agit du « plus grand saut générationnel » de son histoire. Le fabricant promet par exemple une puissance brute de 30 TFLOPS sur la RTX 3080, à comparer aux 11 TFLOPS de la RTX 2080, de quoi jouer systématiquement à 60 i/s en 4K. La RTX 3090 place quant à elle la barre à 36 TFLOPS, ce qui permet d'envisager la 8K à 60 i/s avec certains jeux — mais qui a un écran 8K ?

Même si le rapport performances-watt est censé doubler par rapport à l'architecture Turing, les RTX série 30 vont consommer plus que leurs prédécesseures (jusqu'à 350 W pour la 3090). Ça aide pour augmenter significativement les performances.

En plus des cartes proposées par MSI, Gigabyte et consorts, Nvidia va encore commercialiser des modèles de son cru, nommées Founders Edition. La GeForce RTX 3070 sera en vente en octobre à 519 €, la RTX 3080 le 17 septembre à 719 € et le monstre RTX 3090 le 24 septembre à 1 549 €.

Pour marquer le coup, Nvidia et Epic ont annoncé la prise en charge de la technologie RTX par Fortnite. Quatre effets de ray tracing seront bientôt ajoutés dans le jeu : les reflets, les ombres, l'éclairage global et l'occlusion ambiante seront ainsi plus poussés. Une avancée que les possesseurs de Mac n'auront définitivement pas.

@YetOneOtherGit

Vous voyez, vous êtes tellement sûr de vous que vous n’avez toujours pas lu et pas compris mon propos. Vous vous êtes tellement fait une idée de ce qu’est mon propos que vous êtes totalement passé à côté. Désolé pour vous.

@Nesus

Je veux bien assumer être passé à côté de ta vision que tu voulais exposer, mais il faudrait sans doute que tu interroges de ton côté l’articulation de tes propos.

S’il y a malentendu ce n’est que rarement unilatéral 😉

@Nesus

"Je ne suis pas pro, mais j’ai lu (anantech) que la vram posera des problèmes aux pro et que la dissipation thermique aussi.

Donc force est de constater qu’ils continuent de s’isoler dans un micro marché, le PC de gamers. "

Il aurait donc fallu mieux comprendre. Très peu de pro se concentrent sur cette gamme. Mis a part les Scientist et les dev de jeux (et encore), la plupart des pros se tourneront vers des QUADRO etc...

@Ensearque

Je suis d’accord. D’ailleurs Nvidia a bien trouvé la solution, vendre des fermes de processeurs à la location. D’où le fait que la partie server progresse fortement. Ce qui sera très clairement l’avenir de Nvidia.

@Nesus

Vous n'avez pas compris mon propos, NVIDIA ne fait ni plus ni moins que segmenter ses gammes. Les 20XX RTX sont toujours en ventes et le resteront pendant un long moment, et pour les professionnels souhaitant des cartes plus optimisé, ils n'auront qu'à se tourner vers des QUADRO,, TITAN, etc...

@Ensearque

Oui mais dans ce cas, vous ne bénéficiez pas de la puissance et nouvelle techno.

En gros ce que vous êtes en train de me dire, pour faire le parallèle, c’est qu’on peut se consoler de pas avoir Face ID parce que l’iPhone 7 est toujours en vente.

Et donc vous validez mon propos initial qui est de dire que c’est de la fausse progression. Les nouvelle carte en elle-même sont une telle progression, mais le fait qu’au final, elles seront peut acquise, le marché n’avancera pas vraiment. Est-ce plus clair ?

@Nesus

« Les nouvelle carte en elle-même sont une telle progression, mais le fait qu’au final, elles seront peut acquise, le marché n’avancera pas vraiment. Est-ce plus clair ? »

Tu te places donc dans une perspective consumériste, ce n’était absolument pas clair dans tes propos initial qui semblaient clairement être sur des considérations business.

@Nesus

> Avec cette taille, ils s’excluent de l’ensemble des portables et machines compactes.

Euh, c'est plutôt l'inverse : les machines trop compactes excluent de facto de pouvoir embarquer les équipements informatiques les plus puissants.

Par ailleurs, y'a l'eGPU, hein. C'est pas l'eldorado, mais cela existe.

Le jour où le GPU d'Apple pourra rivaliser avec le haut de gamme de NVidia ou AMD on en reparle. En attendant, le haut de gamme vient avec ces contraintes, de la même manière qu'une ferrari s'en sort pas très bien sur des petits chemins tortueux.

> Donc force est de constater qu’ils continuent de s’isoler dans un micro marché,

> le PC de gamers.

Euh, y'a côté serveurs aussi, hein.

> C’est leur choix, ils vont pas en mourir, comme dit précédemment, ils se portent très

> bien grâce aux serveurs. Ils ne veulent plus faire que des cartes d’élite, ce qui est très

> loin de ce qu’ils ont fait (désolé d’être vieux et d’avoir de la mémoire, de les avoir

> vu débarquer au temps où ati régnait en maître).

En gros, vous leur reprocher de cibler le segment prémium en ne proposant que du matos super bon mais trop cher et amenant ses propres contraintes ?

En gros exactement ce que fait Apple, quoi.

Reprochez-vous à Apple de de pas adressez le marché des premiers prix ? De ne pas proposez du polyvalent, qui s'intègre bien avec tout plein d'usages differents, pas ceux uniquement que Apple veut bien adresser ?

@Nesus

En même temps c’est des cartes pour le gaming donc... oui

@Bounty23

Lol c’est exactement ça!

@Nesus

"Nvidia c’est quand même de mal en pis."

Son chiffre d’affaires vient de m’appeler, il n’est pas d’accord.

@fte

Par contre, votre prof de français m’a écrit, et il est désolé de ne pas avoir réussi à vous apprendre la lecture. Il pense que ça vient d’un trouble de l’attention et de l’hyperactivité.

Il m’a proposé de ne plus mettre de point dans mes écrits, sinon vous êtes incapable de lire l’ensemble d’une réponse et donc de l’intégrer avant de répondre.

J’y réfléchis, car ça m’embête de vous faire passer pour un inintelligent...

@Nesus

Ton prof de français ne t’a pas parlé de l’importance de l’incipit d’un propos ?

Il ne te vient pas à l’esprit que si nous sommes si nombreux à réagir ainsi c’est peut-être parce que tes propos ne portent pas le message que tu voulais faire passer ?

@Nesus

« Il pense que ça vient d’un trouble de l’attention et de l’hyperactivité. »

Je suis totalement fasciné par le nombre de collègues que j’ai ici.

Faut vraiment pas hésiter à postuler : on manque de bras.

J'espère pour vous que vous savez vraiment ce qu'est le TDAH (Trouble du Déficit de l'Attention avec Hyperactivité) ...

Sinon, pour d'autres annonces autour de Ampere nous pouvons aussi attendre par exemple Octobre et la GTC. Ne pas croire que NVIDIA en a fini avec les annonces autour de Ampere.

Puis encore un peu plus tard peut être une gamme sans RTX (comme ce fût le cas pour Turing donc et les T1000 / T2000 pour les quadro, ou les GTX 1660Ti entre autre).

Sinon, pour le marché de la console, la Nintendo Switch se vend très bien aussi.

@FrCo

Il y aura peut-être plus et je changerai d’avis à ce moment, un avis, ça n’a jamais été fait pour être figé. J’y vois actuellement un mouvement de fond pour pousser vers l’utilisation du cloud. Je préciserai au besoin, je l’ai fais dans la réponse à oomu si besoin.

La switch me paraît être un parfait exemple. Je l’ai acheté à ma femme.

Graphiquement, c’est une horreur. C’est du bas de gamme, ça chauffe, ça a une autonomie légère et c’est complètement déconnecté des performances de ce qui peut être réalisé.

Je précise tout de suite avant que 50 personnes me sautent dessus. Oui, c’est en majeure partie la faute de Nintendo. Oui, ça convient à son public, même si j’ai entendu ma femme dire que Zelda était pas très beau sur la tv 4k hdr (ce qui est un fait).

J’en reviens à mon propos initial, désolé pour la digression. La switch est pour moi le symptôme de ce qui se passe actuellement chez Nvidia. Ils sont archi leader avec des cartes parfaitement performantes et se complaisent dans une facilité. Nous poussons par l’augmentation. En se faisant, ils creusent un faussé technologique. Tu veux jouer correctement, achètes toi un de gamer, ou loue notre offre de cartes graphiques en cloud. Sinon, contente doit d’un rendu passable mais qu’on ne fait que peu, voir pas évoluer. Par contre, on travaille un peu le prix, pour que le faussé se fasse bien.

Pour faire une analogie, c’est un peu comme si Apple ne faisait plus que des iPhone X et des SE (ancienne génération). Pour une boîte qui voulait démocratiser la carte graphique, je trouve ça clairement dommage.

Bon vous pourrez me répondre que c’est le buisness que c’est normal et que ça leur réussi. Ce qui est vrai.

Tout comme Google ne devait pas devenir le diable. Je trouve ça dommage.

@Nesus

vous n'êtes pas clair alors.

Je ne vois pas non plus où on fait tous collectivement fausse-route sur votre propos initial.

@Nesus

"Il pense que ça vient d’un trouble de l’attention et de l’hyperactivité."

Je suppose que c’est ton "prof de français" qui t’a appelé, celui avec une blouse blanche. Car mes professeurs de français me parlaient de grammaire, de vocabulaire, de littérature... bref, de langue, en forme et fond. Ce n’est pas la même profession qui traite de troubles d’attention ou d’hyperactivité vois-tu.

Cette confusion de métiers explique certainement la profondeur de ton commentaire sur Nvidia. C’est si profond que j’échoue à en voir le fond.

@fte

Alors, les troubles de l’hyper activités, ne sont pas traités par des professeurs. Ils sont supposés par des profs en règles général autour de 6 ans et ce sont des médecins qui les traitent. Parfois vous avez un maître E en complément.

Toutefois votre réponse vient parfaitement illustrer mon propos initial.

@Nesus

"Toutefois votre réponse vient parfaitement illustrer mon propos initial."

C’est exact. La totale confusion du propos initial - et des commentaires suivants - est parfaitement illustrée. Pas assez de méthylphénidate peut-être ?

Plus sérieusement, il n’y a pas de mal à un propos trop approximatif compris de travers par toute l’assistance. Ça arrive. L’attitude subséquente de rejeter la responsabilité sur le défaut d’intelligence de ses correspondants est dépourvue d’élégance cependant. En outre la récidive sur divers sujets laisse à penser que le trop approximatif est hélas fréquent. De bien médiocres conversations.

Bon week-end chez toi.

@fte

Encore une fois, vous creusez votre erreur et vous considérez que ça ne vient que de moi, alors que vous faites approximations sur approximations. Excusez-moi d’attendre que mon interlocuteur prenne le temps de la réflexion et surtout qu’il lise tout ce que j’écris. Pis encore, quand je lui donne une information j’attends qu’il prenne l’ensemble des éléments pour le comprendre et si j’ai une deuxième réponse, elle vient forcément contredire quelque chose, à lui de trouver quoi.

Là vous me prenez de haut parce que ma première réponse n’était soit disant pas assez précise. Et vous faites une réponse encore plus approximative, mais dans votre esprit, vous avez raison et vous vous reprenez les pieds dans le tapis. C’est que ça montre. Mais oui, fallait réfléchir pour en trouver le sens et vous attendez que je vous donne tout sans fournir d’effort alors que vous avez même pas lu le huitième de ce que j’ai écrit. Donc oui, j’ai un problème de communication avec vous, je vous demande beaucoup trop et ça ne m’intéresse pas de devoir tout expliquer. Ce qui m’intéressait c’est de faire avancer une idée, et c’est absolument pas ce que j’ai fait, j’ai passé la moitié du temps à répondre à des attaques personnelles. Toutefois, vous avez raison le problème vient de moi. Car tout comme le vous est une convention, j’ai enfin compris que les commentaires ont aussi une convention, ne pas discuter et attaquer. Je n’en ai toutefois pas compris l’intérêt, mais comme dit plus haut, au final ça ne m’intéresse pas.

On peut très bien acheter une geforce avec puce RVB

-

mais je ne comprends pas vraiment ce discours de la "niche"

Oui, il y a des niches dans le monde, et chaque niche est importante. Y a des chiens dans les niches (WAF !) et y a de quoi se faire du bon nono..heu du bon sous en fournissant des services aux niches.

Selon le point de vue qu'on prend, Apple aussi est une niche (la niche des gens claquant beaucoup de sous dans un machin qui fait BIP)

Le commerce d'Apple est une niche en comparaison de celui des vendeurs de jus d'orange et papier toilette.

Mais cela n'a aucune importance, la Niche est VITALE, et c'est l'UNIQUE chose qui m'intéressera et donc que je m'équiperai pour si dans cette niche y a MOI ! (wououourf !)

Des jeux toujours plus mieux, mais dont le sol est toujours aussi plat, sans relief, ni aspérités, quelque soit sa nature (plage, rochers, goudron, etc ..).

@IceWizard

On doit pas jouer au mêmes jeux.

@Soner

Lance la vidéo de NVidia accompagnant l’article et regarde comment est fait le sol ..

regarde MS flight simulator plutôt ...

Sérieux, tu veux tester Doom2 avec cette carte graphique aussi sinon ?

Tu pourras compter le nombre de pixels

@Dim

"regarde MS flight simulator plutôt ...

Sérieux, tu veux tester Doom2 avec cette carte graphique aussi sinon ?

Tu pourras compter le nombre de pixels"

C'est des mots au hasard, ou il y a un sens caché cryptique ?

Dans les jeux récents on voit même les empreintes de pas des joueurs dans la boue ou la neige, avec de très beaux effets de profondeur.

@Carbonized

"Dans les jeux récents on voit même les empreintes de pas des joueurs dans la boue ou la neige, avec de très beaux effets de profondeur."

Cela ne date pas d'hier. On voyait déjà les empreintes du joueur dans la neige, dans l'un des premiers véritables RPG 3D, NeverWinghterNight en 2002-2003. C'est facile à faire, il suffit de poser des sprites plats en forme d'empreintes sur le sol, avec une durée de vie limitée. La texture est dessinée avec un jeu d'ombres et de lumières donnant l'impression que c'est en creux, alors que c'est un objet plat sur un support plat.

C'est fait différemment avec les jeux modernes, grâce aux shaders, permettant de modifier individuellement la luminosité d'un pixel en fonction d'une texture de référence. L'oeil humain reçoit une image plate que le cerveau analyse en fonction de la lumière ambiante, des variations de luminosité sur les objets et des ombres pour reconstituer le relief. En manipulant ces informations, on peut créer des effets de creux et de bosses totalement imaginaires, comme dans le fameux dessin d'Escher avec l'escalier qui monte tous le temps, tout en bouclant sur lui-même.

Les objets en relief ont deux textures : l'une pour l'aspect normal de l'objet, et une autre contenant une carte de profondeur du relief (en bosse ou en creux). Au moment de l'affichage, le moteur 3D détermine la couleur de chaque pixel en fonction de la couleur locale (ambiance + effets de lumière locaux) et y applique un effet supplémentaire de distorsion en fonction de l'information de profondeur.

https://fr.wikipedia.org/wiki/Placage_de_relief

Les résultats sont visuellement impressionnant. Avec ça, on ajoute des creux et des bosses sur n'importe quelle surface plate, des impacts de balles sur un mur par exemple.

Quand c'est apparu sur les cartes vidéos il y a une quinzaine d'année, je me disais "ok c'est super mais cela consomme des ressources graphiques supplémentaires. Il y a de superbes démos avec des murs (ça donne super sur des murs en brique, par exemple) et du sol en relief. Je comprend que dans un vrai jeu , cela ne soit réservé qu'à quelques objets, comme l'arme du joueur. Ou des traces de pas et d'impacts de projectiles. Mais dans 10 ou 15 ans, on pourra avoir des murs en relief superbes et des sols réalistes.".

Je ne regarde plus trop l'actualité des jeux vidéo depuis une dizaine d'années, mais chaque fois que je regarde une vidéo de démo ou des copies d'écran, je me rend compte que malgré l'impressionnante montée en puissance des cartes graphiques, la plupart du temps l'environnement privilégie toujours les surfaces plates et les textures sans relief, contrairement aux créatures, véhicules et armements qui monopolisent globalement les progrès techniques (et la puissance GPU disponible).

---------

Le serveur se comporte bizarrement ce soir. Je n'arrive pas à poster, malgré plusieurs essais. Peut-être que finalement ce post vas se trouver en plusieurs versions ..

Moi j attends la 3060

Ha c'est sûr que ça ne rentre pas dans un iMac ce genre de carte mais personne n'a jamais demandé à Apple de nous faire un poste fixe de l'épaisseur d'une feuille A4.

Vu la taille du pied de l'iMac ça ne génerait personne si Apple grossissait l'épaisseur afin d'y caler ce genre de carte mais bon tant qu'Apple ne comprendra pas que performance ne rime pas avec finesse les utilisateurs de Mac resteront avec des cartes chères et peu performantes.

@MacGe

Un peu de respect pour ce glorieux Lyonnais 😉🤓

Hâte de voir la réponse d’Apple concernant la partie GPU

Prévois de quoi tenir un siège c'est pas près d'arriver… Je me rappelle la promesse de pouvoir upgrader la carte des MacPro Poubelle, ahah cette blague xD

cela n'a jamais été promis.

il a juste été dit par la "communauté" (pas apple) que c'était théoriquement possible. (on peut débrancher le module et l'enlever)

mais entre le format totalement exotique, le SSD branché via un des gpus etc, ben personne n'a jamais voulu faire un gpu alternatif, pas même un macway ou lacie :)

Le PC reprend quand même de sacrés couleurs dernièrement d'un point de vu Hardware. Des performances tout juste folles pour un prix "contenu". Bizzarement ça me rappelle l'époque début années 2000 où le PC était super passionant avec ses cartes grafiques dédiées. J'espère qu'Apple et ses Mac Arm vont aussi nous en mettre plein la vue au niveau des performances. En tout cas la RTX 3070 est tout simplement la meilleure affaire depuis très longtemps sur ce marché. Avec la nouvelle génération de console et le PC, on risque d'avoir des jeux qui vont décoller la rétine. Le trailer de Cyberpunk 2077 est juste magnifique.

@Glop0606

C’est clair ! Ça fait plaisir de voir ça :)

Mais ici, je ne pense pas que beaucoup de monde s’en rend compte car ça ne touche pas les macs, par contre pour les pc c’est la fête !

si les performances sont excitantes et que le PC est redevenu cette machine folle aux logiciels et jeu toujours plus ambitieux, je ne suis pas convaincu qu'on puisse parler de prix "contenu".

entre les nvme, les cartes mères "gaming", les gpus nvidia, et autre cpu "enthousiaste", le pc de "passionné" devient rapidement plus cher qu'il y a 5 ans.

Moi qui avais renoncé à mettre une 2080 Ti dans ma tour PC vu le prix, je dois avouer que cette 3080 me fait de l’œil. J’utilise de plus en plus le rendu GPU (Redshift), ça me permettrait de gagner pas mal en temps de rendu pour un budget raisonnable.

Il est temps qu’AMD sorte du bois en ce qui concerne les GPU. Quel paradoxe d’avoir à l’inverse ce qui ce fait de mieux question CPU.

le rendu gpu c'est la vie :)

Je suis juste déçu qu’il ne soit plus possible d’avoir le choix entre AMD et NVIDIA. C’est clair qu’Apple n’offre pas ce qui ce fait de mieux, mais pour quelle raison?

@DerFrançois

Pour des raisons de maximaliser ses profits : NVidia étant leader, Apple n'obtien[drai]t pas d'eux des conditions commerciales comparables à son challenger, AMD, qui lui est un peu plus contrait de les accepter, du moins tant qu'il est dans cette position de poursuivant (et en terme de GPU, c'est le cas clairement).

La seconde raison, c'est que les clients au lieu de montrer à Apple qui veulent avoir le choix ou alors il quitte le Mac et bien... restent. Donc s'en accommodent. Donc cautionnent qu'Apple ne leur laisse pas le choix.

Apple ne propose pas ce qui se fait de mieux parce que ses clients se contentent de moins bien, souvent pour plus cher. Pourquoi Apple changerait quoi que ce soit alors que c'est tout bénéf pour elle !?

@byte_order

"Donc s'en accommodent."

La plus part s’en fout même totalement sans doute 😉

Si les performances GPU maximales pesaient lourds dans les motivations d’achat des cibles d’Apple ils auraient fait depuis longtemps d’autres arbitrages.

L’offre GPU d’Apple représente certainement le meilleur rapport coûts/bénéfices pour eux.

"La seconde raison, c'est que les clients au lieu de montrer à Apple qui veulent avoir le choix ou alors il quitte le Mac et bien... restent. Donc s'en accommodent. Donc cautionnent qu'Apple ne leur laisse pas le choix."

ok ok, je suis parti (je monte un pc avec du haine-vidia, en ce moment), voilà, content ? Je n'arrivai plus à m’accommoder du mac actuel et je refusais de cautionner.

Apple va changer ?

(le Oomu est ce petit carbone de trop qui provoque la chute des glaciers alpin)

Et pour les Hackintoshs ?

ça fait belle lurette que nvidia n'est plus supporté par mac os, encore moins avec la nouvelle gen

laisse tomber oublie... j'ai pleuré hier ...

L’action Nvidia largement en hausse en pré ouverture du marché

Et ça fait plusieurs jours que l’action grimpe

Le Mac Pro 2019 aurait fier allure avec un threadripper 3990X + RTX 3090

Pages