Le PCIe 6.0 en préparation, alors que le 4.0 émerge à peine

Dans tous les ordinateurs modernes, le lien entre le processeur et une bonne partie des composants se fait via une connexion PCI Express, plus connue sous le nom de PCIe. Cette norme apparue dans les années 1990 a connu plusieurs évolutions majeures et c’est la version 3.0 qui est utilisée à l’heure actuelle. Elle existe depuis 2010 et permet de bénéficier de débits qui peuvent atteindre 16 Go/s dans le meilleur des cas.

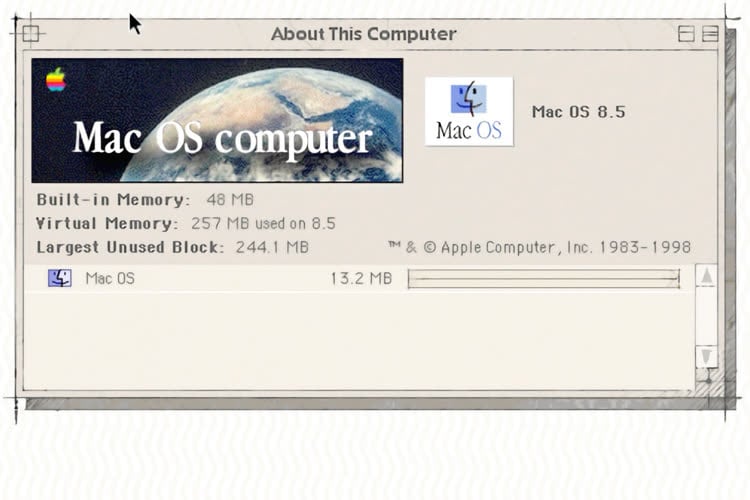

Le PCIe 3.0 est partout aujourd’hui, y compris dans le tout nouveau Mac Pro qui intègre huit connecteurs de ce type (lire : Mac Pro 2019 : le Mac parfait pour quelques pros). Trois connecteurs x16 permettent de bénéficier de cette vitesse théorique maximale qui est utile pour les cartes graphiques professionnelles, deux autres se contentent d’un débit de 8 Go/s qui est suffisant pour bien d’autres usages. Mais pourquoi Apple s’est contenté de cette version qui va sur son dixième anniversaire, alors qu’il existe deux nouvelles générations de PCIe bien plus rapides ?

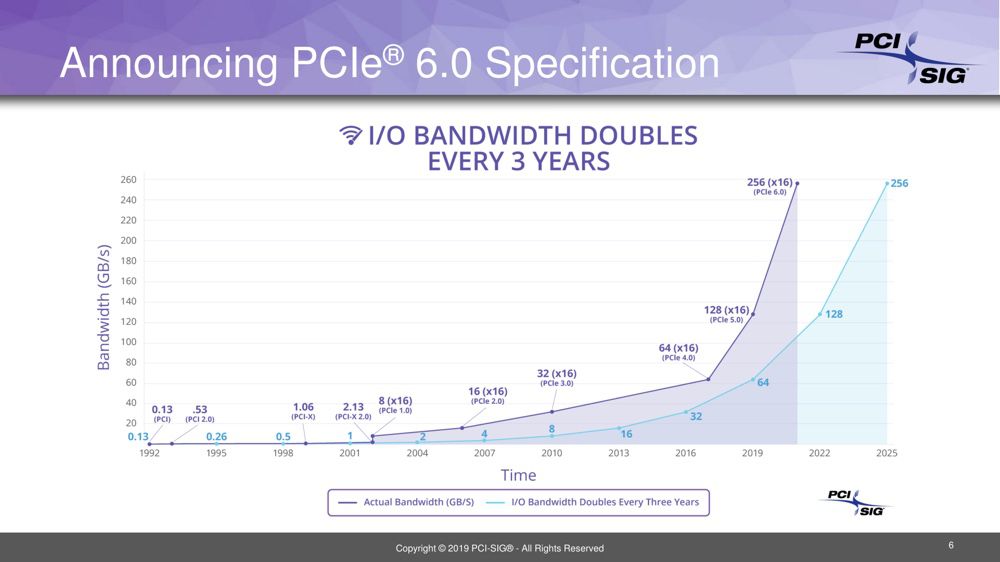

En effet, le PCIe 4.0 a été finalisé en 2017 et le PCIe 5.0 est officiellement disponible depuis la fin du mois de mai dernier. À chaque fois, les progrès ne sont pas négligeables : les débits peuvent atteindre 32 Go/s avec la quatrième version et même 64 Go/s avec la cinquième. Et si cela ne suffisait pas, le groupe en charge de la norme a commencé à travailler sur le PCIe 6.0, prévu pour l’horizon 2022 et qui devrait encore doubler ces débits et offrir des connexions théoriques qui pourront monter à 128 Go/s.

Doubler les débits tous les trois ans, voici le pari des concepteurs de cette norme. Mais le problème, c’est que l’industrie ne suit pas. Apple est restée au PCIe 3.0 pour au moins deux bonnes raisons : c’est celle de l’écrasante majorité des cartes d’expansion actuellement sur le marché, et d’autre part (et surtout), c’est la seule norme gérée par le processeur Xeon. Intel ne s’est pas pressé pour adopter le PCIe 4.0 et quelques modèles sortis d’ici la fin de l’année devrait commencer à gérer cette gamme, mais pas la famille de processeurs utilisée par le Mac Pro.

Apple dépend d’Intel dans ce domaine et le Mac Pro restera cantonné au PCIe 3.0. Ce n’est pas gênant dans l’immédiat, et si le constructeur n’abandonne pas immédiatement la machine comme elle l’a fait en 2013, les futures générations pourront adopter une norme plus récente. De quoi augmenter encore les performances, à condition que les périphériques adoptent aussi cette norme évidemment.

Cela ressemble à un bon vieux cercle vicieux : il n’y aura pas de carte PCIe 4.0 tant qu’il n’y aura pas de machines qui savent les gérer. Donc c’est aux fabricants de cartes-mères et de processeurs de faire le premier pas !

@asseb

Non, l’article le met en avant, c’est au fabricants de processeur de s’y mettre. Tu ne peux pas faire une carte mère compatible si le processeur ne le prends pas en charge ça serait inutile.

AMD y a déjà mis un pied en annonçant des processeurs compatible PCIE 4.0 les fabricants de cartes mères ont suivis.

De plus, sur une carte mère on retrouve un chipset dont le boulot est de coordonner tout ce qui transite via le processeur, ce chipset est fournit par les fabricants de processeur aux fabricants de carte mère, c’est à lui de gérer le PCIE 4.0.

@anti2703

Processeurs et carte-mères avancent main dans la main...

@asseb

Bah non justement non... les fabricants de carte mère font avec ce que les fabricants de processeurs leurs donnent.

Comment tu expliques les nouveaux sockets alors ? Intel sort son nouveau socket et ensuite il faut attendre que les carte-mères soient développées et construites ?

@asseb

Oui... c’est juste que les sockets et les spécifications sont envoyés en avances aux fabricants de CM pour qu’ils soient prêt pour la sortie des nouveaux processeurs...

D’ailleurs c’est souvent comme cela que l’on sait qu’une génération de processeur arrivent les cartes mères arrivent parfois dans le commerce avant les processeurs ^^

Et moi qui pensait que la norme 3.0 était la dernière en date car je n’ai jamais vu autre chose que ça !

Et donc du coup je demande il y a beaucoup de carte mère tout publique qui utilisent les dernières normes ? Quels processeur va avec ?

Quels sont les périphériques utilisant ces débits monstrueux ? Ces débits sont plus pour de la gamme pro je suppose ?

Je serai curieux d’entendre une véritable justification de ne pas rendre compatible les xéons pour le coup c’est de l’obsolescence déjà programmé ça ?

@alexis83

Faut pas voir le mal partout, on vend bien des télés hd alors que le 8k existe...

@asseb

C’est l’inverse

On vend des tv 8K alors qu’il n’existe que des programmes en HD

@ MarcMame

Effectivement. Et toutes les télés "haut de gamme" sont maintenant 4K, alors que les programmes 4K sont très rares et que la TNT n'en diffuse pas...

" Je serai curieux d’entendre une véritable justification de ne pas rendre compatible les xéons pour le coup c’est de l’obsolescence déjà programmé ça ?"

le cliché, qu'on vous a écrasé dans votre crâne à coup de message répété en boucle, de l'obsolescence programmé n'explique RIEN !

Ce n'est PAS programmé au sens où vous le pensez.

Depuis des décennies d'informatique ça a toujours marché ainsi:

un fucking ingénieur met en place une norme, un protocole, un cablage, qu'un deuxième ingénieur immédiatement à coté dit :

" hé les gonzes, si on doublait le nombre de fils ?"

" hé les moustics, si on multipliait la fréquence par deux ?"

" hé les cakes, si on multiplexait encore mieux pour doubler le signal ?"

" hé les kakous, si on diminuait par deux le bruit par un meilleur filtre ?"

etc

la réponse est généralement :

"mais dis donc Henry, t'es pas con du tout, on y avait po pensé ! Non, on a pas la techno fiable pour ça / trop cher / on a vu avec les connards de l'usine c'est pas prêt / ça sera pour la version suivante, zut !"

et vous répétez ça pour le télécom, le réseau , wifi, usb, port série (ben ouais, si on double la fréquence lol !), en parallèle (ben si son double le nombre de fils, trololololol !"), etc

on procède ainsi , parce que ça fois que vous poussez plus loin en multiplexage, en fréquence, en nombre de voix, en compression vous rajoutez un défi technique.

pour augmenter les fréquences, il faut mitiger la chaleur et la consommation que cela implique (par de meilleurs matériaux ou une fabrication améliorée),

si vous doublez les voie (les branchements) vous augmentez le coût de fabrication et l'industrie va vous dire "hé ho mémé, j'ai déjà mes ACTUELLES lignes de fabrication à rentabiliser, alors tu vas attendre hein"

si vous améliorez le multiplexage, vous complexifiez le signal, au risque de devoir ajouter des composants plus performants, voir des circuits dédiés à la correction du signal (donc du coût, donc faut mutualiser la fabrication pour diminuer le prix à l'utilisateur)

etc.

d'ailleurs PCIe 6, on sait _déjà_ que ça sera chéros. Du seul fait que le signal est bien plus complexe que celui de PCIe 3/4/5 et que pour la première fois il faudra ajouter des composants et des données spécifiquement pour corriger les éventuelles erreurs de transmission. Préparez votre porte monnaie, si un jour Apple claque un mac pro pcie6 avec la CM qui va bien (et du double 40Gbps ethernet), ça sera héhé..wouuf là dis ho le prix.

(tout augmentera de prix si les pc migrent à pcie6, tout, heureusement c'est genre pas avant 2030, d'ici là, la Guerre aura anéanti l'industrie et fait chuter l'économie, ça ira donc).

Forcément, on va pas vous vendre du pcie6 tout de suite... alors même que je suis certain que mon pote l'ingénieur il voit déjà ce qui pourrait être encore ajouté pour un PCIe 7 teeEEEeellement mieux...

-

et puis à un moment, le commercial, il vient et il dit

"hé les rastas, on a vu, c'est super cool vos bidules, mais là, le patron, il dit qu'il faut sortir un produit, alors il nous faut un truc finalisé, que je puisse écrire la liste des Nouveautés Trop Cool (les anglouches nomment ça "release notes"). HA non, je mets pas en vente si j'ai pas écrit la Liste des Nouveautés ! "

et donc à un moment faut sortir un "truc", et on lui colle un numéro+1. Si on est modeste on dira N+0.1 et si on est un peu honteux, on se contentera de coller un "+" (ou "Extreme" ou "X" ou autre variante) au nom du produit.

c'est tout.

donc oui, sachez qu'on peut _déjà_ réfléchir à un USB 5 qui enfoncera cette merde de USB 4.

Que WIFI 8 sera tellement meilleur que le primitif et insupportable WIFI 6

que la 5G n'est pas la FIN (y a d'autres techniques et améliorations des processeurs des routeurs et émetteurs qui devraient aider à l'avenir)

Que les actuelles centrales nucléaires reposent sur des conceptions et technos qu'on pourraient aisément qualifier de Ringardes. (mais que la vie est compliquée et qu'il y a de terribles compromis sciemment décidés et que ce qui est sur papier ou en preuve de concept doit être financé lourdement pour devenir réalité. déjà que les gens gueulent pour un tout petit EPR...)

Que le Oomu sera supplanté par un meilleur Oomu (encore plus teigneux)

" Et donc du coup je demande il y a beaucoup de carte mère tout publique qui utilisent les dernières normes ? Quels processeur va avec ?"

en pcie 4, rarement

en pcie 5, aucune à ma connaissance

" Quels sont les périphériques utilisant ces débits monstrueux ? Ces débits sont plus pour de la gamme pro je suppose ?"

quasiment aucun. Pour l'heure, AMD va (quand concrètement ? mystère, méfiez vous des "annonces", la seule date réelle c'est celle de la disponibilité en masse en boutiques) sortir des cpus gérant pcie4

cela ne signifie PAS qu'il y aura des cartes mères et périphériques rapidement ! (en masse, n'oubliez pas "en masse")

Des SSD pcie4 devrait arriver en 2019.

"Ces débits sont plus pour de la gamme pro je suppose ?"

dans un premier temps, ça sera onéreux, vu que ça sera de nouvelles gammes, avec de nouveaux composants pour un tout petit marché d'ordinateurs à jour, AMD de surcroit.

mais à terme, ces débits seront ultra intéressants pour

- le jeux vidéo (ça bouffe le jeu vidéo, le jeu vidéo a FAIM ! il lui faut plus de débit ! PLUUUUUS)

- stocker en masse des flux de données (vidéos, etc) sans discontinuer, y a moyen de faire des NVME plus rapide et donc d'en profiter pour pondre plus de données par seconde

- augmenter le nombre de paquets réseaux passant par le cpu. A nous les routeurs explosant allègrement les centaines de GBps. Cela est important car si on virtualise la fonction réseau, on utilise une architecture PC pour profiter des monstrueuses performants des Xeon multicoeurs pour bouffer des milliards de paquets par s et router/vlan/chiffrer/corriger etc au passage.

etc

bref, l'Humanité a faim.

@oomu

Pour la partie commerciale je suis d’accord mais je n’ai pas ton courage pour écrire un gros pavé !

Sinon pour les précisions sur les périphériques qui devraient y être associé ce genre de performance reste tout de même conditionné pour du matériel professionnelle non ?

Tu parles du jeux vidéo mais d’ici là que ce soit pris en charge on sera absolument tous passé sur du jeux en streaming, les pc gamers et consoles n’ont plus tellement d’avenir a terme. Quoique en finissant cette phrase je repense à ma campagne avec son débit anémique... Tout dépendra de l’évolution du haut débit ?

" Sinon pour les précisions sur les périphériques qui devraient y être associé ce genre de performance reste tout de même conditionné pour du matériel professionnelle non ?"

non.

Vous auriez pu tenir ce même discours lors de AGP, lors de PCI puis PCIe. Et pourtant vous voyez maintenant des technologie, qui dans les 80s étaient du royaume du mainframe météorologique, être utilisés pour permettre d'afficher Games Of Throne en 1080/4K sans délai et des Sekiro nerveux et finement détaillés.

L'amélioration de la technologie et sa mise à disposition au plus grand nombre permet l'émergence de nouvelles approches, services, idées, etc. Ce qui est "de soi" aujourd'hui ne l'était pas du tout y a 20 ans et sera totalement grotesque dans 20 ans.

Ou pas, on en sait rien en fait :)

Même le "streaming" est une justification pour faire exploser les débits et vendre de nouvelles technos. A l'industrie elle même. De google à disney en passant par facebook, amazon, etc, ils auront besoin de muscler leurs infrastructure pour soutenir la demande et en mettre toujours plus plein la vue.

Après, y a pas d'urgence. Mais ça pourrait servir, ça servira, ça sera vendu.

---ne lisez pas la suite, c'est un Hors Sujet sur l'industrie et le streaming------------

"Tu parles du jeux vidéo mais d’ici là que ce soit pris en charge on sera absolument tous passé sur du jeux en streaming"

non.

Le "streaming" est bloqué par 3 trucs

- la qualité du réseau et sa latence. Ce qui n'est pas du tout du tout du tout évident dans touuuuuuuutes les régions limités à ADSL (et adsl est un royaume de variétés de qualité) et pire encore les zones sous couverture radios/liaisons hertzien (genre les Alpes)

- le prix de l'abonnement + prix des jeux. L'équation économique n'est pas nécessairement en faveur du joueur face aux consoles ou pc Steam/Epic

- le profit pour l'industrie. Tout comme avec Netflix, il est aberrant qu'un éditeur suffisamment important accepte que ses œuvres ne lui rapportent qu'un % arbitraire d'une assiette fixée par le nombre d'abonnés d'un PRESTATAIRE (netflix) selon un algorithme qu'il ne maîtrise pas.

Nous voyons déjà pour les séries/films une explosion des concurrents à netflix (amazon, disney, google, paramount, cbs, etc) : chaque producteur/éditeur a vocation à devenir son propre diffuseur en concurrence avec Netflix et consorts : provoquant une hausse des prix pour en revenir à grosso modo le prix du cinéma/dvd pour le consommateur

en jeux vidéo, même si les éditeurs vont participer à google et microsoft gamepass et sony playnow , ils sont aussi en train de développeur leur propre offre directe à eux . Ubisoft va lancer son abonnement, EA aussi, et à terme ils vont muter en concurrent de Stadia etc.

Tout comme Origin est un concurrent (malheureux) de Steam, que Blizzard a sa propre boutique/downloader et pourquoi pas demain diffuseur en direct de jeu (battle live+ je le nommerai :) )

Je fais un rapprochement entre le téléchargement (les boutique) et la diffusion (le streaming) parce que du point de vue du commerçant, c'est similaire : Pourquoi laisser le distributeur (une boutique apple ou steam, un diffuseur google ou sony) prendre une part du pognon du client quand vous pourriez tout prendre vous même ?

Epic s'est dit pareil, et a créé sa boutique : à la fois elle distribue elle même ses jeux et ne partage pas avec Valve (Steam) et à la fois elle prend aussi une part du bénéfice des autres éditeurs pas assez gros pour faire pareil.

Et ben, ça sera pareil avec le streaming.

L'explosion va ramener à la hausse le prix, parce que l'industrie ne peut PAS se contenter que des sous que donnerait mOssieur Netflix ou mOssieur Google.

ça n'a pas de sens économique: vous contraignez l'argent que peuvent se partager les auteurs/producteurs à juste ce qu'un acteur arrive à prendre des gens et qu'il daigne redonner au reste de la chaîne.

L'abonnement de netflix DOIT monter DRASTIQUEMENT de prix, c'est mécanique. plus y a d’œuvre et éditeurs sur le catalogue, plus le prix doit monter pour que chacun s'y retrouve et rentabilise la production. Mécaniquement aussi, chaque acteur a un intérêt économique de virer Netflix de l'équation pour garder tout le sous. Du point de vue d'un Legends ou Warner, Netflix est un prestataire quasi obligatoire à diviser pour pouvoir le dominer.

Je parle de Netflix, parce que la même logique est déjà en train de s'appliquer pour le futur paysage du jeux vidéo.

Netflix (et google ou microsoft pour le jeux vidéo) sont tout autant des diffuseurs d'oeuvre des éditeurs qu'un concurrent. Puisque Netflix est aussi producteur et s'édite elle même.

C'est le même problème que pose Apple aux éditeurs tiers sur l'app store : à la fois partenaire et redoutable concurrent (parlez en à Spotify)

on voit dans le jeu vidéo que les industriels sont pas des abrutis finis et qu'ils ont observé ce qui s'est passé sur la vidéo et bougent encore plus vite que Disney face à Netflix.

DONC: je ne crois pas à un modèle unique de la Réalité. Le "streaming" est bridé par son modèle économique et technologique; Nous vivrons pour encore de très nombreuses années la vente en support physique ou téléchargement pour à la fois des raisons techniques, économiques et aussi pour fournir une offre "premium" aux gens qui veulent le Top du Top.

Y a de la place pour du jeu en média physique ou téléchargé pour encore longtemps. Demain est un autre jour.

-

"les pc gamers et consoles n’ont plus tellement d’avenir a terme."

bof. ça fait 30 ans que je vis la mort des consoles.

ha et la mort du PC aussi.

ha et la mort du Web (célèbre couv de Wired)

et la mort du théâtre

Tout cela on s'en fout.

tout ce que je sais c'est qu'il y aura une PS5, que certains jeux que je souhaiterai seront dispos dessus, et que l'expérience ultime de ouf malade, si je mets les sous, sera dessus. ou sur PC double nvidia gpu 32Go de vram écran 6K 36" (!)

Les offres streaming etc, correspondront à d'autres attentes et prix. D'ailleurs y a déjà Playstation Now. ou Shadow. On avait l'air de s'en foutre pourtant c'est là, on peut les payer et tout. Y a qq différence au niveau des fonctionnalités avec le FUTUR google stadia, mais c'est déjà là, c'est du "streaming".

" Quoique en finissant cette phrase je repense à ma campagne avec son débit anémique..."

Le Monde Réel.

"Tout dépendra de l’évolution du haut débit ?"

catastrophique et conditionnée aux lubies politiciennes et aux impôts locaux.

dans 50 ans/500 ans/5 000 000 années, le monde sera différent de ce qu'il était, le propos du Oomu sera totalement différent.

Je dis simplement: il ne sert à rien de faire de la prospection de choses qu'on ne maîtrise pas.

-

pour l’instant, je vois le "streaming" comme une offre bas de gamme. Qui va rapidement exploser en myriade de services exclusifs sous abonnements.

après, si on a pas de grande passion du jeux vidéo, ça sera certainement très bien.

Par contre, si on ne jure que par le travail artistique d'un Shadow of Colossus, je continuerai d'investir pour être en total 4K (et demain 8K) sans artefact de compression, sans le moindre pet de latence, et le dernier supermonstrueux GPU en local qui débit du raytracing hdr machin chouette pour simuler la douceur des plumes des petits zozios.

Sans attendre que GoogleTrucMuche ait intégré un tiers de prix avec les nouveaux gpus de la mort.

-

A propos de Stadia, ce qui est plus intéressant, ce sont les usages nouveaux que Google propose. Parce que le jeu est un flux vidéo, ça permet toutes sortes d'usages nouveau. Le coté pratique va être plus motivant que la qualité du rendu. Google a plus d'imagination que Shadow ou Sony. Ils ont une approche "youtubesque" du jeux vidéo.

------------

Peu de gens achètent des "ultra bluray 4K" (Mad Max fury road est glorieux en ce format).

Mais si vous le faites, vous obtenez encore mieux que Netflix en 4K en abonnement premium. et sans se farcir internet.

@oomu

"bof. ça fait 30 ans que je vis la mort des consoles.

ha et la mort du PC aussi.

ha et la mort du Web (célèbre couv de Wired)

et la mort du théâtre

"

Tu as oublié la plus célèbre d’entres toutes : la mort de la radio !

@oomu

> Des SSD pcie4 devrait arriver en 2019.

Sachant qu'aucun SSD n'est encore capable de tenir du 16Go/s, techniquement du PCIe 3.0 suffirait encore. Le hic, c'est que pour cela faut squatter un connecteur x16, alors que la demande c'est plutôt avec des connecteurs x4, qui plafonne en PCIe 3.0 a 4Go/s.

Et là, oui, on a des technos V-3D-whatever-NAND qui dépassent déjà les 4Go/s...

" Je serai curieux d’entendre une véritable justification de ne pas rendre compatible les xéons pour le coup c’est de l’obsolescence déjà programmé ça ?"

intel n'a pas besoin de cela pour vendre des cargaisons de cpu et chipsets associés.

Quand elle estimera avoir une offre complète (cpu, cm, réseau et stockage avec les débits justifiant pcie4) pour motiver ses clients à tout racheter à nouveau, et que cela aura du sens pour augmenter le capital de ses investisseurs, alors là, Intel le fera.

Surveillez donc les annonces autour de optane, les chipsets des Carte mères pro, thunderbolt etc d'intel. pour pressentir quand intel se dira "hop, on sort le xeon + mieux qui va pousser à racheter tout le reste".

J’ai arrêté à l’AGP 8x de suivre

@misterbrown

Ha ha, idem ?

« Elle existe depuis 2010 et permet de bénéficier de débits qui peuvent atteindre 16 Gbit/s dans le meilleur des cas. »

Si je ne m’abuse, il s’agit en fait de 16 Go/s (en 16x) et non Gbit/s.

Idem pour les versions 4 et 5, qui passent le débit maximum à 32 et 64 Go/s respectivement.

Sinon, on n’aurait aucune difficulté à profiter pleinement de GPU externes en 16x, même via du Thunderbolt 2. :-)

@BeePotato

Arg, jamais j'y arriverai… Merci en tout cas, c'est corrigé !

@nicolasf

Pour être tout à fait précis, le débit max est de 126Gb/s, car le payload du PCIE3.x est de 2%

Le THB3 offre 32Go/s de bande passante pour un seul périphérique qui corespond à du PCIe3.0 4.x

J’ai lu des benchs de Carte Graphiques sur des PCIe2.0 x16, 3.0 x16, 2.0 x8...

Entre 2.0 et 3.0 x16, il n’y a pas de différence. Le PCIe 3.0 x4 abandonne 7 à 15%.

Peut-être que la raison pour laquelle Apple n’est pas passé au 4.0 est peut-être que 3.0 x16 n’est pas encore près de rendre les armes. Par contre, il n’a jamais assez de lignes.

Le THB4 sera au niveau du PCIE 3.0 x8

Et donc ceux qui utilisent des eGPU, il faudra attendre le THB4 pour avoir des perfs équivalentes aux PCIe embarqués, si et seuleument si l’écran restera externe. Si les images calculées reviennent à l’écran interne, 15% de perdu...

Toutafé, PCIe 3.0 c'est 8Gb/s par ligne, soit 1Go/s par ligne, et donc 16Go/s sur 16 lignes.

autre chose:

avez vous pensez que produire de la norme c'est aussi une activité commerciale ?

ici vous vous étonnez que le consortium PCI-SIG ponde régulièrement de nouvelles normes (pcie 4, 5, 6, 7, 8, 9, 10, 11, l'ensemble des entiers est très grand...)

mais c'est SON BOULOT !

c'est pour cela qu'elle EXISTE.

Pas pour attendre uqe Nvidia ou aautre abruti sorte une carte hein.

Cette entité existe pour pondre de la norme.

Les membres (industriels) du consortium la finance.

Les non-membres doivent payer pour lire les normes.

C'est son fond de commerce.

maintenant que pcie 6 est quasi finalisé, ben va falloir vendre du pcie7 les gars... Hein.

Ne prenez pas au sérieux ou du moins à coeur l'activité de touuuus les pans de l'industrie.

WIFI-Alliance aussi un consortium d'industriels (ou groupe d'intérêt) dont le _commerce_ c'est de pondre de la nouvelle norme radio et la vendre à l'industrie

(d'où les wifi 6, 7, 7.2326363, 8, MAX, etc.. plein de normes plein, faut bien que les salariés servent à quelque chose).

Des fois l'industrie trouve la norme intéressante (wifi 5/ac) des fois non (MAX).

Cela ne signifie pas qu'il y a un plan concerté de Oomu En Toge qui ont planifié de la sortie de Word 2048+cpu+boitier trop design couleur pantone été+série télé netflix+pcie 63+finale de footbelleux.

C'est juste un tas informe d'entreprises plus ou moins en guerres entre elles/partenaires. Parfois dans le tas 4 ou 5 se font secrètement une manipulation du marché pour torcher toutes les autres (et les clients avec) et elles sortent toutes des trucs tout le temps en espérant que le reste va accepter de les payer pour (ça serait cool)

et le constructeur d'un bidule final pour l’utilisateur final pioche dans tout ça au rythme qui lui plaît (au grand dam des fournisseurs de technos qui aimeraient qu'on les paie tous les jours).

-

ha, et votre RAM est ringarde au fait. On peut faire bien mieux que la DDR4trucmuche.

@oomu

> d'où les wifi 6, 7, 7.2326363, 8, MAX, etc..

Attention, la norme wifi 7.37 MAX est cloué au sol je crois.

Ou alors je confonds...

@oomu

"Oomu En Toge"

C’est à la mode en Corse, la toge ?

Retrocompatibilté ?! enfin si c’est possible

Oui, c'est rétro-compatible avec PCIe 3.0.

Et merde. J’en fait quoi de toutes mes cartes NuBus moi maintenant ?

Collector.

> De quoi augmenter encore les performances, à condition que les périphériques

> adoptent aussi cette norme évidemment.

Sachant que PCIe 4.0 et le future PCIe 6.0 sont rétro-compatibles : les cartes en PCIe 3.0 seront toujours utilisables dessus. Certes, les GPU et autres cartes ayant des besoins de bande passante énorme, genre les cartes multiports Ethernet 100Gb/s, les cartes accélératrices "codec" multi-streams profiteront d'une augmentation de la bande passante PCIe et feront le pas, mais pour une carte PCI Wifi par exemple, cela n'est pas nécessaire car le goulot d'étranglement n'est pas encore du côte bus PCI, très loin même.

doublon

Considérer que le nouveau Mac Pro n'a pas de PCI 4 à cause d'Intel n'est pas entièrement convaincant pour moi. Cela me rappelle d'une certaine manière le fait que les nouveaux MacBook Pro 15" n'avaient pas d'option de RAM à 32 Go car, selon Apple, Intel ne prenait pas en charge la RAM à faible consommation (argument qui ne m'avait pas convaincu à l'époque). Cette justification s'est révélée totalement fallacieuse, puisque la dernière version du MBP a 32 Go de RAM sans qu'il s'agisse de version à faible consommation.

Pour revenir au sujet, Apple aurait très bien pu offrir des configurations avec processeur AMD (AMD qui vient d'annoncer plusieurs modèles PCI 4) ; Apple n'utilise depuis longtemps que des cartes graphiques AMD.