Pourquoi est-ce que l’on trouve toujours autant d’écrans 1080p ?

À l’origine de ce constat, un communiqué de presse envoyé par NEC pour une nouvelle gamme de moniteurs, dont certains équipés en USB-C. Comme c’est une caractéristique encore relativement rare, nous pensions traiter l’information sur le site, avant de réaliser que ces écrans flambant neufs et équipés de la dernière norme en matière de connectique n’étaient pas 4K. Les modèles d’entrée de gamme, sans USB-C, sont même limités au 1080p, alors que ce sont des écrans de 27 pouces.

NEC vise les entreprises avec cette gamme, pas le grand public, mais est-ce pour autant une excuse ? Comment peut-on vendre en 2018 un écran de 27 pouces plus de 300 € avec une dalle 1080p ? Le modèle avec USB-C bénéficie d’une meilleure définition, du 1440p, mais il est affiché à plus de 1500 € sur le site du constructeur. Et à ce tarif, ne pouvait-on vraiment pas glisser une dalle 4K ?

Le 1440p, soit 2 560 x 1 440 pixels, c’est la définition de tous les écrans 27 pouces depuis des années, chez Apple depuis au moins 9 ans et le premier iMac 27 pouces. Et cela fait même 14 ans si on considère le Cinema Display 30 pouces, un monstre qui affichait une définition record à l’époque de 2 560 x 1 600 pixels, soit du 1440p avec légèrement plus de pixels en hauteur. Une définition qui, en passant, a pratiquement disparu du paysage aujourd'hui, même si Dell continue de commercialiser un modèle de 30 pouces similaire.

Le marché des écrans semble bloqué depuis une dizaine d’années, avec toujours les mêmes définitions proposées en règle générale. On trouve pléthore d’écrans 4K, c’est vrai, parfois même à des prix qui défient toute concurrence, à l’image de ce 28 pouces 4K de Samsung vendu moins de 290 €. Mais cette définition n’est pas devenue un standard et elle ne semble jamais vouloir le devenir, même sur les grands écrans. On peut ainsi facilement trouver des écrans de 32 pouces en 1080p, comme ce modèle de LG affiché à 236 €. Ce n’est pas cher, mais pour un usage bureautique courant, c’est dommage d’avoir une telle surface de travail physique et de ne pas vraiment pouvoir l’exploiter.

Difficile de caser plusieurs fenêtres sur du 1080p, alors qu’un écran de plus de 27 pouces est parfait pour cet usage. Mais le problème, c’est que ces considérations n’intéressent pas le marché, qui semble uniquement concentré sur une utilisation précise des moniteurs : les jeux. Même si les joueurs représentent certainement une minorité sur le marché des ordinateurs, c’est pour eux que les constructeurs semblent tous travailler. Les innovations, car il y en a toujours, ne sont pas du côté de la définition, mais de la fréquence des dalles.

Aujourd’hui, le mieux pour jouer n’est pas un moniteur 4K, mais un écran qui dépasse les 60 fps traditionnels pour proposer une vitesse de rafraîchissement supérieure. 100 Hz, 144 Hz, voire 180 Hz et même 240 Hz : on trouve des dizaines d’écrans qui font mieux, parce que le résultat est plus impressionnant en jeu. Et en général, ils sont bloqués au 1080p, les modèles plus haut de gamme peuvent atteindre le 1440p. Bon nombre de joueurs préfèrent en rester à la petite définition, pour éviter de changer de carte graphique.

Si le marché est autant déformé par les besoins des joueurs, c’est peut-être parce que cette catégorie est la seule qui achète encore des écrans d’ordinateurs. Le grand public a depuis longtemps tourné le dos aux ordinateurs fixes au profit des portables qui sont souvent utilisés seuls. Quant à la plus grosse masse des utilisateurs, ils sont dans un cadre professionnel où la définition de l’écran n’est pas souvent un critère. Déjà que la taille des moniteurs achetés en entreprise est parfois encore ridicule, alors allez essayer d’expliquer l’avantage de la 4K par rapport au 1080p.

Ce constat explique pourquoi NEC commercialise ces écrans destinés, justement au monde professionnel. Et pourquoi la majorité des modèles vendus sur internet sont destinés en priorité aux joueurs. Mais il n’empêche que cela fait une dizaine d’années maintenant que la définition n’a pas bougé et l’arrivée de la 4K ne semble rien y faire.

C’est d’autant plus frustrant que la définition de l’écran est l’une des caractéristiques les plus visibles sur un ordinateur. On disait plus tôt que la fréquence de rafraichissement était plus importante pour jouer, mais c’est un paramètre qui reste mystérieux pour la majorité des utilisateurs. Alors qu’un écran Retina, où les pixels ne sont plus visibles à l’œil nu, c’est un concept nettement plus facile à « vendre », puisque cela se voit. Nettement plus que le passage de la DDR3 à la DDR4, ou bien d’un SSD SATA à un modèle NVMe, par exemple.

La 4K n’est même pas la panacée

Pour ne rien arranger à l’affaire, la 4K n’est même pas la définition parfaite que tout le monde devrait adopter. Certes, la 8K arrive à grand pas, mais cela reste de l’ordre du rêve, ou en tout cas ce n’est pas pour aujourd'hui. En attendant, il y a mieux que la 4K pour les grands écrans. Ce n’est pas pour rien qu’Apple a opté pour de la 5K dans ses iMac 27 pouces et dans l’écran conçu par LG avec son approbation et qui fait office de moniteur Apple faute de mieux.

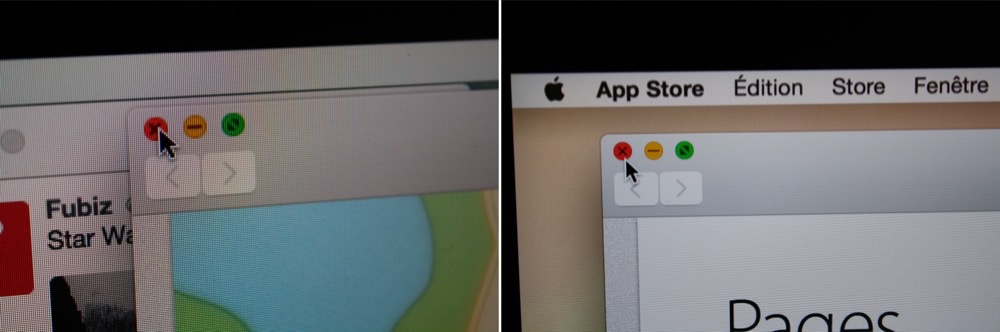

La 4K est parfaite pour succéder au 1080p, c’est quatre fois plus de pixels (deux fois plus à la verticale, deux fois plus à l’horizontale) et on peut ainsi bénéficier d’un affichage Retina @2x. Sous macOS, c’est le cas par défaut d’ailleurs, le système combine quatre pixels physiques en un seul pixel logique et affiche la même quantité d’informations, mais avec une bien meilleure définition. Le rendu est plus net, les pixels ne sont plus visibles.

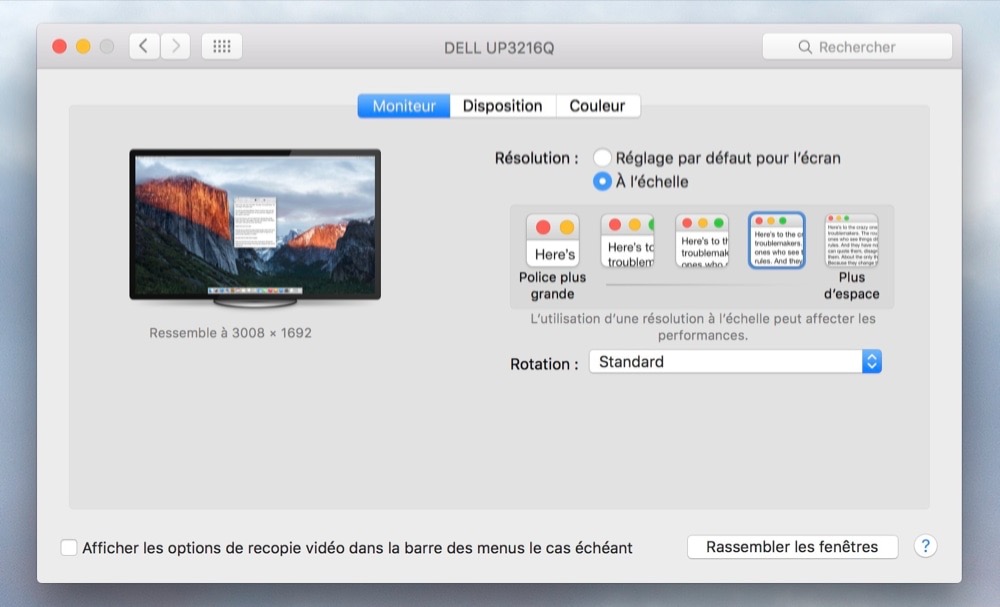

À partir de 27 pouces toutefois, la 4K commence à montrer ses limites puisqu’en partant de l’idée de quatre pixels pour un, on se cantonne au même affichage utile que le 1080p. Concrètement, la dalle dispose bien de 2 160 pixels de haut, mais le système n’en affiche que 1 080, comme si vous aviez un écran Full HD. Pour bénéficier de 1 440 pixels de haut en Retina, il faudrait 2 880 pixels physiques en hauteur, soit la définition d’un écran 5K.

Pour simplifier les choses, si la 4K est le mode Retina du 1080p, la 5K est le mode Retina du 1440p. Pour bien faire, il faudrait privilégier cette définition au-dessus de 27 pouces, alors que la 4K peut suffire pour les écrans plus petits. Hélas, le marché a choisi et les écrans 5K restent extrêmement minoritaires. Il faut dire qu’ils sont aussi compliqués à gérer aujourd'hui, ils nécessitent souvent deux câbles : bref, il y a de bonnes raisons actuellement d’en rester à 4K.

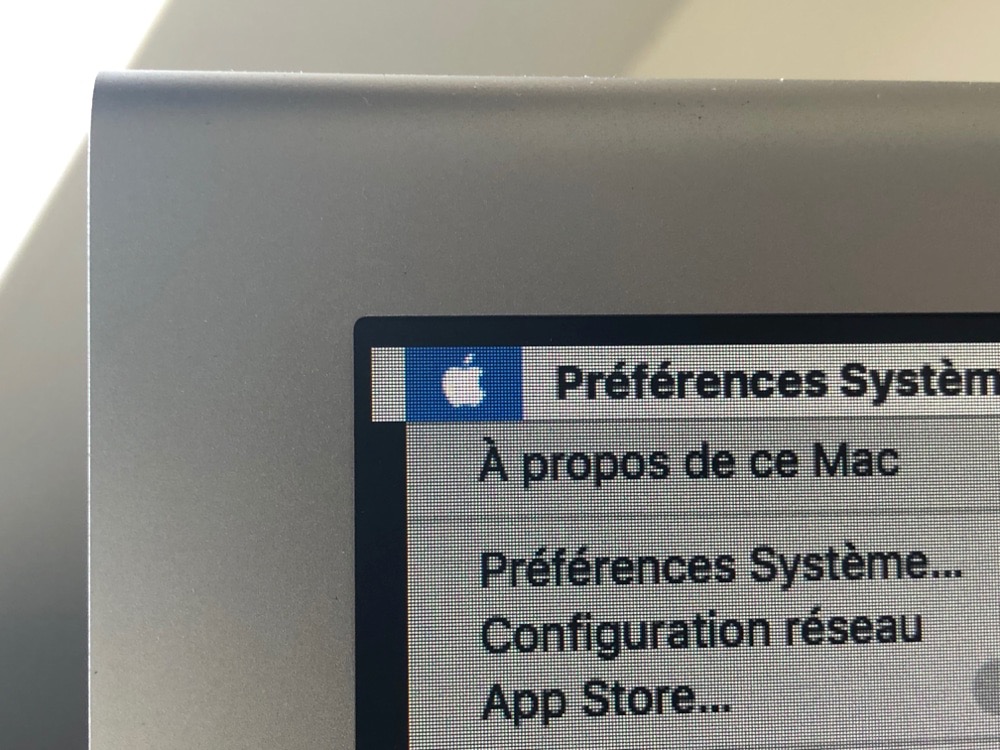

D’autant plus que macOS gère très bien ces nouvelles définitions, comme nous l’expliquions dans cet article dédié à la 4K. Le système d’Apple peut afficher un moniteur 4K dans sa définition physique de base (3 840 x 2 160 pixels), ou bien en vrai Retina (1 920 x 1 080 pixels), mais plusieurs crans intermédiaires sont proposés. Dans le lot, on a un mode qui simule le 1440p que l’on avait auparavant sur ces tailles d’écran. Ça n’est pas aussi net que le mode @2x, mais c’est nettement moins flou qu’un écran traditionnel, donc c’est un compromis qui peut être acceptable.

Pour finir, restons avec les Mac, mais évoquons les portables d’Apple. Si le constructeur a été le premier à passer dans le monde du Retina, avec le MacBook Pro 15 pouces présenté en 2012, il n’a jamais évolué depuis. Toute la gamme propose aujourd'hui du « faux » Retina, une définition physique insuffisante pour proposer une définition logique @2x, où chaque pixel affiché à l’écran est créé par quatre pixels sur la dalle. C’est un compromis qui était parfaitement logique il y a six ans, mais à l’heure où bon nombre de constructeurs concurrents proposent des portables dotés d’un écran 4K, on aimerait voir des évolutions sur ce point.

Une dalle 4K sur les MacBook Pro 13 ou 15 pouces serait idéale pour offrir un affichage par défaut parfaitement net, comme sur les iMac Retina. On imagine qu’Apple attend de pouvoir le faire avec suffisamment d’autonomie, c’est probablement le point qui bloque encore aujourd'hui.

surenchere permanente inutile dans bien des cas.

comme la 4 ou 8k sur un smartphone.

C'est amusant de voir MacG se rebeller contre les dalles 1080p (voire 4K !) sur les écrans fixes, mais ne pas voir de problème à ce que l'iPhone 8 soit toujours en 750p.

Si vous voyez la différence entre 1600p et 2160p sur un écran de 13 pouces, alors pas de doute que vous voyez la différence entre 320 ppi et 550 ppi sur un smartphone pour un usage comparable (consultation de sites web...).

Moi en tout cas, je la fais, la différence, sur les smartphones. Et pourtant, je ne suis pas sûr de la voir entre 1600p et 2160p sur 13 pouces ! (sur 15 pouces, par contre, si)

@sachouba

« mais ne pas voir de problème à ce que l'iPhone 8 soit toujours en 750p. »

Mdr, oui c’est scandaleux 750p sur un écran de... 4,7 pouces. Heureusement que Samsung est là pour faire les choses correctement ?

@ sachouba :

Donc, tu vois nettement la différence entre 320 ppp et 550 ppp sur un smartphone, mais tu serais incapable de voir la différence entre 230 ppp et 300 ppp sur un portable ? Plutôt étrange.

Tu es doté de très longs bras, qui te permettent d'utiliser un portable à deux mètres de distance ? :-)

@BeePotato :

J'ai dit que je n'étais pas sûr ; je n'ai pas encore essayé la 4K sur 13 pouces ! Seulement du 1600p, et je trouve ça déjà très bien résolu.

Mais la différence entre 1600p et 2160p sur 13 pouces serait moins notable pour mon usage que la différence entre 320 et 550 ppi sur un smartphone. Je ne pense pas que la 4K sur du 13 pouces soit une priorité, quand il y a déjà du 1600p.

Par contre, sur 15 pouces, la 4K est un vrai bonheur !

@ sachouba : « J'ai dit que je n'étais pas sûr »

D'où mon emploi du conditionnel. ;-)

Je mettais juste en doute le fait que tu n'y arriverais pas, vu que tu annonces être parfaitement capable de déceler une différence entre deux résolutions bien plus fines (certes à une distance un peu plus faible).

Pour le reste, je suis bien d'accord qu'une telle résolution sur un portable n'est pas une priorité quand on a déjà des écrans aux alentours des 230 ppp, ce qui d'après mon expérience est déjà suffisant pour un bon confort de lecture.

Cependant, le fait que ce ne soit pas une priorité ne signifie pas que ce soit inutile : à la distance à laquelle j'utilise habituellement un portable, on distingue encore les pixels à 230 ppp. Ils sont très fins et je ne trouve pas ça pas gênant, mais un saut au delà des 300 ppp serait donc perceptible et pas désagréable.

Au delà, en revanche, ça commencerait à ressembler à la ridicule course à la résolution qu'on a pu voir chez certains constructeurs de smartphones.

@BeePotato

"Au delà, en revanche, ça commencerait à ressembler à la ridicule course à la résolution qu'on a pu voir chez certains constructeurs de smartphones."

Rien que pour le texte, une plus haute définition est bénéfique. On peut abandonner l’anti-aliasing, mieux, on peut abandonner le sub-pixel rendering. Les conséquences sont multiples : texte plus net, plus d’effets de bords colorés, rendu moins consommateur en CPU (et oui)...

@ fte : « Rien que pour le texte, une plus haute définition est bénéfique. »

Attention : j'ai toujours été de ceux défendant l'intérêt des écrans à haute résolution comme étant avant tout bénéfique pour l'affichage de texte.

Mais dans mon commentaire, je parlais d'une résolution au delà des 300 ppp. Même pour du texte, le gain entre 300 ppp et une résolution plus élevée, à la distance à laquelle on utilise généralement ces écrans (distance plus élevée que pour un smartphone), sera minime, voire imperceptible pour la plupart des gens.

D'où ma conclusion qu'il s'agirait alors principalement d'une course au nombre le plus élevé plutôt que d'une recherche d'un vrai gain de confort.

« On peut abandonner l’anti-aliasing, mieux, on peut abandonner le sub-pixel rendering. »

Le subpixel rendering est déjà abandonné par Apple avec Mojave, alors même que les écrans les Mac sont encore en deçà des 300 ppp. Mais à 220-230 ppp, ils affichent déjà le texte très confortablement (même si je ne nie absolument pas que ça puisse être amélioré par une nouvelle montée en résolution — j'explique juste qu'il n'y aura pas besoin d'aller bien au delà des 300 ppp).

« rendu moins consommateur en CPU (et oui)... »

Je ne me prononcerai pas sur ce point, ne connaissant pas l'implémentation actuelle de ce rendu dans Mac OS et étant donc incapable de comparer sa complexité avec celle du calcul d'un nombre plus élevé de pixels.

@BeePotato

"j'explique juste qu'il n'y aura pas besoin d'aller bien au delà des 300 ppp"

C’est un discours entendu il y a longtemps à propos des imprimantes laser 300dpi. Puis 600dpi. Puis les jet d’encre 1200dpi. Puis les jets d’encre 2400dpi.

On en est à 1200dpi et 4800dpi en général. Il y a mieux. Voire 2400 et 9600 en haut de gamme.

Les explications pour justifier de ne pas aller plus loin ne font que se reporter sur le plus loin suivant...

@ fte : « C’est un discours entendu il y a longtemps à propos des imprimantes laser 300dpi. »

Pas vraiment, non. On pouvait voir clairement, à l'époque, que 300 ppp, bien que représentant un gain significatif en terme de qualité, étaient insuffisants pour l'impression.

Mais ces derniers mots sont importants : « pour l'impression ».

Là, on ne parle pas d’une sortie sur papier, où la résolution spatiale sert aussi à la profondeur de couleurs en raison du tramage utilisé pour rendre les couleurs et les niveaux de gris.

On parle d’écrans, où la résolution spatiale ne joue pas ce double rôle et n’a donc pas besoin d’être aussi élevée.

« Puis 600dpi. Puis les jet d’encre 1200dpi. Puis les jets d’encre 2400dpi. »

Les imprimantes laser que j’utilise tous les jours sont réglées par défaut en 600 ppp, même si elles disposent d’une option 600x1200 ppp pour les sorties de meilleure qualité.

Oui, on a inventé du matériel capable de résolutions plus élevées, mais dans le même temps tout le monde a bien réalisé qu’elles sont superflues pour le cas le plus courant — du texte noir sur fond blanc.

Vu le coût élevé (en puissance nécessaire) induit par l’augmentation de la résolution des écrans, j’ose espérer que cette augmentation se calmera assez rapidement, une fois une résolution « raisonnable » atteinte. Quelque part entre 300 et 400 ppp, j’espère — et au pire (je croise les doigts) aux alentours des 600 ppp.

Bien sûr, le comportement des fabricants de smartphones dans ce domaine peut rendre pessimiste…

@BeePotato

Pour ma part, et je n’ai pas effectué le calcul, la résolution idéale sera atteinte lorsqu’on pourra afficher n’importe quelle image à n’importe scaling sans antialiasing ni effet de flou introduit par la matrice d’affichage. En considérant Nyquist et mon nez, je dirais que la résolution minimale pour y arriver devrait tourner autour de 800dpi, peut-être un peu plus. On n’y est pas encore.

Quant à l’impression, la finesse d’impression permet de mieux moduler les trames d’impression. 1200 est ok, 2400 c’est mieux en BW. 9600 en couleurs pour de belles trames fines et dégradés sans solarisation.

@ fte : « Pour ma part, et je n’ai pas effectué le calcul, la résolution idéale sera atteinte lorsqu’on pourra afficher n’importe quelle image à n’importe scaling sans antialiasing ni effet de flou introduit par la matrice d’affichage. »

Gné ?

On pourra toujours trouver une image ou une échelle d’affichage nécessitant de l’anti-aliasing, donc c’est une définition bizarre de la résolution idéale.

Une définition bien plus simple repose sur la limite de perception de l’œil humain, associée à la distance normale d’usage de l’écran concerné : ça permet de déterminer la résolution au delà de laquelle il est totalement inutile de monter.

Mais bien avant ça on sera passé par la résolution au delà de laquelle il n’est pas franchement utile de monter. ;-)

« Quant à l’impression, la finesse d’impression permet de mieux moduler les trames d’impression. »

Oui, c’est précisément ce que je t’ai rappelé dans mon commentaire précédent : dans le cas de l’impression, la résolution spatiale joue un rôle supplémentaire, qu’elle n’a pas dans le cas d’un écran, ce qui fait qu’un écran n’a pas besoin d’une résolution aussi élevée qu’une imprimante.

@BeePotato

"Une définition bien plus simple repose sur la limite de perception de l’œil humain, associée à la distance normale d’usage de l’écran concerné"

Nope. Nyqvist a dit x 2, en plus de ces points. Quand à la distance, ce n’est pas la distance moyenne ou normale qui compte, mais bien le cas le plus défavorable. Par exemple : le Surface machin de Microsoft, façon iMac table lumineuse, le nom m’échappe, regardé de près, de plus près que "normal".

@ fte : « Nope. »

Yup. :-P

« Nyqvist a dit x 2, en plus de ces points. »

Ce qui… (roulement de tambour)… repose bel et bien sur les éléments que j’ai listés, exactement comme je l’ai indiqué.

Merci d’éviter de sous-estimer son interlocuteur. ;-)

« Quand à la distance, ce n’est pas la distance moyenne ou normale qui compte, mais bien le cas le plus défavorable. »

Non, puisque le cas le plus défavorable, c’est l’écran observé avec un microscope, et je ne vois pas pourquoi on devrait s’emmerder à afficher une bonne résolution même dans ce cas.

Vraiment, c’est la distance d’utilisation « normale » qui compte. Évidemment, c’est déjà délicat de déterminer quel intervalle de distance on considèrera comme représentant un usage « normal », et évidemment aussi, on s’intéressera à la borne inférieure de cet intervalle pour fixer la résolution qu’on veut atteindre — mais ça ne représente pas pour autant le cas le plus défavorable, et on ne voit pas pourquoi il serait souhaitable de s’intéresser à ce dernier.

@BeePotato

"Non, puisque le cas le plus défavorable, c’est l’écran observé avec un microscope, et je ne vois pas pourquoi on devrait s’emmerder à afficher une bonne résolution même dans ce cas."

Monsieur pinaille. Soit. Le choix des termes n’était pas idéal, c’est ma faute.

J’avais exclu d’emblée le microscope à effet tunnel de l’équation, je suis stupide, j’aurais dû penser que quelqu’un en avait un dans son bureau et s’en servait pour regarder son écran.

J’ajouterais "à l’oeil nu" la prochaine fois.

@ fte : « J’avais exclu d’emblée le microscope à effet tunnel de l’équation, je suis stupide, j’aurais dû penser que quelqu’un en avait un dans son bureau et s’en servait pour regarder son écran. J’ajouterais "à l’oeil nu" la prochaine fois. »

J’espérais que tu ne te planquerais pas derrière le trait d’humour du microscope. Je suis déçu.

Ajouter « à l’œil nu » ne change rien : le cas le plus défavorable à l’œil nu, c’est le gusse qui se penche sur son écran au point de n’en être qu’à quelques centimètres. Il est tout aussi vain de concevoir un écran avec un résolution qui permettrait d’assurer des pixels indiscernables dans ce cas — ce serait un pur gaspillage.

Encore une fois, ce n’est vraiment pas le cas le plus défavorable qui est à prendre en compte pour ce genre de décision. C’est l’intervalle de distance correspondant à l’utilisation attendue (« normale ») pour l’écran.

@BeePotato

"C’est l’intervalle de distance correspondant à l’utilisation attendue (« normale ») pour l’écran."

Je ne crois pas.

Tu sembles penser que la technologie doit répondre à un besoin et s’y cantonner. Mais ce n’est pas uniquement ainsi que la technologie évolue.

Parfois la technologie précède les usages, usages rendus possibles parce que quelqu’un de plus créatif que les autres détourne un outil de son usage pour en faire autre chose.

Apple est par ailleurs spécialiste de cette méthode : imposer des trucs sans savoir à quoi ça sert ni si ça va prendre. Et parfois boom, des inventeurs s’emparent du truc et en font quelque chose d’utile et d’intéressant.

La science avance comme ça. Des recherches souvent inutiles, ou en tout cas pas dictées par le besoin immédiat, des découvertes qui ne servent à rien, mais qui enrichissent le savoir et font avancer tout l’édifice et les autres disciplines.

Bref. Tout ça pour des pixels. Je pense qu’il faut voir plus loin que les usages et besoins actuels. Il faut des écrans à 1200 dpi. Quelqu’un saura quoi en faire.

@ fte : « Tu sembles penser que la technologie doit répondre à un besoin et s’y cantonner. »

Non.

Je ne fais pas dans la généralité. Je parle juste du cas précis abordé ici : un écran pour ordinateur portable de 13 à 15 pouces.

« Apple est par ailleurs spécialiste de cette méthode : imposer des trucs sans savoir à quoi ça sert ni si ça va prendre. »

Ne pas savoir si ça va prendre, c’est en effet régulièrement le cas.

En revanche, on sait généralement plutôt bien à quoi ça sert. J’ai du mal à me rappeler, dans l’histoire d’Apple, des exemples de trucs sortis sans savoir à quoi ils pourraient bien servir.

« Il faut des écrans à 1200 dpi. Quelqu’un saura quoi en faire. »

Loufoque.

Inventer la technologie permettant de créer de tels écrans, en espérant que quelqu’un en trouvera une application intéressante, ok. Mais les déployer à grande échelle sur tout un tas d’ordinateurs portables avant qu’une telle application ait été trouvée, juste en se disant « quelqu’un saura quoi en faire » ? Ce serait du gaspillage.

@BeePotato

"des exemples de trucs sortis sans savoir à quoi ils pourraient bien servir."

TouchBar. ARKit. QuickDraw GX, typo en particulier (qui n’a jamais servi à rien). L’Apple Watch...

"juste en se disant « quelqu’un saura quoi en faire » ? Ce serait du gaspillage."

Les drones c’était du gaspillage. Les GoPro c’était du gaspillage. Le LHC est un énorme gaspillage. Mais qu’importe, le capitalisme tout entier repose sur le gaspillage, et l’invention de nouveaux gaspillages.

Tu as raison. Notre monde est totalement loufoque.

@ fte : « TouchBar. ARKit. QuickDraw GX, typo en particulier (qui n’a jamais servi à rien). L’Apple Watch... »

ARKit, ok. C’est vraiment une sorte d’OVNI en attente que quelqu’un en trouve un utilisation.

Pour le reste, pas d’accord.

« Mais qu’importe, le capitalisme tout entier repose sur le gaspillage, et l’invention de nouveaux gaspillages.

Tu as raison. Notre monde est totalement loufoque. »

Ouaip.

Il est sans doute vain d’essayer de lutter contre ça.

Cela dit, si on renonce à la lutte, alors ça fait vraiment petit joueur de se limiter à des écrans à 1200 ppp. :-P

Il faut des écrans à 20000 ppp. Quelqu’un saura quoi en faire.

Plus sérieusement, notre désaccord semble reposer sur le fait que, sur ce sujet du moins, tu tournes en mode « if you build it, they will come ».

Moi, dans ce cas précis (et donc pas du tout pour le LHC ou plein d’autres choses), je préfère « get ready to build it in case they come ». ;-)

@BeePotato

"Il faut des écrans à 20000 ppp. Quelqu’un saura quoi en faire."

Les viseurs électroniques d’appareils photo ou autres engins à viseurs pourraient sans aucun doute bénéficier de matrices à ultra haute définition. Ou des projecteurs rétiniens. Combien de dpi exactement, je ne sais pas, mais ton chiffre sonne bien.

"Plus sérieusement, notre désaccord semble reposer sur le fait que, sur ce sujet du moins, tu tournes en mode « if you build it, they will come »."

Assez d’accord avec cette expression de notre désaccord. Je dirais cependant que je suis plus en mode "if you can build it, build it", mais je reste d’accord avec ta formule.

Au passage, encore un exemple de tramage appliqué aux écrans : Kindle.

@ fte : « Les viseurs électroniques d’appareils photo ou autres engins à viseurs pourraient sans aucun doute bénéficier de matrices à ultra haute définition. Ou des projecteurs rétiniens. Combien de dpi exactement, je ne sais pas, mais ton chiffre sonne bien. »

Oh, oui, il sonne bien.

Cependant, comme j’ai pris le soin de le rappeler plusieurs fois pour essayer d’éviter (en vain) ce genre de hors-sujet, la discussion portait sur la résolution d’écrans de portables classiques de 13 à 15 pouces.

Il est évident pour tout le monde que des écrans de taille et usage différents ont des contraintes différentes et donc une résolution optimale différente. Mais ça ne fait pas avancer la discussion de répéter cette évidence.

« Je dirais cependant que je suis plus en mode "if you can build it, build it", mais je reste d’accord avec ta formule. »

Dison que ma formule donnait plus dans la référence cinématographique. ;-)

(Légèrement incorrecte d’ailleurs, car il me semble que c’était « if you build it, he will come »)

« Au passage, encore un exemple de tramage appliqué aux écrans : Kindle. »

Jusque là, on parlait de tramage pour des écrans affichant des couleurs sur 24 voire 30 bits. Ce n’est pas le cas des Kindle, si je ne m’abuse (à moins que je n’aie pas suivi une récente évolution de la gamme).

@BeePotato

"Jusque là, on parlait de tramage pour des écrans affichant des couleurs sur 24 voire 30 bits. Ce n’est pas le cas des Kindle, si je ne m’abuse (à moins que je n’aie pas suivi une récente évolution de la gamme)."

Niveaux de gris en 300 dpi. Et du tramage. Il y a eu une génération 4-bit ou deux, 8-bit maintenant.

@ fte : « Niveaux de gris en 300 dpi. »

C’est donc bien, comme je le pensais, en dehors du cadre de ce dont on discutait jusque là.

Oui, sur des écrans à niveaux de gris, et plus encore sur des écrans noir et blanc, une montée vers de très hautes résolutions serait bien utile, pour rendre invisible le nécessaire tramage. Encore une fois, chaque type d’écran / d’usage a ses propres contraintes, c’est évident.

@BeePotato

"Il est évident pour tout le monde que des écrans de taille et usage différents ont des contraintes différentes et donc une résolution optimale différente."

Absolument.

Pour ce type d’écrans, je pense que 800 dpi comme évoqué plus haut, soit donc un pouvoir séparateur de 400 lpi (l pour lines), est une bonne cible pour commencer. 200 dpi est clairement insuffisant. On peut le vérifier aisément, on peut encore voir les lignes adjacentes les plus fines. Ou des escaliers sur les lignes inclinées. Sur les OLED Samsung, c’est un brin problématique à cause de la matrice de couleurs, ça fait des moirés déplaisants dans toutes les directions. J’imagine que c’est pour ça que Samsung a monté la résolution aussi vite aussi haut.

Note bien, je n’essaie pas de te convaincre. J’explique juste, certes maladroitement, pourquoi je pense que c’est utile de monter la résolution encore plus haut. Plus on monte haut, plus les besoins ou usages satisfaits par ces très hautes résolutions se réduisent. Dans 99% des cas, ça ne sert à rien qu’un écran puisse afficher deux lignes adjacentes et que l’oeil ne puisse plus les séparer, ni qu’une trame d’affichage soit si fine qu’elle soit imperceptible (c’est pas loin d’être le cas déjà). Il y a ce 1% cependant. C’est celui qui m’intéresse. Le reste est chiant.

@ fte : « Note bien, je n’essaie pas de te convaincre. »

C’est heureux. :-)

Notamment parce que ton commentaire abonde dans le sens de ce que j’expliquais jusque là, en rappelant qu’avec 200 et quelque ppp on n’est pas encore arrivé à une résolution totalement satisfaisante pour ces écrans, mais que pour 99 % des cas on n’aura tout de même pas besoin de monter jusqu’à des résolutions énormément plus élevées que ça.

« Il y a ce 1% cependant. C’est celui qui m’intéresse. Le reste est chiant. »

Même pas sûr que ça représente 1 %. Mais quoi qu’il en soit, l’idée que je défends est de ne pas imposer aux 99 % d’autres utilisateurs les contraintes liées aux besoins de ce 1 % (jusqu’au jour où ces contraintes seront devenues quasiment imperceptibles, bien sûr, grâce à des CPU/GPU surpuissants couplés à des quantités de RAM à peine imaginables de nos jours, le tout disponible pour une bouchée de pain).

@BeePotato

"Mais quoi qu’il en soit, l’idée que je défends est de ne pas imposer aux 99 % d’autres utilisateurs les contraintes liées aux besoins de ce 1 %"

Hum. Certains écrans 27" (il y en a peut-être d’autres de plus petite diagonale, sûrement même, mais je ne me suis pas penché sur la question) 1440p sont vendus comme tel bien qu’en réalité équipés d’une dalle 4K. Il y a du scaling forcé, un léger flou introduit. Parce que les dalles 4K sont légion et leur coût a considérablement baissé et qu’il est plus économique de ne produire qu’un type de dalle plutôt que deux.

Le x% minoritaire est déjà imposé au y% majoritaire...

Soit dit en passant, les mises à l’échelle sur des écrans à très haute définition introduisent toujours un flou (si le multiple n’est pas entier), mais si ce flou est rejeté au delà du pouvoir séparateur de l’écran, il ne se verra plus si les dpi / lpi sont assez élevés. Autre avantage d’une très haute définition donc : une indépendance de la résolution d’image affichée, par une mise à l’échelle sans altération visible.

@ fte : « Le x% minoritaire est déjà imposé au y% majoritaire... »

Je pensais plus aux contraintes en termes de CPU et GPU. Forcer tout le monde à avoir des machines gérant quatre fois plus de pixels que raisonnablement nécessaire, quoi.

@BeePotato

"la résolution spatiale joue un rôle supplémentaire, qu’elle n’a pas dans le cas d’un écran, ce qui fait qu’un écran n’a pas besoin d’une résolution aussi élevée qu’une imprimante."

Faux. Ce n’est pas parce qu’il y a des niveaux par pixel qu’il n’y a pas de trames ou dithering. Ça joue aussi.

@ fte : « Faux. »

Ben non. C’est vrai, tout simplement. Je ne vois pas bien comment t’expliquer un truc aussi évident, désolé.

Mais on a cette évidence sous les yeux tous les jours, si ça peut t’aider à t’en rendre compte.

(Et bien sûr, en écrivant un tel commentaire, je ne suis probablement pas fidèle à la recommandation que j’ai exprimée précédemment quant à la façon de considérer son interlocuteur. Si c’est le cas, n’hésite pas à me le prouver en expliquant clairement ce à quoi tu faisais référence.)

@BeePotato

"Ben non. C’est vrai, tout simplement. Je ne vois pas bien comment t’expliquer un truc aussi évident, désolé."

Ok, exemple concret facile.

Il n’y a que fort peu de différences entre une impression papier et un écran. Si l’espace entre deux lettres est de n centièmes de millimètres, cette distance sera arrondie selon la finesse de la grille d’impression ou d’affichage. Une meilleure finesse, une meilleure précision. Papier ou écran, idem, même besoin de précision. (Windows et macOS ont apporté des solutions lowdpi différentes, déformations des caractères pour le premier, antialiasing agressif et flancs flous pour le second, aucune n’est idéale, seule une haute résolution l’est.)

Dit autrement, si tu veux ajuster deux pièces mécaniques précisément, c’est mieux de disposer d’un pied à coulisse de précision que d’un mètre ruban de couturière.

Je ne te sous-estime pas du tout. C’était faux, voilà tout.

@ fte : « Il n’y a que fort peu de différences entre une impression papier et un écran. »

Si, en fait, il y en a une énorme : le rendu des couleurs, qui nécessite un tramage à l’impression dont on n’a plus besoin à l’écran depuis la généralisation de la couleur sur 24 bits.

« Si l’espace entre deux lettres est de n centièmes de millimètres, cette distance sera arrondie selon la finesse de la grille d’impression ou d’affichage. Une meilleure finesse, une meilleure précision. Papier ou écran, idem, même besoin de précision. »

Oui, c’est gentil de m’expliquer ce que je sais parfaitement, mais rien de cette explication n’a quoi que ce soit à voir avec ce dont on parlait : la nécessité d’une résolution plus élevée à l’impression pour assurer le rendu des couleurs et le fait qu’un écran ne subit pas cette contrainte (sauf pour les nostalgiques de l’affichage en 256 couleurs) et n’a donc pas besoin d’une résolution aussi élevée qu’une imprimante — juste suffisamment élevée pour assurer un bon rendu du texte.

« C’était faux, voilà tout. »

Ben non. C’était — et ça reste — parfaitement vrai.

@BeePotato

"Si, en fait, il y en a une énorme : le rendu des couleurs, qui nécessite un tramage à l’impression dont on n’a plus besoin à l’écran depuis la généralisation de la couleur sur 24 bits."

Faux encore une fois.

Fais un beau dégradé vert - blanc, et observe ton écran de près.

Selon le logiciel, tu verras des bandes vertes ou tu n’en verras pas. Si tu en vois, le logiciel ne crée pas de "trame". Si tu n’en vois pas, c’est que le logiciel en utilise une.

Ou un écran 10 bit. Encore que, selon le dégradé, ça se verra encore. 12 bit c’est mieux. Et pour rejeter le bruit de traitement des images, des fichiers 16 bits par composante sont recommandés. Voire plus.

@ fte : « Faux encore une fois. »

Non, une fois de plus.

Täche de faire un énorme effort pour arrêter de me prendre pour un débile ignorant, merci. :-)

J’aurais dû être plus précis cependant : « dont on n’a plus besoin à l’écran pour afficher des couleurs sur 24 bits (voire 30 maintenant), alors que l’impression nécessite un recours au tramage dès 2 bits ». Pour moi, il était implicite que je parlais de l’affichage des formats d’image actuellement utilisés.

« Fais un beau dégradé vert - blanc, et observe ton écran de près. Selon le logiciel, tu verras des bandes vertes ou tu n’en verras pas. »

J’espère bien que j’en verrai ! Vu que c’est le comportement normal attendu pour de la couleur codée sur 24 bits.

Je n’ai pas connaissance de logiciels qui s’amuse à tenter de contrer ça en ajoutant un tramage à la volée. Il y en a ?

« Ou un écran 10 bit. Encore que, selon le dégradé, ça se verra encore. 12 bit c’est mieux. »

Comme tu le fais remarquer, la voie dans laquelle s’est engagée l’industrie des écrans, c’est celle de technologies d’affichage supportant une plus grande profondeur de couleur pour chaque pixel — et non un retour au tramage.

Merci de confirmer implicitement ce que je disais. ;-)

« Et pour rejeter le bruit de traitement des images, des fichiers 16 bits par composante sont recommandés. Voire plus. »

Selon les traitements que l’on doit appliquer, on pourra toujours souhaiter des données de départ à la plus haute résolution possible (qu’il s’agisse de résolution spatiale ou de profondeur de couleur), c’est évident et c’est comme ça dans tous les domaines.

Mais ça n’a rien à voir avec l’affichage et donc avec notre discussion.

@BeePotato

"Je n’ai pas connaissance de logiciels qui s’amuse à tenter de contrer ça en ajoutant un tramage à la volée. Il y en a ?"

Compare le rendu d’InDesign ou Illustrator avec le rendu de Photoshop.

@ fte : « Compare le rendu d’InDesign ou Illustrator avec le rendu de Photoshop. »

Mais là, on ne parle pas de tramage pour le rendu des couleurs lors de l’affichage à l’écran. On parle de tramage intégré au document, créé à la résolution du document, pour contourner les limites de la profondeur de couleurs utilisée pour le document.

Pas la même chose.

@BeePotato

"Mais là, on ne parle pas de tramage pour le rendu des couleurs lors de l’affichage à l’écran."

Si. Justement. Le moteur d’affichage écran de ces logiciels applique une trame. Photoshop pas.

@ fte : « Si. Justement. Le moteur d’affichage écran de ces logiciels applique une trame. Photoshop pas. »

Ah. Désolé, je ne savais pas, n’étant pas utilisateur de ces logiciels. Je pensais au contraire que tu faisais référence à un tramage appliqué par Photoshop lors de la création d’un dégradé.

C’est une bien curieuse idée de la part des développeurs de ces logiciels.

@BeePotato

"C’est une bien curieuse idée de la part des développeurs de ces logiciels."

C’est pas étrange du tout. Visuellement le dégradé est continu et quasi-parfait. Sur écran hidpi comme mon notebook, c’est bluffant.

La technique était utilisée extensivement déjà sur les premiers Mac, Amiga, Atari TOS, en b&w comme en palette 8-bit, c’est vieux comme l’affichage graphique. Et toujours utilisé aujourd’hui, même pas en terriblement plus sophistiqué.

@ fte : « C’est pas étrange du tout. Visuellement le dégradé est continu et quasi-parfait. »

Oui, je sais bien à quoi sert le tramage, merci.

En fait, je trouvais ça étrange qu’un logiciel de création graphique donne à son utilisateur un rendu de l’image en cours de création différent du rendu que verront ensuite les consommateurs de cette image, la visualisant via un autre logiciel ne faisant pas appel, lui, au tramage.

Mais c’était parce que je me focalisais sur l’idée d’une exploitation de l’image en format vectoriel, avec donc un rendu dépendant du logiciel de visualisation.

Ce n’est qu’après avoir écrit mon commentaire que je me suis rappelé que les productions réalisées avec InDesign étaient encore majoritairement destinées à l’impression plutôt qu’à un export en PDF, et que les images crées dans Illustrator pour être visualisées ensuite sur écran l’étaient, dans l’immense majorité des cas, via un site web et donc dans un format bitmap incluant le tramage d’Illustrator.

Ce n’est donc finalement pas un choix si curieux. :-)

« Sur écran hidpi comme mon notebook, c’est bluffant. »

Et sans même avoir besoin d’un écran à 1200 ppp ! ;-)

« La technique était utilisée extensivement déjà sur les premiers Mac, Amiga, Atari TOS, en b&w comme en palette 8-bit, c’est vieux comme l’affichage graphique. »

Oui, c’est bien pour ça que je rappelais que c’était principalement un truc du passé. J’ai aussi connu cette époque.

Le tramage que je trouvais le plus convaincant en noir et blanc était celui obtenu par l’algo de Bill Atkinson.

« Et toujours utilisé aujourd’hui, même pas en terriblement plus sophistiqué. »

Quasiment plus utilisé aujourd’hui, à part dans quelques logiciels tels ceux que tu as cités.

Et, on l’espère, bientôt rendu totalement inutile par de nouveaux progrès dans les écrans.

@BeePotato

"Oui, je sais bien à quoi sert le tramage, merci."

J’avais compris. Chill. Tu n’es peut-être pas le seul à lire et peut-être que le sujet n’est pas maîtrisé par tous, hein...

@ fte : « J’avais compris. »

À voir combien de fois tu répétais la même chose, je n’en étais pas totalement sûr. ;-)

« Tu n’es peut-être pas le seul à lire »

À mon avis, il ne doit plus y avoir grand monde qui nous lit… :-)

@BeePotato

"et non un retour au tramage."

Il n’y a pas de retour au tramage. Il n’a jamais été abandonné.

@BeePotato

"Ben non. C’était — et ça reste — parfaitement vrai."

Il y a quelque chose de terriblement faux dans cette affirmation.

On ne peut pas prédire les usages futurs. On ne peut pas affirmer qu’une avancée technologique est inutile - était et reste et sera -. Il suffit d’un illuminé pour trouver un usage, et les illuminés, franchement, ce n’est pas ce qui manque. (Dans le bon sens du terme.)

640 Ko de mémoire est assez pour tout le monde.

Jusqu’à ce que quelqu’un trouve un usage pour 641 Ko. Ou 2 GB dans un téléphone. Ou 10 TB (ça existe et c’est utile).

@ fte : « Il y a quelque chose de terriblement faux dans cette affirmation. »

Moi, j’y vois surtout du terriblement vrai.

« On ne peut pas prédire les usages futurs. »

C’est peut-être pour ça que l’affirmation que tu cites ne contenait aucune trace de futur. Mais vu que tu sembles avoir oublié à quoi elle faisait référence, il n’est sans doute pas bien gênant que tu décides d’y voir un verbe au futur. :-)

« 640 Ko de mémoire est assez pour tout le monde. Jusqu’à ce que quelqu’un trouve un usage pour 641 Ko. Ou 2 GB dans un téléphone. »

C’est beau, de citer des exemples qui n’ont rien à voir avec le sujet dont on discute. :-)

« Ou 10 TB (ça existe et c’est utile). »

10 To dans un téléphone ? Ça existe ? Où ?

@BeePotato

"10 To dans un téléphone ? Ça existe ? Où ?"

D’un côté tu imagines que je te prends pour un crétin des Alpes, ce que je ne fais pas, de l’autre tu sors ça... je n’ai d’autre choix que de commencer à penser que tu te paies ma tête.

@ fte : « je n’ai d’autre choix que de commencer à penser que tu te paies ma tête. »

Ben relis ce que tu as écrit : « Ou 2 GB dans un téléphone. Ou 10 TB (ça existe et c’est utile). »

Ça ne brille pas par sa clarté.

Soit on se dit que cette mention des 10 To fait aussi référence aux téléphones, comme pour les 2 Go — et on a ma réaction.

Soit on évite toute tentative d’interprétation et on se dit que ça fait référence au fait que le concept de 10 To existe — et on se dit « ben oui, ça existe depuis l’invention du concept de To, et c’est effectivement utile pour exprimer ce qui se trouve entre 9 To et 11 To, mais je ne vois pas ce qu’il y a de renversant là dedans ».

Soit on s’essaye à imaginer d’autres interprétations. Comme celle de se dire que ça parlait en fait d’un disque dur de 10 To — et là, on se dit « ben oui, ça existe depuis un petit moment et ça n’a rien d’extraordinaire, et surtout l’utilité en est immédiatement évident, au contraire d’un écran à 1200 ppp sur un portable de 13 pouces ». Ou encore comme celle de se dire que ça faisait référence à un espace de stockage de 10 To — et là, on se dit la même chose, assortie de la remarque comme quoi ça fait bien plus longtemps que ça existe et que l’utilité est encore plus évidente.

Bref, non, je ne me paye la tête de personne.

J’essayais juste de trouver quel pouvait bien être de truc de 10 To qui serait apparemment sorti avant que qui que ce soit ait pu en imaginer un usage. La seule hypothèse qui collait à cette contrainte, tout en collant bien avec la phrase précédente, était celle du téléphone, malgré son côté peu crédible.

@fte :

"En considérant Nyquist et mon nez"

La fréquence de Nyquist ? Je ne vois pas le lien...

@sachouba

Un écran 800 dpi n’a un pouvoir de séparation "que" de 400 dpi.

Le retina est défini sur la base de la perception des pixels. Disons que c’est la définition du pauvre...

Ce qui compte vraiment, et ce qui a du sens, pour une vraie définition de retina serait lorsque l’oeil ne peut plus séparer deux lignes fines adjacentes. Pour ça, le retina tel que défini par Apple est insuffisant, il faut doubler la résolution.

Voilà le rapport.

@fte :

Je ne comprends toujours pas...

Le théorème de Shannon donne une fréquence d'échantillonnage permettant de reconstituer parfaitement un signal de fréquence maximale connue.

Dans le cas de la résolution d'un écran, quel est le signal ? Quelle est la fréquence maximale ?

Les 2 limites de perception de l'oeil sont l'acuité visuelle, et la dilatation de la pupille (diffraction et aberrations). Il n'y a pas besoin de fréquence de Nyquist pour calculer ces limites et en déduire la densité de pixels optimale d'un écran.

Pages