Intel serait encore bloqué en 14 nm pour Cannon Lake

De façon réaliste, on devrait voir des processeurs basés sur NetBurst atteindre les 8 à 10 Ghz dans les cinq prochaines années.

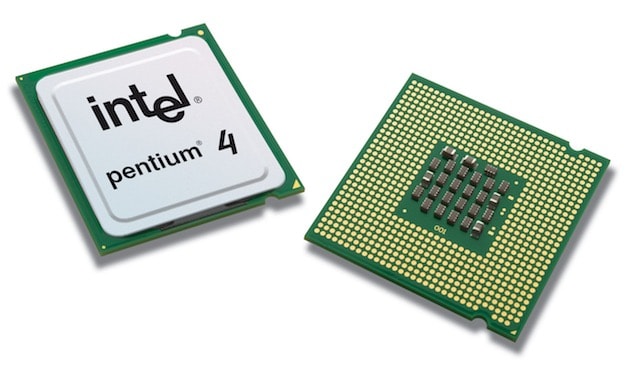

C’est ainsi que le site AnandTech présentait cette nouvelle architecture Intel à la fin de l’année 2000. À l’époque, la toute nouvelle architecture inaugurée par le fondeur pour ses Pentium 4 promettait beaucoup et les prévisions calquées sur les années d’évolutions du Pentium III faisaient rêver. Imaginez donc, un processeur à 10 Ghz qui nécessite moins d'un volt en 2005 !

Inutile de vous dire que l’histoire a largement donné tort à AnandTech et à Intel. Les énormes progrès suivis depuis les débuts de l’informatique ont rapidement rencontré un mur : la consommation électrique et la dissipation thermique des Pentium 4 a augmenté de façon exponentielle. Si bien que l’entreprise n’a pas tenu son objectif et a même été contrainte d’abandonner la nouvelle architecture pour les ordinateurs portables.

Dès 2003, trois ans seulement après les prédictions d’AnandTech, les Pentium M sortaient pour les ordinateurs portables. Beaucoup moins gourmands, ils étaient basés sur une architecture dérivée de P6, celle des Pentium III. En 2006, Intel présente une nouvelle architecture, nommée Core, qui est toujours dérivée de celle-ci, mais modernisée notamment pour gérer plusieurs cœurs. Depuis, de nombreuses générations se sont succédées et les changements sont toujours plus réduits.

Le fondeur n’arrive même plus à suivre son rythme Tick-Tock où une génération sur deux seulement avançait vraiment. Kaby Lake est la troisième génération d’affilée gravée à 14 nm et sans évolutions notables. On attendait mieux pour la prochaine, nommée Cannon Lake, mais la huitième génération des Core devrait encore rester à 14 nm au lieu des 10 promis à l’origine par Intel.

Au mieux, Intel devrait pouvoir passer certains modèles réservés aux ordinateurs mobiles à 10 nm, mais la gamme dans son ensemble devrait encore stagner sur le plan des performances. Le problème, c’est que le constructeur semble désormais incapable de tenir ses promesses, que ce soit en termes de fonctions ou bien de délai. Le passage à 10 et même à 7 nm était prévu il y a deux ans pour la fin de l’année 2016, mais il faudra sans doute attendre 2018 au mieux.

Le chemin parcouru depuis 2000 reste impressionnant sur certains points. Les meilleurs processeurs d’alors tournaient autour de 1 Ghz seulement et ils étaient gravés à 180 nm, près de treize fois plus épais qu’aujourd'hui. Malheureusement pour Intel (et pour nous), les progrès phénoménaux des années 1990 n’ont pas perduré et la difficulté pour obtenir des améliorations s’est révélée exponentielle…

Pendant ce temps, les processeurs ARM de nos smartphones progressent encore de façon significative tous les ans. Le processeur de l’Apple A10 qui équipe l’iPhone 7 est gravé en 16 nm et devrait passer à 10 nm dès cette année. Les deux cœurs tournent à plus de 2 Ghz et les performances de ce processeur s’approchent dangereusement des processeurs Intel de ces dernières années.

@Pousse :

En électronique, la consommation est symbolisée par le Voltage.

Il faut savoir que c'est loins d'être inhabituel puisque la puissance est directement liée à la tension d'alimentation.

Ainsi un LowPower processor aura une tension faible :

On donne P = U*I

Avec P la puissance, U la tension, et I le courant.

Donc si ton U est faible, ta puissance consommée diminuera aussi

@ruru75020

Oui, c'est bien çà, P=U*I. Mais pas P=U.

On comprend bien qu'à intensité égale, la puissance consommée est proportionnelle à la tension.

Proportionnelle, mais pas égale ni équivalente.

Ça reste une aberration d'exprimer une consommation en volts.

@Pousse

""Imaginez donc, un processeur à 10 Ghz qui ne consomme même pas un volt en 2005 !"

Euh, j'ai de l'imagination, mais une consommation en volts ... c'est comme une distance en litres, j'ai du mal à voir."

C'est très mal dis dans l'article. En fait ce volt est le seuil électrique codant l'information logique "1". Les premiers processeurs codaient les "0" par une tension de 0 volts, et les "1" par une tension de 5 volts. On l'a progressivement réduit pour consommer moins d'énergie, passant par 3,3 volts, 2,8 volts, 1,8 volts, 1,5 volts et 1,2 volts.

Comme le dis @ruru75020, la puissance consommée dépend de la tension de fonctionnement d'un processeur multiplié par l'intensité du courant. Avec une tension faible on diminue la puissance, donc la production de chaleur qui est l'ennemi naturel des processeurs.

A performance identique, un processeur 1,2 volts consomme moins d'énergie qu'un modèle antédiluvien à 5 volts, et chauffe beaucoup moins.

@IceWizard

Tu oublies un facteur fondamental, la consommation dépend aussi de la fréquence...

Ce n'est pas juste une question de tension.

@Stardustxxx

"Tu oublies un facteur fondamental, la consommation dépend aussi de la fréquence...

Ce n'est pas juste une question de tension."

Tiens c'est marrant je n'avais pas remarqué que je répondais à la question "Pourquoi est-ce que les processeurs chauffent ?". Et moi qui pensait réagir à "Euh, j'ai de l'imagination, mais une consommation en volts ... c'est comme une distance en litres, j'ai du mal à voir."

Si j'avais oublié la fréquence, je n'aurais pas écrit :

"A performance IDENTIQUE, un processeur 1,2 volts consomme moins d'énergie qu'un modèle antédiluvien à 5 volts, et chauffe beaucoup moins."

Ce qui coûte de l'énergie à chaque cycle du processeur c'est le changement d'état des portes logiques. La fréquence de fonctionnement n'a pas d'influence sur la consommation énergique d'UN cycle d'horloge, alors que la tension si. Un processeur consomme davantage d'énergie quand la fréquence augmente, parce qu'on accroit le nombre de cycles par seconde, mais la consommation énergétique d'UN cycle est toujours la même.

On a pu monter en fréquence parce que l'efficacité énergétique d'UN cycle s'est amélioré. Moins d'énergie dépensé pour changer d'état logique, c'est moins de chaleur générée, donc possibilité d'augmenter la fréquence de fonctionnement sans cramer les circuits.

@IceWizard

Tu assumes que la relation entre fréquence et consommation est linéaire, ce qui est une approximation.

Regarde la consommation vs horloge pour un i7 : https://forums.anandtech.com/threads/power-consumption-scaling-with-clockspeed-and-vcc-for-the-i7-2600k.2195927/

Ca a l'air super lineaire effectivement...

Donc oui c'est bien de simplifier pour expliquer, sauf que la réalité est bien plus complexe, la température de ton cpu affecte ses performances (le leakage depend de la temperature), la réalité est bien plus compliqué qu'une simple relation linéaire comme tu le dit.

Désolé d'avoir attendu lundi pour te répondre, WE chargé.

Oui, j'ai simplifié mes explications. Je sais bien que la vérité est toujours plus complexe que la théorie. J'en suffisamment bavé sur les bancs d'essai pendant mes études. Mais dans le cadre de ce forum, lu en grande partie par des non-spécialistes curieux je crois qu'il est important de présenter avant tout les grandes lignes.

La courbe de rapport consommation/fréquence que tu montres, pour un i7, est linéaire jusqu'à 3,5 GHz, avant de diverger. Au delà de 4 GHz, il faut fournir un sacré boost en énergie pour monter en fréquence.

J'ai regardé les caractéristiques des i7 d'Intel.

https://fr.wikipedia.org/wiki/Intel_Core_i7

Ils fonctionnent tous à des fréquences inférieurs à 3,5 Ghz, en restant dans la zone de linéarité. Seuls quelques modéles peuvent dépasser la limite, pour un temps très limité, en mode Turbo Boost.

Après effectivement, on peut effectivement augmenter la fréquence, sans tenir compte des limites fixés par le constructeur, mais là on se trouve dans des conditions hors-normes. C'est comme approcher le mur du son pour un avion à hélice. Sur le papier on devrait facilement dépasser ce mur, mais en pratique d'autres phénomènes se produisent et BANG .. avion kaput !

Pour dépasser efficacement les limites physiques des processeurs, il faut lutter contre l'emballement thermique en utilisant les astuces de l'over-clocking : énormes ventilateurs, refroidissement par écoulement d'eau, paraffine liquide et même azote liquide pour les mieux équipés. A ce stade ce n'est plus de la technologie, mais de l'art.

@IceWizard

C'est toujours un exercice délicat de vulgariser des technologies aussi poussée et complexes.

J'ajouterai, qu'il ne faut pas non plus généraliser, car autant il est facile de modéliser un composant individuel comme un transistor, il ne faut pas l'erreur de généraliser le résultat. Ce composant peut très bien avoir une réponse linéaire, mais le système complet non.

Ce qui est bizarre par contre, c'est que ça démarre lentement un iPhone par rapport à un Mac dès que celui-ci a un SSD.

@ Le docteur

Bonne remarque !

Quelqu'un peut nous expliquer ce phénomène ? Sachant que les systèmes sont les "mêmes" (iOS/macOS) ?

Je me doute que la mémoire flash d'un iPhone est certes moins rapide que les ssd PCI des Mac, mais tout de même. Par ailleurs, la quantité bien supérieure de RAM sur les Mac "ralentit" le démarrage...

Un expert dans la salle ?

Un Mac est fait pour etre redemmarer chaque jour, un iPhone est fait pour ne jamais redemarrer.

Petite demonstration: met un disque le plus lent possible dans un Mac (ceux qui le peuvent encore). Et la tu vas voir tout le travail de MacOS, l'illusioniste. En effet le demarrage est plus ou moins aussi lent que celui de l'iPhone, sauf que le Mac charge en premier l'image du bureau lors de l'extinction et te donnes le controle sur la souris, bien avant que la barre de menu soit capable de repondre au moindre clic, ou que les applications soient accessibles... Et le processus de demarage se poursuit alors que t'as l'impression que le Mac et au taquet...

C'est juste une illusion

En plus l'iPhone lui il doit en plus attendre que le resaux cellulaire reponde, ce qui peut prendre du temps en plus...

Pour l'histoire de la RAM, facile: le "BIOS" du Mac vérifie la présence et l’intégrité des composants au demarrage, donc plus tu as de RAM plus la vérification est longue...

Même en comptant le chargement de tout pour que ça fonctionne le Mac reste tout de même très rapide (avec un SSD, sinon c'est devenu catastrophique).

J'entends bien tout ce que tu dis, et je n'ai rien appris. J'utilise des Mac depuis bien longtemps et des iPhone aussi.

Merci pour ton explication, mais je ne suis pas certain que ce soit vraiment la bonne... Sans vouloir te vexer.

Si intel n'utilisait pas une pâte thermique dégeulasse sur ses dernières générations, yaurait beaucoup moins de mal à monter en fréquence...

Un i7-7700k OC à quasi ~5GHz qui perd 33°C en bench après un délid et un changement de pâte... Se foute de la gueule du monde chez intel.

@GoldenPomme

Ouille ! ?

Apparemment l'énervement nuit à l'orthographe ?

@GoldenPomme

Le mien tourne à 52x mono cœur, 50x 4 cœurs, sans dépasser 75º sur un tower Noctua. Pas si mal.

Après, je ne suis pas certain que la chose soit totalement stable. J'ai chargé et fait quelque benchs pour le fun, tout OK, mais je ne tourne pas ma machine à cette fréquence en utilisation normale. Je tourne à 46x, pas parce que c'est nécessaire mais parce que ça serait con d'avoir un K et de ne pas le pousser un tout petit peu. ;)

À noter qu'en plus Intel a du mal à les produire en quantité. En plus d'avoir du mal à les améliorer.

Est AMD ce débrouille comment? Il y as pa qu'Intel dans les processeurs x86

@cecemf

AMD est à la rue depuis une décennie. Aucun de leur processeurs actuels n'est compétitif par rapport à ce que propose Intel, ni en puissance ni en efficacité énergétique. AMD est présent dans les consoles, et dans le segment entrée de gamme, c'est à peu près tout. Matos cheap vendu quasi à perte.

Mais ça va peut-être changer très prochainement. Leur nouvelle architecture Zen est plutôt innovante, à peu près à niveau côté I/O. Et l'architecture GPU Vega qui se fait attendre mais est en approche néanmoins à l'air prometteur également.

Cependant avec l'historique d'AMD cette décennie, il est urgent d'attendre d'avoir les puces au banc test pour vérifier si elles tiennent la route ou si AMD est parti pour une nouvelle déculottée.

Franchement j'espère que Ryzen va envoyer du bois. Déjà parce qu'un peu de concurrence face à Intel ne pourra que faire du bien au secteur et aux clients, et parce que j'aimerais que leurs particularités d'architecture donne quelque chose plutôt qu'un fiasco de plus.

@fte

Merci pour l'explication ?

C'est la que je me dit qu'Apple devrait vraiment faire leur propre processeur car tout les délai de MacBook , iMac ... dont due aux problèmes des processeurs. Pas assez de différence entre génération, support de nouveau port en retard... si Apple peut faire ce qu'elle fait avec les Ax (ARM) sur les appareil iOS sur le Mac ça serait énorme !

@cecemf

"C'est la que je me dit qu'Apple devrait vraiment faire leur propre processeur car tout les délai de MacBook , iMac ... dont due aux problèmes des processeurs. Pas assez de différence entre génération, support de nouveau port en retard... si Apple peut faire ce qu'elle fait avec les Ax (ARM) sur les appareil iOS sur le Mac ça serait énorme !"

Ce qui m'a marqué avec l'évolution des Ax, c'est la montée en puissance du GPU. On pourrais imaginer un Mac "Hybride" avec un processeur Intel et un GPU ARM made-in-Apple, histoire de garder la compatibilité avec les applications Intel tout en disposant d'une puissance graphique accrue à un prix (de fabrication) faible.

Cela aurais du sens d'avoir une puce graphique Metal avec un OSX conçu pour Metal, comme Sierra. Sans parler que les GPU Ax sont économes en énergie, à la différence des GPU mobiles des autres constructeurs.

@IceWizard

Je n'avais jamais pensé au GPU Arm ; mais ton idée est loin d'être bête. Les CPU Arm ne sont pas encore au niveau pour remplacer ceux d'Intel ; par contre, comme processeurs graphiques, il y a certainement une idée à creuser, si ce n'est pas déjà en cours chez certains ?

Apple devrait acheter AMD ? est faire c'est propre processeur. Trop d'indépendance as Intel.

Pages