GPU et autonomie : les avancées de Skylake

Lors du keynote d'ouverture de l'Intel Developper Forum, il a été question de tout (« sensification » des ordinateurs, internet des objets, stockage), sauf de Skylake. Heureusement, les sessions qui ont suivi la conférence ont permis d'en savoir plus sur cette nouvelle génération de processeurs qui a récemment fait ses débuts.

Ars Technica a consacré plusieurs articles fouillés sur les nouveautés de Skylake. L'un d'entre eux est consacré au GPU, un composant aujourd'hui essentiel puisqu'on lui confie de plus en plus de tâches — Apple l'a illustré récemment en portant l'API graphique Metal sur Mac et en s'en servant comme d'un moyen pour accélérer l'ensemble du sytème.

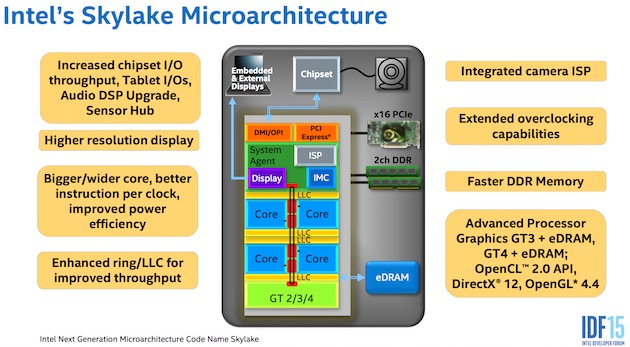

Intel a amélioré la modularité des GPU des puces Skylake. Schématiquement, si vous utilisez uniquement la partie du GPU dédiée à l'encodage/décodage matériel, le reste sera mis en veille afin de préserver l'autonomie.

L'unslice (la partie fixe qui gère la géométrie et d'autres fonctions fixes) peut aussi être cadencé indépendamment des slices (les parties qui contiennent les unités de calculs) afin d'optimiser la consommation et les performances en fonction de la tâche exécutée.

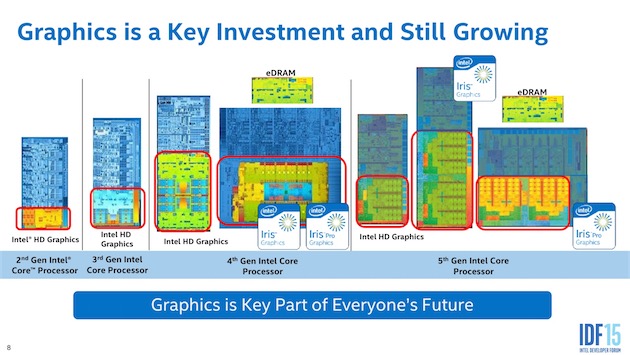

Skylake introduit par ailleurs une nouvelle configuration de GPU au nom de code « GT4 ». Il existait déjà le GT2 (Intel HD 5600) qui contient 24 unités d'exécution (EU), le GT3 avec 48 EU et le GT3e (Iris Pro) avec 48 EU et un module d'eDRAM. Le nouveau GT4 dispose, lui, de 72 EU et devient ainsi le nouveau GPU le plus puissant. Intel n'a pas annoncé de version « e » avec module d'eDRAM, mais ce n'est pas à exclure pour plus tard.

Est-ce que les prochains MacBook Pro 15" seront équipés d'un GPU GT4(e) ? Compte tenu de leur positionnement et de l'absence de GPU dédié sur le modèle de base, ce serait logique et souhaitable, mais Intel n'a toujours pas dévoilé quels seront les couples CPU + GPU — en dehors des deux premiers processeurs de bureau lancés, évidemment.

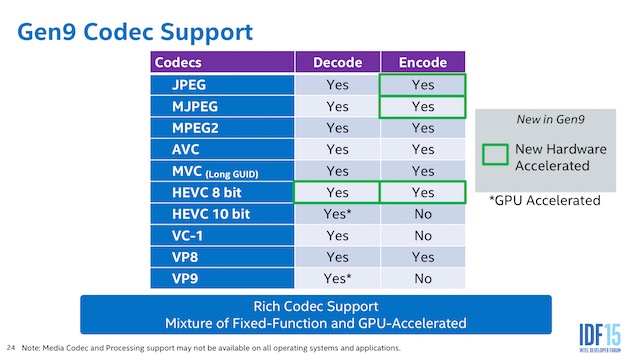

Qui dit nouvelle génération, dit généralement nouveaux protocoles pris en charge, et c'est le cas avec Skylake. Rappelons que les GPU Broadwell supportent la 4K à 60 Hz via le DisplayPort 1.2 et la 4K à 24 Hz via le HDMI 1.4, entre autres.

Les GPU Skylake peuvent gérer en plus la 4K à 60 Hz via le HDMI 2.0, mais à condition d'utiliser un adaptateur DisplayPort vers HDMI 2.0. Sur les machines qui sont équipées du contrôleur qui va bien, la norme HDMI 2.0 intégrée au Thunderbolt 3 est également supportée.

L'accélération matérielle, qui décharge le CPU de la tâche et améliore les performances, fonctionne plus largement. Les GPU Skylake peuvent encoder et décoder matériellement le H.265/HEVC 8-bit, et encoder matériellement les formats JPEG et MJPEG. Ars Technica précise que le décodage du H.265/HEVC est pris en charge par l'unslice, ce qui signifie que lire une vidéo dans cette norme va mettre à contribution seulement une partie du GPU, et ainsi ne pas grever l'autonomie.

Du côté des API, Skylake supporte DirectX 12, OpenGL 4.4 et OpenCL 2.0. Les prochaines versions d'OpenCL et OpenGL, ainsi que Vulkan, pourront être prises en charge à l'avenir.

Des perfectionnements ont été apportés à la gestion de la mémoire. Les nouveaux GPU peuvent notamment compresser les données avant de les envoyer à la RAM, permettant ainsi de laisser plus de bande passante pour le reste. Les joueurs seront sinon contents d'apprendre qu'Intel a amélioré les performances de l'antialiasing multisample (MSAA) et ajouté une option 16x. Encore faut-il que le GPU fasse tourner convenablement le jeu avec les réglages de base pour pouvoir prétendre activer cet antialiasing.

Dans un autre article, Ars Technica explique comment Intel procède pour améliorer l'autonomie avec les processeurs Skylake.

La fonction la plus importante est Speed Shift. Elle permet une meilleure répartition des rôles entre le processeur et le système d'exploitation qui gèrent tous deux la consommation. Le processeur peut choisir tout seul et quasi instantanément (1 milliseconde) un des paliers d'utilisation en fonction de l'activité — il va augmenter la fréquence si on commence une tâche ou la baisser si l'ordinateur passe en veille. Avant Skylake, cet ajustement devait être « demandé » au système et prenait environ 30 millisecondes.

Ne reste plus qu'à vérifier si toutes ces optimisations sont visibles à l'usage. Les premiers tests de Skylake étaient mi-figue mi-raisin, mais ils concernaient des processeurs de bureau équipés de GPU GT2. Les puces qui pourraient trouver leur place dans la plupart des Mac n'ont pas encore été annoncées, mais certains modèles ont déjà fuité. Une partie devrait sortir d'ici la fin de l'année.

- 960 GTX (voire 970 GTX) => milieux de gamme, plutôt (et elle s'en sort plutôt pas mal).

- 980 GTX, Ti, Titan X, etc.. : là, on est déjà dans le haut de gamme.

Enfin, déjà que les perfs des GPU intel intégrés ne sont pas top (inférieurs à ceux d'AMD de conception de 3 ou 4 ans), les drivers ne semblent pas optimisés, non plus.

Intérêt du GPU intégré ? En cas de panne de sa carte graphique, par exemple.

Quant à l'encode h.265 8 bits : ça semble assez limité en terme de qualité (par rapport au 10 bits)

@ Stardustxxx ET @C1rc3@0rc

Merci pour vos propositions d'explications !

ajout : Je commence à mieux comprendre l'enthousiasme autour de l'architecture ARM hors mobilité. "Fondue par un peu n'importe qui", disponible en masse et de plus en plus puissante elle a gagné le marché du mobile, trouve gentiment sa place dans les serveurs et peu s'attaquer au PC...Bref, Intel propose un Skylake bien foutu mais si Intel a un savoir faire plus que correct Intel a aussi un nouvel ennemi : l'architecture ARM.

En fait le principal enemi d'Intel c'est... Intel!

Par la il faut comprendre qu'Intel est schizo au dernier degre. D'un cote on a l'ingenierie avec des vrais genies et des chercheurs aussi competents que les ingenieurs qui doivent realiser.

De l'autre cote on a des dirigeants, qui sont sur les rails du x86 everywhere et de la conjecture de Moore et ne veulent pas voir d'alternative.

Pourtant Intel avait co-developpé (et commercialise toujours) un architecture concurrente au x86 et novatrice: l'Itanium base sur une architecture EPIC, successeur des architectures RISC.

Seulement, meme si l'Itanium a un potentiel d'evolution et offre des reponses la ou le x86 s'englue, la strategie monopolistique basee sur le x86 a ettoufé le developpement de l'Itanium. C'est a ce point ridicule que la generation suivante de XEON integrera plusieurs mecanismes de l'Itanium...

Pendant ce temps, le x86 est menacé par ARM sur le mobile, les petits serveurs, les systemes de telecom, l'embarqué, le PC... et sur les gros serveurs, stations de travail et calculateurs par le couple IBM/Nvidia avec le POWER 9 et Pascal et les processeurs OpenPower. Sans oublier qu'Intel etant reputé rouler pour la NSA et la CIA, nombre d'etats de plus en plus mefiants veulent se proteger d'Intel et developper leurs propre processeurs, ce qu'il peuvent faire avec ARM et IBM, mais pas avec Intel...

Donc mine de rien Intel est de plus en plus dans une situtation difficile, malgre la mane du au monopole Wintel (d'ailleurs meme Microsoft a tourne le dos a son partenaire historique...)

petit calcul doigt mouillé en prenant les bench geekbench. Un équivalent A8x 8 coeur cadencé à la même fréquence ca donnerait dans les 12000 en multicore bench (1800*8/1,2 de perte de perf lié au multicore) soit très proche des scores de l'imac retina.

En boostant la clock, ca pourrait effectivement donner quelque chose de sympa un iMac ARM based.

Apple peux effectivement proposer une solution graphique de meilleure qualité, compatible Metal, et avec des blocs d'accélération HW utiles:

- crypto

- video codec h264 et h265

Reste à voir la consommation d'une solution de ce type

Pages