MacBook Pro : surprises dans la bascule des cartes graphiques

On en découvre un peu plus sur le système de bascule entre les cartes graphiques apparu avec les MacBook Pro Core i5/7. De prime abord, impossible de savoir quelle carte travaille à l'instant T. On coche une case dans Préférences Système, et l'affaire est entendue. En coulisse, le système fait ses petites affaires avec la promesse de préserver l'autonomie. On sait simplement que le système se base sur les API utilisées par les applications (lire : Comment les MacBook Pro font la bascule graphique).

Lors du test du MacBook Pro Core i5, on disait toutefois espérer la sortie d'un utilitaire capable de dire qui fait quoi à quel moment (maj : depuis il est arrivé, lire gfxCardStatus gère mieux les "anciens" MacBook Pro).

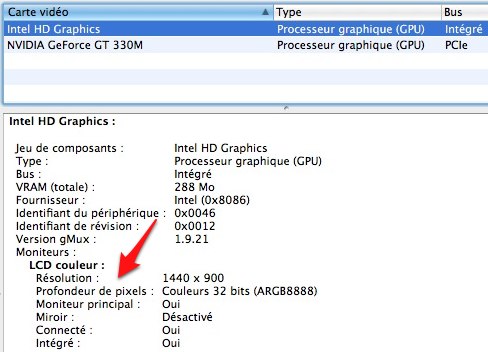

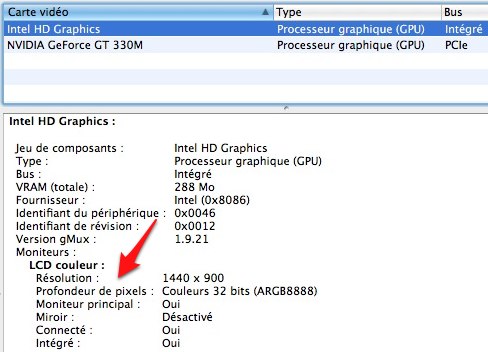

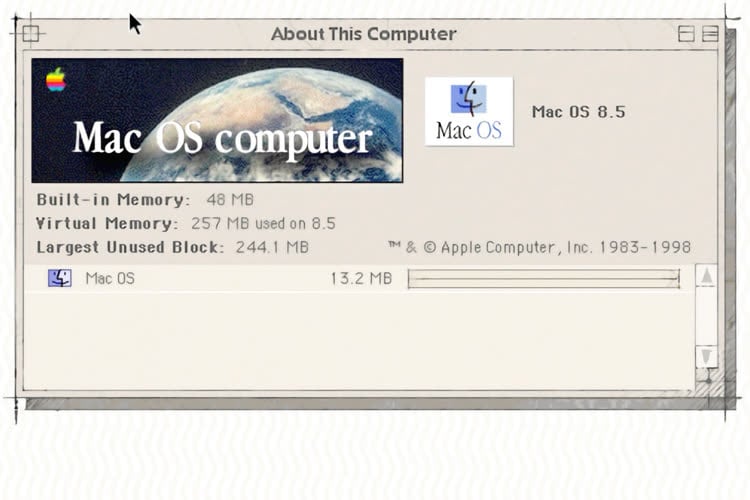

En fait, cet utilitaire existe, il s'agit tout simplement d’Informations Système… Un lecteur de MacRumors a remarqué que les infos relatives aux deux solutions graphiques changeaient lorsque l'une ou l'autre était en service. Ainsi, avec iMovie c'est la GeForce qui est désignée comme étant celle qui gère l'écran. Avec Calculette, c'est l'Intel HD qui lève la main. Il suffit d'un Cmd + R pour rafraîchir ces données.

La carte active

La carte non active

Du coup, nous avons refait quelques essais sur notre Core i5, avec à la clef des constats parfois surprenants.

Parmi les applications qui déclenchent l'utilisation de la GeForce on trouve iMovie, iPhoto, Pixelmator - jusque-là rien que de très normal - mais également Tweetie et Nambu… deux clients Twitter ! C'est à dire des applications qui n'ont d'autre fonction que d'échanger des bribes de textes en réseau (Twitterrifc, lui, s'en tient à l'Intel HD).

À l'inverse, parmi les applications qui se satisfont de la puce Intel, on trouve Lecteur DVD, Word 2008, Safari, Mail, Adium, iTunes, Firefox, Chrome… ou Lightroom. Le logiciel de traitement d'image d'Adobe se montre donc moins gourmand que le petit Tweetie.

Autre singularité, la lecture d'une même séquence YouTube va lancer la GeForce dans Chrome alors que Safari et Firefox se contenteront de l'Intel (que la séquence soit HD ou pas). Et il faudra quitter Chrome pour qu'il revienne sur l'Intel, le fait de fermer la page YouTube ne suffit pas.

Ailleurs, avec un film DivX ou un film HD (.mkv), VLC va utiliser la GeForce alors que pour ces fichiers QuickTime Player utilise l'Intel HD.

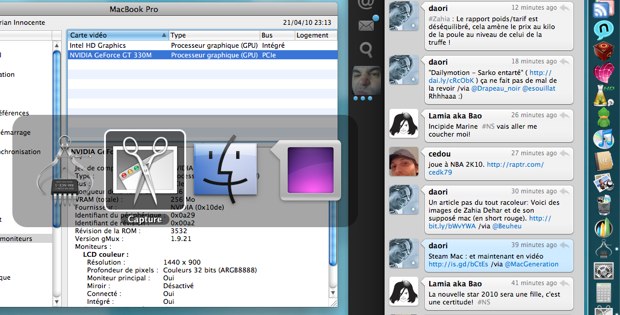

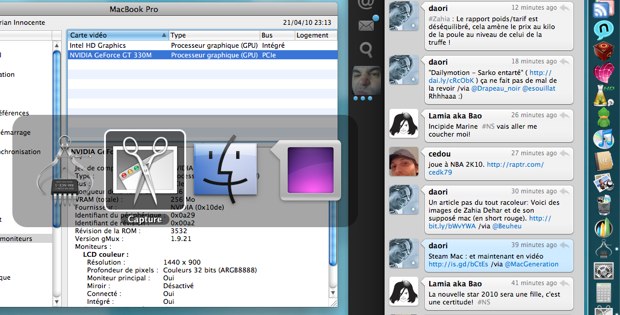

Mais le scénario le plus surprenant reste celui de ces clients Twitter. Exemple : vous regardez un DVD, c'est donc l'Intel HD qui travaille, mais s'il vous prend l'envie de laisser Nambu ou Tweetie en tâche de fond, ceux-ci forceront l'utilisation de la GeForce, rongeant votre autonomie. Même chose si vous ne faites que taper un texte dans Word (ou même dans TextEdit), pour peu que l'un de ces deux logiciels soit ouvert, l'Intel HD passera la main…

Tweetie est ouvert, la GeForce est en action

Dès lors, le système d'Apple peut être assez facilement pris en défaut. Une application (relativement) sommaire, sera néanmoins considérée comme exigeante sur la foi de certaines API utilisées. Est-ce qu'Apple doit optimiser son mécanisme, ou est-ce aux développeurs de reconsidérer certaines instructions dans leurs logiciels ? Aux deux ? La question est posée. L'utilisateur, lui, devant s'en tenir à un poste d'observation.

Conclusion (temporaire), le système d'Apple est élégant par sa simplicité, mais en cuisine, les choses sont nettement plus corsées…

Lors du test du MacBook Pro Core i5, on disait toutefois espérer la sortie d'un utilitaire capable de dire qui fait quoi à quel moment (maj : depuis il est arrivé, lire gfxCardStatus gère mieux les "anciens" MacBook Pro).

En fait, cet utilitaire existe, il s'agit tout simplement d’Informations Système… Un lecteur de MacRumors a remarqué que les infos relatives aux deux solutions graphiques changeaient lorsque l'une ou l'autre était en service. Ainsi, avec iMovie c'est la GeForce qui est désignée comme étant celle qui gère l'écran. Avec Calculette, c'est l'Intel HD qui lève la main. Il suffit d'un Cmd + R pour rafraîchir ces données.

La carte active

La carte non active

Du coup, nous avons refait quelques essais sur notre Core i5, avec à la clef des constats parfois surprenants.

Parmi les applications qui déclenchent l'utilisation de la GeForce on trouve iMovie, iPhoto, Pixelmator - jusque-là rien que de très normal - mais également Tweetie et Nambu… deux clients Twitter ! C'est à dire des applications qui n'ont d'autre fonction que d'échanger des bribes de textes en réseau (Twitterrifc, lui, s'en tient à l'Intel HD).

À l'inverse, parmi les applications qui se satisfont de la puce Intel, on trouve Lecteur DVD, Word 2008, Safari, Mail, Adium, iTunes, Firefox, Chrome… ou Lightroom. Le logiciel de traitement d'image d'Adobe se montre donc moins gourmand que le petit Tweetie.

Autre singularité, la lecture d'une même séquence YouTube va lancer la GeForce dans Chrome alors que Safari et Firefox se contenteront de l'Intel (que la séquence soit HD ou pas). Et il faudra quitter Chrome pour qu'il revienne sur l'Intel, le fait de fermer la page YouTube ne suffit pas.

Ailleurs, avec un film DivX ou un film HD (.mkv), VLC va utiliser la GeForce alors que pour ces fichiers QuickTime Player utilise l'Intel HD.

Mais le scénario le plus surprenant reste celui de ces clients Twitter. Exemple : vous regardez un DVD, c'est donc l'Intel HD qui travaille, mais s'il vous prend l'envie de laisser Nambu ou Tweetie en tâche de fond, ceux-ci forceront l'utilisation de la GeForce, rongeant votre autonomie. Même chose si vous ne faites que taper un texte dans Word (ou même dans TextEdit), pour peu que l'un de ces deux logiciels soit ouvert, l'Intel HD passera la main…

Tweetie est ouvert, la GeForce est en action

Dès lors, le système d'Apple peut être assez facilement pris en défaut. Une application (relativement) sommaire, sera néanmoins considérée comme exigeante sur la foi de certaines API utilisées. Est-ce qu'Apple doit optimiser son mécanisme, ou est-ce aux développeurs de reconsidérer certaines instructions dans leurs logiciels ? Aux deux ? La question est posée. L'utilisateur, lui, devant s'en tenir à un poste d'observation.

Conclusion (temporaire), le système d'Apple est élégant par sa simplicité, mais en cuisine, les choses sont nettement plus corsées…

Pages