Les Mac M1 voient les eGPU mais sans rien en faire

Les Mac M1 ont bien des qualités, mais la nouvelle architecture d'Apple, aussi puissante et efficace qu'elle soit, cache un ou deux revers de la médaille. Les utilisateurs les plus exigeants devront attendre avant de mettre la main sur les premiers Mac intégrant plus de 16 Go de RAM et davantage que deux ports Thunderbolt/USB4. Autre écueil : le support inexistant des cartes graphiques externes.

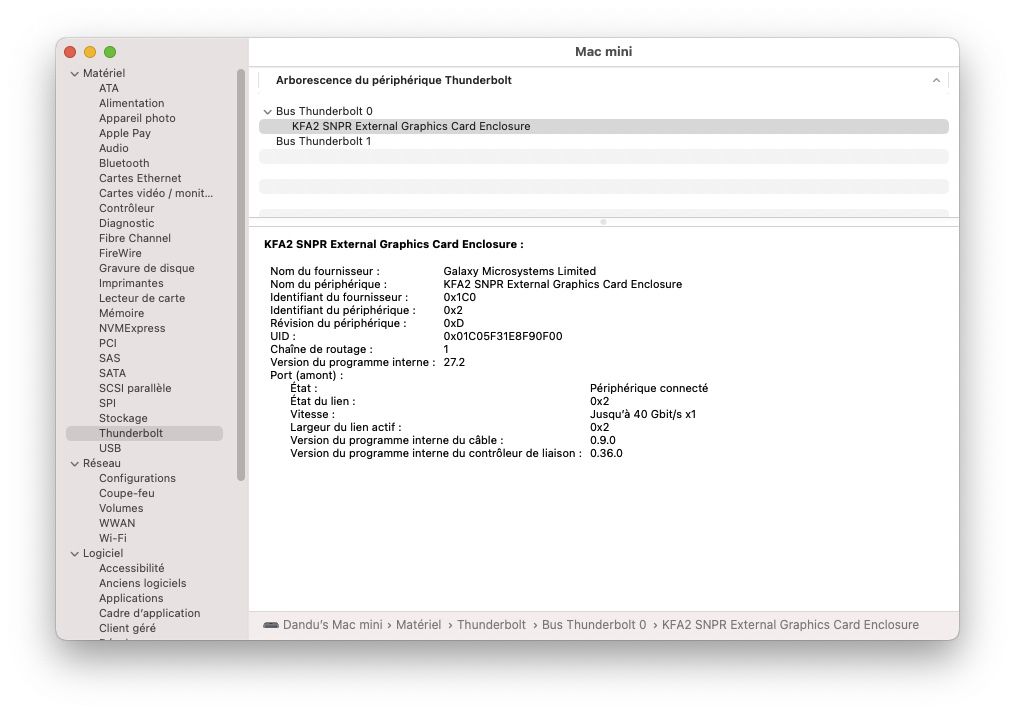

Le GPU intégré au M1 est certes très performant, mais les eGPU sont nécessaires pour certains traitements graphiques lourds, pour jouer à de gros jeux, ou pour y brancher des écrans. Il y a un peu d'espoir : Big Sur « voit » un boîtier externe GPU, comme l'a constaté Mac4Ever après avoir branché un Pro Display XDR sur l'eGPU lui même connecté à un Mac mini M1.

L'écran s'affiche sans problème, mais l'accélération graphique qu'est censée apporter la Radeon RX580 est aux fraises pour une excellente raison : les pilotes sont aux abonnés absents. Pierre Dandumont explique que les indispensables drivers AMD et Nvidia ne sont pas compilés pour ARM. Ça va au-delà des fichiers qu'il fallait bidouiller sur les précédentes versions de macOS, et cela peut prendre un certain temps…

@reborn

Non, je pense qu’ils ont réellement été surpris de l’autonomie que permettait le M1 et que les ingénieurs se sont "trompés".

We overshot,” says Federighi. “You have these projects where, sometimes you have a goal and you're like, ‘well, we got close, that was fine’.

This one, part of what has us all just bouncing off the walls here – just smiling – is that as we brought the pieces together, we're like, ‘this is working better than we even thought it would’.

We started getting back our battery life numbers, and we're like, ‘You're kidding. I thought we had people that knew how to estimate these things’.”

@redchou

Non, je pense qu’ils ont réellement été surpris de l’autonomie que permettait le M1 et que les ingénieurs se sont "trompés".

Ils ne se sont pas "trompés", ils ont optimisé le soft et le SoC plus que prévu. Et ça c’était pendant le développement des Macs en M1.

Et visiblement personne ne s’attendaient à ça. Ils ont tous été très surpris par le résultat de leur travail, que ce soit les équipes du soft, hard, et marketing.

Se tromper c’est quand tu commercialise la machine et que les caractéristiques réelles ne correspondent pas avec ce qu’annonce le constructeur.

Tu met sur le même plan une affirmation donné publiquement par le VP tool and frameworks évoquant les capacités du GPU intégré, avec des constats meilleurs que prévu sur le plan de l’autonomie fait en interne pendant le developpement d’une machine. Donc à un moment où rien n’est encore définitif.

On retrouve aussi cette affirmation dans la doc d’Apple:

-Don’t assume a discrete GPU means better performance. The integrated GPU in Apple processors is optimized for high performance graphics tasks. See Porting Your Metal Code to Apple Silicon. 👇

https://developer.apple.com/documentation/xcode/porting_your_macos_apps_...">dans la doc d’Apple

@reborn

Ils ne se sont pas "trompés", ils ont optimisé le soft et le SoC plus que prévu. Et ça c’était pendant le développement des Macs en M1.

- Arrêtez de jouer sur les mots, l’équipe qui avait prévu l’autonomie s’est planté sur ses prévisions (point).

Et visiblement personne ne s’attendaient à ça. Ils ont tous été très surpris par le résultat de leur travail, que ce soit les équipes du soft, hard, et marketing.

- Surtout l’équipe marketing.

Se tromper c’est quand tu commercialise la machine et que les caractéristiques réelles ne correspondent pas avec ce qu’annonce le constructeur.

- Non, ça c’est mentir. 🤦♂️

Tu met sur le même plan une affirmation donné publiquement par le VP tool and frameworks évoquant les capacités du GPU intégré, avec des constats meilleurs que prévu sur le plan de l’autonomie fait en interne pendant le developpement d’une machine. Donc à un moment où rien n’est encore définitif.

- Non, je dis juste que les discours ne sont pas des vérités universelles et que l’avis, même du mec qui bosse sur les GPU d’Apple peut être erroné, comme celui de l’équipe qui devait prévoir l’autonomie, que ce soit en interne ou en externe...

Les mecs qui bossent chez Apple sont comme vous et moi, ils ont parfois raison, mais ils se trompent aussi, voir le discours du mecs qui a fait libdispatch récemment... bref, il y a plein d’exemple dans l’histoire qui le montre, chez Apple ou ailleurs.

On retrouve aussi cette affirmation dans la doc d’Apple:

« Don’t assume a discrete GPU means better performance. The integrated GPU in Apple processors is optimized for high performance graphics tasks. See Porting Your Metal Code to Apple Silicon. 👇 »

- Ce n’est pas la bible, la doc d’Apple évolue, ça ne veut en rien dire qu’un eGPU ne serait d’aucune utilité ou bien même une puce GPU dédié, puce qui n’est pas impossible dans les futurs Mac Apple Silicon. La puce M1 fait plein de chose mais ne remplace pas un GPU de +20 tflops.

@redchou

ça ne veut en rien dire qu’un eGPU ne serait d’aucune utilité

Personne n’a tiré cette conclusion.

Evidement que dans le Mac Pro un GPU intégré ne suffira pas. D’où les cartes accélératrices Afterburner. Peut-etre un GPU dédié Apple ou AMD

@reborn

ça ne veut en rien dire qu’un eGPU ne serait d’aucune utilité

Personne n’a tiré cette conclusion.

- Il faut lire l’article et le commentaire d’origine, du coup maintenant...

Evidement que dans le Mac Pro un GPU intégré ne suffira pas. D’où les cartes accélératrices Afterburner. Peut-etre un GPU dédié Apple ou AMD

- Ca, on ne le sais pas, avec les puces SIP comme le M1, il est possible de mettre un gros GPU directement dans le SoC.

@redchou

Il faut lire l’article et le commentaire d’origine, du coup maintenant...

Fait donc de même.

Ca, on ne le sais pas, avec les puces SIP comme le M1, il est possible de mettre un gros GPU directement dans le SoC.

Bien sur, 1 GPU ne couvriraient pas tous les usages d’une machine comme le Mac pro. D’où les cartes d’extensions

@reborn

"Ca, on ne le sais pas, avec les puces SIP comme le M1, il est possible de mettre un gros GPU directement dans le SoC."

Très délicat, le M1 c’est déjà un die de 16B de transistors.

Les implementation plus haut de gamme risque d’avoir plus de corps CPU et il,semble très improbable d’ajouter aussi plus de logique câblée pour le GPU.

M’est avis que le GPU migrera sur un second die qui sera peut-être intégré sur le même package (comme l’est la RAM sur le M1)

Cette séparation en deux die libérera l’allocation de transistor utilisées dans le M1 pour le GPU au profits d’une multiplication des cœurs CPU (Le GPU prend sur le M1 environ 1/4 du die) et la capacité de faire un GPU bien plus performant exploitant bien plus de transistors.

Après Apple peut aussi aller vers un die de plus grande surface plus cher à produire.

En tout cas je crois de plus en plus qu’Apple n’aura plus recours à des fournisseurs tiers de GPU et se focalisera sur son architecture propriétaire dédiée à Metal.

@YetOneOtherGit

"Ca, on ne le sais pas, avec les puces SIP comme le M1, il est possible de mettre un gros GPU directement dans le SoC."

Très délicat, le M1 c’est déjà un die de 16B de transistors.

- C’était mal formulé, si on lit mes commentaires, je ne dis évidemment pas qúil vont mettre tout dans un SoC mais un SiP, après, Nividia dépasse déjà les 50B de transistor et en 7nm... Mais bon...

Les implementation plus haut de gamme risque d’avoir plus de corps CPU et il,semble très improbable d’ajouter aussi plus de logique câblée pour le GPU.

- Ce n’est pas impossible, surtout qu’il sera aussi possible de faire un tri plus large des puces 100% fonctionnelle ou non...

M’est avis que le GPU migrera sur un second die qui sera peut-être intégré sur le même package (comme l’est la RAM sur le M1)

- C’est ce que je dis depuis un moment...

Ça sera du coup bien un GPU dédié, même si intégré au sein du SiP...

Cette séparation en deux die libérera l’allocation de transistor utilisées dans le M1 pour le GPU au profits d’une multiplication des cœurs CPU (Le GPU prend sur le M1 environ 1/4 du die) et la capacité de faire un GPU bien plus performant exploitant bien plus de transistors.

Après Apple peut aussi aller vers un die de plus grande surface plus cher à produire.

- Oui, surtout sur des machines du type Mac Pro, mais je pense que la prochaine grosse évolution ce sera les I/O, a l’intérieur du SiP et vers l’extérieur. La actuellement, 16Go, un seul contrôleur Thunderbolt, il faudra augmenter tout ça sur une machine du type MP avec tous les ports TB, etc...

En tout cas je crois de plus en plus qu’Apple n’aura plus recours à des fournisseurs tiers de GPU et se focalisera sur son architecture propriétaire dédiée à Metal.

- Il aurait adapté les drivers dans le cas contraire, la, le fait qu’il ne prennent même pas la peine de les adapter, et un très mauvais signal pour une compatibilité avec des eGPU ou ou des CG tiers...

Après, on sait jamais, peut-être qu’ils ont pris du retard et que ça viendra, mais j’ai de gros doutes aussi.

@redchou

"La actuellement, 16Go"

Sur le 16Go c’est juste une contrainte toute bête: les chip placés sur le package sont limités à 8Go, Micron commence à distribuer des échantillons de chips 16Go.

Des M1 avec 32Go en option pourraient apparaître à moyen terme;-)

@YetOneOtherGit

Sur le 16Go c’est juste une contrainte toute bête: les chip placés sur le package sont limités à 8Go, Micron commence à distribuer des échantillons de chips 16Go.

Des M1 avec 32Go en option pourraient apparaître à moyen terme;-)

- Je sais pas si Apple proposera le même processeur avec plus de mémoire, il utilise déjà rarement les 16Go... Je pense plus à une variante qu’à un M1 avec juste plus de Ram...

@redchou

"Je sais pas si Apple proposera le même processeur avec plus de mémoire, il utilise déjà rarement les 16Go... Je pense plus à une variante qu’à un M1 avec juste plus de Ram..."

Commercialement l’absence d’une option 32Go sur les machines présentées ne doit pas peser grand chose effectivement, après elle deviendra possible dans un temps raisonnable, nous verrons bien si Apple la propose.

@redchou

"- Il aurait adapté les drivers dans le cas contraire, la, le fait qu’il ne prennent même pas la peine de les adapter, et un très mauvais signal pour une compatibilité avec des eGPU ou ou des CG tiers..."

Je suis un peu moins certain que toi, le portage des drivers juste pour le eGPU est largement dispensable.

Si jamais la collaboration avec AMD continuait cela arrivera avec des machines ARM intégrant des GPU AMD.

Après j’ai de gros doutes sur la pérennité de cette démarche et suis comme toi sur une vision du tout Apple sur toute la gamme 😉

@redchou

"Nividia dépasse déjà les 50B de transistor et en 7nm..."

Oui ils sont sur ce type de chiffres, mais je vois mal Apple allez vers cela pour des processeurs qui devront animer : iMac, Mac Pro haut de gamme et un éventuel Mac Mini Pro.

Reste le Mac Pro, cela vaudrait-il la peine de se lancer dans un processeur spécifique onéreux sur une niche de marché?

Une association intelligente d’éléments pensée pour le milieu de gamme ne serait-elle pas préférable?

En tout cas : intéressant et excitant de questionner le futur 😋

@YetOneOtherGit

Oui ils sont sur ce type de chiffres, mais je vois mal Apple allez vers cela pour des processeurs qui devront animer : iMac, Mac Pro haut de gamme et un éventuel Mac Mini Pro.

- Ce n’est pas utile à mon avis non plus quand ils peuvent les mettre côte à côte avec une connexion à la "infinity fabric" d’AMD...

Reste le Mac Pro, cela vaudrait-il la peine de se lancer dans un processeur spécifique onéreux sur une niche de marché?

- Je me dis que les possibilités de binning seront plus nombreuses...

Une association intelligente d’éléments pensée pour le milieu de gamme ne serait-elle pas préférable?

En tout cas : intéressant et excitant de questionner le futur 😋

- Oui, hâte de voir ce que ça donnera sur ses systèmes type Mac Pro maintenant qu’on voit ce que ça donne sur des configurations "basiques"...

@redchou

"Oui, hâte de voir ce que ça donnera sur ses systèmes type Mac Pro maintenant qu’on voit ce que ça donne sur des configurations "basiques"..."

m’est avis que ce sera la dernière machine à basculer.

La prochaine itération qui devrait concerner iMac et Mac Book Pro haut de gamme voir un éventuel Mac Mini Pro est déjà pas mal excitante 😋

@YetOneOtherGit,

« Très délicat, le M1 c’est déjà un die de 16B de transistors.

Les implementation plus haut de gamme risque d’avoir plus de corps CPU et il,semble très improbable d’ajouter aussi plus de logique câblée pour le GPU.

M’est avis que le GPU migrera sur un second die qui sera peut-être intégré sur le même package (comme l’est la RAM sur le M1)

Cette séparation en deux die libérera l’allocation de transistor utilisées dans le M1 pour le GPU au profits d’une multiplication des cœurs CPU (Le GPU prend sur le M1 environ 1/4 du die) et la capacité de faire un GPU bien plus performant exploitant bien plus de transistors.

Après Apple peut aussi aller vers un die de plus grande surface plus cher à produire. »

Effectivement, 16 milliards de transistors, cela prend de la place !

Les Apple Silicon Pro auront certainement plus de cœurs pour le CPU mais aussi l'IA, et cela prendra aussi de la place.

Comme vous le précisez, soit Apple utilisera un support plus grand mais plus couteux, soit il utilisera deux supports.

Mais dans ce cas, Apple se priverait de sa mémoire unifiée et de ses bus ultra rapides qui interconnectent le tout.

Pour ma part, je pencherais plus pour une solution sur un support plus grand, quitte à faire d'autres compromis...

😎

@Scooby-Doo

"Les Apple Silicon Pro auront certainement plus de cœurs pour le CPU mais aussi l'IA, et cela prendra aussi de la place.

Comme vous le précisez, soit Apple utilisera un support plus grand mais plus couteux, soit il utilisera deux supports.

Mais dans ce cas, Apple se priverait de sa mémoire unifiée et de ses bus ultra rapides qui interconnectent le tout.

Pour ma part, je pencherais plus pour une solution sur un support plus grand, quitte à faire d'autres compromis..."

Attention ne confond pas die et package.

Deux die et plusieurs CI mémoire sur le même package sont parfaitement envisageable.

C’est une des options envisageable.

Pour les die de très grande surface j’y crois relativement peu.

Wait & See 👀

@YetOneOtherGit,

« Attention ne confond pas die et package. Deux die et plusieurs CI mémoire sur le même package sont parfaitement envisageable. C’est une des options envisageable. Pour les die de très grande surface j’y crois relativement peu. »

Je ne confonds pas die et package merci.

😘

@reborn

Il faut lire l’article et le commentaire d’origine, du coup maintenant...

Fait donc de même.

- Un article sur l’incompatibilité des eGPU et un commentaire sur le fait qu’un GPU dédié ne serait pas plus rapide... 🤷♂️

@redchou

et un commentaire sur le fait qu’un GPU dédié ne serait pas plus rapide...

Ce qui est vrai, dans certains cas.

reborn

https://media4.giphy.com/media/q5ZGrl0J65ivu/giphy.gif?cid=4d1e4f29sswp7...

@fousfous

Les 2 graphiques que j’ai tweeté provenant d’une vidéo de MaxTech sont fort intéressants.

https://twitter.com/marcosickx/status/1331726550455169030?s=21

Mais je conseille à tous d’aller voir la vidéo dans son entièreté. Ça vaut la peine.

@fousfous,

« Comme l'a dit Apple: "Ne pensez pas qu'un GPU dédié soit plus rapide". »

Désolé de vous paraphraser et de vous reprendre concernant vos citations mais ce ne serait pas plutôt ceci :

« Comme l'a dit Apple: "Ne pensez pas, nous pensons pour vous, merci de nous croire !" »

Je plaisante mais je pense que nous ne sommes pas si loin de la vérité !

😁

Je vous conseille de suivre le blog de Pierre Dandumont, une mine d’or pour tous les geek de technologie actuelle et ancienne !

https://www.journaldulapin.com/

Un grand merci à Intel d’avoir refuser de fournir processeurs pour le 1er iPhone.. 🙏

@reborn

Ou encore plus loin, merci le Newton.

@maxou56

« Ou encore plus loin, merci le Newton. »

Et encore plus loin, merci la BBC anglaise et ses ordinateurs Acorn pour initier le grand-public à l’informatique, à l’origine de la technologie des processeurs ARM.

@IceWizard,

« Et encore plus loin, merci la BBC anglaise et ses ordinateurs Acorn pour initier le grand-public à l’informatique, à l’origine de la technologie des processeurs ARM. »

Dans mes grosses pattes, cher animal de bonne compagnie qui avait encore quelques neurones en service.

Ronger des OS améliore la mémoire parait-il !

https://fr.wikipedia.org/wiki/BBC_Micro

😘❤

@reborn

Tu m’étonnes ! Y aurait eu un ventilo sur le premier iPhone 🤣

Le site barefeats.com donne les résultats d’une comparaison de performances entre un MacBook pro M1 et un MacBook pro 13 Intel mid2020, avec egpu équipé d’une carte AMD 5700 xt ; le M1 s’en sort plutôt bien, mais il y a quand même une belle différence avec les jeux: Shadow of the Tomb raider, 40 fps avec le M1, 57 fps avec le egpu associé au MacBook pro Intel, résolution 1280 par 800. 18 fps pour le macbookpro intel, sans egpu, loin derrière le M1.

Eh ben c’était bien la peine d’handicaper les Mac mini 2018 pour vendre du eGPU. Pas très écolo tout ça.

Si Apple ne s’appuie pas sur des GPU tiers pour les futures offres en ARM, les GPU Amd seront au niveau de support de celles de NVidia : Néant.

@YetOneOtherGit

Complètement d'accord... pourquoi Amd engagerait des frais de développement de drivers ARM si ça ne sert qu'à quelques unités de cartes graphiques vendues en eGPU sur les Mac AppleSilicon. Ça n'a aucun sens économiquement parlant.

Est ce nécessaire un EGPU sur les M1 ? Et pour quelle utilité ? Vu le prix...et l’encombrement !

Mais suivant les nouvelles version Mac Pro M1 on aura sûrement la raison du « le M1 n’a pas besoin de EGPU ».

@wilfried50

"Est ce nécessaire un EGPU sur les M1 ?"

Les performances GPU du M1 sont très intéressantes, au regard de celle des machines Intel remplacées.

Mais il,faut attendre la suite pour voir ce qu’Apple proposera en terme de performance sur son haut de gamme.

Pour le moment nous n’avons pas tous les paramètres de l’équation:

- GPU tiers ou propriétaire?

- Niveau de performance par rapport aux GPU tiers ?

Il n’est pas exclu que le palliatif du eGPU n’est tout simplement plus de raison d’être dans une gamme renouvelée sous SOC ARM.

Wait&See 👀

@wilfried50

On peut même fantasmer une offre eGPU portée par Apple basée sur ses GPU propriétaires 🤩

Techniquement se serait possible sans doute, même si commercialement j’ai de gros doutes sur la pertinence de l’offre.

@YetOneOtherGit,

« On peut même fantasmer une offre eGPU portée par Apple basée sur ses GPU propriétaires »

Non Apple ne fera jamais cela !

Elle souhaite que l'utilisateur final achète de suite la configuration la mieux équipée et pas lui offrir l'opportunité d'étendre les performances par la suite.

C'est contreproductif pour Apple. L'important c'est que le matériel vendu soit le plus profitable.

Et quand on connait comment sont facturées les options, la mémoire par exemple, il ne faut pas se faire d'illusion pour du matériel à destination des pros.

Apple ne produira pas de solution maison externe pour améliorer un matériel déjà vendu.

Apple vous proposera une nouvelle station de travail qui correspondra à vos besoins du moment.

Sinon, on aurait la possibilité aussi de placer une SD-Card dans son iPhone pour augmenter la mémoire de stockage de masse...

Vous voyez où je veux en venir ?

👌

@Scooby-Doo

"Non Apple ne fera jamais cela !"

C’est pourquoi je parlais de fantasmes.

Après il y a une petite fenêtre de tire pour une façon simple et efficace de décupler la puissance GPU des Laptop en usages fixe mais elle est tellement petite que j’y crois fort peu.

Ceci dit Apple est parfois capable de faire des choses atypiques si cela donne à ses offres une image intéressante.

Le champ des possibles ouvert par la transition autorise quelques fantasmes improbables.

@YetOneOtherGit,

« C’est pourquoi je parlais de fantasmes. Après il y a une petite fenêtre de tire pour une façon simple et efficace de décupler la puissance GPU des Laptop en usages fixe mais elle est tellement petite que j’y crois fort peu. Ceci dit Apple est parfois capable de faire des choses atypiques si cela donne à ses offres une image intéressante. Le champ des possibles ouvert par la transition autorise quelques fantasmes improbables. »

Rêver n'est pas interdit, effectivement !

C'est même une douceur de l'esprit salutaire en ces temps tristes...

😇

@Scooby-Doo

"Elle souhaite que l'utilisateur final achète de suite la configuration la mieux équipée et pas lui offrir l'opportunité d'étendre les performances par la suite."

Attention, ce que pourrait offrir un eGPU Apple basé sur sa propre architecture n’aurait de sens que s’il offrait des performances supérieures au plus puissant des Laptop.

Ce la n’a de sens que si cela permet d’aller plus loin que ce que l’on peut configurer dans sa machine.

Cela pourrait même prendre sens pour augmenter le potentiel GPU d’un Mac Pro n’ayant plus de bus interne, d’un iMac ou d’un Mac Mini.

C’est un fantasme et il n’aurait de sens que s’il offre une puissance très conséquente.

Ce qui a toujours été la raison d’être du eGPU

@Scooby-Doo

"C'est contreproductif pour Apple. L'important c'est que le matériel vendu soit le plus profitable.

"

Une option externe peut être profitable si elle permet de dépasser les limites de ce que l’on peut avoir en interne et si le marché est suffisamment conséquent.

Il ne s’agit nullement de cannibaliser les offres de segmentation de la gamme.

@Scooby-Doo

"Apple ne produira pas de solution maison externe pour améliorer un matériel déjà vendu.

Apple vous proposera une nouvelle station de travail qui correspondra à vos besoins du moment.

Sinon, on aurait la possibilité aussi de placer une SD-Card dans son iPhone pour augmenter la mémoire de stockage de masse...

Vous voyez où je veux en venir ?

"

Yep mais je trouve que tu vas un peu vite en besogne en oubliant que la vocation des eGPU a toujours été de dépasser les limites de ce qui peut être proposé en interne pour les usages les plus voraces en ressources 😉

@àYetOneOtherGit,

« Yep mais je trouve que tu vas un peu vite en besogne en oubliant que la vocation des eGPU a toujours été de dépasser les limites de ce qui peut être proposé en interne pour les usages les plus voraces en ressources »

Sauf que Apple a tout intérêt à vous vendre la configuration la plus musclée, et donc la plus chère, et donc la plus profitable, TOUT DE SUITE, pas dans 1 ANS !!!

Une solution eGPU Apple, j'y crois pas du tout, mais bon l'avenir peut nous réserver des surprises...

😉

@Scooby-Doo

"Une solution eGPU Apple, j'y crois pas du tout, mais bon l'avenir peut nous réserver des surprises..."

C’est parfaitement recevable et je partage largement ton doute

Par contre cet argument :

« Sauf que Apple a tout intérêt à vous vendre la configuration la plus musclée, et donc la plus chère, et donc la plus profitable, TOUT DE SUITE, pas dans 1 ANS !!!»

N’est pour moi pas bien articulé.

Les eGPU ont vocation à offrir plus que ce que peut offrir en internet la plus grosse configuration disponible.

Ce n’est pas « à la place de» mais en «complément de» cela ne cannibalise rien 😎

C’est une potentielle source de business en plus (reste à connaître la taille de la cible)

@YetOneOtherGit,

Dans un Mac Pro à venir, il y aura toute la place pour monter des extensions Apple et augmenter à souhait la puissance embarquée.

Dans un iMac Pro ou un Mac Book Pro, la solution eGPU Apple est recevable et même souhaitable.

Faut-il encore que Apple ait le temps et les ressources humaines pour développer cela en interne.

Je me demande si toutes les évolutions et gros changements pris récemment par Apple ne la monopolise pas totalement !

😁

Alors développer une eGPU Apple juste pour le fun et un marché de niche, j'ai beaucoup de mal à y croire.

Mais bon l'avenir nous le dira...

😉

@Scooby-Doo

"Dans un Mac Pro à venir, il y aura toute la place pour monter des extensions Apple et augmenter à souhait la puissance embarquée."

Pas forcément personne ne sait quel seront les choix d’Apple, ils reviendront peut-être à la vision du MacPro 2013 qui était en avance sur son temps.

Ce qui est assez excitant avec cette transition c’est que le champ des possibles est largement ouvert, même pour la deuxième génération des machines qui viennent d’être présentées.

Les cartes gpu dédiées sont peut être du passé pour Apple ?

Je pense qu’ils vont pousser leur concepteur de tout intégré dans le même chip au maximum.

A mon avis les futures chip oriente pro d’Apple, se rapprocheront des perfs des meilleurs cartes gpu.

En même temps, si on regarde les perf des cartes actuelles au regard de la consommation électrique, n’y aurait-il pas un problème ?

La puissance pas watt consomme n’est pas terrible. Elles génèrent beaucoup de pertes en chaleurs.

C’est comme le rendement d’un moteur thermique par rapport à un moteur électrique.

Avec cette puce M1, Il est claire que nous assistons à un très gros changement et qu’il va falloir revoir nos références.

Performance ne découlera pas nécessairement de grosse mémoire, gros gpu, grosse alimentation et ..... chaleur 😃

@Kafy28,

« Les cartes gpu dédiées sont peut être du passé pour Apple ? Je pense qu’ils vont pousser leur concepteur de tout intégré dans le même chip au maximum. A mon avis les futures chip oriente pro d’Apple, se rapprocheront des perfs des meilleurs cartes gpu. »

👌👍

Apple va rendre obsolète l'utilisation de eGPU tant leur solution maison embarquée mettra la patée à la concurrence.

« Avec cette puce M1, Il est claire que nous assistons à un très gros changement et qu’il va falloir revoir nos références. »

Ne surtout pas oublier que le processeur Apple Silicon M1 est d'entrée de gamme et que cela envoie déjà du steak comme jamais, y compris chez Intel !

😁

Attendons de voir le milieu de gamme et surtout le haut de gamme avant de s'affoler pour la non prise en charge de eGPU qui seront de toutes les façons à la ramasse par rapport à ce que va proposer Apple.

Je peux l'écrire parce que nous avons une première itération en entrée de gamme qui préfigure parfaitement où Apple veut aller !

😘❤

Ils ont optimisé leur M1 pour que le CPU travaille de concert avec le GPU, et ça doit s'arrêter la (c'est déjà beaucoup). Peut-être que de future puce dédiée à des besoins en GPU beaucoup plus important supporteront ces GPU externes, ou pas.

Pour la modélisation 3D le GPU est quand même limité, même si la symbiose entre CPU et GPU esg optimal sur le M1, ça reste un GPU de puissance "faible"

@pechtoc,

« Ils ont optimisé leur M1 pour que le CPU travaille de concert avec le GPU, et ça doit s'arrêter la (c'est déjà beaucoup). Peut-être que de future puce dédiée à des besoins en GPU beaucoup plus important supporteront ces GPU externes, ou pas. Pour la modélisation 3D le GPU est quand même limité, même si la symbiose entre CPU et GPU esg optimal sur le M1, ça reste un GPU de puissance "faible" »

Ce n'est pas comme cela qu'il faut comprendre la situation technique dans laquelle nous sommes avec les ordinateurs Apple motorisés grâce à des processeurs Apple Silicon M1 !

Le M1 est un modèle entrée de gamme.

Attendez de voir le milieu de gamme et surtout le haut de gamme, avant de penser qu'il vous faudra absolument une eGPU d'une tierce partie pour traiter efficacement vos données...

Je pense que vous ne vous poserez même plus la question !

😁

Pages