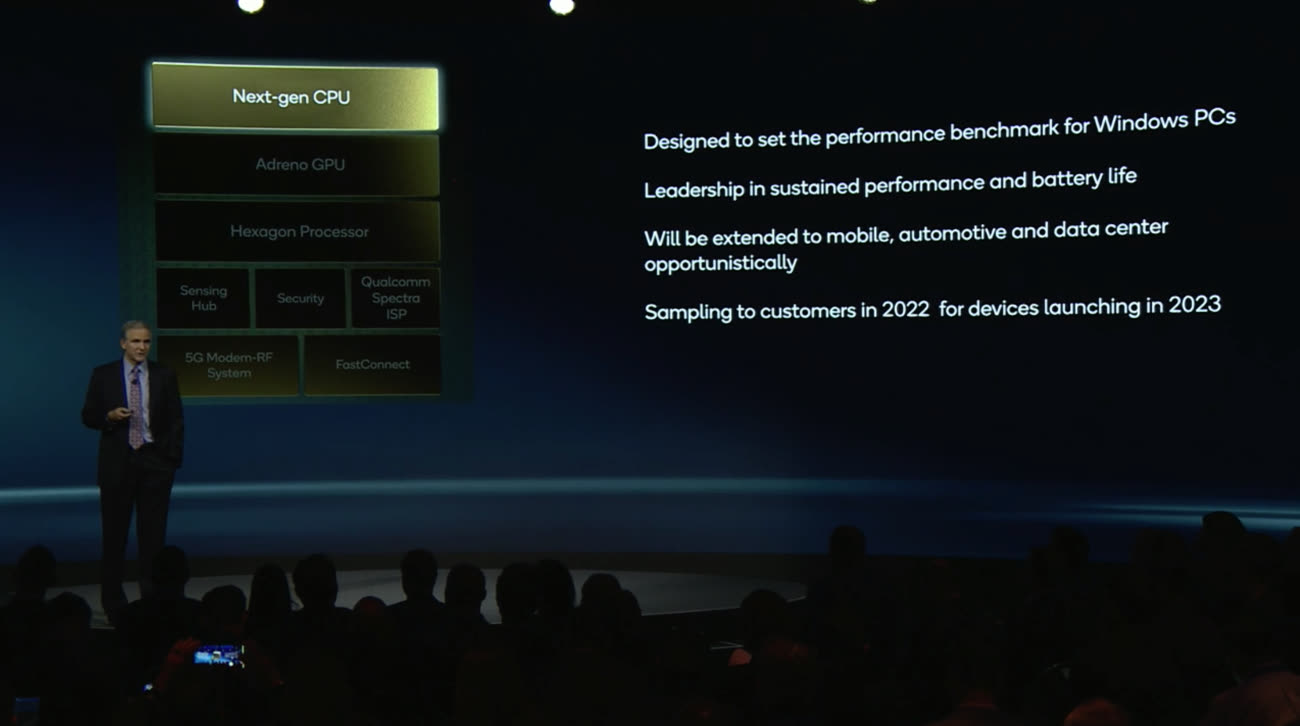

La puce Qualcomm concurrente de la M1 sera présentée d'ici neuf mois

Jusqu'à présent, les puces pour ordinateurs développées par Qualcomm n'ont pas réellement su trouver leur clientèle. La version de Windows pour ARM n'est pas devenue un incontournable, malgré la gamme Snapdragon 8cx dévoilée en décembre 2018. Et le travail en commun avec Microsoft sur les puces SQ1 et SQ2 pour les Surface X n'a pas donné les fruits escomptés.

Malgré tout, Qualcomm a bien l'intention de marcher sur les platebandes d'Apple avec une puce qui pourrait en remontrer aux SoC surpuissants du constructeur de Cupertino. Durant la journée dédiée aux actionnaires, le fondeur a fait un point d'étape sur le développement du futur système-sur-puce qui a l'ambition de devenir la référence en termes de performances pour les PC sous Windows.

Qualcomm veut arracher le leadership en matière d'autonomie et de performances sur la longueur, ce qui ressemble à une déclaration de guerre contre Apple et les puces M1 qui ont fait leurs preuves dans ces deux domaines. L'entreprise est tellement sûre de son coup que les innovations intégrées à ce SoC vont profiter aussi aux équipements pour mobile, pour le secteur automobile et les centres de données.

Les premiers exemplaires de cette puce miraculeuse seront livrées d'ici neuf mois, tandis que les premiers ordinateurs équipés seront disponibles en 2023. Si Qualcomm fait preuve de tant d'optimisme, c'est qu'il s'appuie sur une technologie développée par des anciens d'Apple ayant fondé Nuvia. Cette start-up avait commencé à développer des puces pour serveurs, avant que Qualcomm mette la main au portefeuille.

Qualcomm promet une puce aussi puissante que la M1 des Mac, avec l'aide d'anciens d'Apple

Une acquisition qui n'a pas fait que des heureux chez Apple, le constructeur ayant porté plainte contre Nuvia pour des infractions à des clauses de non-concurrence. Le ton est rapidement monté dans les tours entre les deux entreprises.

En attendant, Qualcomm et Apple continuent de travailler ensemble, le premier fournissant ses puces 5G au second. Un contrat qui pourrait s'achever en 2024, lorsque la Pomme pourra utiliser son propre modem et uniquement celui-là. Les livraisons de Qualcomm pourraient cependant se réduire plus rapidement au fur et à mesure du développement de la puce maison : le groupe prévoit en effet que d'ici 2023 (soit l'iPhone 15 ?), il ne fournira plus que 20% du nombre total de smartphones d'Apple.

La perte progressive de ce gros client signifie qu'à terme, Apple ne représentera plus qu'un pourcentage « à un chiffre » de l'activité « puces » de Qualcomm d'ici la fin de l'année fiscale 2024 (elle a pesé pour 27 milliards de dollars en 2021). Le fondeur peut toutefois s'appuyer sur les autres constructeurs qui continuent d'utiliser ses modems, comme Xiaomi, Oppo et Vivo.

@Philarmonik

"Par contre un provider comme AWS a l'ambition accélerer l'adoption de ses processeurs graviton (et graviton 2) disponibles déjà sur de nombreux services dont les fonctions lambda qui ne nécessitent pas de reprendre le code pour tourner sur graviton, mais permet de faire des économies."

yep il y a plein de choses intéressantes mais ça ne fait pas un bouleversement du marché pour autant 😉

@Philarmonik

"Cela dit 5 ans, ça passe vite et des changements et des revirements de situation, il y en aura un certains nombre sur ce laps de temps."

Contrairement à ce que l’on imagine le secteur de l’IT est très frileux et ne saute pas sur les changements et les nouveautés.

Au passage, Intel a déjà vécu une époque de grande concurrence avec de nombreux acteurs proposant des solutions RISC de qualité (Sun, HP, IBM…) et pourtant à la fin Intel a gagné avec ses immondes x86 🤢

Le succès business ce n’est pas que de la tech et de la performance c’est aussi une stratégie commerciale, une puissance économique, une création de relations stables et/ou de dépendance…

@Philarmonik

"- Intel peut continuer à dominer le marché en continuant à faire évoluer ses processeurs x86/64 (avec des capacités graphiques intégrées bien maigres par rapport à la série M1) tout GPU dédié mis à part ?”

Ici plusieurs points importants:

- contrairement à ce que l’on imagines la puissance brute n’est pas une clé du marché.

- les flag ship ont une importance symbolique

- mais la plus grande part de ventes se fait sur des CPU dont les caractéristiques ne t’emballeraient pas

- pour le GPU c’est encore plus flagrant, les besoins en puissance GPU ne concernent nullement le cœur de marché

Après oui il y a des marges de progression conséquentes tout en préservant l’ISA x64

“- Intel investie massivement dans la R&D pour rattraper en 1 ou 2 ans, ce que des companies comme Appe ont mis des années à développer ?”

Là c’est assez déplacé par rapport aux réalités: il n’y strictement rien dans les SOC d’Apple qui ne soit à la portée d’Intel ou qui soit de l’ordre d’une innovation technologique nécessitant de lourds investissements pour Intel.

Apple est passé petit à petit au design de SOC en partant ex-nihilo

Intel est leader de cette industrie qu’ils ont quasiment inventé depuis presque un demi siècle.

Intel à une expérience et des savoir faire en terme de design largement supérieur à ceux d’Apple là n’est pas l’enjeu.

Le seul réel avantage d’Apple c’est son fondeur qui possède actuellement des solutions de gravure meilleure que celle d’Intel

C’est là où Intel doit rattraper son retard pas sur des enjeux de design

“Intel essaye de racheter une société comme Qualcom pour accélérer le rattrapage de son retard sur ARM ?"

Pourquoi faire?

Si Intel voulait se lancer sur des offres ARM ils n’ont qu’à acheter une licence ARM nul besoin d”un achat (d’autant qu’une acquisition est quasiment impossible pour un tel acteur)

Mais je doute fort qu’il soit nécessaire de renoncer à l’ISA x64 pour pouvoir progresser.

AMD montre de belles choses Intel a largement les moyens d’en faire autant voir mieux.

A te lire on a la sensation que pour toi pas d’avenir hors ARM pour Intel ce qui est fort discutable.

Et derniers points non technique mais pourtant fondamental : Intel est le seul acteur à pouvoir se permettre une stratégie commerciale agressive en baisant ses tarifs sur les marchés où ils ont une compétition agressive et en compensant sur les marchés extrêmement rentables où ils sont en forte croissance.

La puissance commerciale d’Intel dont une part écrasante ses ventes est le fruit d’accords en très grands volumes est et reste incomparable.

@YetOneOtherGit

Non le plus important c’est probablement la consommation d’énergie et la chaleur dégagée. Points sur lesquels le M1 excelle.

Plus de puissance est toujours appréciable mais on a atteint qqch de correct pour la plupart des besoins. Quand tu prends un serveur, généralement tu regardes le prix et le nombre de cœurs et la quantité de mémoire. Tu ne sais pas forcément précisément de quel type de cœur il s’agit.

La majorité de mes serveurs ne fait quasiment rien hors horaires de bureaux. Comme la plupart des serveurs dont les utilisateurs sont européens.

Je me demande quel serait l’impact énergétique d’un M1 vs les puces intel/amd sur 1 an pour un serveur, puis pour un data center complet.

@cybercooll

"Non le plus important c’est probablement la consommation d’énergie et la chaleur dégagée. Points sur lesquels le M1 excelle. "

Un peu réducteur de réduire les nombreux sujets abordés à un « non » et à une emphase sur la consommation 😉

Oui la consommation est un enjeu pour l’IT mais croire que l’architecture x64 est consubstantiellement plus vorace que celle ARM c’est aller un peu vite en besogne.

@YetOneOtherGit

L’architecture non. Mais ce qu’ils en font en pratique oui. Je n’ai jamais parlé de l’architecture x64. Je dis juste qu’un petit geste de régulation via des malus ou une volonté d’Apple d’investir des marché juteux pourraient radicalement changer la donne (pas a horizon 5 ans, c’est plus lent que ça).

On est d’accord cela n’arrivera pas.

Du moins pas tant que le parc automobile est passé à 90% électrique. Ensuite faudra bien qu’ils trouvent un autre endroit où mettre des malus et faire baisser la conso électrique. Et vu qu’il n’y a aucun fondeur européen, mettre une taxe sur la conso des puces c’est tout benef.

@cybercooll

"L’architecture non. Mais ce qu’ils en font en pratique oui. "

Nous parlons de l’avenir et donc si l’architecture n’est pas une limite : aucune raison qu’Intel porte un handicap

@YetOneOtherGit

J’attends toujours une puce intel puissante qui ne chauffe pas et consomme peu.

En pratique, mon M1 max démonte mon MacBook core i7 et mon fixe ryzen 3800X.

Il est 50% plus rapide sur des taches que je fais 100 fois par jour.

Il me fallait 10 ans pour constater un tel écart entre 2 machines.

Moi j’appelle ça un handicap, qu’il vienne de l’archi ou d’autre chose m’importe peu en tant que consommateur. Je veux des résultats. Et le résultat me donne envie de voir des équivalents M1 de partout (= faible conso d’énergie et puissance phénoménale). Je rêve d’un data center utilisant exclusivement des puces équivalentes au M1, qui consommerait 10 fois moins d’énergie tout en ayant de meilleures perf et qui serait en plus probablement moins cher.

Oui c’est une vision triviale, je sais merci. N’empêche que ça serait bien.

@cybercooll

"Moi j’appelle ça un handicap"

Un handicap c’est quelque chose qui a un impact sérieux sur le business et les perspectives business.

@YetOneOtherGit

Bah non. Tu la sors d’où cette définition? Tu rajoutes un « sérieux » parce que ça t’arrange.

Et puis même, l’impact est sérieux. Si les cpu intel consommaient moins et étaient plus puissants, amd ne serait plus la et ils auraient encore plus de perspectives.

@cybercooll

"Bah non. Tu la sors d’où cette définition? Tu rajoutes un « sérieux » parce que ça t’arrange."

De la logique business la plus classique : un handicap c’est quelque chose dans ne cadre d’une entreprise qui obère les perspectives d’avenir et qui est très difficile à surmonter.

Ce n’est pas parcelle que cela m’arrange : demande à un panel de chef d’entreprise ce qu’ils considèrent être un handicap 😎

C’est quelque chose de lourd.

À employer les termes sans mesure ont les vide de tout sens.

Là nous sommes sur un pb transitoire impactant une petite part de l’activité et n’ayant pas de conséquences graves à moyen sur l’avenir.

L’ostentation de certains à voir un Intel en difficulté pour abonder dans le sens de leurs goûts et dégoûts est absolument remarquable.

@cybercooll

"Et puis même, l’impact est sérieux."

Où ça ? Tu as lu les derniers bilans d’Intel ?

@cybercooll

"Si les cpu intel consommaient moins et étaient plus puissants, amd ne serait plus la et ils auraient encore plus de perspectives."

Absolument marginal en terme d’impact business pour Intel, chiant mais marginal.

AMD a fait un remarquable travail d redressement mais ils sont loin d’être une grande menace pour la profitabilité d’Intel.

Au passage on de demande bien pourquoi tu mets les enjeux énergétiques dans la balance concernant l’opposition avec AMD ?

Comme tu l’as dit plus haut tu es dans des fantasmes fruits de ton imagination.

Et tu essayes de rationaliser ces fantasmes avec des éléments qui ne se tiennent pas.

@YetOneOtherGit

@YetOneOtherGit

"Au passage on de demande bien pourquoi tu mets les enjeux énergétiques dans la balance concernant l’opposition avec AMD "

Les perf et prix sont globalement du même niveau, il n’y a pas vraiment de raison d’éliminer l’un ou l’autre de façon rédhibitoire au moment de l’achat. Si l’un était nettement meilleur sur la consommation, ça lui profiterait nécessairement.

@YetOneOtherGit

"Et tu essayes de rationaliser ces fantasmes avec des éléments qui ne se tiennent pas"

En pratique un graviton est 40% moins cher qu’un intel a perf équivalentes. Ce n’est pas un fantasme. A moins d’avoir de bonnes raison de favoriser un cpu intel, je ne vois pas grand chose en sa faveur.

Je me demande juste ce que ça donnerait avec un M1 max.

Je n’ai pas la réponse.

@cybercooll

"Je rêve d’un data center utilisant exclusivement des puces équivalentes au M1, qui consommerait 10 fois moins d’énergie tout en ayant de meilleures perf et qui serait en plus probablement moins cher."

Yep c’est un rêve : l’architecture ARM sur serveur ne fait pas des miracles dans ces proportions.

Tu idéalises le M1 qui est un superbe travail mais n’est pas le game changer que tu fantasmes

@cybercooll

"N’empêche que ça serait bien."

Nope car ce n’aurait nullement les bénéfices que tu imagines 😎

À puissance de traitement équivalente les offres ARM serveur sont très très loin d’un gain de consommation énergétique d’un facteur 10 😉

@cybercool : oh tu sais tout est relatif

ce qu'on sait c'est que la puce M1 et M1pro/max sont des puces peu énergivores sur des applicationsbien optimisées et sur un écosystème bien maîtrisé

en fait, si tu veux, le mac parait absolument fantastique et hyper puissant lorsque tu l'utilises comme Apple voudrait que tu l'utilise.

Figure toi que j'ai voulu faire le kéké, installer crossover, steam, puis age of empire 2 pour tester en me disant, c'est pas gourmand, pas très énergivore, mon MBP M1 ne chauffe JAMAIS y compris lorsque je l'utilise à fond...

j'ai vite fait la tronche quand je l'ai entendu souffler comme un airbus au bout de 15 min et quand je me suis rendu compte qu'il était littéralement bouillant !

Je ne m'y attendais pas, donc oui, YOOG a raison, ce n'est pas aussi simple

@Dimemas

Je pense pas au monde du grand public, je pense aux pro et aux datacenters. Je développe des appli en java, puis je les déploie sur un serveur, comme beaucoup de développeurs. Je me fiche de ce qu’Apple veut que je fasse de mon ordi, je fais ce que je dois faire avec. Soit il est bon et tant mieux pour moi soit il n’est pas bon et je vais voir ailleurs.

Le M1 max a largement dépassé mes attentes. Il est 2 fois plus rapide que mon ryzen 3800X. Je reçois un dell xps dans qq semaines (les délais dell sont très supérieurs à Apple), on verra ce que donne un intel de prix équivalent.

Alors je me prends à rêver d’une amélioration équivalente sur mes serveurs, tout en baissant les coûts, et la consommation d’énergie.

Si cette piste n’était pas prometteuse, les gravitons d’aws n’existeraient pas.

Je n’ai pas besoin de plus de puissance sur mes serveurs, je pense à l’échelle d’un data center, il doit y avoir moyen de faire de belles économies. Aujourd’hui c’est du rêve, dans 10 ans optimiser sa conso énergétique sera crucial.

@Dimemas

« Figure toi que j'ai voulu faire le kéké, installer crossover, steam, puis age of empire 2 pour tester en me disant, c'est pas gourmand, pas très énergivore, mon MBP M1 ne chauffe JAMAIS y compris lorsque je l'utilise à fond...

j'ai vite fait la tronche quand je l'ai entendu souffler comme un airbus au bout de 15 min et quand je me suis rendu compte qu'il était littéralement bouillant ! »

Rappelle-moi qui est le développeur et l’éditeur de ce jeu 2D datant de 20 ans, qui fait souffrir ton Mac M1 ?

Un indice : ça commence par MI et se termine par SOFT !

@cybercooll

"Je n’ai jamais parlé de l’architecture x64"

Nous parlons bien de x64 vs ARM si non je ne vois pas le sens de tes propos 🤔

@YetOneOtherGit

Non on parle de puce intel vs puce Apple. Peu importe l’archi de la puce, d’un côté on a une puce soit pas puissante soit qui consomme bcp, de l’autre on a faible conso ET puissance. Combien de temps le marché peut-il faire le choix 1 si le choix 2 lui est proposé (ce qui n’est pas le cas pour le moment)

@cybercooll

"Peu importe l’archi de la puce, d’un côté on a une puce soit pas puissante soit qui consomme bcp, de l’autre on a faible conso ET puissance"

Et une fois que tu as enfoncé cette porte ouverte tu veux en venir où ?

Tu a bien considéré pourtant que cet enjeu était favorable aux architectures ARM plus haut dans les échanges.

« Non le plus important c’est probablement la consommation d’énergie et la chaleur dégagée. Points sur lesquels le M1 excelle. »

En commentaire d’un propos sur ARM vs Intel.

Tout est affaire de contexte comme disait Aragon 😉

@cybercooll

"ou une volonté d’Apple d’investir des marché juteux pourraient radicalement changer la donne (pas a horizon 5 ans, c’est plus lent que ça)."

Apple sur le marché IT je n’y crois pas une seconde, exister sur un marché avec une telle domination d’une poignée d’acteurs établis de longue date c’est très loin de n’être qu’une question d’offre.

Un petit côté #YaKafoKon dans ta vision ici un peut triviale.

ce serait ce que dans le fait d’imaginer que l’arrivée d’Apple sur ces enjeux changerait la donne.

@YetOneOtherGit

"Un petit côté #YaKafoKon dans ta vision ici un peut triviale"

Pourquoi tout de suite l’agression ? C’est pas pcq ton imagination est très limitée qu’il interdire aux autres d’en avoir.

S’il n’y avait que des gens comme toi, l’iPhone n’existerait pas.

Je ne te demande pas d’y croire, je te demande d’imaginer.

@cybercooll

"Pourquoi tout de suite l’agression ?"

Nul agression, juste un constat : « il suffirait qu’Apple arrive pour changer la donne » c’est très #YaKaFoKon.

Pas besoin d’être soupe au lait 😉

@cybercooll

"C’est pas pcq ton imagination est très limitée qu’il interdire aux autres d’en avoir."

L’imagination et les fantasmes ne sont pas de bons outils d’analyse des réalités des business.

Je préfère largement le régionalisme 😎

Après si tu veux que je libère mon imagination je peux te proposer du grand n’importe quoi SF. Le même qui faisait croire aux personnes imaginatives que nous aurions des voitures volantes au XXIe siècle 😉

@cybercooll

"Je ne te demande pas d’y croire, je te demande d’imaginer."

Confronter ce qu’on imagine au champ des possibles est une nécessité, si non c’est absolument stérile 😎

@YetOneOtherGit

Imagine si Apple change de stratégie et se dit que sortir des M1 max dans boîtier 1U pourrait être rentable.

Tu reverrais rapidement ton discours.

Bon d’accord ça n’arrivera jamais mais imagine quand même l’impact que ça aurait sur aws, gcp, azure, ovh…

@cybercooll

"Imagine si Apple change de stratégie et se dit que sortir des M1 max dans boîtier 1U pourrait être rentable.

Tu reverrais rapidement ton discours."

Nope 😎

@Philarmonik

"Il est probable que Intel rêve de pouvoir racheter Qualcom, son savoir faire et ses brevets pour pouvoir s'engager da la voie qu'ils nont pas su prendre durant ces 2 dernières décénies et ainsi sécuriser leur avenir."

Tu vas bien vite en besogne et tu sous-estimes grandement ce qu’est Intel face à Qualcomm 😎

Et de toute façon un tel rachat et impossible pour des raisons de concurrence.

@Philarmonik

"La différence entre les architectures ARM et x86/64, c'est que l'architecture x86/64 continue d'évoluer, mais semble commencer à être à bout de souffle à côté de ce que semble pouvoir offrir les SoC ARM."

Je déteste pour des raisons esthétiques l’ISA x64 mais ce n’est pas réellement handicapant aujourd’hui.

AMD montre qu’il est possible de tirer de belles progression en restant dans l’architecture x64, Intel pourra aussi le faire.

On surestimes terriblement l’impact d’une ISA aujourd’hui.

Les processeurs Intel ne sont déjà plus depuis longtemps des processeurs x64 en interne. L’ISA réellement exécuté est transpilé en temps réel à partir de l’ISA x64.

Enterrer le x64 c’est aller très vite en besogne comme croire que cette ISA est et restera un handicap.

@Philarmonik

"Il n'y a pas que dans le monde du mac et pc que ARM fait des émules, c'est aussi en marche côté serveurs avec le design neoverses ou les processeurd graviton d'Amazon Web Services."

Yep mais ce n’est en rien un raz de marrée 😉

La majorité des forcast voient le x64 en situation de grande domination à un horizon de 5 ans 😎

On ne fait pas bouger les lignes d’un héritage de plusieurs décennies rapidement 😉

@YetOneOtherGit

Il suffit de mettre un malus sur la consommation d’un data center ou mieux par puce vendue en fonction d’un seuil de consommation fixé selon l’usage (tel, serveur, ordi perso etc). Ça bougera plus vite, comme le monde de l’automobile qui a radicalement changé depuis les malus constructeurs.

@cybercooll

"Il suffit de mettre un malus sur la consommation "

Une phrase commençant par « il suffit de » et souvent douteuse.

Ta position présuppose qu’à service égal une architecture x64 est par construction condamnée quoi,qu’on fasse à être plus énergivore qu’une architecture ARM ce qui est très discutable 😉

@YetOneOtherGit

Seul l’avenir pourra trancher.

On en reparle dans 10 ans 😁.

On verra bien la part de marché des gravitonX chez aws vs les intel x64.

@cybercooll

"Seul l’avenir pourra trancher."

L’avenir est effectivement difficile à prédire pour ce qui se réalisera par contre en général les projections basées sur des analyses bancales se détectent fort bien dans le présent.

@cybercooll

"On verra bien la part de marché des gravitonX chez aws vs les intel x64."

La encore imaginer Amazon comme acteur majeur à 10 ans relève de la vision sous psychotropes 🕴

@cybercooll

"On en reparle dans 10 ans 😁."

A un horizon de 10 ans c’est toujours délicat par contre aucune des motivations de tes projections ne tient la route.

Le gratuit challenge à 10 ans est la continuation de la miniaturisation qui atteint quasiment les limites physiques actuellement.

Et pour des projections à 10 ans il faudrait tenir compte des évolutions d’un monde confronté à d’incroyables challenges.

Bref je ne me risque jamais à des prospectives à dix sachant que tous les travaux de prospective à cet horizon fait dans le passé se sont toujours trompés

@YOOG :

oui mais ...

assisterons-nous à un mouvement similaire à celui des puces de smartphone qu'apple avait initié.

comme le passage du 32 au 64bit à l'époque de liphone 5 si je me souvient bien non ?

Franchement, je m'attends à tout tant que je n'aurais pas vu les puces desktop, je vois beaucoup de comparaisons foireuses entre le M1 pro/max vs des puces desktop qui consomment 2 à 4 fois plus mais en vrai, nous sommes face à des puces mobiles avant tout !

Visiblement y a pas qu’intel qui est à la ramasse…

Voyons si Nvidia et AMD sauront mieux rebondir…

@laraigneegypsymontealagouttiere

"Visiblement y a pas qu’intel qui est à la ramasse…"

A la « ramasse » sur quoi ? 🤔

Ce que pense AMD de son concurrent « à la ramasse » :

Intel Corporation has been the market share leader for microprocessors for many years. Intel’s market share, margins and significant financial resources enable it to market its products aggressively, to target our customers and our channel partners with special incentives and to influence customers who do business with us. Intel exerts substantial influence over computer manufacturers and their channels of distribution through various brand and other marketing programs. Additionally, Intel is able to drive de facto standards and specifications for x86 microprocessors that could cause us and other companies to have delayed access to such standards. We expect Intel to continue to invest heavily in marketing, research and development, new manufacturing facilities and other technology companies.

@YetOneOtherGit

Elle est où la démonstration ? Qu’intel investisse dans le marketing, pas besoin de parler anglais…

@Malouin

"Elle est où la démonstration ?"

La démonstration qu’ils ne sont pas à la ramasse?

Elle semble évidente pourtant 😎

Et non cela ne dit pas simplement “qu’Intel investit dans le marketing” 🤨

Très loin s’en faut: cela explique la place prépondérante qu’occupe Intel dans ses business aussi bien en terme de moyens financiers, de force commerciale, de R&D, de puissance de contrôle des marchés, d’alliances…

Si toutes les entreprises “à la ramasse” avaient une telle santé et un tel avenir 😄

Donc pratiquement 2 ans en retard 🤔

@Mrleblanc101

"Donc pratiquement 2 ans en retard 🤔"

En retard sur quoi ?

Ils ratent quoi comme opportunité de marché ?

@YetOneOtherGit :

En retard sur la concurrence et sur les parts de marché.

Parce qu'en 2 ans, il y aura certainement eu assez de temps pour que ceux qui veulent de la puissance ET de l'autonomie passent sur un Mac quel qu'il soit.

Ils vont arriver avec quoi d'ici là ? Quelle plus-value par rapport aux puces d'Apple qui existeront depuis des années ? Ils vont mettre en avant l'autonomie ? Elle sera abyssale par rapport aux puces Apple pour que ce soit un critère de choix ?

Je ne suis pas devin, OK. Mais quand les utilisateurs de Windows moyen de gamme à 450-700 euros se rendront compte que leur PC tient trois fois moins la charge que le MacBook Air et que ce dernier fait tout plus vite, Apple aura marqué les esprits (ce qu'elle a fait avec les téléphones mais pas encore - je crois - avec les ordinateurs).

Les Qualcomm arriveront sur un marché du "plutôt haut de gamme" en termes de performances bien tard... Et encore faudra-t-il que les systèmes et matériels périphériques soient à la hauteur. Là l'avance d'Apple est certainement encore plus grande, non ?

@smog

"En retard sur la concurrence et sur les parts de marché."

🤩🤯😳

Tu as une idée des PDM d’Intel sur ses divers marchés ?

@YetOneOtherGit : on ne parle pas d'Intel ici mais de Qualcomm, il me semble. Donc de la concurrence Qualcomm/Apple sur les ARM dans les ordinateurs (dites-moi si je me trompe d'article, mais je ne crois pas).

Pages