Comment fonctionne le Retina des Mac (1/2) : à la recherche du pixel parfait

Depuis une bonne dizaine d'années maintenant, Apple commercialise des Mac avec des écrans dits « Retina ». Mais la notion est parfois mal comprise, surtout sur la méthode utilisée par macOS pour générer les images affichées. Dans ce dossier, nous allons donc nous pencher sur le fonctionnement du Retina, pour expliquer comment Apple arrive à proposer un affichage net et fin sans que l'ensemble devienne illisible.

Un peu de vocabulaire

Pour parler de ce sujet, il faut définir certaines choses pour bien se comprendre, car c'est un thème dans lequel les termes sont parfois mal utilisés. Premièrement, la différence entre la définition et la résolution.

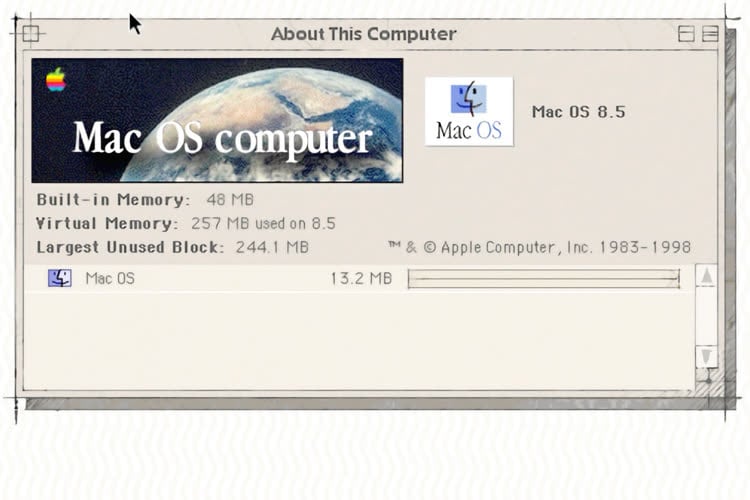

La définition caractérise le nombre de pixels dans une image ou — dans notre cas — sur une dalle. Elle s'exprime généralement en indiquant d'abord le nombre de pixels par ligne (par exemple 1 920) et ensuite celui par colonne (1 080 avec un ratio de 16:9). Un moniteur en « Full HD » (le D signifie Definition, d'ailleurs) a une définition de 1 920 x 1 080 pixels, soit un total de 2 073 600 pixels. Point important, la définition se limite à un nombre, sans référence physique. Un téléviseur Full HD de 55 pouces peut ainsi avoir la définition d’une dalle de 5,5 pouces (c’était le cas pour l’iPhone 6 Plus, par exemple) : 1 920 x 1 080.

Accroche : Richard Thomas (CC BY-NC 2.0)

Merci Pierre !

Article très intéressant, complet et instructif ! 👍

Merci, entre autres, pour ce rappel de la différence entre définition et résolution.

Cet article a l’avantage de ses défauts : préciser le sens des mots

Car on utilise « résolution » depuis 20 ans sinon plus, pour indiquer soit le nombre de pixels de la dalle (pour un écran LCD basse résolution) soit le nombre de pixels de l’espace de travail (pour un écran cathodique, ou un écran LCD haut résolution) …

… et c’est pas plus mal

Alors faut il rester sur le mauvais terme, mais communément utilisé ?

Ou faut il utiliser le bon mot, mais au risque d’être compliqué à comprendre et de perdre l’intérêt auprès des lecteurs ?

Bonne question…

C'est pas totalement le cas. On parle bien d'écrans "HD" pour "haute définition"

Et de toute façon, oui, il vaut mieux utiliser les bons mots que de se tromper au risque d'amener des confusions et des erreurs.

@Pierre Dandumont

la confusion vient de l'anglais, c'est tout. Allez dans Wikipédia et lisez la page "définition d'écran", elle est très intéressante, et correspond bien à ce qui est dit dans cet article, tout va bien

Mais ... si on demande à Wikipedia la version anglaise de cette page, on arrive sur "display resolution"

Et là pif paf, c'est plus le même mot

Bref plutôt que de confusion sur ces deux termes, comme si on prenait le mot français de "résolution" à la place du mot français de "définition", je me plais à penser que l'on utilise, tout simplement, l'anglicisme de "définition" au lieu du mot français "définition"

@pocketalex

bon de toutes façons la réalité du problème n'est pas là

la réalité du problème, mais on y viendra plus tard, est de conclure que c'est bien mieux un écran 27'' 5K, ou 32'' 6K ... qu'un écran 27 ou 32'' 4K 😝

@pocketalex

C'est une tendance classique de prendre le contre-pied de ce que l'on dit vernaculairement, en mélangeant terme technique et terme usuel. Exemple : les pingouins qui sont en fait des manchots, les tomates qui sont des fruits, l'augmentation de 10 points au lieu de 10%... Je préfère en général laisser le jargon aux articles scientifiques (et pourquoi pas celui-ci du coup) et le populaire pour les commentaires. Ce que je n'aime pas trop c'est quand on se prend on sérieux en reprenant les autres alors qu'en définitive on a bien compris le propos (pour les points/% il y a des exceptions car cela ne veut pas dire oa même chose, mais c'est finalement assez car les chiffres sont souvent donnés en brut aussi).

@koko256

"ce que l'on dit vernaculairement"

Chapeau ! faut le placer celui là dans une discussion ...

"Ce que je n'aime pas trop c'est quand on se prend on sérieux en reprenant les autres alors qu'en définitive on a bien compris le propos"

ça me concerne ce passage ? parceque si tu as lu mon commentaire, je ne fais que discuter d'un sujet abordé par l'article, et qui pose discussion

ce à quoi un commentaire sert ... hormis les sempiternels "bravo bel article"

@pocketalex

Vous n'êtes pas concerné par la phrase "je n'aime pas..." et je suis plutôt d'accord avec vous.

Super article, merci !

Donc, une image dans Aperçu, une vidéo YouTube dans Safari ou une vidéo dans VLC aura toujours la résolution native (si la place le permet) ou il faut qu’elle soit en mode plein écran ?

Réponse : les contenus sont affichés dans les pixels de la dalle

Exemple : Tu as une "résolution" de 2560x1440 affichée dans un écran 5K par exemple (iMac ou Studio Display), donc une dalle de 5120x2880 pixels, et tu veux lire une vidéo 1080p,

Tu double-clic sur ta vidéo, elle s'ouvre dans Quicktime Player ou VLC et s'affiche à 100% "de la dalle", donc dans le cas d'une vidéo 1080p dans une fenetre de 1920x1080 pixels réels et 960x540 dans l'interface

C'est un peu tordu à comprendre mais c'est comme ça que ça se passe

D'un point de vue "résolution de l'ordinateur" ta fenetre de lecture occupera 960x540 pixels

D'un point de vue "ce que tu vois réellement", c'est une vidéo de 1920x1080 pixels et tu vois chaque pixel de ta vidéo. Enfin je sais pas si tu les vois, car on parle de pixels 4x plus petits, donc faut avoir de très bon yeux

Ensuite, libre à toi de l'étirer, de la mettre en full screen, de la réduire. Après c'est open bar

Mais en tout cas les contenus multimedia s'affichent avec les pixels de la dalle : un pixel du contenu (de la photo, de la vidéo) = 1 pixel de la dalle

Autre exemple : dans le même écran "retina" une photo de 1024x768 pixels ouverte dans Photoshop s'affichera 2x plus petite que la même photo, dans le même photoshop, ouverte depuis un écran "classique"

Effectivement, j'ai testé sur mon iMac 24" 4480 × 2520 et je suis descendu au max. (1280x720).

Même dans cette « pseudo définition », les vidéos Youtube 2160p sont toujours impeccables de même que les photos dans Apple Photos ; ceci en plein écran ou dans leur interface.

Donc, c'est vraiment bien fichu !

Super intéressant, merci 👍

Sur un écran cathodique il y a quand même les luminophores RVB. Ça ne correspond pas aux pixels et donc en lien avec la résolution?

@aghez

je me souviens qu’en effet on n’affichait pas ce qu’on voulait dessus)

Ahh les cathodiques qui « scintillaient » si la résolution n’était pas adaptée. De quoi avoir une migraine en quelques minutes.

Ben c'était pas directement lié à la définition, en fait.

C'est lié à la fréquence de rafraîchissement et donc à l'électronique du moniteur et de la carte graphique. C'est indirect dans le sens ou la définition influe sur la fréquence de rafraichissement maximale mais un bon moniteur pouvait dépasser les 60 Hz même en définition maximale.

Par contre, il fallait un GPU avec un RAMdac assez rapide (le truc qui convertit le numérique en analogique). Dans certains cas, l'écran pouvait faire du 1600x1200 à 85 Hz (par exemple) mias pas la carte graphique.

@Pierre Dandumont

Le passage des iPhones au Retina ( iPhone 4) c’était vraiment une belle avancée même l’oled je n’ai pas autant constaté de différence bon après j’avoue je n’ai pas une très bonne vue

ces évidences me sont revenus au visage récemment avec adobe animate et un mac studio sous ventura.

j’ignore pourquoi mais la meme scene sous monterey glissait assez facilement alors qu’elle lague sous ventura

j’ai trouvé une parade: passer en 2x (donc full hd) ou en reso native ( donc 4k)

et la c’est fluide.

c’est a ce moment que j’ai compris pourquoi le MbP m2max n’avait pas ce soucis: ecran interne comme externe sont en mode par defaut ( voire natif pour l’ecran externe)

l’article tombe a point pour me remémorer tout cela, merci pierre!!!

"Techniquement, un canon à électron balaye une surface recouverte de phosphore et excite certains points pour former une image."

C'est vrai même avec un écran couleurs ? Je pensais la couleur sur les pixels (et donc on a bien un résolution horizontale -- ou définition horizontale cela marche aussi).

Je ne comprends pas qu’en mode 2k on puisse avoir un affichage plus fin: je l’imagine plus grossier puisque 4 pixels au lieu d’un doivent former une sorte de carré qui n’évoque plus un point ? Je sais que je me trompe mais je n’arrive pas à me faire une raison !

@imrfreeze

Sauf que oui mais non. En « logique » on pense au truc comme si les 4 pixels affichaient la même chose mais en « pratique » ils n’affichent pas toujours la même chose, ce qui permet de lisser les courbes et d’affiner les éléments d’interfaces et les caractères. Pense le comme un cahier à carreaux 5x5 ou tu compte les carreaux pour mesurer ce que tu dessine, mais où tu dessine quand même avec des « feutres » de couleurs dont la pointe « trace » des petits carrés de 1,25 par 1,25 au lieu de remplir chaque carré de 5x5 (ce qui se rapproche de la réalité avec des gros feutre dont la pointe aurait un diamètre de 1,25).

@Phiphi

👍🏻 Merci !