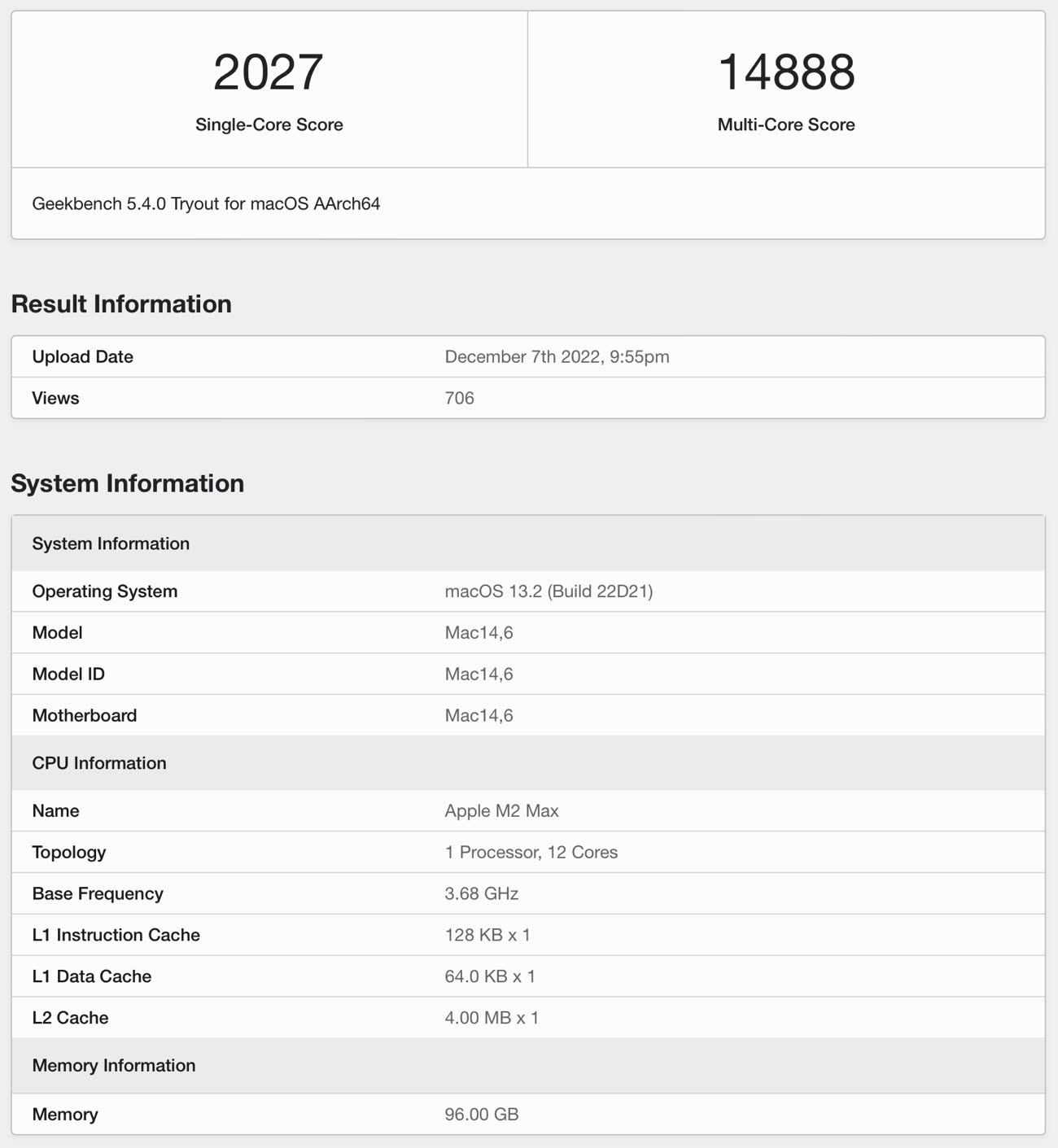

Un second test Geekbench d'un Apple M2 Max, un peu plus rapide

Après un premier résultat d'un Apple M2 Max sur Geekbench fin novembre, un second vient de tomber sur le site du célèbre logiciel de benchmark. Et les chiffres sont un peu plus élevés.

Un premier test d'un Apple M2 Max présumé nous apprend plusieurs choses intéressantes

Les informations sont très similaires : un Apple M2 Max sur un Mac inconnu (Mac14,6) qui pourrait autant être un MacBook Pro qu'un Mac Studio. La machine dispose de 96 Go de RAM et le processeur possède 12 cœurs, comme pour le premier. Nous l'expliquions pour le premier résultat posté, les résultats montrent qu'il s'agit probablement d'une puce en 8+4 (8 cœurs rapides, 4 cœurs basse consommation), alors que le M1 Max est en 8+2.

Le résultat en single core dépasse la barre des 2 000 points et le multi-core est de 14 888. Ce second M2 Max fonctionne à une fréquence un peu plus élevée que le premier (3,68 GHz contre 3,54 GHz) mais la différence de performances est plus grande que le gain en fréquence, ce qui implique des optimisations du côté d'Apple1. Sur un seul cœur, ce M2 Max est environ 15 % plus rapide que la moyenne des Mac Studio sur Geekbench (à peu près 20 % sur tous les cœurs). Le score est aussi assez proche d'un Mac Pro 2019 doté d'un Intel Xeon à 16 cœurs (et 32 threads).

Rappelons qu'un gain réel de 15 à 20 % est considéré comme un résultat correct lors d'un saut d'architecture tel que celui effectué entre le M1 et le M2. Les gains plus élevés ne sont généralement obtenus qu'en partant sur une nouvelle architecture, en augmentant fortement les fréquences ou en lâchant la bride sur la consommation et le nombre de cœurs, ce qui ne semble pas être le cas ici.

-

Ou, plus pragmatiquement que le test a été fait à un moment où le Mac travaillait. Lancer un benchmark peu de temps après une installation peut donner des résultats biaisés, liés aux différentes indexations effectuées par les logiciels Apple. ↩︎

Excellent ces puces M!!! :)

Tout comme à l’époque des Intel multi-coeurs, existe-t-il actuellement des applications (vidéo, son, photo) qui attendent ou a défaut savent tirer profit de ces puissances ?

Ceux que ça pourrait servir sont les logiciels de conception 3D (modélisation, conception architecture type AutoCAD) sont assez frileux avec l’environnement Mac.

Est-ce que ça les fera revenir de manière pérenne ?

@YSO

J'utilise HandBrake qui utilise bien les coeurs.

Mais je suis encore sur un iMac 27" core i7 de 2012, que j'aimerais bien remplacé avec un Studio

@YSO

ceux optimisé mx le sont en général

perso j’ai l’exemple d’un projet after effect lance sur mon imac i7 2020 et le meme lancé sur le mac studio

5h vs 1h quand meme, le disque dur externe restant le meme, la version d’after aussi, la ram n’est pas la meme, 40 pour l’imac vs 64 pour le mac studio, ca a pu jouer mais pas etre la seule explication

@raoolito

Sans nier ce que vous écrivez tous les deux, ce que je voulais dire c’est qu’Apple apporte beaucoup de puissance et de cœur à ses machines, et que ni son OS, ni ses logiciels, ni des logiciels tiers ne savent pleinement en tirer profit à ce jour.

@YSO

ah bon?

alors peut-être davinci resolve est connu comme la référence en matière d’optimisation sur macos.

et comme il envoie du lourd niveau demande de puissance ca peut se sentir avec lui peut-être ?

@raoolito

Je ne dis pas qu’il n’y en a pas, je dis que ça fait peu sur l’ensemble du parc des logiciels existants ; comme s’ils ne cherchaient pas à en tirer profit.

Un exemple : à la sortie des Mac ARM et des nouvelles versions de Final Cut. même ce dernier ne semblait pas pleinement tirer profit de ces nouvelles puces.

Vu que les Mac ARM sont définis comme étant bien plus performants et bien plus économes en énergie que les PC de chez Windows, quand on regarde ce que l’on trouve sur Internet sur les comparaisons entre ces Mac et les PC Intel on constate certaines améliorations pour quelques logiciels, mais pas sur d’autres (aucun gain de temps).

@YSO

Oui c’est bien le problème chez Apple ! Les produits sont super puissants, ça fait des beaux graphiques pendant les Keynotes, puis ensuite… bah rien…

C’est encore plus flagrant avec les iPhone et iPad… ça fait des années que les testent nous disent que le nouvel iPhone est ultra puissant et paré pour le futur et les prochaines versions d’iOS, puis finalement les prochaines versions arrivent avec les nouveaux produits, et les fonctions un peu gourmandes ne sont pas supportées (Stage Manager, et pire encore les insertions d’emojis à la voix ou la fonction karaoké d’Apple Music). On se demande bien à quoi sert toute cette puissance.

Le Mac étant plus ouvert, c’est un peu différent. Mais c’est dommage car depuis Mavericks (et à minima High Sierra) Apple ne semble plus très préoccupée par l’optimisation… En se reconcentrant une année pour nous sortir un OS à la Mavericks, avec de nombreuses nouveautés et optimisations sour le capot, je suis persuadé qu’ils pourraient encore augmenter la performance, l’autonomie,…

@mat16963

"Les produits sont super puissants, ça fait des beaux graphiques pendant les Keynotes, puis ensuite… bah rien…"

Vous montez un groupe là ? La réunion des farfelus anonymes ?

Déja les Macs ne sont pas plus puissant que les PC dans tous les cas, cette affirmation ne veut RIEN dire, et il faut considérer la consommation dans l'équation, sinon en puissance pure les Macs sont LOIN d'être les plus performants.

Ce nouveau M1Max même pas sorti est en score multi 2x moins puissant que le core i9 13900K, donc les Mac puissant, on repassera

Par contre, si on met un i9 13900K dans un laptop, et qu'on fasse en sorte qu'il assure les benchmark qu'Intel affiche pour son processeur, je donne pas 30 secondes pour que le laptop se transforme en boule de flamme, et quand bien même le laptop ferait 18cm d'épaisseurs avec un Watercooling de taré, alors la machine tiendrait environ 30 minutes avec les meilleures batteries du moment

Bref NON Apple est loin de proposer le top de la puissance, en revanche seul Apple peut actuellement tenir les benchs indiqués dans un laptop fin et léger, silencieux et frais tout le temps, et permettant plus de 6 à 8h de travail intensif, là ou les meilleurs laptops concurrent n'offriront pas mieux sauf à imposer une prise de courant, faire tourner une soufflerie de taré, ou proposer 1 à 2h max sur batterie

L'offre Apple reste donc pertinente, en laptop en tout cas, ou en desktop si on préfère un petit boitier silencieux à une grosse tour énergivore

Reste les logiciels, et sur ce point ils exploitent tous les CPU et GPU, inutile de nous expliquer que les logiciels sont en retard, ils sont au gout du jour. Des améliorations et optimisations sont surement possible ici et là, mais c'est pareil "en face" et il n'y a pas à ma connaissance de "retard grave", bien au contraire

Encore faut il les utiliser avant de parler

@pocketlatex

sauf que avec les usages actuels c'est bien l'intelligence du rapport puissance vs ergonomie, maniabilité, encombrement bruit... consommation qui compte.

@Javelin

c'est compliqué

Si la puissance était TOUT, alors je ne serais pas sur Mac.

En vrai, l'important est d'avoir "assez de puissance sous le coude" pour quand même faire la plupart des métiers confortablement. Et après d'autres considérations interviennent, qui font tout l'intérêt du Mac même si ce dernier ne propose PAS les machines les plus puissantes. Eh oui.

Déja, je parle du core i9 13900K dans mon commentaire ... mais ne croyez pas que tous les PC sont équipés de ce CPU, même les grosses machines de travail n'ont pas toute un bousin comme ça dedans (ni une GTX 4090). Il y a d'autres core i9 plus modestes mais tout de même redoutables, et des core i7, et des core i5 ... il y a tout une palette de CPU chez Intel et tout le monde n'a pas le mastodonte qui bouffe 300W à l'usage, et si on descend en gamme, même en restant dans le très haut de gamme, ben fatalement on se rapproche du M1Max, ou du M2Max

Ensuite, si l'on prend mon cas, je suis ce que l'on appelle un "travailleur nomade". J'ai un bureau ultra confortable avec un grand écran 32" 6K, un clavier top, la meilleure souris du monde (la Logitech MX Anywhere 3), le reseau avec le NAS, la fibre 1Gbps ... super !!! ... mais j'aime pouvoir travailler ailleurs que dans ce bureau : dans mon salon le soir, dans des bars en journée, chez des amis, prolonger le lieu de vacances une ou deux semaines et mélanger boulot et plage, etc

Et je ne suis pas seul, c'est la tendance de travailler de n'importe où

Ainsi, je préfère mais 100 000 fois mon MBP M1Max qui m'offrira moins bien que ce que m'offrirait une monstrueuse tour en core i9 watercoolée (entendons nous bien : UN PEU moins bien) mais de l'autre coté la possibilité d'avoir toutes ses performances même sur batterie, même pendant 6 à 8 heures d'affilées ! D'un point de vue taf, ça change tout.

Et vu mes usages, un Mac portable Intel, ou tout laptop PC du commerce, est proprement incapable de m'aider professionnellement, car ce sont des machines qui ont une gueule de portable, mais qui ne sont pas des portables, car ils nécessitent une prise de courant. Sinon au bout de 2h ils s'éteignent. Ou alors ils faut se restreindre à faire de l'excel si on veut une plus grande autonomie, mais moi mon métier c'est After Effect, Photoshop, Blender, C4D. Ou se restreindre à bosser 2h.

Mais la puissance, même si ce n'est pas TOUT, ce n'est pas RIEN non plus. C'est important. Dans les métiers de la création, c'est ce qui fait que le soft tourne vite ou pas, permets des gros trucs, ou pas, sors les rendus rapidement, ou pas. Il faut donc un minimum, il faut un rapport prix/puissance qui sont intéressant

A ce petit jeu là, fort heureusement, les Mac Silicon sont extrêmement bien positionnés.

Le MBP M1Max par exemple, pour un ticket entre 2000 et 5000€ suivant config, tient parfaitement la route par rapport à l'offre PC laptop, les rapports prix/puissance sont équivalents, et le Mac conserve l'avantage de l'autonomie (et donc du silence aussi), bref ce sont des investissement intéressant

En desktop c'est plus discutable

Et, enfin, pour une NICHE (c'est à dire vraiment, mais vraiment, mais vraiment TRES peu de monde) de métier ultra-exigeants, comme la 3D "high end", alors le PC est juste obligatoire

Conclusion : faut il dire que PC c'est mieux car une micro niche de gens insignifiante bénéficie de meilleurs performances que si ils étaient sur Mac, le tout sur des configs grosse tour ultra-énergivores hors de prix ?

Il ne me semble pas

Apple peut dormir sur ses deux oreilles, son offre Silicon reste aujourd'hui un excellent choix, si ce n'est le meilleur, concernant les laptops, et moins concernant UNE catégorie de desktop : les tour puissantes.

C'est à dire pas grand monde.

@ raolito : tu résume un peu sur la base d'un logiciel très bien optmisé là ;)

mais il a raison, il y a beaucoup d'appli qui n'ont pas été encore optimisées.

Après c'est du boulot !

@ YSO

> ni son OS, ni ses logiciels, ni des logiciels tiers ne savent pleinement en tirer profit à ce jour

Faux.

C'est la beauté justement de libdispatch* (Grand Central Dispatch) et des possibilités de coder en asynchrone en Swift que d'exploiter automatiquement toute la puissance disponible sur un Mac.

Le développeur "se contente" de définir les tâches à exécuter en parallèle, et macOS répartit ces tâches sur les cœurs existants. Mieux encore, macOS gère également ce faisant des priorités.

La limitation, ce sont les algorithmes. Certains ne peuvent pas être ré-écrits ou pensés pour une exécution en parallèle. Donc certains logiciels profitent mieux que d'autres du parallélisme. Quoiqu'il en soit, une chose dont profitent tous les logiciels, c'est le découplage Interface utilisateur / traitement de données. Tu peux avoir un traitement hyper lourd, l'interface utilisateur restera quand même fluide et surtout ne sera pas bloquée par ce traitement. Avant c'était compliqué à gérer, depuis Grand Central Dispatch, c'est relativement facile. Ne pas oublier les systèmes de services au sein d'une application, avec le code découpé en modules. Certains gèrent l'interface et communiquent avec des services (au sein de l'app) qui font le taf.

(*) libdispatch a d'ailleurs été porté sous Linux.

@ marcos : donc en gros tu viens de dire exactement la même chose que lui mais tu conclus le contraire :)

Pour utiliser GCD, il faut que les dev l'utilisent correctement et fasse du code propre et asynchrone pour utiliser les thread correctement. Mais il faut qu'ils mettent les mains dans le cambouis !

Mais oui grand central dispatch a énormément simplifié le code et c'est ce qui rend UIKit et SwiftUI (qui devient super intéressant) hyper accessible et agréable à prendre en main.

@ Dimemas

> tu viens de dire exactement la même chose que lui mais tu conclus le contraire

Non, d'une part lui prétend de manière arbitraire qu'aucun logiciel n'en profite, d'autre part je dis que ce n'est pas toujours possible, et que donc il est vain de s'en offusquer.

@YSO

"que ni son OS, ni ses logiciels, ni des logiciels tiers ne savent pleinement en tirer profit à ce jour."

bah, ça fait juste une bonne dizaine d'années que les apps "pro", pour les gammes "pro" (PC ou Mac) exploitent le multi, mais à part ça tout va bien hein

je serais toi, je reviendrais aux fondamentaux de l'informatique avant de balancer de telles énormités

@pocketalex

Essaie d’argumenter avec moins de véhémence et plus d’aplomb. Ça élève le débat.

Ils ont développé des applications (Pro ou pas), plus performantes depuis 20 ans. Certes !

Mais l’accroissement de puissance vanté par le passage à la puce ARM devrait permettre d’aller encore plus vite, puisque le processeur (mono-cœur ou multi-coeur) n’est plus un frein (le maillon faible si tu préfères). Et ce, avec une consommation d’énergie moindre.

A l’arrivée (à ce jour) et plus d’un an après l’avènement du M1 et malgré des outils de codage simplifiés (cf les autres interventions) il n’y a qu’une relative amélioration ; pas l’effet Wahoouuuu escompté.

Mais ce fut pareil quand jadis on est passé au PowerPC, puis Intel.

Donc :

- soit c’est du vent (bluff commercial),

- soit nous sommes trop impatients, mais la facilité de programmer devrait le permettre,

- soit les développeurs des gros logiciels n’ont pas envie de se fatiguer à tout réécrire pour un marché - au final - marginal : 5 à 10% du parc (certes plus pour certaines niches : vidéo, son, photo).

Nota : on l’a bien vu avec les jeux.

Mais ce qu’on peut reprocher c’est qu’on nous vend ces nouveaux Mac pour aller à la vitesse d’un Rafale alors que malgré cela les logiciels embarqués ne peuvent aller plus vite qu’une Ferrari. Ce qui est déjà pas mal au demeurant !😄

@YSO

« soit nous sommes trop impatients »

ya peut-être de ca aussi

quand je suis passé de mon iMac 2020 à mon Mac studio, je n’ai pas toujours eu cette impression de je passe d’une Dacia à un Rafale sauf récemment avec ce projet after effect.

il est plus rapide, c’est indéniable mais il n’est pas deux fois plus rapide il est 30 à 50 % plus rapide la plupart du temps

ce qui avait biaisé ma sensation au début, c’est qu’il remplacait un Mac Mini 2018, et là par contre la baffe était monumentale

c'est clair que tu as dû halluciner !

@ YSO

> - soit c’est du vent (bluff commercial),

C'est ce que vous insinuez gratuitement comme je l'ai montré plus haut mais comme je le montre ci-dessous.

> - soit nous sommes trop impatients,

C'est certain, beaucoup veulent le beurre et l'argent du beurre et ne veulent pas accepter que tout ce qu'ils désirent n'est pas possible, vous y compris me semble-t-il vu vos insinuations.

> - soit les développeurs des gros logiciels n’ont pas envie de se fatiguer

Peut-être est-ce votre cas, la fainéantise, mais rien ne vous permet d'accuser les autres de vos propres travers.

Et bien sûr comme par hasard vous oubliez les cas où des algorithmes ne peuvent pas être implémentés "de manière parallèle". Dénigrement d'autrui oblige.

@marc_os

Vous avez décidément un problème avec la compréhension :

Quand on dit que « c’est du vent » c’est que ce qu’on nous monte lors des démonstrations de « Keynote » : c’est superbe, magnifique ça va très vite.

Mais à l’arrivée et comme expliqué avec détails précédemment : seul l’OS va vite.

C’est à dire sur les applications ne sont pas développées pour pouvoir pleinement exploiter toute cette puissance.

Il m’est difficile d’être plus clair.

Il n’y a pas de notion de vouloir le « beurre et l’argent du beurre ».

Pour information, cette expression veut dire que l’on veut l’avantage sans avoir à payer en regard, ce qui n’est pas le cas.

Quant à la problématique des développeurs, je n’insulte personne : tout le monde sait très bien que le monde Mac constitue une toute petite partie, même si elle est fort intéressante et « c’est elle qui tient le gouvernail » comme le disait Jean Louis Gassé.

Mais est-ce que les développeurs des deux plates-formes vont s’embêter à tout reconsidérer spécifiquement pour le Mac ARMqui vient de naître ?

Nul doute que tout s’accélèrera lorsque Windows pour ARM sera mis en vente ou à disposition et que le « monde d’en face » y basculeras totalement.

Il n’y a pas d’autres sous-entendus et donc d’insultes à l’égard de gens qui développent. Il suffit de d’aboi lire et comprendre. 😊

en fait non, le M1 ultra n'est pas utilisé avec toute sa puissance car trop de coeurs.

@ Dimemas

> le M1 ultra n'est pas utilisé avec toute sa puissance car trop de coeurs.

Pourriez-vous étayer cette affirmation péremptoire et expliquer ce que « trop de coeurs » veut dire selon vous ?

Perso, quand je vois la différence de perfs entre mon MBP Core I7 de 2019 au taf et mon MBP M1 Pro perso avec Xcode + simulateur, je ne trouve pas que le M1 ait « trop de coeurs ».

parce que tu compare un intel core I9 à la con qui throttlait dès que tu lance Xcode versus une puce beaucoup mieux conçue qui chauffe à peine déja.

Respire, prend du recul et relit moi stp.

Je parle du M1 ULTRA pas du M1pro que j'ai aussi et qui est clairement bien calibré pour faire ce que tu décrit, d'ailleurs c'est aussi mon usage en ce moment ;).

Même macg a parlé de l'absence d'opti sur cette puce.

Ce que je voulais dire, c'est qu'il y a beaucoup de coeurs et que les applis ne sont pas forcément codés de façon à fonctionner sur autant de thread. ;)

Et franchement c'était une génération cata, nous sommes d'accord pour dire que les apple silicon ont clairement changé la donne sur mac, le14nm a été rincé et usé jusqu'à la moelle avec des processeurs absolument pas conçu pour un usage portable

@ Dimemas

> parce que tu compare un intel core I9 à la con qui throttlait

Mais oui bien sûr, les intel core i9 c'était de la merde.

Disiez-vous cela aussi en 2019 où il n'y avait pas d'alternative ?

> Respire, prend du recul et relit moi stp.

Euh, ça va, pas besoin de relire la seule et unique phrase à l'emporte pièce de ton commentaire. Et Merci de laisser les attaques personnelles de côté.

De plus, je ne vois pas pourquoi vous vous offusquez de choses qui ne peuvent pas être faites d'une part, et de choses qu'Apple n'a pas promises d'autre part, à savoir une accélération miraculeuse des logiciels non "multi-threadés", et qui ne serait possible qu'en augmentant de manière significative la fréquence des CPU, alors qu'on sait qu'on est arrivé aux limites de la technologie dans ce domaine.

PS : J'attends toujours l'explication sur ce que veut dire « trop de cœurs ».

@ marcos : OUI !

et je le redirai autant de fois qu'il le faut.

J'abhorre la gamme de MBP de 2016 à 2019, c'est comme ça.

Parce que Apple était enfermé dans l'écosystème Intel.

sinon pas la peine de s'énerver encore une fois, mais on dirait que tu ne lis pas nos messages, je ne peux rien pour toi visiblement et désolé j'ai autre chose à faire.

@Dimemas

Mais enfin tout est question d’usage… les Ultra sont destinés à des applications vidéo principalement avec plein de traitements parallèles via des filtres ou effets en temps réel… et certains usages audio.

Quelle utilité pour des applications simples ? Aucun… sinon savoir qu’on en a sois le capot pour plus tard…

Tout ce qui est traitement d’image est très compliqué à coder en parallèle, et même le parangon du genre, Adobe, utilise des astuces pour ce faire et avec un découpage des zones à gérer pour chaque cœur avec des limites vites atteintes sur ce type de puce…

C’est pas que les logiciels n’existent pas pour tirer profit de ces traitements c’est soit que vos logiciels n’en tirent pas profit ou vos usages pas adaptés à cette puce.

Intel a longuement été dans le même cas de figure… plein de cœurs et des logiciels sous Windows qui n’en tirent pas profit… du coup ils sont repartis à la hausse des fréquences… mais sous Mac ou a Grand Central Dispatch qui automatise beaucoup de choses et optimise le système tout seul…

ah mais on est d'accord ! même entièrement d'accord, j'ai essayé de dire la même chose que toi en fait. (mais peut-être mal on dirait)

je répondais juste à ce disait YSO mais visiblement, dès que je dis un truc, on lit la moitié de mon commentaire et on s'énerve en répondant à coté de ce que je mettais.

alors que je tempère vachement mes messages actuellement.

Mais seul sur des appli extrêmement gourmandes on peut voir la différence, un word de 10 pages s'ouvrira et fonctionnera à la même vitesse qu'un M1 ^^

@Dimemas

Alors mea culpa, j’ai mal interprété ta réponse 😉

On est bien d’accord, et je plus soir ce que tu as écris sur les autres réponses…

je me demande si apple ne va pas aussi jouer sur les cœurs économiques pour faire des separations de gammes ?

on peut imaginer qu’un m2 « extrême » pour mac pro n’ai aucun coeur econome?

ou c’est trop compliqué à gerer peut-être 🤔 ?

Pas vraiment d'accord sur le passage sur les core E, c'était surtout pour la course à la puissance et sur certaines puces seulement.

En fait la 13e génération a 2 nouveautés, des puces avec le même procédé gracemont mais avec quelques centaines de Mhz en plus d'où le semblent de perf en plus, et surtout un joli coup de com' marketing pour dire "eh guys ! nous avons créé une gamme encore plus puissante et nous avons dépassé la loi de moore"

Sauf que si tu compares la gamme de la 12e et de la 13e génération (ce que je t'invite à faire), tu vas remarquer un truc absolument génial (qui montre le génie marketing d'intel), c'est qu'il n'y a pas réellement de nouvelle génération !

En fait, ils ont juste créer un nouveau processeur le 13900K qui consomme un réacteur EPR et te chauffera ta maison tranquillou tout l'hiver.

ET ... et ils ont décalé toute la gamme pour que le 12900K soit le 13700K, le 12700K soit le 13600K et ainsi de suite.

Avec un léger overclock pour dire, "mais si regardez ! les puce ssont plus rapides"

;)

ils sont vraiment forts.

Autant je suis impressionnés par le futur 13400 autant le reste me fait pisser de rire.

laisse tomber :

https://www.techpowerup.com/review/intel-core-i5-13600k/

https://www.techpowerup.com/review/intel-core-i9-13900k/

https://www.cowcotland.com/images.php?url=images/news/2022/09/specifications-techniques-14-cpu-intel-raptor-lake-s-1.jpg&t=660

Dans un MBP 16, et en supposant qu’il ne chauffe pas, ça va dépoter!!!

Il ne faut pas être déçu puisque le vrai saut était annoncé pour le M3. Le M2 est une version amélioré du M1 et c’est correct.

Mais c’est vrai qu’avec le M3 on attend le saut qu’on a eu entre le PPC 603/604 et Arthur aka PPC 750/G3. S’ils reproduisent ça en 2024, c’est la fête !

@ melaure

Le saut a déjà eu lieu : Il a eu lieu lors du passage de Intel au M1, niveau performance et efficacité performances / consommation d'énergie.

Désormais, à mon avis il ne faut pas s'attendre à de grande révolution avant un moment, mais tabler sur une évolution continue. Et quand dans quelques années on comparera le M1 au M10, on pourra dire " wouah !" finalement un autre grand saut a quand même eu lieu.

@Pierre Dandumont

Quand j’ai upgradé mon Starmax 4000 604e/200 au G3/300 ca m’a fait une grande claque ! Le saut ètait très conséquent.

Apple n'aurait pas différé la sortie de ses MB sans raison , qu'on les appelle M2 ou M2max ou M3 l'important c'est le 3nm... Et à consommation équivalente, ça va envoyer du très lourd, dès 2023.

J'espère que vous avez raison j'ai tellement peur d'un "simple" M1+ overclocké (faux M2)

La finesse de gravure est LA clé du succès pas autre chose.

@TheUMan

Il ne faut pas attendre une nouvelle génération de puce à chaque fois qu’on abaisse la finesse de gravure.

Les gains en finesses sont limités et long a obtenir

On aurait une maj tous les 3 ans si on doit attendre un saut technologique à chaque fois

SI c'est pour avoir moins bien que le M1 (pas aux niveau performances brutes mais perfs/conso) cela ne vaut pas le coup...

Apple fait des tests de fréquence pour savoir laquelle mettre en production ❓

ça reste un test geekbench qui favorise les apple silicon versus d'autres bench plus réalistes.

Donc sans intêret sans les autres bench. Mais wait and see !

@Dimemas

Faux désolé de te contredire mais beaucoup des sources utilisés par Geekbench n’utilise que très peu les dernières technologies d’Apple.

Mais comme je ne vais pas affirmer sans argumentation je dirai simplement que Clang (compilation) ne présente pas aucun test en swift. Objective C, C et consors c’est sympa mais pas vraiment adapté à la situation Apple Silicon.

Vous aurez la même chose avec les optimisations AMX, point de tests poussant les limites perfs du Neural Engine et encore moins sur les capacités spécifiques de UMA. Bref on est très loin d’un truc pro Apple.

Oubliez geekbench

Ça ne nous dit rien du neural engine

Rien de la puissance réelle du cpu / gpu

Bon, alors pour ajouter mes 2 cents.

J'ai acquis un Mac Studio M1 Max - 64 go - 1to.

J'ai testé la machine dans le cadre de mon utilisation : montage vidéo, animation 2D, rendu 3D (Octane Render)

Concernant le montage sous Première Pro et l'anim sous After, il fait bien mieux que mon Mac Mini m1. C'était attendu.

Sous C4D, je retrouve enfin un peu de patate.

Les temps de rendu CPU sont bien plus courts et la machine a du répondant. Mais on est très en deçà de mon PC (AMD RYZEN 9 - 3900X 12-cores 32 GO RAM - RTX 2070 Super). Sur un rendu qui prend 1mn50 sur le PC, le Mac Studio affiche 3mn.

Sous Octane Render (rendu GPU), ça marche enfin correctement (toujours des bugs, mais disons que je peux bosser). A l'affichage, le rendu GPU est plus rapide, plus fluide. Mais on ne dépasse que rarement les 50% de puissance CPU utilisée. La RAM je n'en parle même pas, sur les 64 Go, 16 Go suffiraient.

Il reste qu'en termes de puissance délivrée, l'historique GPU est au taquet et les temps de rendus affichent quasiment le double que sur le PC (RTX 2070 S).

Suis-je déçu ? Oui un peu. Mais je m'y attendais.

La puissance de ces machines est un animal timide. Elle est là, bien présente, mais semble ne pas vouloir se montrer souvent.

Le problème de l'optimisation logicielle est une piste plausible (Apple n'est pas la seule en cause).

En dehors d'une utilisation très spécifique (calculs parallelisés, peut-être) le gain est assez faible.

Et j'imagine qu'un gain de fréquence n'y changera pas grand-chose. Il a fallu du temps à Apple pour tirer le maximum possible des CPU Intel et je pense qu'il faudra encore du temps pour arriver à tirer toute la puissance des M1, M2 et successeurs. Les gains seront surement marginaux au début mais évolueront.

.DR.