Ice Lake, Intel sort une nouvelle architecture de son chapeau

Intel a officiellement annoncé une prochaine architecture processeur baptisée "Ice Lake". Elle est promue comme profitant d'une finesse de gravure de 10 nm, apte à réduire encore la consommation électrique. C'est tout ce que son fabricant en dit pour le moment.

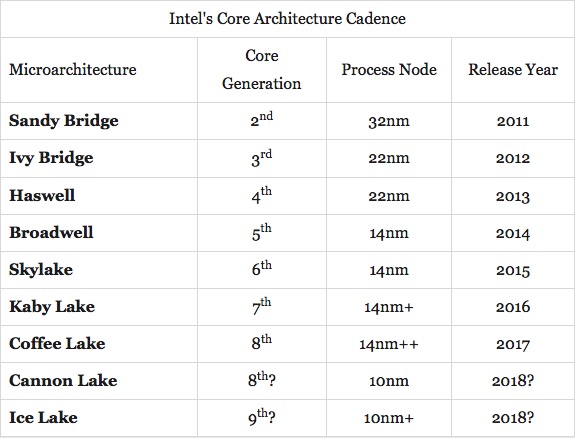

Actuellement les processeurs d'Intel s'en tiennent à 14 nm et le passage vers ce nouveau seuil reste délicat. Ars Technica, qui a repéré l'apparition soudaine de cette nouvelle référence, s'en étonne puisque le fondeur a déjà sur le feu Coffee Lake (successeur des Kaby Lake qui équipent les derniers Mac) et Cannon Lake, deux évolutions à propos desquelles les détails sont là aussi ténus.

La lecture de la grille des prochaines architectures d'Intel s'en trouve dès lors compliquée. Ice Lake est sommairement présenté comme le successeur, en 10 nm, de Coffee Lake alors que ce rôle était jusque là dévolu à Cannon Lake.

Telles que les choses se présentent, les ordinateurs de bureau et les portables utiliseraient Coffee Lake, les portables seuls (et machines de bureau, comme l'iMac qui peuvent utiliser des puces pour portables) passeraient ensuite sur Cannon Lake et tireraient avantage les premiers de cette nouvelle finesse de gravure. Puis, tout le monde embarquerait sur Ice Lake.

Pour Ars Technica Intel pourrait vouloir roder et mûrir ses techniques de fabrication en 10 nm sur les puces pour portables, car plus petites — les taux d'échec sont moins graves eu égard aux volumes produits - avant d'en faire bénéficier les plus gros processeurs pour machines de bureau.

On va bientôt dépasser les 30 millions de transistors par millimètre carré sur une puce.

Putain... hallucinant.

Intel sous pression ? arm arrive ?.

@Alberto8

Déjà qu'AMD leur a mis un coup de pression.

Grâce à la concurrence, Intel se sort enfin les doigts.

@Hasgarn

"Grâce à la concurrence, Intel se sort enfin les doigts."

Bien et pas bien…Aujourd'hui on a l'assurance d'avoir du matériel dans le coup plusieurs années, perso j'ai pas envi de revenir à l'époque où son matériel n'est plus dans le coup en même pas 2 ans car c'est la course à la puissance (les dev n'optimisaient plus leur programmes mais se reposaient sur la puissance brute et on se retrouvait avec un ordi dans les choux qu'il fallait remplacer assez rapidement)

@alfatech

Je valide ton propos !

Complètement d'accord avec toi

On peut vouloir effectivement se complaire dans la stagnation, qui a quelque chose de confortable en assurant une forme de stabilité, pour autant, si ses besoins sont couverts, ce n'est pas le cas pour tous.

On est dans une situation assez dramatique ou le manque de puissance de traitement se fait sentir de plus en plus dramatiquement. La croissance en taille et complexité des données a traiter par l'informatique est exponentielle, pas moins. Aujourd'hui on a la moitie de la puissance necessaire pour traiter les donnees existantes, elles s'accumulent. Dans 3 ans on va passer a 1/5 de la puissance necessaire... c'est dramatique.

Certes il va falloir attendre 8 a 10 ans pour que le particulier ressente cet ettoufement ineluctable, mais au niveau de la recherche et de l'industrie c'est un cataclysme en cours.

Pour ce faire une idée meme caricaturale des choses, la puissance necessaire aujourd'hui impliquerait que chaque humain dispose de 8 a 10 To de stockage et 4 a 5 serveurs de calcul ( avec disons du Xeon 18 core a 4Ghz - qui n'existe pas - et du multiGPU type Nvida 1080Ti - mais dans sa version pro -) tout ça relie en fibre.

Certes pour regarder Netflix ou flaner sur Twitter ou Fessebouc un macbook suffit, voir un chromebook (aussi puissant mais bien moins cher). Alors, lorsque ses besoins se cantonnent a cela, oui la stagnation d'Intel est confortable et fait faire des economies. Aujourd'hui un Mac d'il y a 10 ans a la meme puissance de calcul qu'un tout fraichement sorti, ok, mais on a bien une puissance de calcul d'il y a 10 ans...

Bonsoir,

Comment se manifeste ce besoin en puissance ? Et-ce du calcul pour l'industrie de pointe ? De la recherche scientifique ?

J'ignorais cette approche étayée ici,

merci s'il y a possibilité de m'éclairer.

1ere reponse simple: on genere aujourd'hui plus d'informations qu'on ne peut en traiter et cela de maniere croissante en masse comme en complexite. Les datasciences entrent partout, le bigdata est un mot devenu courrant, les mathematique avancées sont incontournables dans un nombre croissant de domaines.

2eme reponse en chiffres:

-jusqu'en 2005 l'humanité disposait de 130 exaoctet de données... en 2020 on sera face a 50 000 exaoctet, soit une croissance de presque 40 000% en 15 ans.

-En 2010 tous les ordinateurs de la planete etaient capables de traiter 7 000 exaoctet, aujourd'hui c'est 10 000 et en 2020 ce sera 12 000 ou 13 000 exaoctet... (soit une perte de croissance de puissance de 10% sur 5 ans)

3eme reponse plus technique: on est dans la situation des annees 60, juste avant l'arrivee de la micro-informatique. Les sciences ont fait des progrès considérables dans quasi tous les domaines et accélèrent, il y a de plus en plus de scientifiques et de chercheurs (sciences dures aux sciences humaines en passant par la médecine et la politique ou le commerce), de plus en plus de spécialistes, qui produisent non seulement beaucoup de connaissances qui obligent a reconsidérer chaque activité et domaine, mais surtout il y a une interconnexion croissante et une multiconnexion.

Cela implique qu'il n'y a quasi plus aucun domaine indépendant et cloisonné et que toute activité dans un secteur implique des interactions et donc des connaissance dans ceux qui sont connexes. Tout cela devant passer par des outils de gestion de l'information puissants.

Poses la question autour de toi de qui connait le langage R, les soft SPSS ou Tableau, qui utilise Excel pour faire de la modelisation (en fait pour autre chose que gerer sa liste de course ou son carnet d'adresse). Il y a 10 ans le secrétariat consistait a faire des PV, ecrire des lettes, tenir un agenda,... aujourd'hui il faut savoir utiliser des fonctions avancer d'un tableur. Le comptable a disparu, l'expert comptable est devenu commun.

N'importe qui en politique ou dans le marketing aujourd'hui travaille avec des outils statistiques avancé, code en R ou synthétise des flots de données avec SPSS. Les dernières élections en occident ont toutes été conduite avec des outils d'analyses sociologiques traitant de big data et d'analyse de millions de profils comportemento-affectivo-economico-sociologique (ouf).

Meme un agriculteur aujourd'hui doit utiliser un outil informatique connecté pour decider de sa strategie de culture... ceux qui ne le font pas disparaissent.

Au cours des 10 prochaines annees il va disparaitre plus d'emplois qu'il n'en a disparu au cours des 100 precedentes. On ne parle pas de chomage par surpopulation mais de disparition de type d'activité du fait de l'automatisation et de l'informatisation. L'outil informatique n'en est pas la cause, la cause en est la complexification de l'information. Dans 10 ans quasi tous les emplois seront concernés par ce qu'on nomme les datasciences.

Au niveau du particulier c'est le flot d'information de consommation qui augmente. Si on considere les fichiers media, ils necessitent aujourd'hui des puissance de traitement croissantes (on commence a le voire avec la Hii Res et les H265) mais le gouffre arrive avec la VR.

Mais il se pose un gros probleme: dans les annees 60 on avait une informatique en pleine croissance (technologique). Les mini ordinateurs allaient laisser la place a la micro-informatique, qui allait aboutir a l'informatique individuelle. La puisse d'un ordinateur individuel ateignant et depassant tres vite la puissance de mini-ordinateur. Les utilisateurs individuels disposaient alors de machines de plus en plus puissantes et apprenaient a les utiliser de maniere de plus en plus efficace.

Aujourd'hui, le PC stagne en puissance depuis 10 ans (processeur), voire régresse (processeur choisi, capacité de stockage, autonomie, possibilité de connexion), et ou l'obsolescence due a progres a fait place a l'obsolescence programmee par le marketing. On a des machines de divertissement (tablette, smartphone, console,...) ou des incongruité inutiles (smartwatch).

Prenons un exemple concernant Apple: le MacMini serveur 2012 16Go / 2 To. En monocore il est similaire en puissance avec le Mac Pro, et il arrive selon les domaines a depasser ce dernier. Pareil en comparaison du Macbook Pro 15". Si on compare en rapport puissance/prix c'est effrayant.

Prenons l'iPad, machine de consultation par excellence: il a une puissance équivalente voire supérieure aux PC de moyen de gamme d'Apple actuels, parce que ces derniers ont fortement régressé ou stagné.

Dans tous les cas on a des machines qui sont au niveau de capacité de traitement qui se situent au niveau moyen de ce que l'on avait il y a plus de 5 ans. Et pendant ces 5 ans la croissance globale de donnees et sa complexification s'est accélérée de plus de 2500% par an…

Merci beaucoup pour cette longue analyse, passée actuelle et à venir de l'évolution des besoins en puissance informatique.

J'en avais absolument pas conscience.

Bien sûr que nous entendons parler de data, bigdata, etc., mais je n'avais pas pris conscience de la puissance d'analyse nécessaire. Je pensais bien à l'aspect logiciel de traitement des données, cela m'impressionne, mais pas les besoins au niveau matériel.

Et en même temps que ces explications techniques, la façon dont nous allons vivre à une échéance moyenne - du fait de ces évolutions - mériterait d'être interroger.

Là, ce n'est plus du ressort de ce forum. Merci en tout cas pour le temps consacré à ces explications.

Complètement.

Reste aussi, outre la course à la puissance, la place de leader incontestable d'Intel qui lui a permis d'imposer ses prix. C'est quand même bien d'avoir la possibilité d'acheter un 8core/16threads pour 500€ là ou Intel en demandait 1000€ y'a pas si longtemps.

Quand au dev pour du multithreading, des logiciels comme DXO savent utiliser autant de cores qu'il est dispo. Il semble que le pas à franchir, aussi grand soit-il, ne refroidit que les plus fainéants (Adobe, je te regarde) et une fois franchi, ça demande de l'entretien et de l'optimisation mais pas des travaux considérables (encore une fois cf Prime de DXO). À confirmer toutefois.

Et enfin, la finesse de gravure va forcément ralentir la course à la puissance pendant encore quelques années. Personne ne peut affirmer que ça va durer longtemps (ou pas longtemps), mais on est tranquille pour au moins 3/4 ans, je pense.

@Hasgarn

"Et enfin, la finesse de gravure va forcément ralentir la course à la puissance pendant encore quelques années. Personne ne peut affirmer que ça va durer longtemps (ou pas longtemps), mais on est tranquille pour au moins 3/4 ans, je pense."

L'opinion générale dans le milieu est la fin de la loi de Moore en 2020-2021 avec une finesse de gravure de 3-5 nm.

Ensuite c'est ordi quantique, nanotubes et architectures radicalement différentes.

Entièrement d'accord avec toi !

T'inquiète, ça fait déjà des années que l'évolution n'évolue pas vraiment. J'envisage de plus en plus un changement matériel tous les 4 ans voire 5 ans avec les années qui passent

«Grâce à la concurrence, Intel se sort enfin les doigts.»

Alors en fait, non.

Intel fait pas mieux ni autrement que ce qui est fait depuis 30 ans, mais Intel fait plus et mieux de marketing et de campagne de com.

De toute façon, Intel a toujours fait de son mieux, le mur qui freine les progres, c'est l'architecture x86, archaique et inadaptée aux problemes actuels.

Si Intel devait se sortir les doigt du marecage nauseabond ou la societe s'est enlisée, entrainant le reste du secteur electro informatique, c'est en changeant radicalement d'architecture... ce qui n'est pas le cas, ni meme a l'horizon.

La, Intel a trouvé un moyen de prendre de l'avance sur ses retards a extension sur ses feuilles de routes irrealistes.

La gravure a 14nm n'est toujours pas maitrisée (taux de dechets importants, efficacité de consommation anecdotique). Depuis le passage sous les 32nm les gains energetique, calirifiques sont... quasi nuls. La vitesse de traitement ne subit aucun benefice.

Le seul interet de descendre sous les 22nm c'est que les puces sont plus petites et que par economies d'echelle sur la quantite de materiaux employées, elles sont plus rentables... en theorie, parce qu'avec l'augmentation du taux de dechets, l'augmentation du cout des materiaux qui doivent etre de plus en plus de haute qualité et le cout exponentienl des usines, ce gain est tres relatif.

AMD n'a rien mis comme coup de pression, AMD a fini par rattraper Intel qui s'est pris le mur. La ou AMD a un avantage sur Intel, c'est qu'AMD est fabless, donc n'a pas a investir ni a amortir des usines de productions a couts astronomiques. Et on peut suspecter AMD de faire tres peu de benefice sur les Ryzen et qu'ils servent surtout a casser la politique de terre brulée qu'Intel a developpé en flanquant un eGPU de m!@#$% dans tous ces Core i et quelques Xeon, qui a pour consequence de priver AMD de son principal revenu: les GPU d'entree de gamme.

Le seul a vraiment mettre, sans le vouloir, la pression sur Intel c'est ARM. Intel s'est systematiquement cassé les dents pour entrer ou revenir sur les marchés pris par ARM, et maitenant ARM arrive sur PC et serveurs, le monopole du x86. Ça c'est de la pression, mais on constate une chose: Intel est incapable de gagner un marché concurrentiel.

On dirait qu'AMD leur a mis un petit coup de pression, on va soudainement passer de 4 cores à 6, 8, et plus sur les gammes grand public, chose qu'intel vendait une blinde auparavant.

Le match s'annonce intéressant surtout niveau tarifaire, sur les tâches massivement parallélisées comme le traitement vidéo, AMD est désormais bien placé.

Il n'empêche que l'évolution est de plus en plus lente même si le 10nm est impressionnant, le passage à 7nm risque de se faire dans ma douleur et en dessous on va commencer à atteindre des limites quantiques qui vont obliger les fondeurs à repenser complètement les CPU pour que les performances augmentent de nouveau significativement.

En tout cas ça présage du bon niveau mobilité, dans moins de 5 ans on aura dans le creux de la maison et sur le poignet des appareils dont la puissance rivalisera avec des machines de bureau d'aujourd'hui, ce qui est assez hallucinant quand on y pense et promet de belles choses notamment dans le domaine de la réalité augmentée cher à Apple depuis quelques temps.

Si j'en crois certains, Intel nous prendrait pour des truffes depuis un petit moment...bizarre que je ne sois pas surpris ! ?

Question simple, mais j'ai du mal à trouver une réponse complète sur le web : est-ce que chaque nouvelle génération de processeurs apporte un gain de puissance ou de vitesse ou n'est-ce que la consommation qui baisse en conservant une même puissance ?

Autrement dit est-ce qu'un processeur de X GHz de génération N est équivalent en puissance à un processeur N-1 de X GHz à puissance équivalente ?

Merci à ceux qui peuvent d'éclairer ma lanterne ?

Y'a tellement à boire et à manger avec cette question.

Déjà, chez Intel, depuis plusieurs années, le gain en puissance d'une génération à l'autre est de 5 à 15% sur la gamme i3/5/7. Pas foufou, mais heureusement il y a un peu de puissance en plus.

Effectivement, avec la réduction de la finesse de gravure, les gagnants sont la consommation et le dégagement de chaleur.

La puissance, ça dépend aussi ce que tu mets dedans : il y a la puissance mono-cœur (la fréquence) et la puissance multi-cœur (le nombre de cœur). Sur le mono-cœur, je ne vois pas de progrès significatif depuis un baille.

Sur le multi-cœur, ça dépend du nombre de cœur mais il y a eu une vraie augmentation dû notamment à la finesse de gravure (plus de place pour plus de cœurs avec un même radiateur tu refroidis aussi bien). Par exemple, Apple mettait des Westmer (une architecture 32 nm si je ne m'abuse) dans les anciens Mac pro 5.1 qui se sont retrouvé un peu derrière lorsque le Mac Pro 6.1 est sorti : avec une seul puce, les Xeons de cette génération mettait dans le vent les Macs à 2 puces.

Donc, la puissance augmente d'une manière générale, peu pour le iX, beaucoup pour les grosses puces Xeon ou i3/5/7 gamme X (et le prix va avec).

J'en parle un peu plus haut mais on pourrait avoir un vrai gain si les développeurs prenaient vraiment en charge le plus grand nombre de cœur possible. Beaucoup de logiciel se repose encore sur la fréquence des puces plus que sur leur nombre. Aujourd'hui le problème est là.

Ensuite, il y a le fait qu'Intel a fait al course en tête depuis tellement longtemps qu'on n'a pas l'impression qu'ils ont fait des efforts pour proposer du mieux. Comme tu le soulignes, on se demande parfois s'il y a vraiment du progrès en puissance.

Perso, ça commence à me courir et j'en viens à critiquer sévèrement chaque fois que je le peux les éditeurs qui ne font pas ce travail.

J'espère avoir apporté une petite flamme à ta lanterne :)

@Narcis

C'est une question compliquée en 2017, il a 10-20 c'était facile.

En moyenne, une nouvelle génération est environ 5% plus rapide, donc oui la consommation baisse pour la même puissance (le tdp diminue).

La fréquence n'est plus un indicateur que l'on peut comparer directement, Intel ajuste les fréquences de fonctionnement en fonction de la micro architecture sous jacente. Et maintenant les cpus peuvent booster leur fréquence en fonction du nombre de coeur utilisés.

Mais globalement c'est surtout le nombre de coeur qui va décider de la puissance de ton cpu, un gain de 5% sur un core ne battra jamais l'addition d'un autre core.

La fréquence n'est plus un moyen de différencier la performance des CPUs, le nombre de coeur, la quantité de cache est aussi importante.

Bah, la finesse de gravure n'a rien a voir avec la puissance ni la consommation. C'est une question de rentabilité des puces au niveau des economies d'echelle en production de dimension industrielle.

La conjoncture de Moore c'est un principe d’économie industrielle et rien d'autre.

Nvidia a demontré, comme Apple, qu'en gardant la meme finesse de gravure on pouvait augmenter la puissance tout en diminuant la consommation et la production calorifique. C'est le travail sur l'architecture qui permet d’obtenir l'efficacité énergétique, rien d'autre.

Les problemes insurmontables quantiques et electriques lie a la finesse de gravure ont ete mis en evidence a partir de 18nm au Leti, y a un paquet d’années de ça. Depuis, les fondeurs ont trouvé des subterfuges pour compenser ces problemes (rattrapage d'erreur par le logiciel, empilage 3D avec le FinFET, et autres petites merveilles de complication) mais ça n'evite pas les problemes et ça a un cout en terme de puissance et de consommation.

Tant que graver plus fin permettra de faire de la marge sur la quantite de materiaux economisé (le prix de vente de la puce ne baissant pas...) ils se débattront pour graver plus fin (avec un cout par usine si énorme qu'il n'y aura qu'un ou 2 fondeurs dans le monde, c'est lenjeu de la course actuelle et de la fausse dénomination 10nm - qui est du 14nm ou du 16nm, voir du 20nm). Ça n'a aucun impact positif sur le consommation ni la puissance, c'est juste financier.

apres, une fois que le coût de production sera si eleve que le prix de vente ne pourra plus être rentable, ils s’arrêteront de graver plus fin. A partir de la on a 2 perspectives: soit on a une nouvelle revolution electronique (enfin photonique, quantique, ADN ou je ne sais quoi), soit on doit passer a autre chose que du silicium (mais le cout explose), soit on entre dans une phase de stagnation intense ou c'est le travail d'optiisation logicielle et d'architecture materiel qui va pousser la puissance ( et la y a une bonne marge par rapport a inefficacité actuelle, mais ce sera pas suffisant pour les besoins croissants)

Quand au parallélisme que tu evoques, il a un intérêt dans certains domaines, mais l'usage d'un PC le limite a un maximum de 6 a 8 core, apres, il n'y a pas de bénéfice, au contraire (ce qu'a demontré Intel avec sa gestion de l'alimentation et le mode turbo). Par contre le gain de puissance grace a la frequence plus eleve lui est immédiatement visible, seulement la on est limité a 4Ghz. Apres on peut avoir un meilleur taux d'instructions traitées par cycles, mais c'est une question d'architecture.

@C1rc3@0rc

"Quand au parallélisme que tu evoques, il a un intérêt dans certains domaines, mais l'usage d'un PC le limite a un maximum de 6 a 8 core, apres, il n'y a pas de bénéfice"

Et pourquoi il y a une limite après 8 core ? Les logiciels arretent de fonctionner ?

AMD Threadripper 16 core / 32 threads, Intel i9, et Xeon ont tous plus de 8 core.

Pour les application multithreader ca apporte de la puissance. il suffit d'aller voir les benchmark de Threadripper.

Le passage a un process plus petit permet de moins consommer, le fait que les transistors soient plus petit permet d'abaisser le voltage de fonctionnement. Et qui dit voltage plus petit, dit conso plus petite. Et donc le même cpu a 10 nm consomme moins qu'a 14 nm pour la même puissance.

«Et pourquoi il y a une limite après 8 core ? Les logiciels arretent de fonctionner ?»

Parce qu'il y a peu de programmes qui sont parallélisables sur PC (sur serveur c'est un cas a part).

Sur tout ce qui est PC et devices, on a majoritairement des programmes séquentiels, donc pas parallélisables. On peut exploiter le parallélisme en lançant plusieurs programmes en même temps, mais la on a des problèmes pour gérer les accès mémoire (y a qu'une seule RAM, meme si les caches se multiplient comme des lapins). Et la plupart des applications passent leurs temps a attendre que l'utilisateur se maniste...

Bref, d'une part les langages de programmations usuels en micro sont pas fait pour le parallélisme (a part ADA, mais hors de l'industrie... et de l'aviation...), d'autre part tres peu de développeurs sont formés au parallélisme, et y a finalement très peu d'application micro qui bénéficient du parallélisme...

Donc on arrive vite au cas ou le processeur voit 2 de ses core tourner a fond, et les 6 autres dormir profondément. intel a beau avoir fait un travail de la gestion electrique par core remarquable, sur un octocore, la plupart du temps on a moins de puissance que sur un dual ou un quad, qui eux beneficient d'une frequence par core plus elevee.

«Le passage a un process plus petit permet de moins consommer, le fait que les transistors soient plus petit permet d'abaisser le voltage de fonctionnement.»

De 130nm a 22nm je veux bien qu'il y ait une baisse 'mecanique', meme de 32nm a 22nm ça peut encore se sentir, mais de 14nm a 10nm... c'est anecdotique, par contre toutes les compensations et et vérifications qui doivent etre mise en place pour corriger les erreurs qui se multiplient avec les effets quantiques et autres joyeusetés, ça consomme des cycles en plus donc de l'energie.

De plus Nvidia a bien démontré avec sa génération précédente resté a 28 nm, qu'on pouvait sans reduire la finesse diviser par 2 la consommation... AMD aussi dans le sens inverse, alors que les Vega bénéficient de la même gravure que les GTX1080, plus ancienne d'un an... les AMD consomment 50% d'energie en plus pour une puissance qui talonne les GTX1080 (et encore c'est que les premiers resultats, on va attendre pour voir si c'est pas plus)

@C1rc3@0rc

"Parce qu'il y a peu de programmes qui sont parallélisables sur PC (sur serveur c'est un cas a part)."

Donc le pb c'est le parallélisme et non pas le nombre de core.

"Sur tout ce qui est PC et devices, on a majoritairement des programmes séquentiels, donc pas parallélisables."

Une majorité, ca veut pas dire pas tous. Ex les navigateurs modernes, compilation, bref certains logiciels utilisent parfaitement tous les core, et donc il y a un marché pour ca, si tu passes ton temps dans word effectivement pas besoin d'investir dans 16 core. Les jeux modernes utilisent les core.

"Donc on arrive vite au cas ou le processeur voit 2 de ses core tourner a fond, et les 6 autres dormir profondément. intel a beau avoir fait un travail de la gestion electrique par core remarquable, sur un octocore, la plupart du temps on a moins de puissance que sur un dual ou un quad, qui eux beneficient d'une frequence par core plus elevee."

Et c'est exactement pour cela qu'Intel offre des i3, des i5, des i7 et bientot de i9. On pas tous besoin de la meme chose.

"De 130nm a 22nm je veux bien qu'il y ait une baisse 'mecanique', meme de 32nm a 22nm ça peut encore se sentir, mais de 14nm a 10nm... c'est anecdotique"

Tu veux bien ? Moi je regarde les chiffres, ex pour TSMC a 10 nm le voltage est de 0.7V et a 7nm il est de 0.5V : https://en.wikichip.org/wiki/10_nm_lithography_process et https://en.wikichip.org/wiki/7_nm_lithography_process

"De plus Nvidia a bien démontré avec sa génération précédente resté a 28 nm, qu'on pouvait sans reduire la finesse diviser par 2 la consommation"

nVidia n'a rien démontré, deja tu compares GPU et CPU qui n'ont du tout les meme contraintes, et ensuite nVidia l'a fait une fois qu'une fois, difficile de généralise.

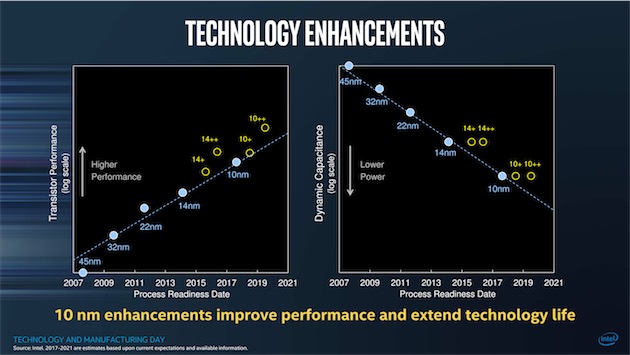

@Narcis

La réponse est dans la publication d'Intel dans l'article (sur fond bleu). Tableau de gauche.

@Narcis

Hardware.fr vient de faire un comparatif des processeurs x86 entre 2008 et 2017 : http://www.hardware.fr/articles/965-1/2008-2017-tests-46-processeurs-16-archis-intel-amd.html

Comme on peut le voir, la performance augmente, la consommation diminue (conso au repos divise par 3 en 9 ans).

ARM les oblige à donner le meilleur.

C'est à côté du sujet principal mais comme je lis des commentaires liés à la multiplication des coeurs, etc...

Je viens de tomber sur ça : Microsoft prépare une version de son OS Windows optimisé pour Workstation : capacité de gérer 4 CPU et 6 to de mémoire... un autre monde.

https://www.developpez.com/actu/154082/Microsoft-confirme-l-arrivee-d-une-nouvelle-edition-de-Windows-10-optimisee-pour-les-stations-de-travail-et-qui-debarquera-cet-automne/

@cv21

C'est ce que fait et beaucoup plus n'importe quel Linux ou Unix adapté au HPC. MS fait ici juste une segmentation marketing pour reprendre des PDM et eviter que du PC "gonflé" lui échappe. Le secteur ou la puissance de calcul a le plus progressé ces dernieres annees c'est le GPGPU, avec Nvidia en tete et de loin. Nvidia et IBM se sont associés il y a quelques annees pour developper l'architecture POWER afin qu'elle integre et optimise le GPGPU de Nvidia. En terme de station de travail et serveur de calcul c'est ça la principale menace pour Intel et Microsoft.

Merci C1rc3@Orc pour la précision,

Je me doutais que les Linux/Unix pouvaient gérer ce genre de machine (sauf Unix-MacOs je suppose)...mais je dois reconnaître que je n'imagine pas un "PC unitaire gonflé" avec autant de CPU/mémoire. Les fermes de calcul avec GPGPU, j'imagine très grossièrement, la seule que j'ai pu voir dans une boite de 3D c'était 2 baies avec plein d'ordis en rack, bref cela ressemblait à des rack de serveurs classiques. Je vois bien que Nvidia propose des trucs avec des cartes graphiques pour du calcul. Quand je vois Deep Learning et Intelligence Artificielle sur leur site et d'autres, bon sang la retraite est encore loin et mer.. il va falloir suivre un peu, malheureusement de loin pour la compréhension. Apple suit, Microsoft aussi, chacun à son niveau sur ces marchés...

L'architecture Power !!! Cela me rappelle l'architecture pour les G3 à G5, cela existe encore ! IBM et Nvidia ensemble c'est du lourd, merci pour l'info.

«L'architecture Power !!! Cela me rappelle l'architecture pour les G3 à G5, cela existe encore ! IBM et Nvidia ensemble c'est du lourd, merci pour l'info.»

Les G3 et les G5 etaient des derivés des POWER "d'ancienne generation" de l'epoque.

IBM a meme lancé avec Nvidia et quelques autres (dont...Google) l'association OpenPOWER pour developper l'architecture POWER en licence libre. Pour l'instant cela inclut pricipalement les POWER de generation 8 et precedent, l'architecture POWER actuel etant la 9 chez IBM.

C'est plutot orienté pour cibler le server et le HPC, mais n'importe qui peut rejoindre l'association et developper son proc a condition de respecter le jeu d'instructions et les normes de l'architecture. Aujourd'hui ça tourne sous Ubuntu Serveur et SUSE.

En terme de performances et d'efficacite energetique le POWER est bien meilleur que le Xeon, mais Intel ayant cassé les prix pour prendre des PDM...

«mais je dois reconnaître que je n'imagine pas un "PC unitaire gonflé" avec autant de CPU/mémoire.»

Ça n'aurait pas beaucoup de sens actuelement.

Les soft tournant meme sur station n'ont dans la majoirité des cas pas besoin de plus de 4 core et de 128Go de RAM. Pas que le besoin en puissance de calcul ne soit pas la, mais une station de travail c'est un "gros PC" fait pour l'interaction, et il est tributaire de la vitesse d'action de l'utilisateur... Quand on veut lancer du calcul lourd qui sature les 4 Quadro ou les 18 core du processeur, on le lance depuis un PC avec une jolie interface (ou meme un terminal...) sur un serveur de calcul sans ecran ni clavier.

A une epoque Apple avait lancé un truc qui paraissait intéressant qui etait la capacité a repartir un traitement sur les machines disponibles sur le reseau local ( un truc de base d'Unix en fait), mais ce type d'usage est plus efficace avec un serveur ou une grappe de serveur, sachant qu'en plus que le cout par machine est bien plus faible que le rapport puissance/prix des Mac qui est vraiment mauvais.

En theorie MacOS c'est un FreeBSD, donc un Unix, qui peut tourner et faire tourner du raspberry de base au super-calculateur monstrueux. A part l'interface et le systeme de fichier et deux 3 trucs, l'essentiel de MacOS est disponible en Opensource sous le nom de Darwin https://opensource.apple.com/... en theorie n'importe qui peut l'utiliser pour l'adapter a une machine x ou y...

«Quand je vois Deep Learning et Intelligence Artificielle sur leur site et d'autres, bon sang la retraite est encore loin et mer..»

Moais, faut pas non plus tomber dans le paneau du marketing. L'IA dont il est question n'a rien avoir avec de l'IA, mais plutôt du big data, et quand il s'agit d'IA véritable ce sont des choses assez archaïques et primitives qui bénéficient de la puissance du GPGPU. Plus de la demonstation de la puissance brute des GPU qu'autre chose. Le Deep learning et la pseudo-IA actuelle c'est surtout un moteur de croissance marketing pour le materiel... J'ai pas encore vu grand chose de plus avancé que ce qui date des annees 80...

@C1rc3@0rc

"Nvidia et IBM se sont associés il y a quelques annees pour developper l'architecture POWER afin qu'elle integre et optimise le GPGPU de Nvidia."

Ca consite surtout a integre NVLink sur POWER. 2.5 plus rapide que le PCIe.

Ca n'est pas unique a POWER comme techno.

Dans le fil du débat, cet article de 2014 ;

"Semi-conducteurs: de quoi sera fait l’après silicium ?"

http://parisinnovationreview.com/2014/06/27/semi-conducteurs/

Dont je retiens que "La véritable innovation pourrait venir des « quantum dots », les puits quantiques, et des nanoparticules"...

@Mike Mac

Chacun y va de sa chapelle, de sa croyance et de ses prospectives.

Pour l'instant rien n'est tangible, il y a plusieurs voies de recherches, plusieurs acteurs, pas mal de declarations et beaucoup de questions et de doutes.

Il y a quelques années j’étais quasi certain que l’armée US disposait deja d'ordinateurs quantiques fonctionnels, mais avec l'entente entre les gouvernement pour rendre le chiffrement illégal, je doute qu'il y ait des techno autres que celles auxquelles le civil a acces (a part peut etre en terme de masse, et la entre Facebook et Google ou Amazon,... j'ai des doutes qu'il y ait beaucoup plus)

Au niveau des processeurs, on peut graver plus fin et on sait le faire avec des matériaux qui ne sont pas du silicium, seulement ça sert pas a grand chose en terme de puissance et de consommation et surtout ça coûte beaucoup plus cher.

D'un avis personnel, j'ai tendance a penser que l'approche la plus innovante et qui multipliera la puissance passera par l'abandon de l’électronique pour aller sur l'optique, le photon, mais c'est pas encore fonctionnel en phase industrielle. Et c'est bien ça le probleme, la phase industrielle. Parce que concevoir un transistor atomique ou un processeur quantique en labo c'est une chose, en sortir des millions par an pour mettre sur les bureaux c'est autre chose...

Pour l'instant les grosses ameliorations relevent de 2 voies:

- le développement d'architectures plus performantes, plus efficace énergétiquement

- l' ingénierie logicielle et la formation des développeurs

L'abandon du x86 va enfin donner de l'air pour proposer d'autres architectures bien plus performantes et adaptées aux problemes d'aujourd'hui (le x86 date des connaissances et problemes de la fin des annees 60...)

Du cote de l'ingenierie informatique, il va falloir reporter l'optimisation sur la compilation et pas au niveau interne du processeur comme le fait le x86, ce qui est une ineptie en terme d'efficacité (un x86 passe une partie de son temps a optimiser/compiler a la volée le flux d'instruction qu'il reçoit, plutot qu'a l'executer le plus vite possible...)

Il va aussi falloir faire adopter des langages qui sont fondamentalement parallèles, qui sont pensés pour faciliter l'optimisation de la compilation et la sécurisation du code et tres orientés "mathematique" et gestion de données massives... parce qu'aujourd'hui, les langages massivement utilisés en industrie c'est tout l'inverse et leurs formats de données c'est un modele de processeur datant des annees 70/80...

Merci aux fana de jeux (les gamer),grâce a eux, il y aura toujours un marcher de vente de pièces détachées ou de pièces modifiable pour la quette de perf...Mais jusqu’à quand ?

J'ai un pc QILIVE™ de la marque Auchan © hs, est bien, rien n'est "réparable☹" "modifiable☹", ou "updatable☹" dessus!!!

une simple carte mère (la taille d'un smatphone 5.5") ou tous est soudés,et donc pas réparable/modifiable.

Et les iptv box(comme le Nvidia shield) , sous androïde, ça pullule en se moment et sur un écran TV on à tout a porter de main (plus besoin d'un pc)

ARM♺ beurk.

PS: En complément du post de Stardustxxx,

Lenovo thinkPad c'est une filière d'IBM également ;)