Mac ARM : Apple va-t-elle se passer totalement d'AMD ?

Maintenant que la transition vers les processeurs ARM est enclenchée, il reste encore quelques inconnues de taille. L’une d’elles concernait l’avenir du Thunderbolt. L’affaire n’a pas trainé, Apple a fait savoir par voie de presse que cette technologie aurait bien sa place dans ses futurs Mac.

L’autre grande interrogation porte sur les GPU. Comment Apple va-t-elle s’y prendre ? Va-t-elle tout internaliser comme elle le fait sur l’iPad et l’iPhone ou va-t-elle continuer à faire appel à un partenaire comme AMD ?

Apple n’a pas donné d’informations officielles sur le sujet, mais a semé de petits indices ici ou là. Dans sa documentation concernant le portage d’apps vers Apple Silicon, Apple glisse une petite phrase lourde de sens :

Don’t assume a discrete GPU means better performance. The integrated GPU in Apple processors is optimized for high performance graphics tasks

Que l’on pourrait traduire succinctement par ne pensez pas qu’un processeur GPU distinct est synonyme de meilleure performance. Les GPU intégrés dans les processeurs Apple sont conçus pour de hautes performances graphiques.

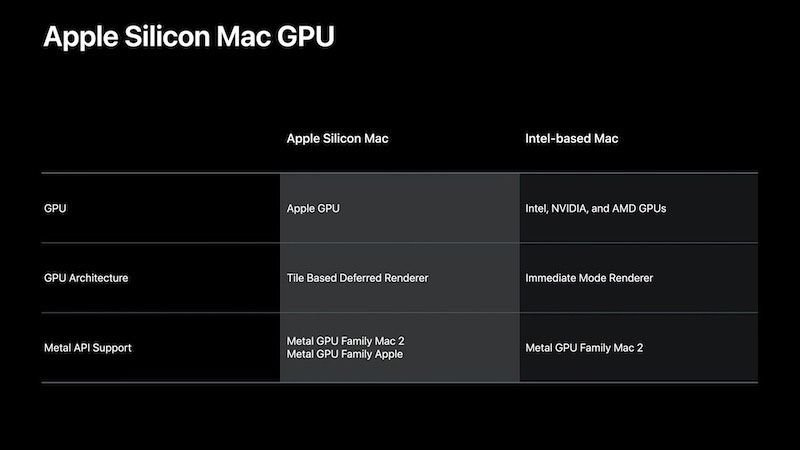

Il y a également cette diapositive parue lors d’une session de la WWDC, qui montre les différences d’un point de vue graphique entre les Mac ARM et les Mac Intel. Là où les Mac Intel ont le choix entre les GPU Intel, Nvidia et AMD, les Mac équipés Apple Silicon se limitent aux GPU d'Apple. La question que certains se posent est de savoir si Apple dit bien tout ou si elle cache encore son jeu.

Il y a plusieurs choses à observer dans la situation actuelle. Tout d’abord, il faut bien se rappeler que les démonstrations faites par Apple avec son DTK lors du keynote d’introduction de la WWDC étaient assez impressionnantes. L’Apple GPU semblait performant et était capable d’exécuter des jeux dans des conditions qui paraissent impensables sur les MacBook Air par exemple.

Pour expliquer le passage à Apple Silicon, les dirigeants d’Apple ont réexpliqué leur philosophie de design et ont insisté comme ils l’avaient fait quinze ans plus tôt sur le fameux axiome performance par watt. De ce point de vue, on imagine mal Apple faire autrement sur ses ordinateurs portables.

Reste à savoir comment Apple va s’y prendre pour rivaliser avec les cartes graphiques relativement puissantes que l’on trouve dans ses stations de travail comme l’iMac Pro ou le Mac Pro. Apple sera-t-elle en mesure de mettre au point une solution maison ? Sur ces machines, le circuit graphique sera-t-il retiré du système-sur-puce, car celui-ci est trop volumineux ? Et si c’est le cas, aura-t-on le droit à une carte graphique Apple ou provenant d’un acteur établi comme AMD ? Comme nous l’expliquions dans cet article « Quel GPU pour un futur Mac ARM ? » en amont de la WWDC, les options ne manquent pas pour Apple. Les choix architecturaux d’Apple pour ses stations de travail seront d’ailleurs assez passionnants à suivre.

Dernière inconnue souvent évoquée : l’avenir des boitiers externes eGPU. L’annonce du support des Thunderbolt sur les Apple Mac Silicon laisse à penser que ces périphériques continueront à exister.

Oui, et ça va faire très mal à AMD je pense.

Quelle proportion de leur activité constitue Apple ? Je n'arrive pas à trouver l'information mais j'imagine que c'est significatif, beaucoup plus que pour Intel...

@Simnico971 : vu le faible nombre de mac vendu avec puce AMD, et sachant qu'AMD fournit les puces pour les ps5 et xbox x, j'imagine que la perte est négligeable

@ereyre

Ah j'étais pas au courant pour les consoles de Sony et Microsoft. En effet dans ce cas ça va limiter l'impact...

justement c'est bien ça le problème...

vous n'y connaissez rien mais absolument rien pour la grande majorité d'entre vous !

Vous ne savez pas même pas ce qui se passe en dehors de l'écosystème Apple et vous devriez pourtant !

Surtout qu'apple va être confronté à un problème de taille et pas des moindres !

Apple n'est pas le client principal de TSMC pour les puces, c'est AMD qui est en train de faire un retour fracassant depuis l'été dernier !

Et l'autre futur client qui risque de faire mal aussi c'est Nvidia, Apple aura beaucoup de mal à faire plus de puces que ces 2 là et donc à fournir beaucoup beaucoup de machines.

@Dimemas

sauf que justement le nombre de puces à fournir pour idevices est et sera toujours largement plus significatif que celui des mac

ensuite que ce soit intel ou amd, tous deux fournissent des chipsets modifies pour des demandes spécifiques d’apple, donc infime ou pas, apple est suffisament important opur eux pour qu’ils fassent des efforts

enfin apple negocie les productions de puces bien en avance, dans le cas de tsmc, ces derniers se sont décarcassés pour avoir la production de celles d’apple vis à vis de samsung il y a quelques années

à votre decharge, je dirais que trop s’intéresser à ailleurs fait oublier l’importance enorme d’apple dans ces marchés (constament ignorée et raillée par le monde pc qui n’y connait pas bcp plus que « apple c de la merde » )

vendre une serie de gpu dans le commerce c’est une chose en vendre à apple ca va direct dans le cv de la boite.

(comme expliqué dans un ancien article, de nombreuses mises à jour du micro firmware des puces skylake d’intel etaient le fait des remontées de bug d’apple qui ont profité à tout le monde finalement)

@ereyre

Les MBPro 16" 2019 sont équipés AMD pour le second GPU.

Ce n'est peut-être pas la majorité des ventes, mais Apple est un porte étendard important.

@andr3

AMD touche aujourd’hui tous les gamers (consoles et PC), via les GPU ou CPU.

AMD sur le marché des PC c’est 19% des GPU (et 27% des GPU dédiés, excluant Intel, donc).

Apple pour sa part ne représente que 7% des ventes de PC sur 2019 selon un article de janvier de MacG. Je me demande la part des Mac vendus avec un GPU dédié, mais dans mon entourage il ne me semble pas très élevé (où je vois essentiellement des MBA et MBP13").

Ils vont certes le voir passer, mais je ne pense pas que si Apple se passe d’eux (ce dont je ne suis pas convaincu pour le moment) cela leur fasse plus mal qu’à Intel. Pour Intel, il y a un véritable risque en terme d’image et de capacité à se renouveler. Si Apple réussi son pari, ça va donner à réfléchir à Microsoft et aux constructeurs de PC, à l’industrie en général.

@andr3

Vous croyez? Pour une boite comme AMD j’aurais pensé qu’être dans une console serait bien plus intéressant. D’autant que le mac n’a jamais été une plateforme de jeu très convaincante.

@simnico971

Intel s’étant pris une bastosse, ça fait un bon exemple pour AMD. Les exécutions publiques avaient du bon 😉

ah oui ?

sauf que sans intel et AMD, tu n'aurais pas de matériel digne de ce nom pour écrire ce genre de merde, n'oublie pas qu'apple a failli disparaître aussi et que rien n'est gagné dans ce monde

Vu tout les marcher que AMD gagne ... ca va rien changer

ahahah c'est peanut le mac pour AMD XD

Non mais sérieux, vous avez vraiment cru que les macuser étaient si nombreux

@simnico971

"Oui, et ça va faire très mal à AMD je pense.

Quelle proportion de leur activité constitue Apple ? Je n'arrive pas à trouver l'information mais j'imagine que c'est significatif, beaucoup plus que pour Intel..."

Les consoles de jeu représentent un marché très considérablement plus important que le marché Apple, pour AMD. Rien que le mining, qui va et qui vient, représente un marché bien plus considérable pour AMD.

AMD ne sentira même pas la piqure, ne t’inquiète pas pour eux.

Et pour les Mac Pro je ne pense pas qu’il arrive sur ARM sinon abandon des GPU donc évolution très restreinte. Et ARM gère t’il la ram ECC. Et pourrons nous changer le processeur ?

@DoomFightPro

Pour la ECC, oui et non, ça du dépend du fabricant, donc si apple veut mettre de la mémoire ECC, il y aura de la mémoire EEC.

Par contre si on pourra changer le CPU. Le SOC ARM serra très probablement soudé à la carte mère sur toute les machines.

@DoomFightPro,

« Et pour les Mac Pro je ne pense pas qu’il arrive sur ARM sinon abandon des GPU donc évolution très restreinte. Et ARM gère t’il la ram ECC. Et pourrons nous changer le processeur ? »

Si le Mac Pro survit à cette transition, chose pas totalement acquise !

Apple concevant ses propres processeurs, elle peut y intégrer ce qu'elle veut.

Charge ensuite aux développeurs d'en profiter.

CUDA on va oublier donc et AMD aussi je suppose !

🙄

@Scooby-Doo

"Si le Mac Pro survit à cette transition, chose pas totalement acquise !"

Ce serait hilarant un Mac Pro avec deux cartes d’accélération : une carte GPU (AMD sans doute) - c’est déjà le cas actuellement, tout est normal - et une carte CPU Intel Xeon - et là c’est l’hilarité -.

On peut aussi se poser la question si dans le futur ARM d'Apple, ils continueront à commercialiser un Mac Pro.

Apple a rappelé l’importance des pros avec l’iMac Pro et le Mac Pro. La démo FCP va dans ce sens.

@bonnepoire,

« Apple a rappelé l’importance des pros avec l’iMac Pro et le Mac Pro. La démo FCP va dans ce sens. »

C'est beau de rêver, cela donne de l'espoir !

😁

Dans la vraie vie, il faut juste se poser la question suivante :

Compte tenu du marché ultra minoritaire du iMac Pro / Mac Pro pour Apple, Apple va-t-elle prendre le temps et l'argent pour développer des processeurs spécifiques pour uniquement satisfaire une minorité de ses utilisateurs ?

Parce que développer un processeur maoussss costaud avec des performances qui tiennent la cadence et de la puissance graphique comme des Quadro de nVidia par exemple, cela demande un peu de temps et un peu d'argent...

Je ne dis pas que Apple n'a pas le savoir faire ! Apple a le savoir faire et l'a prouvé par le passé.

Mais comment amortir les frais de développement conséquents sur des volumes si faibles ?

C'est le prix de ces processeurs Apple Silicon haut de gamme qui risque d'exploser.

Du coup, c'est mort et enterré à mon avis comme MacOS Server et les machines qui allaient avec.

Faut arrêter de rêver...

😉

Ça marche comment techniquement ? Est-ce qu’un GPU AMD ou NVIDIA classique peut fonctionner avec autre chose qu’un CPU x86 ?

Ou est-ce que des GPU spécifiques seront nécessaires dans le cas où AMD travaillerait toujours avec Apple ?

@SimR69

J’ai eu la même réflexion. J’attends avec impatience la réponse 😉

À priori oui. C’est ce que fait Nvidia sur ses kits jetson (CPU ARM + GPU Maxwell, Pascal ou Volta) ou sur ses SoC Tegra.

@SimR69

Les G5 donc PPC fonctionnaient avec des processeurs ATI(AMD) et de même il y avait eu des cartes graphiques 3DFX (les voodoo) donc potentiellement ce n'est pas un pb d'architecture, plus une question de disponibilités de drivers.

@olgluk

"Les G5 donc PPC fonctionnaient avec des processeurs ATI(AMD) et de même il y avait eu des cartes graphiques 3DFX (les voodoo)"

3DFX a cessé d’exister bien avant la commercialisation des PowerMac G5.

On pouvait mettre des cartes Voodoo dans les G3, au mieux.

@SimR69

"Est-ce qu’un GPU AMD ou NVIDIA classique peut fonctionner avec autre chose qu’un CPU x86 ?"

L’interface de communication est le PCIe. Ce n’est pas strictement lié au x86.

Thunderbolt est une variante autour de PCIe. Si Apple supporte le Thunderbolt, il y a quasi-obligation à supporter une forme de PCIe tant au niveau matériel qu’au niveau drivers.

Il n’y a donc pas d’obstacle technique insurmontable à avoir des ports PCIe dans une machine arm, ou NVMe par ailleurs qui est aussi une variante à base de PCIe, ou du Thunderbolt donc. Et donc des GPU de ces constructeurs.

Après il faut qu’Apple propose des ports PCIe, ce n’est pas gagné d’avance. Il faut qu’Apple supporte le eGPU, ce n’est pas non plus gagné d’avance. Et qu’Apple fournisse des drivers recompilés pour arm. Ou qu’AMD ou Nvidia s’y collent, ce n’est pas certain que ça les intéressent le moins du monde. Et qu’Apple permette d’une manière ou d’une autre d’utiliser Metal sur d’autres GPUs que les siens. Bref, il y a beaucoup d’autres obstacles que simplement techniques.

Du coup la question n’est plus celle que tu posais, mais plutôt : « Est-ce qu’Apple permettra qu’un GPU AMD ou Nvidia classique puisse fonctionner en interne ou en eGPU avec Metal et est-ce que AMD et Nvidia en auront quoi que ce soit à foutre ? », je pense.

@fte,

« Du coup la question n’est plus celle que tu posais, mais plutôt : « Est-ce qu’Apple permettra qu’un GPU AMD ou Nvidia classique puisse fonctionner en interne ou en eGPU avec Metal et est-ce que AMD et Nvidia en auront quoi que ce soit à foutre ? », je pense. »

Merci, c'est exactement la bonne question et c'est aussi la plus importante !

😉

On peut dire que c’est une certitude et que c’est une question de temps

Les iPad Pro et les iPhone font tourner des jeux gourmands

Si Apple se passe d’intel y a pas de raison que pour le GPU Apple ne fasse pas pareil avec AMD et Nvidia

Le GPU représente une part important du coût d’un ordi après le CPU

@corben

"Les iPad Pro et les iPhone font tourner des jeux gourmands"

tu sais ce qu'est un jeu gourmand? tu as deja vu un jeu PC? compare avec les jeux PC debut 2000 avec les jeux iphone plutôt

@en chanson

Vous avez vu les jeux qu’on a maintenant ? Le montage qu’on a vu à la WWDC? Ils vont amélioré leurs processeurs pour leurs Mac et ce sera bon

@corben

"Les iPad Pro et les iPhone font tourner des jeux gourmands"

Non.

Enfin oui, comparativement à des jeux Mac ou des jeux d’il y a 10 ans. Mais tellement pas comparé à Cyberpunk 2077 ou Metro Exodus...

@corben,

« Si Apple se passe d’intel y a pas de raison que pour le GPU Apple ne fasse pas pareil avec AMD et Nvidia. Le GPU représente une part important du coût d’un ordi après le CPU. »

Mais Apple va produire ses propres GPU, c'est écrit noir sur blanc !

Il vous faut quoi de plus pour comprendre la situation ?

AMD / nVidia, c'était pour la plate-forme Wintel et le coût d'un GPU est important.

Du coup, Apple va produire des SoC avec tout ce qu'elle veut dessus.

Maîtrise totale du hardware, en plus verrouillé avec une T2 en amont.

C'est le concept de jardin d'enfant si cher à Steve Jobs que l'on installe dans Alcatraz !!!

😁

A mon avis c’est tres clair, fini les gpu dédiés, Apple a insisté sur l’avantage du partage de mémoire entre cpu et gpu sur une meme puce.

De plus, ils ont pas l’habitude de faire les choses à moitié.

Sauf peut etre pour le mac pro qui est une machine à part.

@Grizzzly

| Sauf peut etre pour le mac pro qui est une machine à part.

Pour combien de temps encore ?

@andr3

"Sauf peut etre pour le mac pro qui est une machine à part.

Pour combien de temps encore ?"

En effet, ce n’est probablement qu’une question de temps.

Si Apple s’engage à 100% avec ses puces maison c’est probablement que leur marge de progression est grande

Le GPU Apple gère le ray tracing. Gageons que ça augure du bon. Ça semble bien plus puissant que les GPU intégrés Intel.

@bonnepoire

“Le GPU Apple gère le ray tracing. Gageons que ça augure du bon.”

Aucun GPU actuel ne gère LE Ray Tracing temps réel. Les plus puissants ont des fonctions limitées de RT, suffisantes pour réaliser des démos comme une voiture (forme simple, carrosserie luisante), dans un décor ultra-simple ou inexistant (fond noir), avec quelques sources de lumière. C’est techniquement impressionnant, mais insuffisant pour faire de véritables applications en RT.

Les jeux en Ray Tracing c’est 95% d’affichage classique à base de polygones 3D, pour une pincée d’effets en RT. Et des commerciaux faisant fièrement des zooms x10 sur des copies d’écrans pour montrer que : « regarder ici et là, ces pixels montrant l’efficacité en RT de notre nouvelle carte RTX à seulement 1000 €).

Dans 10 ans, peut-être, mais pas à l’heure actuelle ! A moins d’acheter des systèmes de rendu professionnels à 50.000 €, renfermant des tas de GPU et de processeurs pour avoir la puissance de calcul nécessaire. Je n’imagine pas un assembleur proposer un PC Gamer à seulement 58.000 €, ou Sony une console PS 7 à 38.600 € !

L’affaire n’a pas trainé...

Apple à quand même attendue plusieurs semaines !

On est d’accord que rien n’empêche techniquement un GPU amd de tourner sur un Apple Silicon ? Ou bien est-ce complètement dépendant de jeux d’instructions des processeurs Intel ?

Je me souviens à l’époque PowerPC et celle d’avant où il était pratiquement impossible de prendre une CG non prévue pour le Mac, mais c’était je crois surtout dû aux bus particuliers utilisés alors dans le Mac…

Un spécialiste dans la salle ?

@Cactaceae

AMD ne fournit pas de driver pour ARM à ma connaissance. Cela va peut être changer pour .

@hirtrey

Hum oui c’est là que ça risque de coincer. Merci.

Correction à apporter :

AURA et pas AURAIT

« Apple a fait savoir par voie de presse que cette technologie AURA bien sa place dans ses futurs Mac. »

Cela a été confirmé par Apple, donc pas de conditionnel.

Pourquoi plaindre sur AMD ?

Macbook Pro 16 avec AMD comme le seconde graphique, tout est semble bien fonctionné, même pour les logiciels sous Adobe.

Moi-même, j'ai un notebook sous Windows qui a un processeur sous AMD et un graphique sous AMD. Tout est fonctionné parfaitement car j'évite l'utilisation des logiciels Adobe... (j'ai eu un expérience que le processeur/graphique AMD ne supporte pas les logiciels d'Adobe pendant mon formation donc il y a eu beaucoup des plaintes... Impossible avancer mon travail...)

Il faut juste savoir bien choisir un produit.... Si vous ne savez pas choisir alors ce sera votre faute...

Surtout qu’AMD est en train de reprendre du poil de la bête sur le marché des CPU...

Ça faisait quelques années qu’intel dormait sur ses lauriers et AMD est revenu en force avec ses Threadripper mais également ses petits processeurs Zen

Je me suis pris un petit Lenovo m715q qui dépote et qui fait aussi bien voir mieux qu’un Mac mini pour moitié prix

Donc franchement y a pas à les plaindre je ne m’inquiète pas pour eux

Le marché d'AMD c'est surtout les PC windows et les consoles next Gen. Apple avec ses représente un trop faible marché pour la société. De plus les Apple users ont l habitude de mac qui sont à la ramasse niveau perf graphiques et sans réelle ludotheque

@en chanson

Les consoles next gen ? La PS4 et la Xbox One tournent déjà avec des SoC AMD depuis 2012.

@NestorK

Je disais la même chose

C'est pourtant repris dans un des slide, il n'y aura PAS de dGPU "séparé du CPU", CPU et GPU forment un seul bloc (SOC)

- Le cpu et le gpu partageront la même mémoire système

- Le gpu aura sa propre mémoire à l'intérieur du sillicone

--> la bande passante de la DRAM n'est plus le goulot d'étranglement comme avec les dGPU

--> utilisation de la TBR (Tile-Based Deferred Rendering) aulieu de la IMR ( Immediate Mode Rendering) pour les rendus graphique contrairement au gpu classique Nvidia/amd. Ca demande moins de resource et moins de puissance pour un même rendu.

Ils ont aussi introduit le "metal developer tools on windows" pour pouvoir créer des applications et jeux utilisant métal sur une machine windows (ce qui permet de se passer d'un mac théoriquement pour le plus gros du boulot)

Le raytracing est supporté sur ses nouveaux gpu (cfr: video raytracing with metal)

Source: video "build GPU binary with metal" dans la section developer

Tous les GPU modernes Intel (Gen11-2019), Nvidia (Maxwell-2014), AMD (GCN5-2017) gèrent le tile rendering.

Les APU AMD gèrent depuis un moment l'hUMA (mémoire unifié GPU/CPU) ~2013.

Je n'ai pas tout lu sur ARM, mais même sans être un initié il y a une chose qui saute aux yeux concernant cette architecture, c'est sa modularité.

Les modules GPU à base d'ARM ne sont peut-être pas tout-puissants, mais on peut en accumuler un max au sein d'une même puce, ce qui multiplie d'autant les perfs... si l'architecture (je pense ici aux différentes méthodes d'interconnexion entre les modules) suit.

Et là je pense en particulier à la console NVIDIA Shield, qui a prouvé qu'on pouvait atteindre des perfs graphiques (en jeu) véritablement impressionnantes en utilisant la techno ARM.

Grace à cette modularité, rien n'empêche d'imaginer des boitiers GPU externes à base de puces Apple Silicon connectés en TB qui viendraient booster la puissance déjà dispo "in the box", ce qui serait une base idéale pour une informatique "hybride" je m'explique :

Lorsqu'on est en mobilité on a pas forcément besoin d'un GPU super-puissant, on a plutôt besoin d'autonomie. Une fois rentré à la maison, on pourrait connecter notre ordi "hybride" (à la fois portable et fixe) sur une station d'accueil TB qui étendrait véritablement les perfs, les connections, le stockage...

(On peut aussi imaginer des modules façon Lego qui s'emboitent les uns avec les autres, etc...)

C'est une chose qui a déjà été tenté dans le monde PC, mais qui n'a jamais donné de résultats probants. Là, avec la créativité et les capacités d'innovation de la pomme, ça pourrait peut-être réussir...?

Pages